基于整形特征的目标显著性检测算法研究

2016-12-26胡玉兰片兆宇

胡玉兰 黄 梨 片兆宇

(沈阳理工大学信息科学与工程学院 辽宁 沈阳 110159)

基于整形特征的目标显著性检测算法研究

胡玉兰 黄 梨 片兆宇

(沈阳理工大学信息科学与工程学院 辽宁 沈阳 110159)

针对传统目标显著性检测算法存在显著区域弱化、最显著的中心点被抑制、背景差对比度低等问题,提出一种新的整形目标显著性检测算法。算法首先利用灰度不一致算子作为局部处理手段,刻画图像局部纹理的非均匀性,使得最显著的中心点亮度提高;其次,利用改进的FT算法,建立一种新的全局量化方法,使得显著区域增强;再次,为了滤除孤立显著区的影响,算法提出一种空间权重表达法,对所提显著图进行线性处理,提高整体显著区与背景间的对比差。最后的仿真实验中,与FT、Itti等6种典型的目标显著性检测算法相比,该算法不仅具有更好的识别准确性和稳定性,而且所提算法的精确率和召回率等客观指标也具有较强的优势,从而表明该算法是切实可行的。

目标显著性检测 灰度不一致算子 空间权重

0 引 言

近年来,目标显著性检测已成为计算机视觉和图像处理领域新的研究热点。其相关研究成果已被广泛应用于诸多领域,如图像和视频的压缩和解码、图像分割、图像检索[1]和目标识别[2]等领域。

目标的显著性源于视觉的独特性和不可预测性,是由颜色、亮度、边缘、纹理、对称性等图像固有属性而致。而视觉注意机制是一种模拟人类视觉智能筛选的重要机制,该机制在大量的视觉信息中,可以将注意力快速聚焦于图像中显著目标区域。经过多年的发展,关于视觉注意机制的研究被分为两种方法[3,4]:一种是快速的、下意识的、自底向上的数据驱动的显著性提取;另一种是慢速的、任务依赖的、自顶向下的目标驱动的显著性提取。由于视觉内容需要大量的先验知识,自顶向下的方法应用不多。而自底向上的方法受图像特征支配,不依赖任何先验知识,被广泛研究和应用。较经典的自底向上的视觉注意模型是Itti[5]算法,Itti算法在特征整合理论的基础上,在多特征和多尺度上,计算纹理和颜色特征的中央差算子,把各个特征的显著图合成一幅显著图。在此基础上,目标显著性检测算法大多是采用低层视觉特征,即通过图像的亮度、颜色、方向和对称性等计算中央周边差对比度,得到显著图。其中比较具有代表性的有: GBVS[6]算法、 SR[7]算法、FT[8]算法、AIM[9]算法和CAS[10]算法等。Itti和GBVS算法采用局部特征的处理方法,GBVS算法是在Itti算法的基础上,运用马尔可夫随机场的特点构建二维图像的马尔可夫链,由它的平衡分布得到显著图。而这两种算法的显著图中部分显著区域的显著度较高,但是存在显著目标整体区域弱化和显著区域的轮廓模糊等问题。SR算法和FT算法均采用全局特征的处理方法,而且都是基于空间频域处理的算法。其中SR算法是对剩余谱做傅里叶逆变换得到显著图;FT算法是通过颜色和亮度特征提取来计算中央周边差对比多尺度方法得到全分辨率显著图,其中SR算法由于没有保留足够的高频信息,导致显著目标的边界模糊。这两种算法的显著图中虽然保留了显著区域的整体轮廓,但是均导致最显著的像素点受到抑制以及背景差对比度低等问题。AIM算法是采用香农的自信息理论,将图像的特征平面变换到对应于视觉显著性的维度,并利用该特征与相对于它周围的其他特征的信息的差别度来计算显著值。该算法存在显著目标弱化,非显著区域突出的问题。CAS算法是结合局部和全局考虑的处理方法,相对前面几种算法来说,显著图的处理效果较好,但是仍不完善,例如该算法耗时较长、运算效率低。综上所述,这六种目标显著性检测算法均存在显著区域弱化,最显著的中心像素点被抑制以及背景差对比度较低等问题。

针对传统目标显著性检测算法的上述缺点,本文提出一种新的基于局部和全局处理的目标显著性检测算法。首先,采用灰度不一致算子,计算各图像块内每个像素的显著值,作为局部处理手段,使得最显著的中心点亮度增强;其次,在局部处理的基础上,改进传统FT算法,引入图像全局的纹理特征,与颜色和亮度特征整合处理,作为全局处理手段,增强图像的显著区域;再次,通过计算图像的二维高斯函数,获得空间权重图,利用该权重图对全局处理后得到的显著图进行线性处理,来提高整体显著区与背景间的对比差。最后,应用所提的目标显著性算法与其他六种传统算法进行定性对比,并对所提算法进行定量评估,证明了算法的稳定性与有效性。

1 局部处理过程

局部处理先把自然图像转变成灰度图像。在灰度图像中,几乎所有的感兴趣目标,其内部像素都具有不同程度的灰度不一致度。对于显著目标而言,其内部区域的像素不一致度趋于一致,背景区域的像素也趋于一致,而目标和背景区域之间的不一致度存在差异。故选择基于灰度不一致性算子进行局部处理。局部处理将使得最显著的中心像素点的亮度变亮。

(1) 灰度不一致性

2010年,Ding等人[11]通过统计图像灰度的不一致性,提出了一种刻画图像纹理非均匀性的方法,即灰度不一致因子,简称NIF。

定义一幅灰度图像I,像素p=(px,py)∈I,I(p)表示像素p的灰度值,即亮度值,N(p)表示p的以κ(κ≥1)为边长的正方形领域。给定一个非负阈值(ε≥0),则像素p的κ领域中的所有像素可以被分成以下两个集合:

Ω(p)={q∈N(p):|I(p)-I(q)|>ε}Ω′(p)={q∈N(p):|I(p)-I(q)|≤ε}

(1)

像素不一致因子PIF(Pixel inhomogeneity factor)是用来描述任一个像素与其领域内其它像素的亮度差异性,PIF[12]公式如下:

(2)

式中|Ω(p)|表示在集合Ω(p)内的像素的个数,同理|N(p)|表示的是正方形领域内所有像素的个数。显然,0≤PIF(p)≤1,当|Ω(p)|<|Ω′(p)|时,0≤PIF(p)<0.5,这表明像素点p与它邻域内其它像素点的灰度差异性比较小;相反,当|Ω(p)|≥|Ω′(p)|时,0.5≤PIF(p)≤1,这表明像素点p与它邻域内其它像素点的灰度差异性比较大。

像素的灰度不一致因子NIF定义像素p的显著值:

(3)

其中 InNeb(p)={q∈N(p):PIF(q)≥0.5,p∈I}表示像素p周围的一个正方形邻域内的具有灰度不一致的像素数的集合。

灰度不一致因子NIF得到的函数值即为像素的显著值,任一像素点p的显著值用SLP表示:

SLP(p)=NIF(p)

(4)

经过大量的对比计算实验,取κ=3,非负阈值ε被设为ε=Ave(κ),其中:

(5)

(2) 局部显著图

由式(4)得到局部处理的显著图,如图1所示。

图1 两幅图像的局部显著图

图1中,(a)列是原图像,(b)列是局部处理后得到的局部显著图。从局部处理得到的显著图看,最显著的中心像素点亮度较高,但是显著目标内部部分区域弱化。从第二幅图像来看,部分非显著目标被突出,对于背景复杂的图像,冗余信息依然存在,故采取全局处理来解决其缺点。

2 全局处理

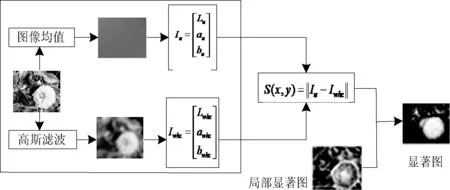

在对原图像局部处理的基础上,进行全局处理。全局处理采用改进的FT算法得到,如图2所示。

图2 全局处理流程图

基于改进的FT算法的全局处理步骤如下:

第一步对原图像进行高斯模糊。为了消除纹理细节以及噪声,选择5×5的二项式滤波器与原图像卷积,令原图像表示为f(x,y),其公式如下:

f1(x,y)=f(x,y)×G(x,y)

(6)

其中:

(7)

第二步颜色空间转换。提取图像的亮度、颜色和纹理特征,并把高斯模糊后的图像XYZ由sRGB颜色空间转换为CIELab颜色空间。Lab空间的设计接近人类视觉,其中的L表示亮度,与人对亮度的感知相匹配,a和b分量表示的是颜色。a,b用来调节颜色的平衡,L用于调整亮度。颜色空间转换的过程是先从sRGB空间转换到空间,再由XYZ空间转到Lab空间。

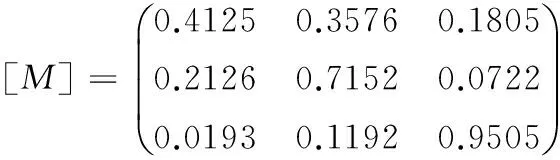

设M是一个3×3的矩阵,那么RGB到XYZ的转换关系为:

[X,Y,Z]=[M]×[R,G,B]

(8)

其中,M定义为:

(9)

rgb是RGB的原始的色彩分量,g是Gamma校正函数。

(10)

R=g(r),G=g(g),B=g(b),RGB的取值范围是[0,1),由式(9)-式(11) 计算得出XYZ的取值范围分别为[0,0.9506),[0,1),[0,1.0890)。

然后将XYZ空间转换到L×a×b空间:

先定义一个与Gamma函数相似的校正函数f(x):

(11)

X1、Y1、Z1是XYZ线性归一化的值,那么有XYZ到L*a*b的转换为:

L=116×f(Y1)-16

a=500×(f(X1)-f(Y1))

b=200×(f(Y1)-f(Z1))

(12)

第三步计算改进的FT算法的像素显著值。公式如下:

S″(x,y)=‖Iu(x,y)-Iwhc(x,y)‖

(13)

式中,Iu是高斯模糊图像在Lab空间的像素算术平均值,Iwhc是高斯模糊图像在Lab空间的值,‖‖是欧式距离。

第四步全局显著图。利用改进的FT算法,量化局部显著图,得到全局显著图S″。

3 空间权重

一般来说,像素的中心分布常被用于定位和估计显著区域,根据格式塔法则[13],视觉形式可能具有一个或几个中心图形。这表明接近注意焦点的部分被认为显著,远离注意焦点的部分被认为是背景。故提出中心优先[14]的概念,命名为空间权重[15],目的是滤除背景中的孤立显著区,同时进一步优化显著图的评估结果。

使用一个二维的高斯函数确定图像的中心,定义图像的高度为H,宽度为W,高斯函数在二维空间定义为:

(14)

图3 空间权重图

图像中任意像素p的最终显著值是全局显著图与空间权重图线性处理得到,公式如下:

S(p)=S″(p)G(p)

(15)

其中G(p)为像素p在空间权重图中的像素值。经空间权重处理后,去除了孤立显著区域的影响,显著图效果较好。

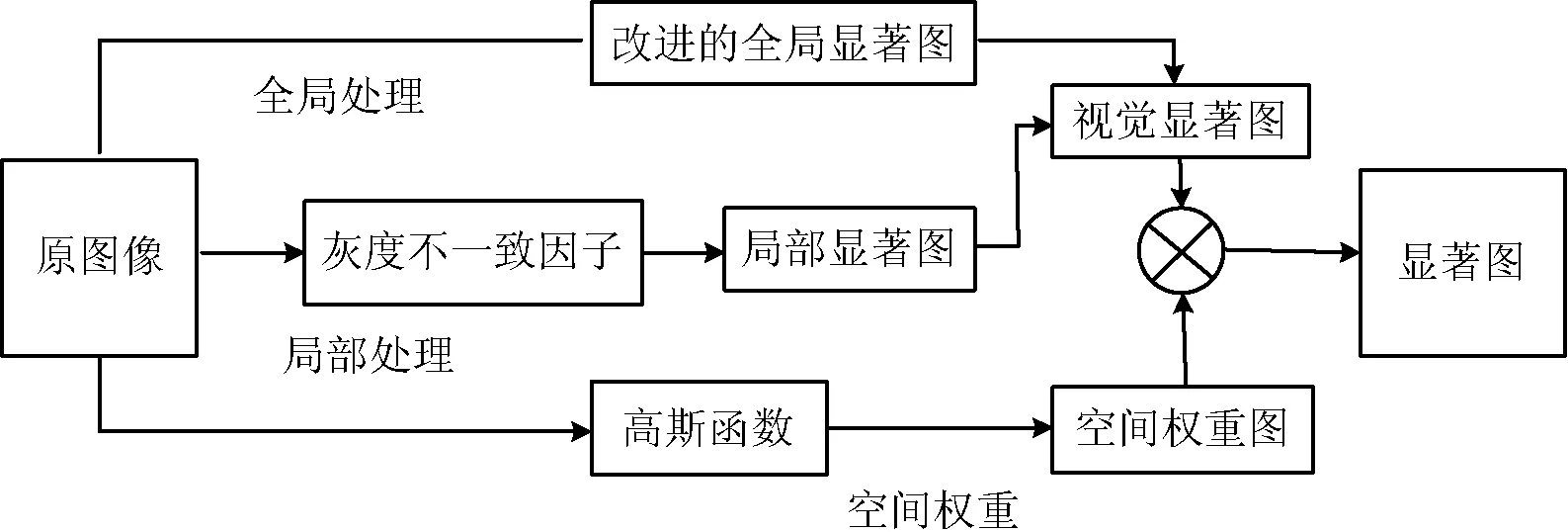

4 新的目标显著性检测算法

该算法首先采取基于灰度不一致算子的局部处理,得到局部的像素显著值;然后,在局部处理的基础上采用全局方法量化显著图,得到新的全局显著值;最后,引入空间权重,去除孤立显著区。算法流程如图4所示。

图4 新算法流程图

第一步对原图像进行局部处理,利用灰度不一致因子(NIF)获得局部方法的显著图。经局部处理后,最显著的像素点变得更亮。

第二步全局处理,提出改进的FT算法作为全局量化方法,使得显著区域增强。

第三步利用二维高斯函数得到空间权重图,将其与全局显著图进行加权处理,得到最终的显著图,使得显著区与背景差对比度提高。

5 实验分析

本实验是从MSRA数据库中选取1000幅图像,这1000幅自然图像均有所对应的人工精确标注的显著性区域。本实验中,将新算法与传统的显著性检测算法Itti、GBVS、SR、AIM、CAS和FT在这1000幅图像上进行仿真得到显著图。

5.1 显著图的比较

七种算法的显著图比较如图5所示。其中,(a)列是原图像,(b)列是Itti算法的显著图,(c)列是GBVS算法的显著图,(d)列是AIM算法的显著图,(e)列是SR算法的显著图,(f)列是CAS算法的显著图,(g)列是FT算法的显著图,(h)列是新的整性算法的显著图。

图5 七种算法的显著图的比较

从图5中看出,新算法的显著图最好,显著目标最突出,含有的背景冗余信息最少。而传统的显著性算法,例如Itti算法,GBVS算法和AIM算法只考虑局部对比度,显著图中的某些显著区域的对比度较高,但是显著区域的边界并不清晰,对于背景较复杂的图像,背景差对比度较差。基于频域分析的SR算法因为没有保留充足的高频信息,致使显著区域的边界模糊。考虑全局特征对比的CAS算法和FT算法的显著区域尽管保留了较完整的轮廓,然而显著区域弱化,最显著的位置被抑制。新算法的显著图中,显著区域与背景区域对比度提高,显著区域整体显著度较高,并且显著区域的边界清晰,显著图的效果最好。

5.2 显著图的性能评估

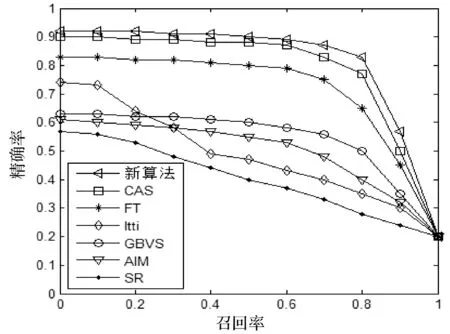

选用两个指标,即精确率和召回率来客观评价新的目标显著性检测算法与其他六种算法。这些算法均在这1 000幅图像上计算精确率和召回率,并绘制P-R曲线如图6所示。

图6 六种算法和新算法的精确率和召回率曲线

图6中的精确率和召回率曲线明确地展示出提出新的目标显著性检测算法的性能明显优于其他的六种算法。新算法的最小召回值比其他算法高,说明此算法得到的显著图最平滑,显著图中包含较多的显著值为255的像素,表明背景差对比度较高。其中本数据库中SR算法的显著图中显示目标的效率最低,其次是Itti和AIM算法。

6 结 语

新的整形目标显著性检测算法,包括局部和全局处理,然后是空间权重作为补充手段。显著区域得到了强化,最显著中心像素的亮度得到了增强,背景差对比度得到了提高。最后空间权重对视觉显著图做线性处理,有效地去除了孤立显著区的影响,得到最终的显著图,显著区域的边界更加清晰,显著图的性能得到了优化。新的整性算法简单、高效,通过定量和定性实验分析,该算法是可行的,并且优于其他六种显著算法。

[1] Tao D,Tang X,Li X,et al.Asymmetric bagging and random subspace for support vector machines-based relevance feedback in image retrieval[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(7):1088-1099.

[2] Yeh Hsinho,Liu Kenghao,Chen Chusong.Salient object detection via local saliency estimation and global homogeneity refinement[J].Pattern Recognition,2014,47(4):1740-1750.

[3] Triesman A M,Gelade G.A feature-integration theory of attention[J].Cognitive Psychology,1980,12(1):97-136.

[4] Koch C,Ullman S.Shifts in selective visual attention: towards the underlying neural circuitry[J].Human Neurbiology,1985,4:219-227.

[5] Itti L,Koch C,Niebur E.A Model of Saliency-Based Visual Attention for Rapid Scene Analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[6] Harel J,Koch C,Perona P.Graph-based visual saliency[J].Neural Information Processing Systems,2007,19(1):545-552.

[7] Hou Xiaodi,Zhang Liqing.Saliency detection:a spectral residual approach[C]//IEEE Conference on Computer Vision and Pattern Recognition,Shanghai Jiao Tong University,2007:1-8.

[8] Achanta R,Hemami S,Estrada F,et al.Frequency-tuned salient region detection [C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Los Alamitos: IEEE Computer Society Press,2009:1597-1604.

[9] Bruce N D B.Features that draw visual attention: an information theoretic perspective[J].Neurocomputing,2005,65(3):125-133.

[10] Goferman S,Zelnik-Manor L,Tal A.Context-aware saliency detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.San Francisco:IEEE Computer Society Press,2010:2376-2383.

[11] Ding Jundi,Shen Jialie,Pang HweeHwa,et al.Exploiting intensity inhomogeneity to extract textured objects from natural scenes[C]//Asian Conference on Computer Vision.Springer-Verlag,2009:1-10.

[12] 郭东岩,赵春霞,李军侠,等.结合图像显著与灰度不一致性的目标自动提取[J].南京理工大学学报,2014,38(5):701-706.

[13] Koffka,Kurt,Koffka K.Principles of Gestalt Psychology[M].Routledge,1999.

[14] Yang Weibin,Tang Yuanyan,Fang Bin,et al.Visual saliency detection with center shift[J].Neurocomputing,2013,103:63-74.

[15] Zhang Yongdong,Mao Zhendong,Li Jintao,et al.Salient region detection for complex background images using integrated features[J].Information Sciences,2014,281(10):586-600.

ON OBJECT SALIENCY DETECTION ALGORITHM BASED ON INTEGRAL FORM CHARACTERISTICS

Hu Yulan Huang Li Pian Zhaoyu

(School of Information Science and Engineering,Shenyang Ligong University,Shenyang 110159,Liaoning,China)

Aiming at the problems in traditional object saliency detection algorithms that the salient region is weakened, the most salient pixels are suppressed, and the contrast of background difference is low, etc., we proposed a new integral form object saliency detection algorithm. First, the algorithm utilises the gray inconsistency operator as the means of local processing to depict the non-uniform of local texture, which makes the brightness of the most salient pixels be increased; Secondly, it uses the improved FT algorithm to set up a new global quantification approach, this makes the salient area be significantly enhanced; Thirdly, in order to filter out the influence of the isolated salient areas, the algorithm proposes a spatial weight expression method to carry out linear processing on the saliency map mentioned so as to improve the contrast between the integral salient area and the background. In final simulation experiments, compared with 6 typical object salient detection algorithms including FT, ITTI, etc., the proposed algorithm not only has better recognition accuracy and stability, but also has higher advantage in objective indicators of precision rate and recall rate, therefore indicates that the proposed algorithm is feasible.

Object saliency detection Gray inconsistent factor Space weight

2015-06-04。国家自然科学基金项目(61373089)。胡玉兰,教授,主研领域:图像信息处理,模式识别,人工智能。黄梨,硕士生。片兆宇,副教授。

TP391

A

10.3969/j.issn.1000-386x.2016.11.048