一种OSS信息模型客观评价方法和工具

2016-12-26黄鹂声汪文勇

黄鹂声 王 烨 赵 强 汪文勇

1(电子科技大学计算机科学与工程学院 四川 成都 611731)2(中国移动通信集团公司 北京 100032)3(中国工程物理研究院计算机应用研究所 四川 绵阳 621900)

一种OSS信息模型客观评价方法和工具

黄鹂声1,3王 烨2赵 强3汪文勇1

1(电子科技大学计算机科学与工程学院 四川 成都 611731)2(中国移动通信集团公司 北京 100032)3(中国工程物理研究院计算机应用研究所 四川 绵阳 621900)

为了对海量的OSS(运维支撑系统)数据进行管理、存储和分析,各个机构和组织提出了多种OSS信息模型。对于运营商而言,如何评价这些信息模型的优劣成为了一个重要挑战。提出一种针对OSS信息模型的客观评价体系及评价工具,与现有评价方法相比,该评价方法是一个完全客观的评价体系,能够对OSS信息模型进行自动化客观评价,不需要任何人工参与。实际应用表明该模型和工具对运营商有较强的应用价值。

运营支撑系统 信息模型 信息模型评价 信息模型优化 评价工具

0 引 言

随着宽带网络运维支撑系统OSS的不断发展,OSS积累的信息量日益庞大,对OSS信息的管理和挖掘也日益受到重视。因此,OSS信息建模成为一项重要的基础工作。网络管理信息模型是网络管理的重要组成部分,其质量的好坏将直接影响网络管理的信息质量,并进一步影响整个网络管理系统的开发与应用,因此有必要对网络管理信息模型质量进行评价。从网络管理的需求出发,研究OSS信息模型的评价体系已成为一个重要的研究课题。

此前的研究已经提出了若干针对信息模型的评价体系,但大多为概念模型,在实际评价过程中难以应用;而且大多数现有评价指标为主观评价指标,评价过程需要大量人为参与,不利于快速、自动化评价。在实际应用中,运营商往往需要一种完全客观的评价方法,能够自动地分析并评价不同厂商提出的信息模型,并且对新设计的信息模型进行质量分析和改善。与此同时,目前国内外还没有一款正式应用的OSS信息模型自动化评价工具。

本文在研究现有信息模型评价体系的基础上,提出了一种新的客观评价体系,设计了相应的客观评价指标,并设计了一款完全自动化的OSS信息模型评价工具。本文工作的目的是能够为运营商提供一种完全自动化的客观评价体系和工具,协助运营商对OSS信息模型进行评价、选择和设计优化。

1 现有信息模型评价体系

1.1 信息模型评价背景

ITU-T X.720[1]提出网络管理信息模型是管理资源的抽象,就像一个“交互中心”,管理功能并不直接与网络资源交互,而是通过信息模型,由信息模型对资源直接进行操作。

信息模型质量评价是网络管理基础研究的主要内容之一,目前的网络管理方法和系统还没能很好地解决信息模型质量评价问题。在新一代网络的网络管理中,这个问题将会显得更加突出。例如,缺少指标对已有信息模型进行评价,缺少指标对多个信息模型进行评价比较以确定哪个更适合投入使用,缺少指标或方法对实施的建模过程进行控制等。可以说,对于运营商而言,OSS信息模型质量评价研究的现实需求极为迫切。

信息模型评价对信息模型的完善、运营支撑系统的优化实现起着重要作用。它可以用于:

(1) 估计使用不同管理信息模型的管理系统的集成难度。

(2) 为已知模型案例选择一个最合适的管理信息模型。

(3) 为管理信息模型的设计提供一个框架:可以帮助构建新的信息模型。评价体系可被视为设计新管理信息模型的模版,同时又可以增强已经存在的模型[2,19]。同时,对信息模型的评价为运营商提供了整合各类OSS信息的可行途径[3,20]。

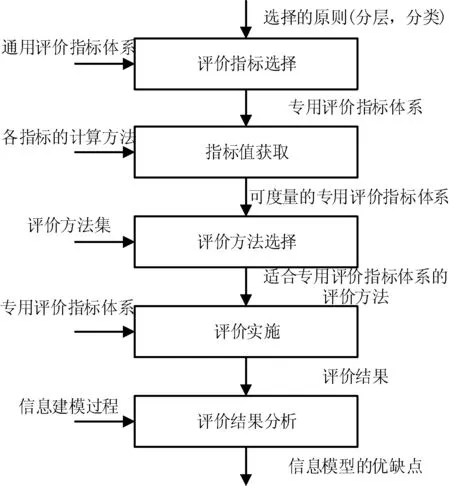

信息模型质量评价过程分为若干阶段,且上一阶段的成果即是下一阶段实施的基础。评价的一般过程如图1所示分5个阶段,分别为:评价指标选择、指标值获取、评价方法选择、评价实施、评价结果分析。

图1 信息模型评价过程

1.2 现有评价体系

网络管理信息模型质量评价的相关研究目前仍然处于理论阶段。现有的评价体系主要包括以下几类:

1) 经验评价法与非经验评价法

一些研究机构和会议推动着信息模型评价策略的发展,其中包括:Method Engineering,Workshop on Evaluation of Modeling Methods in Systems Analysis and Design,CRIS(Comparative Review of Information Systems) series等[1-3]。这些策略可以分为两类:非经验评价与经验评价。

非经验评价包括:特征对比法——这种策略给出了一个特征列表,用以评价不同的信息模型,该方案的优点是易于操作,而缺点则体现为其带有一定的主观性;元模型化——以信息模型的元模型作为对比评价的基础,该方案比特征对比法更加客观;本体评价法等。

经验评价包括:调查法——此策略通过问卷调查来统计评价数据,进而得出结论;实验室法——通过试验独立影响变量的方式来评价信息模型,其优点是方便控制;此外,又有案例研究法和行为研究法等[3]。

在实际应用中,往往对上述两种策略进行综合应用,即:部分评价指标为非经验指标,而其他指标为经验指标。

文献[4]中Wand等提出了用本体的概念来评价信息模型的方法。其基本理念是通过基于本体构架的匹配来评价已有的构架。Wand等指出在本体构架和模型构架间应该存在一对一映射。基于本体论的信息模型评价方法具有一定通用性,但强调的是信息模型的语法、本体的完整性和清晰度,基于本体的OSS信息模型成功案例尚不多见文献[13,16]。

2) EURESCOMTRS评价方法

文献[5]定义了一种评价电信管理网TMN(Telecommunication Management Network)信息模型的方法:TRS(Technical Review Session),在欧洲EURESCOM 计划中的P609 项目( 1995~1997)中提出。TRS通过几个视点进行评价:语法、ITU(International Telecommunications Union)X.722标准及GDMO(Guidelines for Definition of Managed Objects,被管对象定义指南)的正确使用、GDMO的合理智能应用,以及目标的适用性等方面,其中重点在于面向GDMO的评价方法。

在文献[5]中的第4卷(Annex C-Quality Metrics for GDMO based Information Models)中定义了若干对信息模型的评价指标(Quality Metrics, QM):类的复杂度WMC(Weighted Methods /attribute operations/actions/notifications per Class)、继承树的深度DIT(Depth of Inheritance Tree)、类的孩子数量NOC(Number Of Children)、对象间的耦合程度CBO(Coupling Between Objects)、关联复杂度AC(Association Complexity)。文献[6]中,Terence Turner对TRS方法做了进一步的介绍与总结。

3) 基于GDMO的评价方法

Czamecki等提出了一组用于评价基于管理对象定义标准GDMO的管理信息模型的评分标准[7]。同时提出一套比较标准来评价3个基于GDMO的管理信息模型(MIM):NMF网络模型、ITU-TM.3100[8]模型以及ETSI GOM模型,为三种模型选择了合适的网络管理类,并以一个简单的SDH 网络作为例子进行分析。该文中提出了一个指标体系,由分为 A、B、C、D、E 五个类别的 24 个指标组成,用于管理信息模型的评价对比。

4) 通用评价模型

文献[9]提出一个通用的评价模型,给出网络管理信息模型质量的定义,并提出相应的质量评价指标。指标被分为 3 级,从上到下逐步细化成可以进行定量度量的子特性。若干指标形成一个分层分类的树状评价指标体系。该指标体系是一个基本框架,旨在建立网络管理信息模型质量评价指标的层次结构和通用方法。因此,该评价模型是一个理论模型,在使用过程中需要根据被评价信息模型进行扩展和修改[12]。

5) 面向NGOSS的信息模型评价体系

文献[10]结合新一代运营支撑系统的特点与需求,提出了一个完备的模型综合评价体系,该评价指标体系遵从新一代运营系统与软件NGOSS (New Generation Operations Systems and Software)的 4 个视图[11]。总体上,NGOSS 评价体系分别从业务视图、系统视图、实现视图和部署视图出发,来反映不同使用者的关心点。其中:由业务视图评测信息模型对于运营需求的满足程度;系统视图则完成模型本身特性的度量;实现视图用于检验模型的有效性,对实现方面的支持;部署视图评价运行时的相关指标。对模型的评价可以从不同的视图出发。

TMF提出了共享信息数据共享信息数据模型SID(Shared Information/ Data Model)[11],SID是NGOSS提出的建立共享信息模型的通用框架,分别从商业和系统两个视点描述了共享信息模型。它不仅对业务过程中所涉及的各种信息进行抽象分析,而且还使用了UML对共享信息进行建模,为聚合业务实体定义了对象、属性等,为OSS提供了信息共享的基础。

目前在运营商领域,普遍将SID作为信息模型的蓝本和对比评价标准。

1.3 现有评价体系的不足

虽然针对信息模型的评价方法众多,但大多难以被运营商直接应用,原因在于:

(1) 概念指标过多:现有评价体系的各项指标众多,但大部分为概念指标,缺少必要的、可操作的计算方法和数据来源。

(2) 主观指标为主:大部分评价指标都是主观指标,即:评价过程需要领域专家参与,根据主观评分决定评价结果[15]。

(3) 工具匮乏:正因为现有评价体系大多不具备实际操作性,因此迄今为止国内外还没有一款被正式应用的OSS信息模型质量评价工具。

2 信息模型客观评价体系设计

针对现有评价体系可操作性不强,评价工具匮乏的问题,本文提出了一种完全客观的评价体系,设计了相应的评价工具,以下分别阐述。

2.1 客观评价体系设计

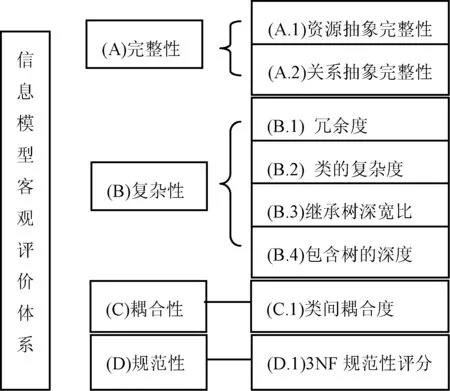

本文提出的客观的评价体系如图2所示。该评价体系的指标全部为客观评价指标,便于通过自动化分析工具进行自动化评估,质量评价指标体系共分2级,其结构如图2所示。

图2 信息模型质量客观评价体系设计

该评价体系包括4个大类共计8个指标,均为客观评价指标,关键指标的设计参考了现有国内外评价模型中的指标设计,并对评价过程进行了改进,摒弃了其中的主观评价部分。该指标体系既可用于单个信息模型的单独评价,也可用于信息模型之间的两两对比评价。

2.2 客观评价指标设计

以下对客观评价体系内的若干评价指标进行详细设计。

1) 完整性

资源抽象完整性旨在考察网管信息模型对被管资源的抽象是否完备,即信息模型中的抽象类是否覆盖管理功能所需的资源实体及其相互关系。具体的质量度量有两个。

(1) 资源抽象完整性

该度量考查信息模型对管理资源的覆盖程度及对管理功能的支持程度,其计算方法如下:

遍历所有资源实体,按照重要性(实体与其他实体之间的关系数量)分成三类:A(重要)、B(一般)、C(不重要),分别给定权值3、2、1,每类包含的管理资源计数为Na、Nb、Nc,由软件系统来判定这些资源在信息模型中是否有对应的抽象类,如果有匹配表示则计数Ma、Mb、Mc,定义资源抽象完整性评分为:

C=(3Ma+2Mb+Mc)/(3Na+2Nb+Nc)

(1)

且其最优值为1。

(2) 关联抽象完整性

OSS资源实体间存在的相互影响、相互作用的关系称为关联关系,这种关系表现在信息模型中就是对一个管理对象类的操作可能会影响到另外一个或几个管理对象类的性质和操作。该指标主要考查资源实体之间的关联关系在信息模型中是否得到正确反映,其计算方法如下:

a) 遍历资源实体间的所有关联关系,计数为n。

b) 遍历信息模型中抽象类之间的关联关系,计数为m。

c) 在信息模型中依次查找与资源关联关系相匹配的类间关联关系,计数为m1。

d) D1=m1/n表示现实中存在的关联关系在信息模型中的实现程度,其取值范围为[0,l],且最优值是1。

e) D2=m1/m表示信息模型抽象所得的关联关系中现实存在的关系所占的比例,以此判断信息模型抽象关联关系的正确程度,其取值范围为[0,1],且最优值是1。

f) 对D1和D2取平均值D:D表示信息模型对支持管理功能的管理资源本身抽象的完备性和合理性,其取值范围为[0,1],且最优值是1。

2) 复杂性

模型的复杂性和建模粒度反映信息模型中单个管理对象类的容量。复杂性旨在考查信息模型中管理对象类的粒度是否合适,以及信息的冗余度,这是判断信息模型对管理资源抽象是否合理的一个重要因素。

具体的质量度量有四个。

(1) 冗余度

信息模型冗余度定义为资源实体数量与模型中的抽象类数量的比值,一股来讲,建模粒度越细,这个数目越大。其计算方法是在抽象类中查找与资源实体匹配的类的数量,记为n,其最优值是资源实体的数量。

(2) 类的复杂度(建模粒度一致性)

建模粒度一致性考察抽象类建模粒度的一致程度,即:将一个抽象类内部的元素(如属性、动作、关系等)全部累加,表示该类的建模粒度;再用方差的形式表示信息模型中所有抽象类的建模粒度是否基本在同一等级上。其计算方法如下:

a) 将所有n个管理对象类内部的元素计数,得到R1,R2,…,Rn,R=(R1+R2+…+Rn)/n。

c) 定义k表示建模粒度一致性程度,计算方法为:

(2)

k值越大,表明一致性越好,k的最大值是1,若k<0,则取k=0。一般针对具体的信息模型,当k大于某一个百分比时就认为信息模型的建模粒度一致性是可接受的。

(3) 继承树的深度宽度比

继承本身就是一种重用。继承树是管理对象类之间继承关系的图形表示。它的深度(也称继承树的层次)反映了管理对象类整体的重用程度。若继承树越深,则底层的类所继承的属性和方法就越多,因此该类的预知行为会越多,类的设计就越复杂。另外,一定的继承又是必要的,因为继承避免了重复设计。因此有必要考虑继承树的深度,其计算方法是从继承树的根节点到叶结点为止计数树的深度n,其最优值是一个针对管理资源和用户要求的合适的值(本文取值为7)。

(4) 包含树的深度

包含树是管理对象类实例之间包含关系的图形表示,它的深度(也称包含树的层次)反映了信息模型整体的建模粒度。一般而言,粒度越细,包含树越深,粒度越粗,包含树越浅,因此可以通过包含树的深度大致了解建模的粗细程度。其计算方法是从包含树的根结点开始到最底层叶子结点为止,包含树深度定义为n,其最优值是一个针对管理资源和用户要求的合适的值(本文取值为7)。

3) 耦合性

面向对象设计的一个重要思想是追求对象类的高内聚、低耦合,管理对象类也不例外。具体的质量度量只有1个:

类间耦合度

类间耦合度量考察模型中类之间的耦合程度,这里的耦合是由类间的关联关系产生的。类间耦合与类的设计相关,耦合越低,表明单个类的封装性越强,独立性越好。其计算方法如下:

a) 找出与某个类x有关联关系的其他类个数Rx;

b) 对模型中每一个类,采用 步骤a)的方法,找出n个Rx计数值,分别记为R1,R2,…,Rn,令:

R=(R1+R2+…+Rn)/n

(3)

其中R表示整体的类间耦合度量值,越小越好,针对具体的资源和用户需求,只要低于特定值就认为信息模型的类间耦合是可接受的。

4) 规范性

模型体系应遵从3NF等数据规范,重点以3NF为参照制定规范性指标。

3NF规范性评分

两两对比信息模型中每两个对象的属性,判断其是否存在可能违背3NF的冗余:

a) 信息模型中有n个类,定义为(C1,C2,…,Cn);

b) 以3NF规范扫描信息模型中所有类,不符合3NF规范的类计数为m,m初始值为0;

c) 令x=(n-m)/n,x为3NF规范性评分。

2.3 客观评价体系的适用

本评价体系适用范围:

(1) 对某个OSS信息模型进行综合评分,分值越高说明信息模型的质量越高;

(2) 对两个以上的信息模型进行分项比较和评分,评分高的模型质量更高。

适用限制如下:

(1) 评价对象为通过UML建模语言所描述的信息模型;

(2) 评价对象为抽象信息模型,不适用于具体网络或信息资源的实体模型;

(3) 评价对象仅仅为电信运营商OSS域信息模型。

3 信息模型客观评价工具

3.1 系统功能

信息模型评价工具严格遵循了本文提出的评价体系和指标计算方法。具备如下评价能力:

(1) 读取并解析UML文档:能够识别UML语法词法并解析UML信息模型中类、属性及其各类关联关系。

(2) 抽取物理数据库并生成UML抽象模型:根据运营商的实际环境和需求,工具能够从Oracle/SQL Server/Mysql等数据库中抽取表、属性、各类外键和关联,并自动生成与之匹配的UML模型文件。

(3) 单个信息模型独立评价:对单个信息模型进行独立的质量评价,给出缺陷分析。

(4) 多个信息模型对比评价:对多个模型进行对比评价,给出被评价模型的相对评分和缺陷分析。

(5) 支持模糊匹配、智能匹配、同义词匹配等多种匹配方式,降低误判率。

3.2 应用效果

本文提出的信息模型评价工具已经成功应用于运营商对厂商模型的质量评价,并应用于某省运营商的信息建模优化过程。该工具包括两个版本:PC版和WEB版,目前已集成于OSS网管云平台,获得正式应用。在实际应用中取得如下效果:

(1) 通过完整性评价,发现某省OSS系统中存在若干管理缺失点,促进管理的完善;

(2) 通过复杂度评价,提出某省OSS系统的性能隐患并获得证实,协助提升了OSS系统性能。

4 结 语

本文研究了当前主要的信息模型评价体系,提出了完全客观化的OSS信息模型自动化评价体系,给出了若干客观评价指标和相应的信息模型自动评价工具。本文方法和工具有利于提升OSS信息建模的质量。本文提出的模型虽然尚未获得国际组织认可,但已构成OSS运营商内部标准体系一部分。

[1] ITU-T Recommendation X. 720-1992, Open system inter connection-structure of management information: management information model[S].

[2] Czarnecki P, Jajszczyk A, Wilkosz M. Comparison criteria for management information models (MIMs): a way of analyzing MIMs[C].Network Operations and Management Symposium, 1996., IEEE. IEEE,1996,3:666-673.

[3] Siau K, Rossi M. Evaluation of information modeling methods—a review[C]//Proceedings of the Thirty-First Hawaii International Conference on System Sciences,1998,5:314-322.

[4] Wand Y, Weber R. An ontological analysis of some fundamental information systems concepts[C]//Proceedings of the Ninth International Conference on Information Systems,1988:213-226.

[5] EurescomProject P609-1997, TMN specification support annex E-TRS guidelines[S].

[6] Terence Turner. Towards more efficient TMN model development-TMN information model-quality evaluation[C]//Proceedings of NOMS’98.1998(4):256-262.

[7] Przemyslaw Czarnecki, Andrzej Jajszczyk, MarckWilkosz. Comparison criteria for management informationmodels (MIMs): a way of analyzing MIMs[ J/ OL] . IEEE Journal,1996(4):666-673.

[8] ITU-T Recommendation M. 3100-1995, Generic network information model[S].

[9] 吴格含,孟洛明,邱雪松.网络管理信息模型质量定义及评价模型[J].北京邮电大学学报,2003(4):19-23.

[10] 吴艳凌. 新一代网络管理信息模型评价体系的研究[EB/OL]. 中国科技论文在线. http://www.paper.edu.cn/download/downPaper/ 201005-619. 2015.

[11] TMF, New Generation Operational Support Systems Architecture Overview[S]. TMF GB920. 2000, 2005.

[12] 沈旺,国佳,李贺. 网络社区信息质量及可靠性评价研究——基于用户视角[J]. 现代图书情报技术,2013(1):74-79.

[13] 刘孟冬. 网络综合资源管理系统中大容量数据处理的设计与实现[D]. 山东大学,2013.

[14] 王毅. CMC集团管控模式研究[D]. 南京理工大学,2012.

[15] 项敏. 基于主观感知的互联网质量监测和评价系统[D]. 电子科技大学,2013.

[16] 李春林,黄月江.基于本体的网络管理策略生成方法研究[J]. 通信技术,2013(12):42-46.

AN OBJECTIVE OSS INFORMATION MODELS EVALUATION METHOD AND TOOL

Huang Lisheng1,3Wang Ye2Zhao Qiang3Wang Wenyong1

1(SchoolofComputerScienceandEngineering,UniversityofElectronicScienceandTechnologyofChina,Chengdu611731,Sichuan,China)2(ChinaMobileCommunicationsCorporation,Beijing100032,China)3(InstituteofComputerApplication,ChineseAcademyofEngineeringPhysics,Mianyang621900,Sichuan,China)

In order to manage, store and analyse huge operation support system (OSS) data, various institutions and organisations have presented different OSS information models. For service providers, how to evaluate the pros and cons of these information models has become a great challenge. We propose an objective evaluation system and evaluation tool targeted at OSS information models. Compared with existing evaluation methods, our method is a completely objective evaluation system, can evaluate OSS information models automatically and objectively without any human intervention. Practical applications show that the model and tool have higher applied value for service providers.

Operation support system Information model Information model evaluation Information model optimisation Evaluation tool

2015-09-23。教育部-中国移动科研基金项目(MCM 20123041,MCM20130661);计算机网络及应用四川省工程实验室研究基金项目(20140415)。黄鹂声,副研究员,主研领域:网络运维技术,网络测量。王烨,高工。赵强,研究员。汪文勇,教授。

TP393

A

10.3969/j.issn.1000-386x.2016.11.014