复杂场景下基于多特征融合的视频跟踪

2016-11-01丁建伟唐云祁田华伟张小博

丁建伟,唐云祁,田华伟,张小博

(1.中国人民公安大学,北京 102623;2.中国电子科技集团公司第三研究所,北京 100015)

复杂场景下基于多特征融合的视频跟踪

丁建伟1,唐云祁1,田华伟1,张小博2

(1.中国人民公安大学,北京 102623;2.中国电子科技集团公司第三研究所,北京 100015)

为了解决常见视频跟踪方法在复杂场景中难以有效跟踪运动物体的难题,研究了在粒子滤波框架下基于多特征融合的判别式视频跟踪算法。首先分析了特征提取和跟踪算法的鲁棒性和准确性的关系,指出融合多种特征能有效地提升算法在复杂场景中的跟踪效果,然后选择提取HSV颜色特征和HOG特征描述目标表观,并在线训练逻辑斯特回归分类器构造判别式目标表观模型。在公开的复杂场景视频进行测试,比较了使用单一特征和多种特征的实验效果,并且将所提算法和经典跟踪算法进行了比较,实验结果表明融合多种特征的视频跟踪更具鲁棒性和准确性。

视频跟踪;多特征融合;复杂场景

视频跟踪研究如何让计算机自动确定感兴趣的目标在连续图像序列中的位置、轨迹以及运动参数等信息。视频跟踪是计算机视觉的关键研究问题,其结果会促进视频分割、行为分析、场景理解等问题的研究。另外,视频跟踪还具有很高的应用价值,在智能视频监控、人机交互和车辆导航等多个领域具有广泛应用。

近年来,虽然视频跟踪研究有了长足的进步,但距离复杂场景下视频的鲁棒跟踪仍然有较远的距离。当场景中存在严重的图像噪声、快速的光照与姿态变化、相似物体干扰、复杂的目标运动以及遮挡时,现有的视频跟踪算法依然很难解决这些难题,原因在于跟踪的核心问题目标表观建模还没有得到根本解决。目标表观建模在对未知目标进行有效的视觉描述上依然存在很多不足。

对目标进行建模,首先需要进行视觉描述并提取特征,选择哪种特征对跟踪性能有着重要影响。在跟踪中常用的特征有原始像素特征[1]、直方图特征[2]和二值特征[3]等。每种特征都有其优缺点和适用场合。目前,研究者们还没有找到一种有效的特征使得跟踪对任意物体和场景均有效。

为了改正常见视频跟踪算法使用单一特征存在的缺点,提升算法在复杂场景中的性能,本文研究融合多种特征来构造视频表观模型,从而减少跟踪中的漂移或失败现象,提升跟踪算法的鲁棒性和准确率。

1 系统框架

为了更好地处理非线性非高斯运动,本文基于粒子滤波框架设计跟踪算法。在粒子滤波框架中,跟踪可以看作是贝叶斯状态空间推理问题

p(Xt|Ot)∝p(ot|Xt)∫p(Xt|Xt-1)p(Xt|Ot)dXt-1

(1)

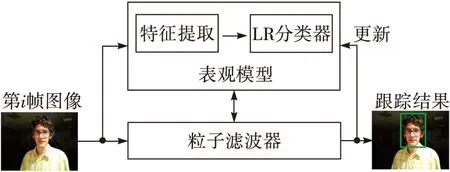

式中:Ot={o1,o2,…,ot}是目标的观测集合,ot是目标在t时刻的观测向量,且ot∈Rd×1。Xt描述的是目标在t时刻的状态参数,在本文中仅考虑目标的位置和尺度,因此Xt主要包括四个变量,即Xt=(xt,yt,ht,wt)。其中xt,yt,ht和wt分别表示目标在横轴和纵轴的位移,以及方框的长度和宽度。表观似然度函数p(ot|Xt)表示目标状态为Xt时观测为ot的概率,基于在线学习的目标表观模型计算而得到。目标动态模型p(Xt|Xt-1)表示连续帧之间目标状态的转移概率。图1是整个视频跟踪系统的算法框架。

图1 视频跟踪系统框架

(2)

根据权重分布函数的形式,可以选择不同的粒子滤波器。SIR粒子滤波器假设权重分布函数和观测无关,即

q(Xt|X1:t-1,Ot)=p(Xt|Xt-1)

(3)

将式(3)代入式(2)后,粒子的权重可通过对表观似然度p(ot|Xt)归一化得到。由于SIR粒子滤波器采样方式简单,因而得到了广泛应用,本文也采用SIR粒子滤波器。

在t时刻估计的最优目标状态为粒子集合中权重最大的那个粒子对应的状态参数,即

(4)

2 融合多种特征的表观模型

目标表观模型可分为生成式和判别式两种。基于生成式模型的视频跟踪算法在每一帧中寻找与目标模型最相似的区域,典型的生成式模型有子空间模型[1]和稀疏表达模型[4]等。而基于判别式模型的视频跟踪算法将跟踪视为前景和背景的二分类问题,通过在线学习得到的分类器,在当前帧中搜索与背景最具区分度的前景区域。典型的判别式模型有在线提升模型[5]等。由于判别式模型融合了背景信息,因而在跟踪时能够比生成式模型更好地区分相似物体的干扰,近年来成为跟踪研究的热点。本文选择判别式表观模型描述目标,具体包括特征提取和在线分类器学习。

2.1特征提取

为了得到更鲁棒的视频跟踪算法,本文提取多种特征来构造表观模型,这样可以克服单一特征造成的局限性,大大提高了跟踪算法在复杂场景下的准确性,并且可以减小跟踪产生漂移的可能。

通过分析跟踪中常用特征的优缺点,并且考虑到算法的实时性,本文选择融合HSV颜色特征和方向梯度直方图(Histogram of Oriented Gradient, HOG)[6]特征描述目标。

HSV颜色特征是基于HSV颜色空间提取的特征,包括色度(Hue)、饱和度(Saturation)和亮度(Value)。首先输入图像从RGB空间转化到HSV空间,然后采集样本图像并调整到标准大小,例如16×16像素,则对应的HSV颜色特征是16×16×3=768维度的向量,最后将该颜色特征向量进行归一化,记为xhsv。

HOG特征[6]通过计算和统计图像局部区域的梯度方向直方图来描述物体,对图像的几何和光学形变都能保持较好的不变性,因而在计算机视觉领域获得了广泛应用,特别是在图像检测领域取得了巨大的成功。由于原始的HOG特征提取比较费时,因此本文采用文献[7]描述的快速HOG特征提取方法,并对提取的HOG特征进行归一化,记为xhog。

将HSV颜色特征和HOG特征组合,即可得到目标图像的特征描述子ot=[xhog,xhsv]T。

2.2在线分类器学习

在判别式跟踪框架中,目标的表观似然度p(ot|Xt)一般由在线学习的二分类器计算得到,本文选择逻辑斯蒂回归(LogisticRegression,LR)分类器。LR分类器的输入是特征描述子ot,设输出的分类结果为y∈{0,1},其中数值0代表背景,数值1代表跟踪目标,则目标表观似然度由下式计算得到

(5)

式中:hw(ot)是输入为特征向量ot输出分类结果为y=1的概率,w∈Rd×1是LR分类器的模型参数。

在跟踪中目标的表观和场景都会发生较大变化,因此需要在线更新表观模型,从而保证模型具有最佳区分性能。在更新表观模型时,为了减小LR分类器训练时发生过拟合的情况,本文在定义损失函数L(w)时增加模型参数w的L2正则化项,即

(6)

(7)

式中:α为w的学习速率。

3 实验结果及分析

为了验证算法在复杂场景下跟踪目标的有效性,本文使用了公开的具有挑战性的跟踪测试视频[8],在这些视频中存在各种跟踪难题,包括快速光照变化、姿态变化、杂乱背景、局部遮挡和低质量图像等。本文设计了两组实验,首先比较了使用单一特征和多种特征的跟踪结果,然后将本文算法与其他几种经典的跟踪算法进行了比较。

3.1多种特征的有效性

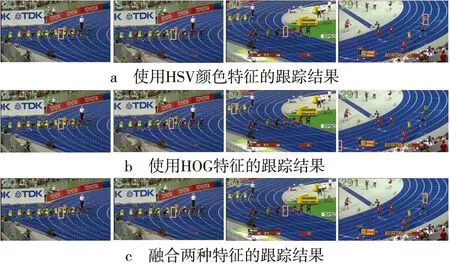

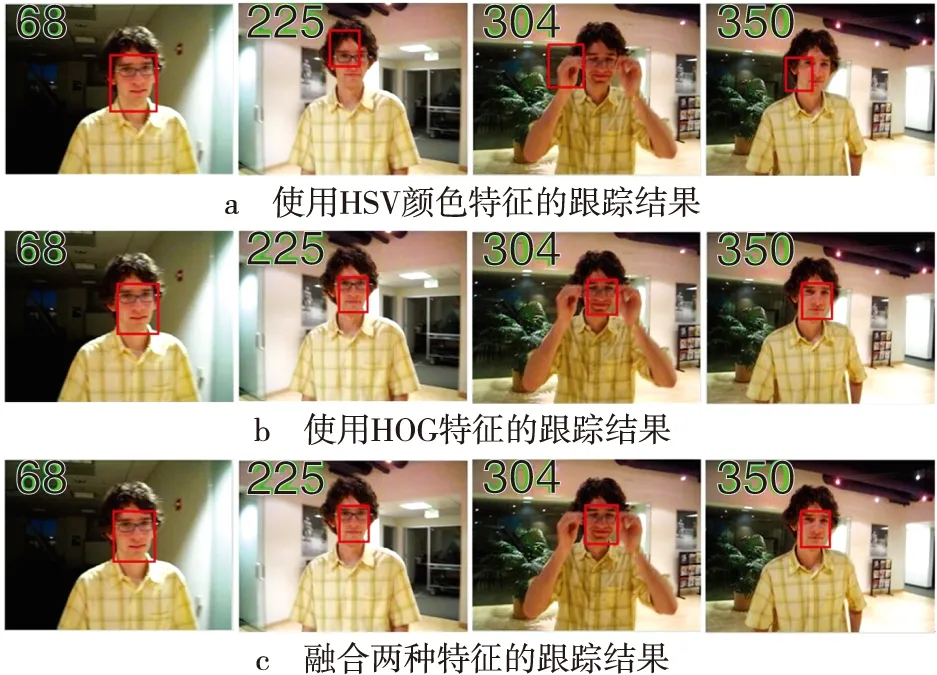

为了验证融合多种特征能够增强跟踪算法的性能,本文使用了视频“Bolt”和“David”进行了测试。图2和图3分别是在视频 “Bolt” 和“David”上使用不同特征的跟踪结果截图,图中第一行和第二行分别是仅使用HSV颜色特征和HOG特征的跟踪结果,第三行是融合两种特征的跟踪结果,图中数字代表图片序列号,方框代表估计的目标位置。

图2 在视频“Bolt”上使用不同特征的跟踪结果(截图)

图3 在视频“David”上使用不同特征的跟踪结果(截图)

在视频 “Bolt”中,跟踪目标是一名运动员,该运动员身穿的运动服颜色与周围运动员和场地具有较大差异性,因此使用颜色特征进行跟踪可以取得较好结果,而由于运动员跑动中姿态变化较大,因此使用HOG特征跟踪效果不太理想,图2的跟踪结果验证了该结论。可以看到第二行的跟踪结果从第5帧就开始出现了偏差,然后很快失去目标,而第一行和第三行的跟踪结果从始至终都是正确的。

在视频 “David”中,跟踪目标是人脸,由于该目标在运动中存在快速的光照变化,因此仅使用HSV颜色特征并不能很好地跟踪目标,由图3第一行的跟踪结果可以看出,在第225帧、304帧和350帧都出现了较大的跟踪误差;而HOG特征对光照变化具有较强的不变性,因此图3第二行和第三行的跟踪结果都是比较精确的。

由该组实验可知,在跟踪算法中融合多种特征可以增强算法在不同复杂场景下的鲁棒性。

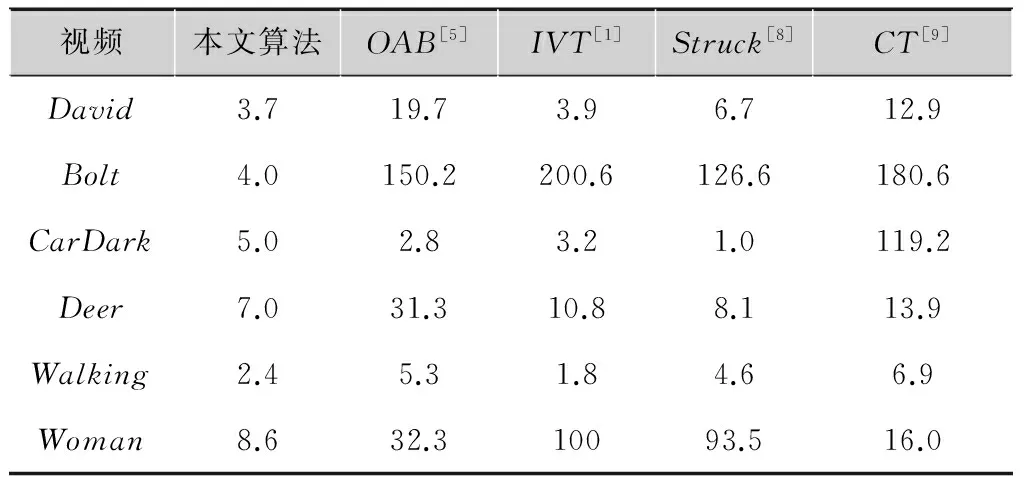

3.2与其他算法的比较

为了进一步验证基于多特征融合跟踪算法的有效性,将本文算法与增量式跟踪算法IVT[1]、在线Adaboost跟踪算法OAB[5]、结构化输出跟踪算法Struck[8]和压缩感知跟踪算法CT[9]进行了比较,共使用6组测试视频[10],跟踪目标包括行人和车辆等典型物体,视频中包括各种干扰因素,例如光照变化、姿态变化、尺度变化以及目标形变等,评价指标是跟踪中心误差均值,即标定方框与跟踪方框中心的欧氏距离,该值越小表明跟踪结果越好。表1是3种方法在测试视频上的跟踪中心误差均值比较结果。在6组视频中,本文算法取得了4组第一,并且在剩下的2组视频中与最好的结果相比也非常接近,可见本文算法在复杂场景跟踪典型物体具有较好的鲁棒性与正确性。

表13种方法在测试视频的跟踪中心误差均值

视频本文算法OAB[5]IVT[1]Struck[8]CT[9]David3.719.73.96.712.9Bolt4.0150.2200.6126.6180.6CarDark5.02.83.21.0119.2Deer7.031.310.88.113.9Walking2.45.31.84.66.9Woman8.632.310093.516.0

4 结论

本文研究了复杂场景中视频跟踪的难题,分析了特征提取与跟踪算法鲁棒性和准确性的关系。为了改正常见算法在复杂场景中仅使用单一特征很难有效跟踪目标的缺点,本文研究了基于粒子滤波框架融合多种特征的视频跟踪算法。本文选择融合HSV颜色特征和HOG特征,通过在线训练逻辑斯特回归分类器构造判别式目标表观模型。为了检验算法的有效性,选取了公开的典型复杂场景视频进行测试,并与经典的视频跟踪方法进行比较,实验结果表明使用多种特征能够提高算法的鲁棒性和准确性。

[1]ROSSDA,LIMJ,LINR-S,etal.Incrementallearningforrobustvisualtracking[J].Internationaljournalofcomputervision, 2008,77(1):125-141.

[2]COMANICIUD,RAMESHV,MEERP.Kernel-basedobjecttracking[J].IEEEtransactionsonpatternanalysisandmachineintelligence, 2003,25(5):564-577.

[3]LIX,SHENCH,DICKA,etal.Learningcompactbinarycodesforvisualtracking[C]//IEEEConferenceonComputerVisionandPatternRecognition.Oregon:IEEE, 2013:2419-2426.

[4]MEIX,LINGH.RobustvisualtrackingusingL1minimization[C]//IEEEInternationalConferenceonComputerVision.Kyoto:IEEE, 2009:1436-1443.

[5]GRABNERH,GRABNERM,BISCHOFH.Real-timetrackingviaon-lineboosting[C]//BritishMachineVisionConference.Edinburgh:BMVA, 2006:47-56.

[6]DALALN,TRIGGSB.Histogramsoforientedgradientsforhumandetection[C]//IEEEConferenceonComputerVisionandPatternRecognition.SanDiego:IEEE, 2005:886-893.

[7]DOLLARP,APPELR,BELONGIES,etal.Fastfeaturepyramidsforobjectdetection[J].IEEEtransactionsonpatternanalysisandmachineintelligence, 2014, 36(8):1532-1545.

[8]HARES,SAFFARIA,TORRPHS.Struck:structuredoutputtrackingwithkernels[C]//IEEEInternationalConferenceonComputerVision.Barcelona:IEEE, 2011:263-270.

[9]ZHANGK,ZHANGL,YANGMH.Fastcompressivetracking[J].IEEEtransactionsonpatternanalysisandmachineintelligence, 2014, 36(10): 2002-2015.

[10]WUY,LIMJ,YANGMH.Onlineobjecttracking:abenchmark[C]//IEEEConferenceonComputerVisionandPatternRecognition.Oregon:IEEE, 2013:2411-2418.

丁建伟(1984— ),博士,讲师,主要研究方向为视频图像处理、模式识别;

唐云祁(1983— ),博士,讲师,主要研究方向为视频图像处理、模式识别;

田华伟(1983— ),博士,讲师,主要研究方向为视频图像处理、信息安全;

张小博(1987— ),博士,主要研究方向为视频图像处理。

责任编辑:闫雯雯

Multiple features fusion for object tracking in complex scenes

DING Jianwei1, TANG Yunqi1, TIAN Huawei1, ZHANG Xiaobo2

(1.People′sPublicSecurityUniversityofChina,Beijing102623,China;2.TheThirdResearchInstituteofChinaElectronicsTechnologyGroupCorporation,Beijing100015,China)

To address difficulties of traditional object tracking methods which can′t track moving object effectively in complex scenes, a multiple features fusion based discriminative object tracking algorithm in particle filter framework is proposed. Firstly, the relationship between feature extraction and robustness and accuracy of tracking algorithm is analyzed, and points out that it can promote tracking performance largely by using multiple features in complex scenes. HSV color feature and HOG feature are selected to represent appearance of object, and the online trained logistic regression classifier is used to construct the discriminative appearance model. The method is tested in public videos with complex scenes. Results obtained by using only one kind of feature and multiple kinds of features are compared. And the proposed method with other classic tracking algorithms are compared. Experimental results show that the proposed object tracking algorithm with multiple features is more robust and accurate.

video tracking; multiple features fusion; complex scenes

TN941.1

ADOI: 10.16280/j.videoe.2016.10.019

国家自然科学基金项目(61503388;61402484;61503387);中国人民公安大学2016年度中央高校基本科研业务费项目(2016JKF01203)

2015-11-20

文献引用格式:丁建伟,唐云祁,田华伟,等. 复杂场景下基于多特征融合的视频跟踪[J].电视技术,2016,40(10):93-96.

DING J W, TANG Y Q, TIAN H W,et al. Multiple features fusion for object tracking in complex scenes[J]. Video engineering,2016,40(10):93-96.