集群NAS存储技术及在石油勘探高性能计算中的应用

2016-08-31汪生珠何庆兵欧阳欣

汪生珠 何庆兵 欧阳欣

集群NAS存储技术及在石油勘探高性能计算中的应用

汪生珠 何庆兵 欧阳欣

当前或今后,信息数据呈现爆炸式增长趋势,存储需求急剧膨胀,集群NAS磁盘存储技术及其产品应运而生。文章较为系统地阐述了传统NAS网络存储技术的优点及局限性,总结分析了目前集群NAS存储两种典型系统架构及其技术特点,对实际使用的集群NAS存储案例进行了剖析论述,并对网络存储技术的热点及其未来进行了展望。

信息呈现爆炸式增长趋势,存储需求急剧膨胀,文件大小和数据规模从TB级、PB级迈向EB级、ZB级已成现实。据IDC的统计,在快速增长的信息数据当中,基于文件类型的非结构化数据的增速极快,全球存储市场的总出货量中将有80%的容量被文件级数据所覆盖。由于非结构化内容的存储规模和复杂程度不断提高,它们使得传统存储系统捉襟见肘。另一方面,非结构化数据具有传统存储系统在设计时并未考虑到的独特特征,包括大型文件和数据量、高吞吐量要求、读取密集型访问方式以及大量并行文件访问。

在石油天然气能源开采行业,随着地震勘探技术的进步和勘探成功率要求的提高,地震勘探的数据采集道数越来越多,随之带来地震采集数据的海量增加。其次,地震资料处理技术也在不断发展和提高,处理的环节越来越复杂,随之产生了大量地中间和成果数据。如高密度空间采集、三维连片资料处理、多波地震勘探、海洋地震勘探等,与4年前比,同样面积的工区,由于采样间隔和道距越来越小、覆盖次数越来越高,地震数据量增加了4~6倍。这些因素都对存储提出了更高的需求。

为此,集群存储、并行存储技术应允而生,其性能可随着存储容量的增加而线性增加,是解决海量非结构化数据存储的理想方案。

NAS存储技术特点分析

NAS(Network-Attached Storage,网络接入存储)采用TCP/IP网络技术,通过网络交换机连接存储系统和服务器主机。随着IP网络技术的发展,NAS存储技术发生了质的飞跃。万兆以太网及InfiniBand网络的出现和投入商用,存储网络带宽大大提高了NAS存储的性能。另外,由于NAS存储采用TCP/IP网络进行数据交换,TCP/IP是IT业界的标准协议,不同厂商的产品(服务器、交换机、NAS存储)只要满足协议标准就能够实现互联互通,无兼容性的问题。

然而,传统NAS存储受到其物理组成(如控制器性能、总线性能、磁盘驱动器的数量、所连接服务器的数量、内存大小以及NAS头的性能等)的限制,以及功能上的局限(如支持文件系统的容量、元数据和数据处理通路的耦合、快照或复制的数量等),造成存储系统瓶颈 。为解决这种单个NAS系统的性能局限性和整个数据带宽瓶颈,一是采用硬件更加强大的单个存储系统,即所谓不断向上扩展(Scale-up,也称纵向扩展)的模式。然而,由于业务和数据的大量增加,尽管单台NAS的最高容量已经达到了PB级,但仍难以满足要求,这种不断向上扩展的模式几乎已走到尽头。二是面对越来越多的数据,企业用户只好不断购买越来越多的NAS存储,这样一来,NAS存储就像以前的DAS和SAN一样 ,形成了新的“数据孤岛”——多文件系统、多命名空间、多个挂载点。这给企业应用和系统管理都带来了诸多不便。

于是,横向扩展(Scale-out)的NAS存储技术,即集群NAS应允而生。采用若干个普通性能的存储系统来组成“存储的集群”,可提供按比例增加存储资源的性能、容量、可靠性及可用性,突破了单机设备的各种限制,并且具有容量和性能线性扩展的优势。这就犹如CPU技术,从不断提高频率转变为增加内核。

集群NAS存储的实现方式

从整体硬件架构及采用的核心文件系统看,比较成熟和典型的实现方式有两种:即SAN共享存储架构和全对称集群系统架构。

SAN共享存储架构

这种架构的核心是采用SAN(Storage Area Network,存储区域网络)模式,如图1所示。后端是由几个大的专用磁盘箱及其控制器部件构成存储池,前端是由几个通用的机架式x86服务器节点构成集群交互(接口)节点,两者(后端和前端)通过FC存储交换机相连接。软件上采用SAN并行文件系统(如GPFS、StorNext等)进行管理。采用这种架构的集群NAS典型案例如IBM SONAS、QUANTUM IPS。

由于采用了高性能的SAN存储网络,这种集群NAS架构可以提供稳定的高带宽和I/O性能,且可通过增加磁盘箱实现存储容量的扩展;可通过增加交互节点实现性能的扩展。

全对称集群系统架构

这种架构也称“全对称分布式架构”,如图2所示。用这种架构的集群NAS典型案例包括EMC Isilon、华为OceanStor 9000等。

图1 SAN共享存储架构

图2 全对称集群系统架构

这种架构看上去很简洁,集群中的每个硬件节点(即存储节点)就好像一台2U或4U的机架式服务器,上面插了几十块硬盘,每个节点都有独立的CPU、内存、网络接口等,集群中每个节点的配置完全是相同的。节点之间通过万兆或IB(InfiniBand)网络进行后端互联,每个节点也有供用户业务访问的万兆或IB网络接口。由安装在每个节点上的集群文件系统软件(如Isilon的OneFS、华为的WushanFS等)统一管理物理分布的存储空间而形成一个单一命名空间的供用户使用的文件系统。为了提高数据检索性能,元数据通常放在性能较高的SSD固态磁盘上。

在这种架构下,集群NAS在性能和容量两方面的扩展都是通过增加存储节点来实现,很多系统可以达到接近线性地扩展。由于服务器和存储介质都可采用通用标准的廉价设备,在成本上有很大优势,规模巨大。

集群NAS存储应用

在上文中提到IBM SONAS存储阵列是属于“SAN共享存储架构”的集群NAS的典型代表,长庆油田研究院于2012年引进并投入使用了一套IBM SONAS存储系统。下面就IBM SONAS的概况、运行机制及使用情况进行介绍和阐述。

SONAS系统概述

SONAS,即为 Scale Out NAS的缩写。不难看出IBM命名的用意,即SONAS属于横向高可扩展的网络连接存储。它是以 IBM GPFS 并行文件系统为核心的横向扩展文件型存储解决方案,它将多个 SAN 存储整合到同一命名空间,从而建构一个可高速并行共享访问的存储系统。它具备横向动态扩展存储容量、横向动态扩展 I/O 性能和分层存储管理能力。SONAS 提供 CIFS、NFS、SCP、FTP 和 HTTP 等多种网络访问接口,最大可管理 10亿个文件,提供 14.4PB 磁盘空间(假如单盘采用2TB),可在数十个物理存储阵列间建立起统一共享的存储命名空间。SONAS 拥有丰富的信息管理功能,包括快照、复制,与自含 TSM 数据备份接口用于数据备份保护,与 IBM 磁带库系统配合可将历史信息自动迁移到磁带库等。

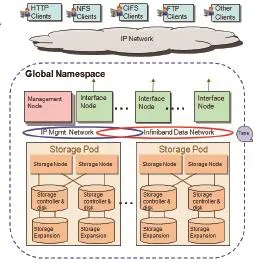

整体上讲,SONAS硬件由管理节点、接口节点、存储节点、控制器及磁盘箱、扩展磁盘箱及连接这几部分的网络构成,软件主要是采用GPFS共享文件系统。图3即为SONAS的体系架构。

管理节点提供整个SONAS的配置管理。接口节点对外提供了基于IP的主机客户端连接。存储节点是连接SONAS控制器箱的网关。管理节点、接口节点、存储节点是通过高性能、低延迟的InfiniBand网络互联。管理节点、接口节点、存储节点都可以采用通用的x86架构系列的机架式服务器(如IBM x3650)来承担。为了实现系统性能和容量的高可扩展性,接口节点、存储节点、控制器及磁盘箱、扩展磁盘箱都是可以分别进行扩展的。交互节点、存储节点可以分别达到30个之多。

以上硬件部件再配置上GPFS共享文件系统,就构成了一个基于SAN的共享存储架构系统。

SONAS应用案例

这套系统的裸容量为240TB(含120块2TB的NL SAS盘),系统主要包括1个管理节点、4个接口节点、2个存储节点、1个双控制器箱(60个磁盘位)、1个扩展磁盘箱(60个磁盘位)。图4展示了本案例的硬件构成部署情况。

运行及应用效果分析

系统搭建完成后,对存储系统的读写性能进行了实际测试。下面简要介绍测试的环境和测试结果。

(1)测试的硬件环境

存储 120块NL SAS硬盘,2TB,7200RPM网络 4个接口节点,每个节点6块千兆以太网卡内存 4个接口节点,每个节点32GB内存测试机配置SoNAS配置48个HP BL460C G7服务器,每片2个千兆以太网口,28GB内存Red Hat Enterprise Linux Server release 5.5内核2.6.18-194.el5

(2)测试场景设计

通过pssh命令同时在32个刀片节点发起dd命令来测试读写性能。共设计了三个测试场景。

a.写性能测试

该测试场景考察写性能,在32个刀片节点同时发起dd操作,每个节点写入的文件名各不相同:

节点名 n1 n2 n3 … n30 n31 n32写入文件名 f1 f2 f3 … f30 f31 f32

b.互斥读性能测试

该测试场景考察读性能,在32个刀片节点同时发起dd操作,每个节点读取的文件各不相同。

节点名 n1 n2 n3 … n30 n31 n32读取文件名 f2 f3 f4 … f31 f32 f1

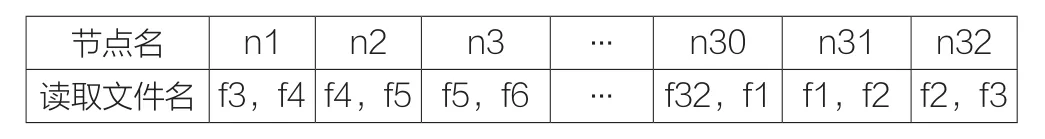

c.交叉读性能测试

该测试场景考察读性能,在32个刀片节点同时发起dd操作,每个节点读取的文件有交叉,用于考察interface node上cache命中率较高时的服务能力。

节点名 n1 n2 n3 … n30 n31 n32读取文件名 f3,f4 f4,f5 f5,f6 … f32,f1 f1,f2 f2,f3

(3)测试结果

a.平均聚合带宽

我们在N个节点,共发起N个线程进行读写。每个线程的数据量记为C,完成时间记作t1,t2,…tN。按以下两种方式统计并发带宽:

结果如下:

写性能 互斥读性能bandwidth1 869.35 1401.05 bandwidth2 912.75 1400.89

b.峰值聚合带宽

由于各读写线程难以完全同步,聚合带宽从时间上是一个逐渐降低的过程。为了衡量SoNAS的I/O能力,我们在运行中期进行实时监控,记录峰值聚合带宽,数值如下:

写性能 互斥读性能 并发读性能聚合带宽(MB/s) 998.42 1556.48 2539.52

图3 SONAS 体系架构

图4 SONAS案例硬件部署

这套系统是用于油田石油天然气勘探地震资料处理高性能运算,通过以上测试,结果完全满足当初设计要求。近几年的实际应用,目前存储数据量已达157TB,占总可用容量170TB的92%,性能上也完全满足本单位的科研生产需要。

SoNAS集群存储系统投入使用后,多项处理作业同时运行时,显著地提高工作效率高达6倍,使用户的应用程序和作业性能达到最佳化。这套解决方案使计算集群中的每个结点都能够直接存取存储器,允许各个结点能以并行方式同时处理I/O操作。系统性能的提升显著提高了地震资料处理解释业务人员的生产效率。

SoNAS集群存储系统易于管理和使用。只要IP网络互联互通,就能够很方便的访问这个存储系统,仅在要访问的客户机上配置DNS服务器IP地址即可,而无需额外安装配置其它任何软件。并且单个全局名字空间特性显著地简化了存储管理,提高了工作效率。

总结与展望

概括地讲,集群NAS存储具备大存储容量、高性能、高可用性、高安全性、高可扩展性、高可管理性等方面的诸多优势。对于最终用户的关键业务,集群NAS更是极大地增强了设备的容错性。对于SAN共享存储架构的集群NAS,它允许多个用户(业务)接口节点互为冗余,多个接口节点中只要有一个正常工作,就能保证用户业务的持续不中断;全对称分布式的集群NAS更是大大提高了系统整体的容错性,由于它每个存储节点都是相同的配置,允许一个或某几个存储节点整体冗余。

从技术的发展趋势看,特别是系统软件的不断完善和发展,操作系统内嵌pNFS协议成为标准。集群NAS的核心是底层的并行文件系统或集群文件系统,随着pNFS协议的日臻完善和普及,在不远的将来,各种NAS存储系统或许不再需要配置各自的专有核心文件系统。

从产品市场研发的形势看,国产网络存储产品应用势头强劲。经过多年的应用摸索和技术积累,国内存储厂商快速发展,纷纷推出自己的集群NAS产品,如华为、海康威视、浪潮以及曙光等。而且伴随国家信息安全形势的迫切要求和系统建设任务的浪潮,国内品牌的服务器、数据库和存储设备厂商表现出了高度热情,积极投身产品研发,技术创新与质量迅速提升。

DOI:10.3969/j.issn.1001-8972.2016.06.007