双目视觉测量中等匹配点的光条中心提取

2016-08-23贾振元樊超楠杨景豪徐鹏涛

贾振元,樊超楠,刘 巍,杨景豪,徐鹏涛

(大连理工大学 机械工程学院,辽宁 大连 116024)

双目视觉测量中等匹配点的光条中心提取

贾振元,樊超楠,刘巍*,杨景豪,徐鹏涛

(大连理工大学 机械工程学院,辽宁 大连 116024)

为了精确、快速提取激光条中心,使其提取结果更适用于工业现场特征尺寸的双目视觉测量,提出了一种等匹配点的激光条中心提取方法。利用灰度重心法粗提取出激光条中心点,计算灰度梯度方向,确定光条边界。接着,根据左右图像中激光条的粗提取结果确定基准光条,对另一幅图像中的对应光条进行插值。然后结合灰度梯度方向与插值结果对激光条进行重提取,得到等匹配点的亚像素中心坐标。最后,利用激光条中心点提取结果重建陶瓷平板、金属板表面及加工现场锻件表面的特征信息。实验结果表明,本文方法提取陶瓷板与金属板的激光条中心点的匹配率分别为99.887%与98.276%,宽度重建的相对误差分别为0.638%与0.488%,激光条中心提取结果能有效重建锻件表面的特征信息,满足工业现场对测量的精度、速度和鲁棒性要求。

双目视觉测量;光条中心提取;等匹配点;亚像素

1 引 言

作为机器视觉方法中的一种,双目立体视觉技术以其精度高、实时在线、非接触及可获取全域信息等优势在工程测量中得到了广泛应用[1-3]。双目立体视觉测量系统通常采用线激光作为辅助光源,利用双目摄像机采集激光条的原始数据。由于激光器投射出的激光条在被测物表面具有一定宽度,双目摄像机采集到的激光条也具有一定宽度,需要通过提取图像中激光条中心点重建测量所需要的特征信息,得到测量要求的尺寸或形貌参数[4-5]。因此,激光条中心点提取是双目视觉测量中的重要环节,准确、高效地提取出激光条中心点对提高双目视觉测量的精度、速度、鲁棒性极为重要。

传统的光条中心提取方法主要利用光条自身的几何属性及其灰度信息,包括曲线拟合法和灰度重心法等[6]。然而,这些方法均未考虑截面的方向问题。Steger利用Hessian阵计算了光条方向,在光条的法矢量方向上提取中心点[7-8],这是一种高精度的光条提取算法,然而较大的计算量及复杂的参数设置限制了它在工业现场的应用。针对各类光条提取方法的优势以及不同的应用需求,众多学者展开了研究,以期获得更具适应性的中心提取结果。熊会元等人在利用阈值法获取光条中心初值的基础上,以灰度梯度与Bazen方法确定中心提取的截面方向,从而获得了精确的光条中心[9]。贾倩倩等人以光条中点的梯度方向确定光条的法向,设定合理的梯度阈值实现了光条中心的亚像素提取[10]。赵博华等人提出了一种适用于粗糙金属表面的光条中心提取方法,通过对噪声来源及其特性进行分析有效去除了光条投射在粗糙金属表面上时常见的噪声,利用灰度重心法提取出了光条的中心[11]。田庆国等人通过多边形表征轮廓线实现激光条的分段,对每段光条分别确定提取的截面方向,利用灰度重心法实现了截面内光条中心的快速高精度提取[12]。刘振等人在灰度阈值的基础上以互相关值区分光条的有效区域与噪声,通过曲线拟合法提取中心点,提高了曲线拟合法的抗干扰性和鲁棒性[13]。李凤娇等人利用细化光条的方式得到光条中心初值,并在此基础上选取最优的高斯核方差求得光条的亚像素中心,有效解决了高反光环境下光条中心的高精度提取问题[14]。上述方法考虑到了激光条中心提取的速度、方向性与算法的抗噪性,解决了不同环境下激光条中心精确提取存在的问题,然而并未针对提取结果在双目视觉系统下的鲁棒性开展研究。

本文提出了一种基于等匹配点需求的激光条中心点提取方法。在分析双目视觉系统测量原理及工业现场测量环境中光条特性的基础上,利用灰度重心法粗提取由左右摄像机同时采集得到的被测物表面的激光条中心,计算光条的灰度梯度,判断光条边界;通过比对两幅图像的粗提取结果确定基准光条及需要插值的对应光条,并进行激光条中心点的重提取,得到满足一一对应关系的特征点;最后,利用极线约束对提取结果进行匹配并重建待测物表面的特征信息,并通过实验验证了本文提出的激光条中心点提取方法的精度及现场测量的速度和鲁棒性。

2 测量原理

2.1双目视觉测量系统

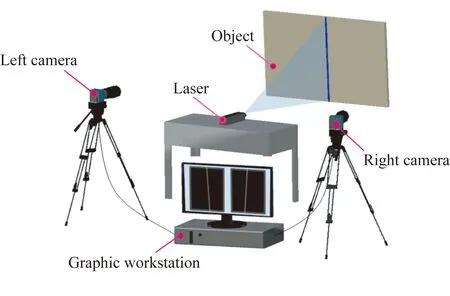

本文采用的双目视觉测量系统由辅助光源(激光器)、双目摄像机(左摄像机、右摄像机)、图形工作站以及待测物体组成,如图1所示。测量前,需要对整个测量系统进行标定,以确定摄像机所拍摄的图像、摄像机及被测物之间的空间关系。测量时,激光器发出线状光投射到待测物体表面作为特征信息,双目摄像机采集激光条及待测物图像,图形工作站处理激光条的特征信息,然后利用系统标定结果进行左右摄像机特征信息的匹配,完成特征的三维重建,获得待测物体的几何尺寸。

图1 双目视觉测量系统示意图

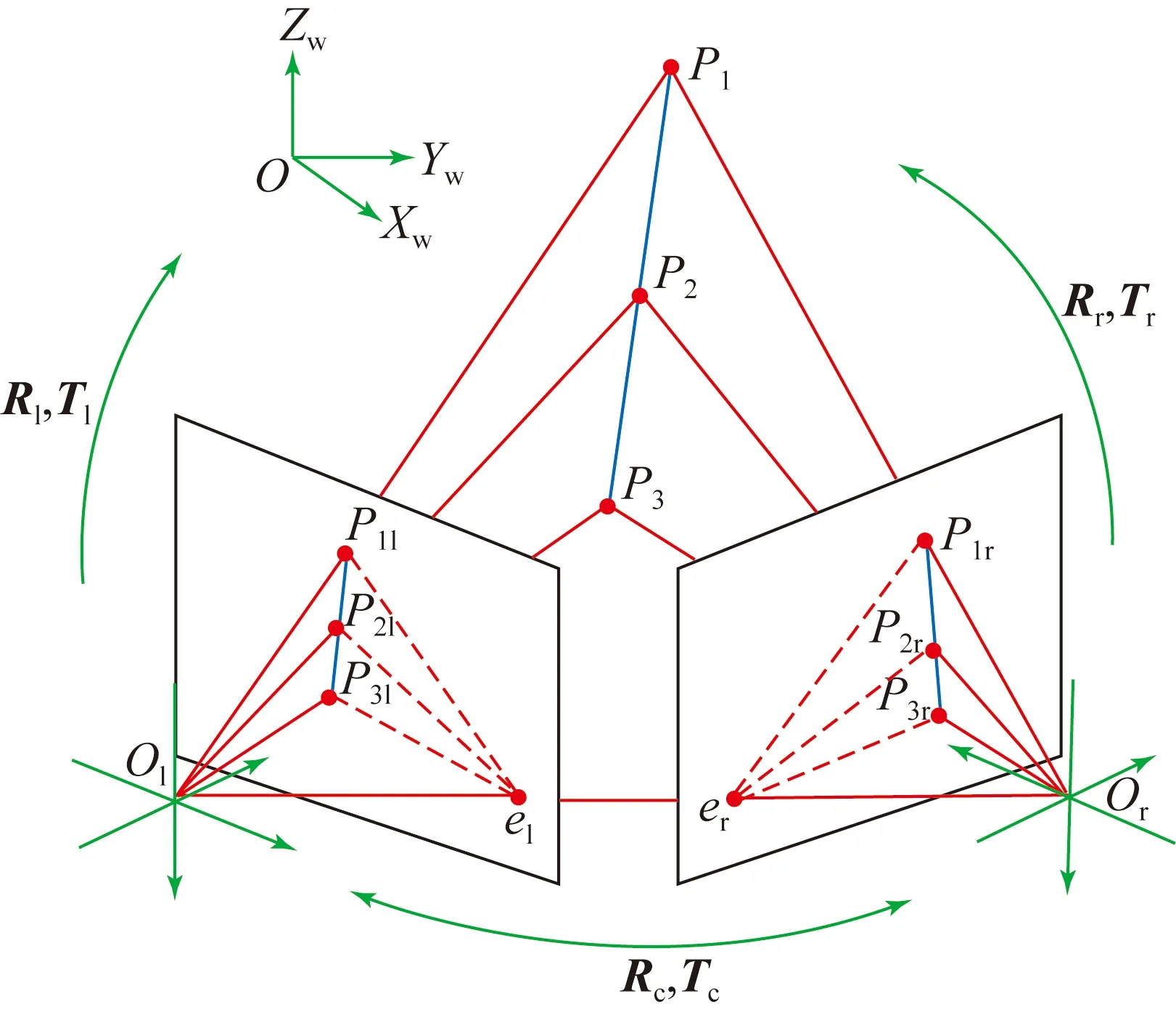

图2 双目视觉测量原理图

实际测量中,摄像机获取的待测物表面激光条图像具有一定宽度,采用图像中激光条的中心点作为尺寸测量的有效特征信息。如图2所示,以被测物表面激光条上在世界坐标系OXWYWZW的3个空间点P1,P2,P3为例,P1l,P2l,P3l及P1r,P2r,P3r分别为左右摄像机拍摄图像中的点基元,通过摄像机标定技术可确定以两摄像机光心Ol,Or为原点的左右摄像机坐标系之间的空间位置关系参数Rc,Tc及它们与世界坐标系的空间位置关系参数Rl,Tl和Rr,Tr,进而得到标定参数R,T。利用左右图像中P1l,P2l,P3l及P1r,P2r,P3r的精确二维坐标,点基元间的一一对应关系以及标定参数,可重建P1,P2,P3的空间三维坐标。因此,在由左右摄像机拍摄的激光条图像进行三维重建还原被测物尺寸的过程中,激光条中心点的提取精度及提取后左右图像中点基元匹配的准确性,对三维重建的精度、速度及鲁棒性至关重要。

2.2加工现场双目视觉测量的光条特性分析

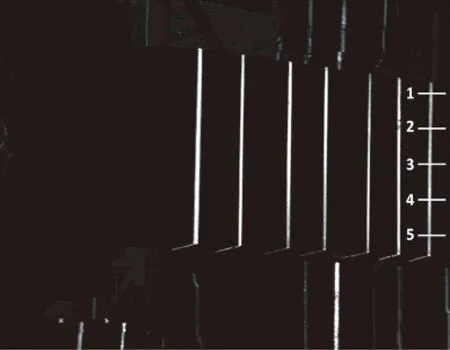

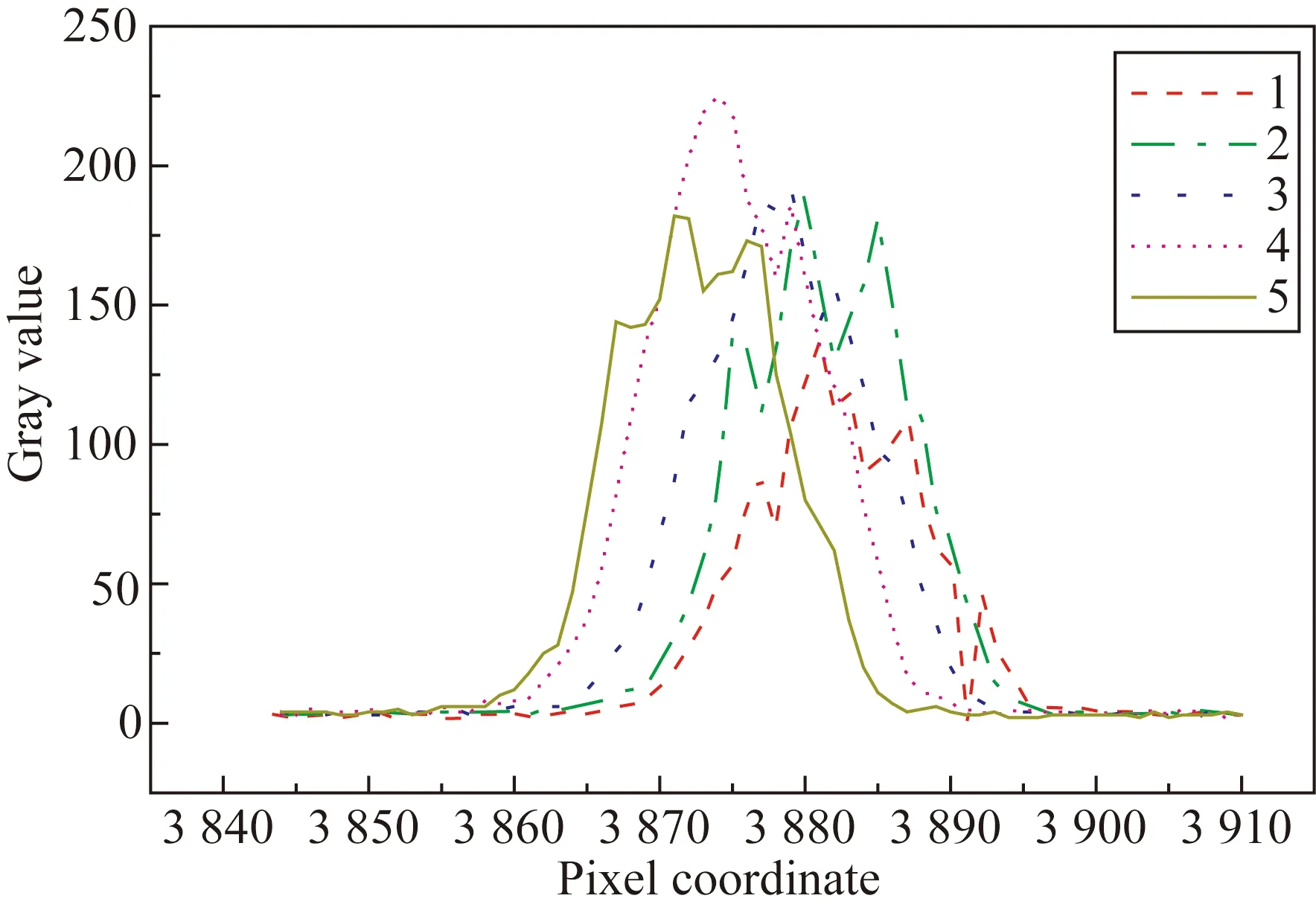

在双目视觉测量中,理论上激光条光强在其截面服从高斯分布,然而在实际测量环境下,拍摄图像受到各种因素的影响,光条强度并不严格服从高斯分布[15]。分析在锻件厂使用CCD摄像机获取的锻件表面的激光条图像,结果如图3所示。

(a)实际拍摄的光条图像

(b)图像灰度分布

如图3(a)所示,选取整体灰度分布较为均匀的光条,对同一根激光条上的5个不同截面位置讨论其截面灰度的分布情况,图3(b)为激光条不同位置的截面灰度分布。由此可知,选取的截面位置不同,光条在截面内的灰度分布不同且差异较大。因此,在加工现场的在线测量中,利用同一种曲线模型进行光条截面能量的拟合会有较大的提取误差。HESSIAN阵方法的计算量较大且参数设置复杂,而灰度重心法能够减小因激光条形态不对称、灰度分布不均匀等引起的误差,且对截面位置的改变不敏感,较一般的中心提取方法的鲁棒性更强,同时兼顾了提取精度与速度[16],所以在线测量中灰度重心法的应用更为广泛。

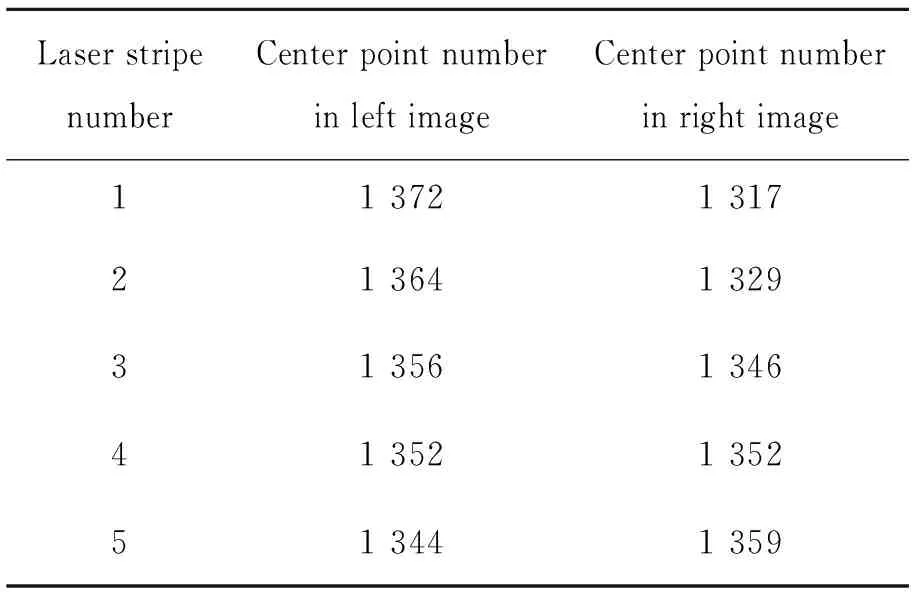

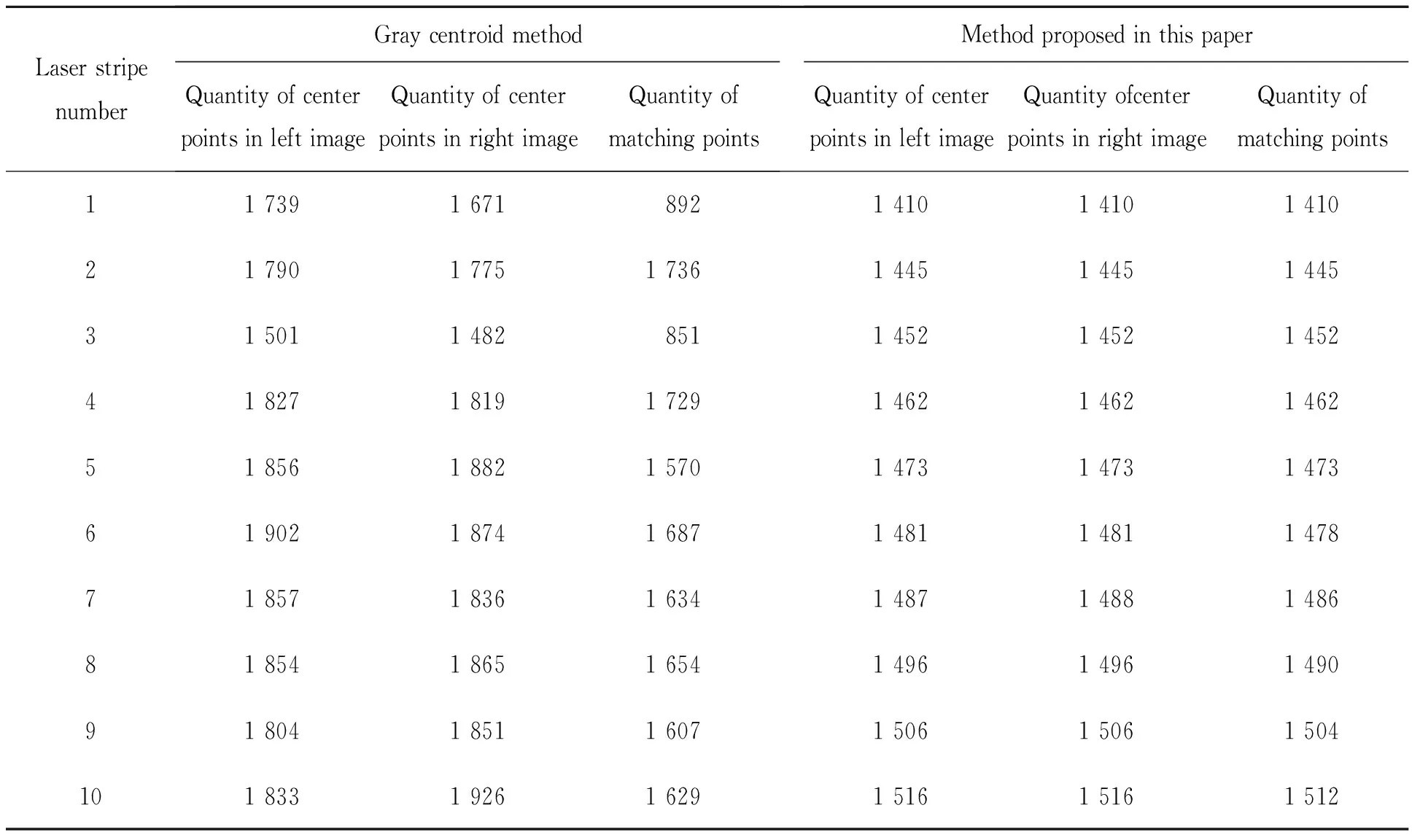

常用的光条中心提取算法通常以某一方向的像素为单位确定光条中心点提取的横截面位置,并在该横截面内进行激光条中心点的精确提取。对于双目视觉测量系统来说,测量过程中左右摄像机视场不可避免地存在差别,以像素为单位确定提取位置的方法往往导致左右图像中同一激光条提取出的中心点数量不一致。本文选取加工现场双目视觉测量系统采集到的激光条边界较为清晰的左右图像,对其中5根激光条以每行像素为横截面的方式进行中心点提取,提取后的中心点数量如表1所示。

表1 左右图像激光条中心点数量

由于双目视觉测量系统的布局受工业现场环境的限制,左右摄像机视场存在差别,因而其左右图像的光条点数不一致。左右图像中待匹配的中心点实际上并不严格对应被测物表面的同一个真实点,将它们强行匹配会影响后续的重建结果,从而影响测量精度。

3 光条中心提取方法

双目视觉测量系统精准测量的前提是特征信息的高精度获取。考虑到激光条的灰度特性,同时使提取结果更有利于提高测量后续匹配和重建的精度,本文提出了等匹配点的激光条中心提取方法。采用灰度重心法进行激光条中心的粗提取,以左右图像中同一激光条粗提取中心点数量多的为基准光条,对相应激光条进行插值计算,最后对基准光条及插值后激光条进行中心点重提取。

3.1光条中心粗提取

提取激光条中心前,对左右摄像机拍摄得到的二维图像进行预处理,分离背景并降低噪声,确定感兴趣区域Iimage,在此基础上根据实际的待测物的边界信息获取激光条的首尾边界,进一步确定激光条特征的感兴趣区域Ilaser。

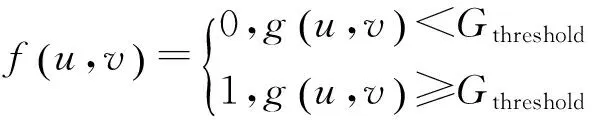

根据双目视觉测量系统中激光条图像的灰度特性,选取合适的灰度阈值Gthreshold,根据式(1)对图像进行二值化处理:

(1)

其中:0-uv为图像坐标系,g(u,v)表示像素坐标为(u,v)的像素点对应的灰度值。若f(u,v)=0,则像素点(u,v)为背景;若f(u,v)=1,则像素点(u,v)为有效信息点。保留f(u,v)=1的所有像素点(u,v),构成二维图像感兴趣区域Iimage。

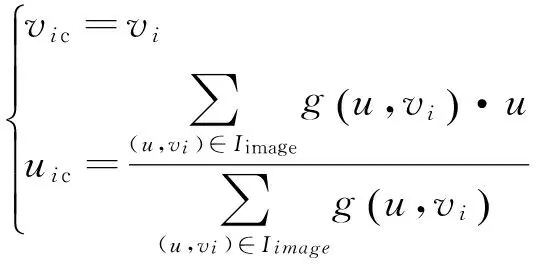

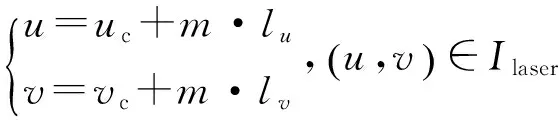

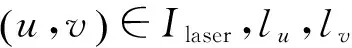

在图像获取过程中,以激光条整体的近似方向为坐标轴ov方向。沿ov方向提取以单像素为单位ou方向内激光条的灰度重心点,如式(2)所示,可求得每行像素的激光条中心点坐标:

(2)

其中:vi为第i行像素所对应的像素点在ov方向的坐标值,则(u,vi)为第i行像素所对应的所有像素点,所得(uic,vic)为第i行像素内的激光条中心像素坐标初值。遍历Iimage内的每行像素点,可求得激光条所有中心点的像素坐标初值。

在双目视觉测量系统所获取的图片中,由于被测物及背景的表面属性不同且具有一定的空间关系,其二维图像的灰度分布也并不相同,对Iimage中粗提取出的激光条中心点进行灰度值及几何位置变化的相关判断,可确定激光条投射在待测物表面的首尾边界点。

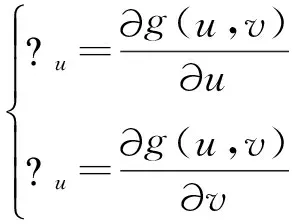

对g(u,v)求取偏导数可得到(uic,vic)对应的灰度梯度值(uic,vic),即有:

(3)

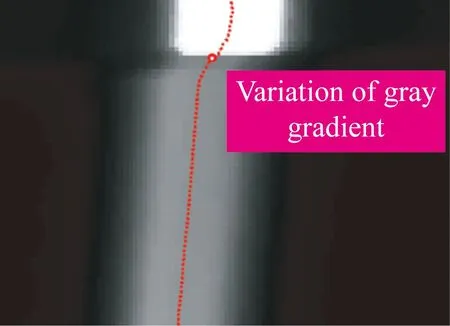

如图4所示,根据图像灰度的分布特性,灰度梯度的绝对值在边缘处较大,可利用激光条中心点(uic,vic)在ov方向的梯度值绝对值|vic|判断激光条在待测物边界处的中心点坐标。根据实际测量情况选取合适的灰度梯度阈值vthreshold,以式(4)作为边界判断条件进行判断:

(4)

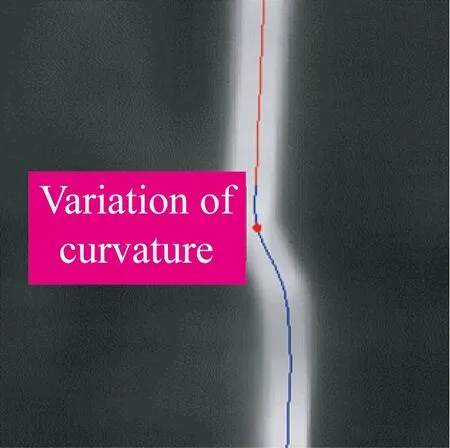

如图4(a)所示,比较满足边界条件的像素中心点在ov方向的坐标值,可得到激光条的首尾边界中心点。实际测量过程中,不是所有的待测物边缘都具有比较明显的梯度变化,在图像灰度基本呈现一致的情况下,基于灰度变化的定位方式会失效。基于光条的连续性,待测物与背景之间的空间位置关系会使光的曲率发生变化,如图4(b)所示,可以利用光条中心线曲率的变化来定位这一类边界点。将光条边界点附近的中心点进行曲线拟合得到F(u,v)=0,根据零穿越定理在最大曲率变化处有F″(u,v)=0,即为边界点的位置。

(a)灰度梯度变化定位(a)Localization withgray gradient

(b)曲率变化定位(b)Localization with curvature change

3.2插值与光条中心重提取

左右激光条图像粗提取操作得到的中心点数量不相同,对另一幅图像的激光条插值进行光条中心重提取。

根据3.1节可得左右图像中激光条的有效中心点,其点数分别为nL,nR。在左右图像中对同一根光条的中心点数进行比较,确定插值单位q,即:

(5)

插值点ov方向的坐标计算方法为:

v=v1+i·q,i=1,2,3,…,n,

(6)

其中:v1为待插值光条起始点ov方向的坐标,n为基准图像中光条中心点的数量。

对基准光条及插值后的图像进行光条精提取,确定精提取的激光条中心点的搜索方向l:

(7)

对每个中心点初值按其所对应的l方向确定中心点的感兴趣区域Icentre:

(8)

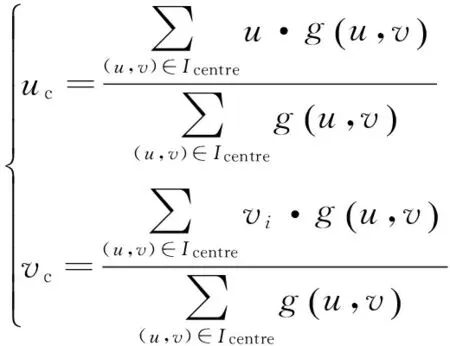

求取激光条在该方向内的灰度重心,得到:

(9)

其中:g(u,v)为(u,v)对应的灰度值。

插值光条在精提取后,光条中心提取的光条中心点分布均匀,且左右图像中激光条中心点数相等。按顺序一致性原则设定左右图像中对应点为初始匹配点对,利用标定结果与极线约束剔除初始匹配点对中的粗大误差,可实现中心点的一一匹配。

4 实验分析

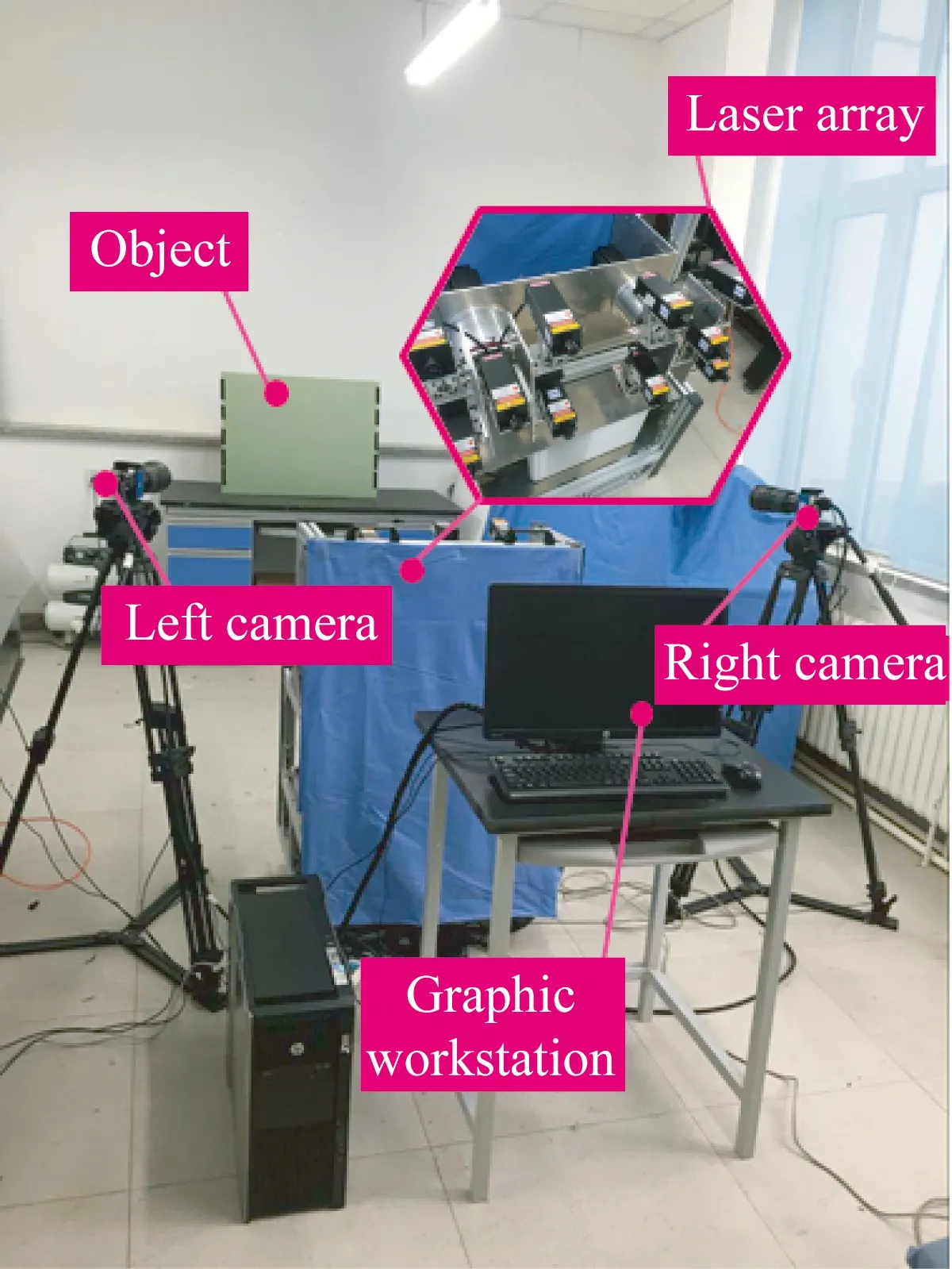

应用Matlab实现本文方法,利用实验室自主搭建的双目视觉测量系统进行实验。如图5所示,采用两台装有50 mm定焦镜头且分辨率为4 008 pixel×2 672 pixel的SVS11002C摄像机,采用450 nm蓝紫激光器作为线激光光源,图形工作站为HP-Z820。

图5 双目视觉测量系统

4.1实验室实验

4.1.1方法对比实验

为验证本文方法应用在双目视觉测量中的优势,选取800 mm×600 mm的标准陶瓷平板作为被测物进行实验室实验,视场为2 m×1.4 m。选用工业测量现场应用最为广泛的灰度重心法作为对比,分别利用灰度重心法和本文方法提取被测物表面的激光条。

由表2可见,直接利用灰度重心法得到的左右图像的激光条中心点数量相差较大,而利用本文方法得到的激光条中心点数量一致。采用极线约束方法匹配提取出的激光条中心点构成的初始匹配点对,本文提出的激光条中心点提取方法得到的提取结果匹配率达到99.887%。

表2 灰度重心法与本文方法提取点数

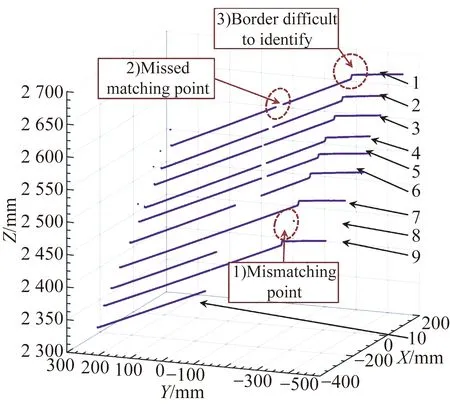

基于三角原理[16-17]对两种方法得到的匹配点进行三维重构。如图6(a)所示,直接利用灰度重心法得到的重建结果中存在如下问题:

(1)误匹配点较多。表现为图中明显的离散噪声,主要因为提取结果不满足极线约束或存在共极线现象。

(2)大量特征信息丢失。这是由于提取结果中心的点数量相差较大,所以在利用极线约束进行匹配的过程中易因中心点不满足约束条件、匹配初值选取不当而导致无法匹配,如图6(a)中光条8、9缺失边界信息,无法用于后续测量。数据量的减少将极大影响测量精度。

(3)缺少边界信息判断。边界信息对于实现工业现场特征尺寸的测量具有重要意义,因提取方法缺少边界识别的过程,故需要对重建数据进行边界信息的判断,从而增大了工业现场还原长度、高度及轴类直径等特征尺寸的难度。

(b)灰度重心法

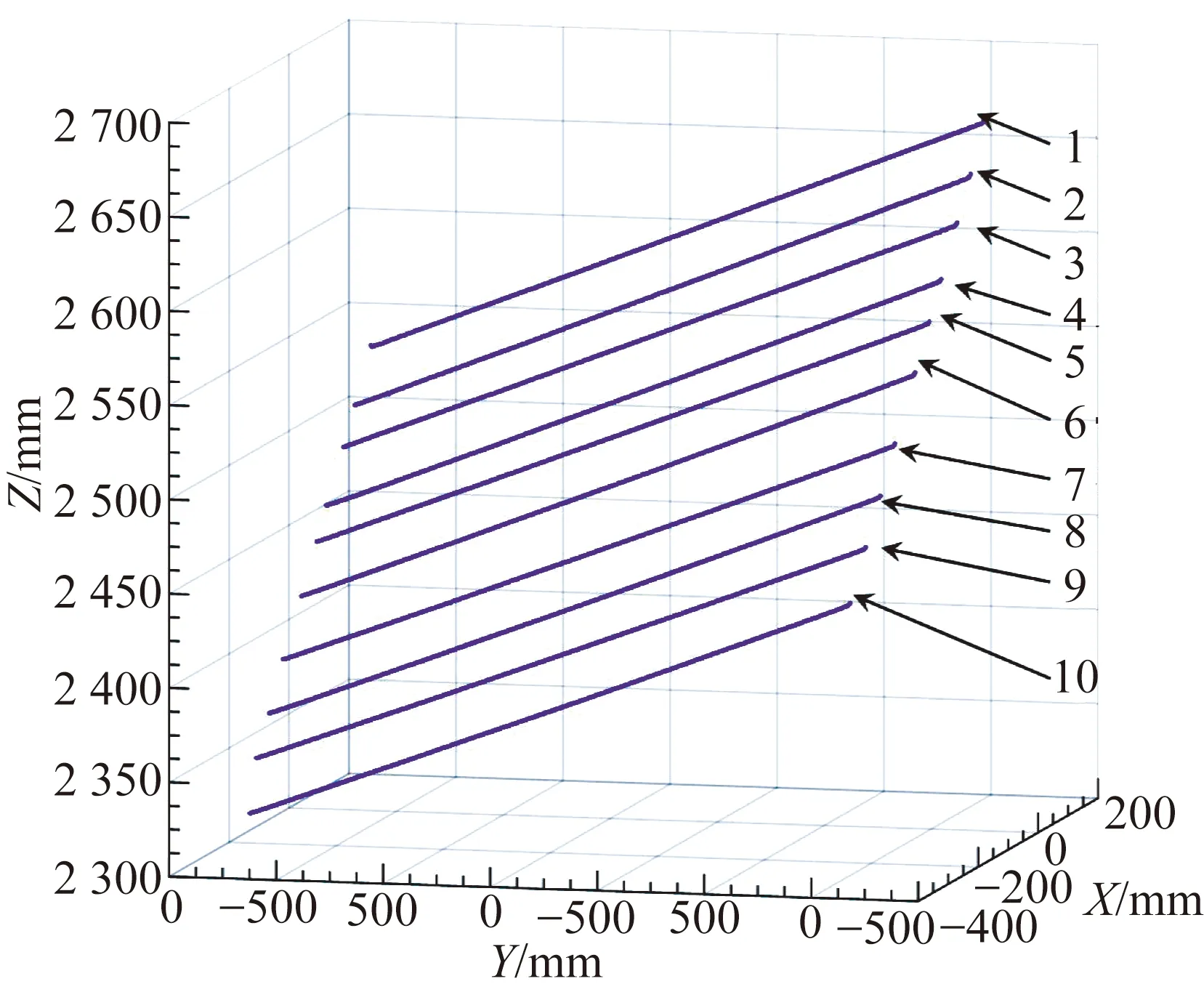

(a)本文方法

相比之下,如图6(b)所示,本文的提取方法得到了等量的光条中心点,可构成合理的初始匹配点对,有效避免了漏匹配与误匹配,保证了测量所需数据的完整性。此外,本文方法利用灰度梯度变化识别待测物边界,可得到清晰的边界信息,便于还原工业现场需要测量的特征尺寸。以高度为测量对象,进一步处理图中光条中心点的重建数据,可得陶瓷板高度为596.172 mm,相对误差为0.638%。而灰度重心法由于需要手动选取待测物边界并剔除被测物外的数据点,不能达到工业现场的测量需求。

4.1.2鲁棒性验证实验

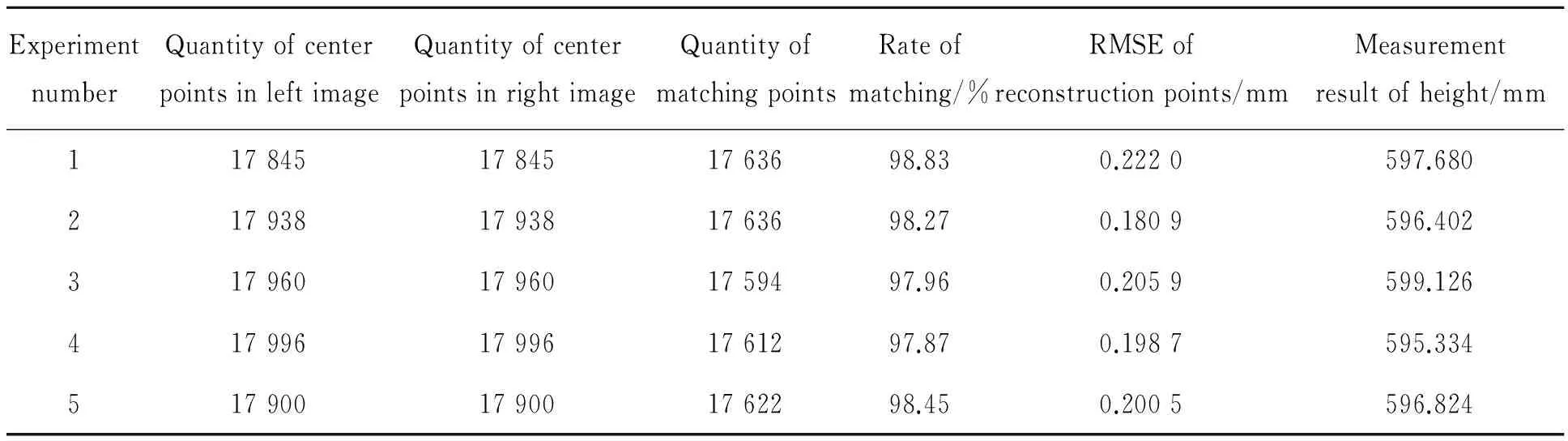

为验证本文方法的鲁棒性,选取标准金属平板进行验证实验,被测物大小为800 mm×600 mm,平面度为0.2 mm,实验视场为2 m×1.4 m,如图7所示。

图7 金属板测量实验

改变激光条投射方向与金属板位置并采集图像,分别进行5组实验,每组实验投射10根激光条,测量结果如表3所示。利用本文方法提取激光条中心后,匹配点的平均匹配率达到98.276%,保证了用于信息的数据量满足测量的需求。重建匹配点三维信息,用于拟合平面的重建点均方根误差值均在0.180 9~0.222 0 mm,符合工业现场对测量所需数据点的鲁棒性要求。激光条中心点用于重建待测目标高度的平均值为597.073 mm,平均误差为0.488%,满足高度重建的精度要求。

表3 鲁棒性验证实验结果

4.2现场应用

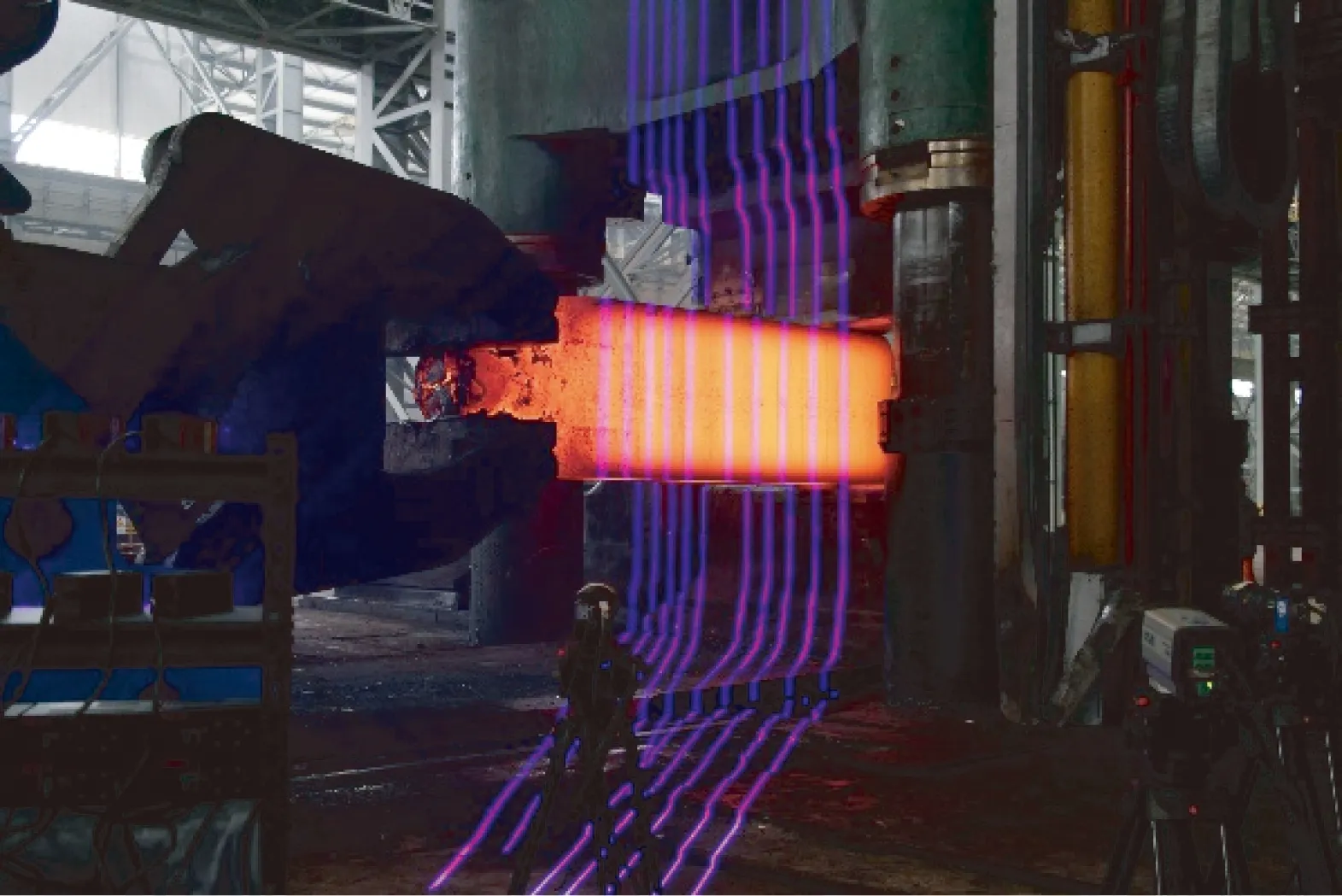

为验证利用本文提出方法在工业现场测量的可靠性,这里对锻件加工现场的热态锻件进行了测量。图8(a)为投射有激光条的待测方形锻件表面,图8(b)为利用本文提出方法实时重建所得到的三维数据,锻件高度的测量结果为1 438.7 mm。

(a)待测方形锻件

(b)三维重构结果

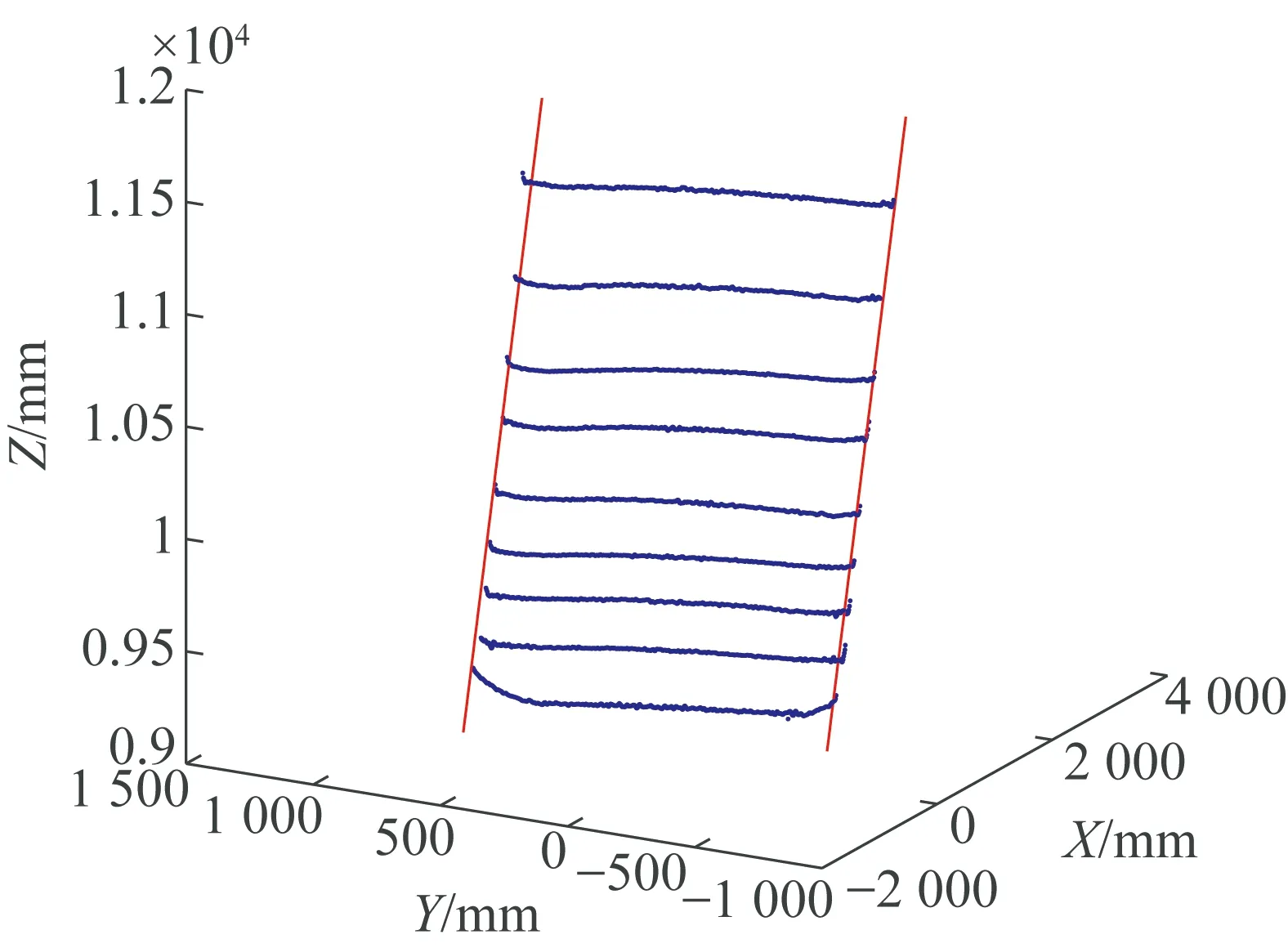

图9(a)为投射有激光条的待测轴类锻件表面,图9(b)为利用本文提出方法实时重建所得到的三维数据,尺寸为800 mm×600 mm。

(a)待测轴类锻件

(b)三维重构结果

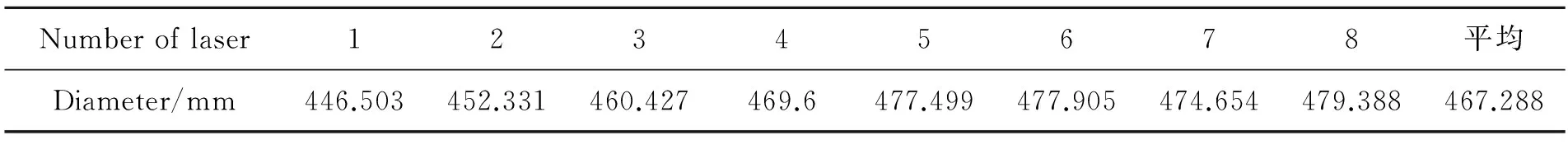

将图9(b)所示锻件表面的8根光条从左至右进行编号,依次求取对应位置锻件直径的近似值,其结果如表4所示。测量结果表明,直径从左至右依次增大,符合热态锻件的实际形貌特征。

表4 锻件直径的测量结果

实验结果表明,利用本文方法得到的提取结果构成了合理的初始匹配点对,在提高匹配速度的同时有效避免了漏匹配与误匹配,保障了重建特征信息的数据量。提取过程中待测物边界的识别,对于现场重建数据的处理以及特征尺寸还原也具有重要意义。因此,本文方法可以满足工业现场对双目视觉测量的速度、精度及鲁棒性要求。

5 结 论

本文提出了一种适用于双目视觉测量的等匹配点光条中心提取方法,利用灰度重心法得到粗提取结果确定基准光条,对其对应的激光条进行插值,在此基础上提取激光条中心,获得左右匹配点数量相同的特征信息。该方法考虑到双目视觉测量系统中后续匹配、重建对光条中心点提取结果的需求,对确定光条横截面的单位进行插值,在满足激光条中心提取精度的基础上保证了左右图像中光条中心点的数量一致,利于测量中特征点信息的匹配和重建构造合理初值,降低了对匹配算法的要求。利用该提取方法在2 m×1.4 m视场内进行了实验室实验,陶瓷平板上的10根激光条提取结果理想,提取后的匹配鲁棒性好,测量陶瓷平板及金属板的高度相对误差分别为0.638%和0.488%。本文方法对加工现场锻件表面特征信息的提取结果可重建出锻件的特征尺寸,且测量结果稳定,满足加工现场的测量需求。

[1]WANG J, WANG X, LIU F,etal.. Modeling of binocular stereo vision for remote coordinate measurement and fast calibration [J].OpticsandLasersinEngineering, 2014, 54: 269-274.

[3]SUN J, MA H, ZENG D. Three-dimensional infrared imaging method based on binocular stereo vision [J].OpticalEngineering, 2015, 54(10):103111.

[4]SUN Q, CHEN J, LI C. A robust method to extract a laser stripe centre based on grey level moment [J].OpticsandLasersinEngineering, 2015, 67: 122-127.

[5]USAMENTIAGA R, MOLLEDA J, GARCIA D F,etal.. Flatness measurement using two laser stripes to remove the effects of vibrations[C].Vancouver,BC,Canada:InstituteofElectricalandElectronicsEngineersInc., 2014:4296-4304.

[6]李莹莹,张志毅,袁林. 线结构光光条中心提取综述 [J]. 激光与光电子学进展, 2013, 10(10): 9-18.LI Y Y, ZHANG ZH Y, YUAN L. Survey on linear structured light stripe center extraction [J].Laser&OptoelectronicsProgress, 2013,10(10): 9-18.(in Chinese)

[7]STEGER C. An unbiased detector of curvilinear structures [J].PatternAnalysisandMachineIntelligence,IEEETransactionson, 1998, 20(2): 113-125.

[8]STEGER C.ExtractingCurvilinearStructures:ADifferentialGeometricApproach[M]. Computer Vision—ECCV’96, Springer,1996: 630-641.

[9]熊会元,宗志坚,陈承鹤. 线结构光条纹中心的全分辨率精确提取[J]. 光学 精密工程,2009, 17(5): 1057-1062

XIONG H Y, ZONG ZH J, CHEN CH H. Accurately extracting full resolution centers of structured light stripe [J].Opt.PrecisionEng., 2009, 17(5): 1057-1062.(in Chinese)

[10]贾倩倩,王伯雄,罗秀芝. 光切法形貌测量中光条中心的亚像素提取[J]. 光学 精密工程,2010, 18(2): 390-396.

JIA Q Q, WANG B X, LUO X ZH. Extraction of central positions of light stripe in sub-pixel in 3D surface measurement based on light sectioning method [J].Opt.PrecisionEng., 2010, 18(2): 390-396.(in Chinese)

[11]赵博华,王伯雄,张金,等. 粗糙金属表面光条中心提取方法[J]. 光学 精密工程,2011,18(9): 2138-2145.

ZHAO B H, WANG B X, ZHANG J,etal.. Extraction of laser stripe center on rough metal surface [J].Opt.PrecisionEng., 2011,18(9): 2138-2145.(in Chinese)

[12]田庆国,葛宝臻,李云鹏,等. 利用轮廓线多边形表示实时提取光带中心线[J]. 光学 精密工程,2012,19(6): 1357-1364.

TIAN Q G, GE B ZH, LI Y P,etal.. Real-time extraction of light stripe central line based on contour polygonal representation [J].Opt.PrecisionEng., 2012,19(6): 1357-1364.(in Chinese)

[13]刘振,李声,冯常. 基于互相关算法的激光条纹中心提取[J]. 中国激光,2013, 40(5): 197-202.

LIU ZH, LI SH, FENG CH. Laser stripe center extraction based on cross-correlation algorithm [J].ChineseJ.Lasers, 2013,40(5):197-202.(in Chinese)

[14]李凤娇,李小菁,刘震. 基于多尺度分析的激光光条中心点坐标提取方法[J]. 光学学报,2014, 11(11): 103-108.

LI F J, LI X J, LIU ZH. A multi-scale analysis based method for extracting coordinates of laser light stripe centers [J].ActaOpticaSinica, 2014,34(11):103-108.(in Chinese)

[15]ZHANG Y, LIU W, LI X,etal.. Accuracy improvement in laser stripe extraction for large-scale triangulation scanning measurement system [J].OpticalEngineering, 2015, 54(10): 105108.

[16]张广军.视觉测量[M]. 北京:科学出版社,2008.

ZHANG G J.VisionMeasurement[M]. Beijing: Science Press,2008.(in Chinese)

[17]邾继贵,于之靖.视觉测量原理与方法[M]. 北京:机械工业出版社, 2011.

ZHU J G, YU ZH J.ThePrincipleofVisionMetrology[M]. Beijing: China Machine Press, 2011.(in Chinese)

贾振元(1963-),男,辽宁朝阳人,博士,教授,博士生导师,1980年、1984年、1987年于大连理工大学分别获得学士、硕士、博士学位,主要研究方向为精密/特种加工和精密测量、精密控制。E-mail:jzyxy@dlut.edu.cn

刘巍(1979-),男,内蒙赤峰人,博士,副教授,博士生导师,2007年于大连理工大学获得博士学位,主要从事功能材料与智能控制等方面的研究。E-mail:lw2007@dlut.edu.cn

(版权所有未经许可不得转载)

Extraction of laser stripe centers based on equal matching points for binocular vision measurement

JIA Zhen-yuan, FAN Chao-nan, LIU Wei*, YANG Jing-hao, XU Peng-tao

(CollegeofMechanicalEngineering,DalianUniversityofTechnology,Dalian116024,China)

*Correspondingauthor,E-mail:lw2007@dlut.edu.cn

In order to extract laser stripe centers accurately and quickly and provide more suitable extraction results for binocular vision measurement of feature dimension, a laser stripe center extraction method with equivalent matching point was proposed. The gray centroid method was employed to extract central points of laser stripe, to calculate gray-gradient directions and to determine boundaries of laser stripe. Then coarse extraction results of laser stripe in the left and right images were used to determine reference laser stripe, with which the interpolation of corresponding laser stripe in another image was conducted. The laser stripes were extracted again based on gray-gradient directions and interpolation results and then sub pixel center coordinate with equivalent matching point was gained. Afterwards, the central point extraction results of the laser stripe were used to reconstruct surface feature information of ceramic plate, metal plate and forge piece on processing site. Experimental results show that, matching ratio for extraction of laser stripe centers of ceramic plate and metal plate with this method reaches 99.887% and 98.276% respectively as well as relative error for reconstruction of width is 0.638% and 0.488% respectively. Center extraction results of laser stripe can rebuild surface feature information of forge piece effectively and can meet measurement accuracy, speed and robustness requirement on industrial site.

binocular vision measurement; extraction of laser stripe centers; equivalent matching points; subpixel

2016-01-18;

2016-03-15.

国家自然科学基金资助项目(No.51227004,No.51375075);辽宁省自然科学基金资助项目(No.2014028010);国家973重点研究发展计划资助项目(No.2014CB46504);创新研究群体科学基金资助项目(No.51321004)

1004-924X(2016)07-1582-10

TP242.62;TP751.2

Adoi:10.3788/OPE.20162407.1582