一种基于无人机位姿信息的航拍图像拼接方法

2016-07-15程争刚

程争刚,张 利

清华大学电子工程系,北京 100084

一种基于无人机位姿信息的航拍图像拼接方法

程争刚,张利

清华大学电子工程系,北京 100084

Foundation support: The National Natural Science Foundation of China (Nos. 61172125; 61132007)

摘要:针对现有航拍图像拼接方法处理速度较慢的问题,提出一种基于无人机位姿信息的快速拼接方法。首先从机载GPS和惯性导航单元获得无人机航拍时的坐标和姿态角,根据每一幅航拍图像对应的无人机坐标和姿态角计算它们之间的单应变换矩阵,实现航拍图像之间的快速配准。然后通过单应变换矩阵的运算得到拼接图像之间的配准,最后完成多幅图像的拼接得到整个区域的全景图。试验结果证明该方法快速有效。

关键词:航拍图像;位置和姿态;图像配准;单应矩阵;全景图

近几年无人机受到了人们越来越多的关注,无人机图像拼接方法也随之得到了快速发展。无人机图像拼接是指在无人机平台上对多幅在不同时刻、从不同视角获得的航拍图像经过对齐处理后,然后无缝地融合在一起,从而得到一幅视野更大、分辨率更高的全景图像。目前被广泛应用于数字地图绘制、城市建设规划以及战场态势评估等领域。

航拍图像的拼接一般包括4个步骤:待拼接图像的获取、图像畸变校正、图像配准以及图像融合。其中图像配准是整个图像拼接技术的核心部分,它直接关系到图像拼接的质量[1],其主要目的是得到两幅图像之间的变换矩阵。目前无人机图像配准技术主要是基于特征点匹配的方法,该方法利用图像中提取到的局部特征进行匹配,其关键步骤是图像特征的提取和匹配[2],其中基于SIFT特征点匹配的方法被广泛地应用于航拍图像的配准。该方法能够有效地适应航拍图像间存在的视角和尺度变化,由文献[3—4]在1999年提出,并在2004年又对该算法进行了完善[3-4]。后来又出现了很多改进的SIFT算法应用到图像配准中[5-9]。文献[5]提出的PCA-SIFT方法,采用主成分分析对SIFT算子进行降维操作,大大减少了计算时间。文献[6]提出的尺度和仿射不变量兴趣点检测的GLOH算法,采用一种SIFT变体的描述子,用对数极坐标分级结构替代SIFT使用的4象限,之后再做PCA将其降维,因此保有和SIFT一样精简的表示方法。文献[7]提出的SURF算法,采用快速Hessian方法进行特征点检测,是SIFT算法的加速版。文献[8]提出扩展SURF描述符,采用邻域采样点的局部归一化灰度统计信息以及二阶梯度值细节信息,增强了描述符的约束性与独特性。文献[9]提出的ASIFT算法,通过模拟不同经纬度的图像,克服了SIFT算法的不完全仿射性。但是上述图像配准方法的一个明显不足就是提取特征点比较耗时,从而导致图像拼接速度较慢。为了提高航拍图像的拼接速度,近几年国内外研究者提出了多种拼接方法[10-14,16-18]。文献[10]中估计变换矩阵以及图像间关系的不确定性,并考虑如何消除图像拼接中的累积误差。文献[11—12]通过预测拼接图像的重叠区域减少拼接的时间消耗。文献[13]提出的F-SIFT图像拼接算法,采用基于子图像块的频域相位相关算法提高图像拼接的速度。文献[14]通过分块Harris角点的方法均匀提取图像中的角点,然后采用金字塔光流算法进行角点配准,缩短了航拍图像的匹配时间。这些方法对于航拍图像的配准和一般图像的配准相同,首先是对航拍图像进行特征点的提取,然后通过相似性度量进行特征点匹配,最后根据得到的两幅图像中对应特征点的坐标关系,采用RANSAC算法[15]计算出最佳匹配的变换矩阵,并没有利用航拍图像特有的优势。文献[16—17]结合了航拍时的参数信息进行图像配准,提高了航拍图像拼接的速度,但是还没有完全发挥航拍参数对图像配准的作用。文献[18]针对机载传感器的精度问题,提出了一种混合的方法,利用基于图像的方法校正由位姿计算带来的拼接误差。本文结合无人机航拍的特点,利用航拍时获得的航拍参数来计算图像间的变换矩阵,然后通过变换矩阵的分解推导出多幅图像连续拼接的变换矩阵,基本不依赖拍摄图像的质量情况,提出了一种快速的航拍图像配准方法。

1两幅航拍图像的配准

1.1航拍图像间的单应变换矩阵

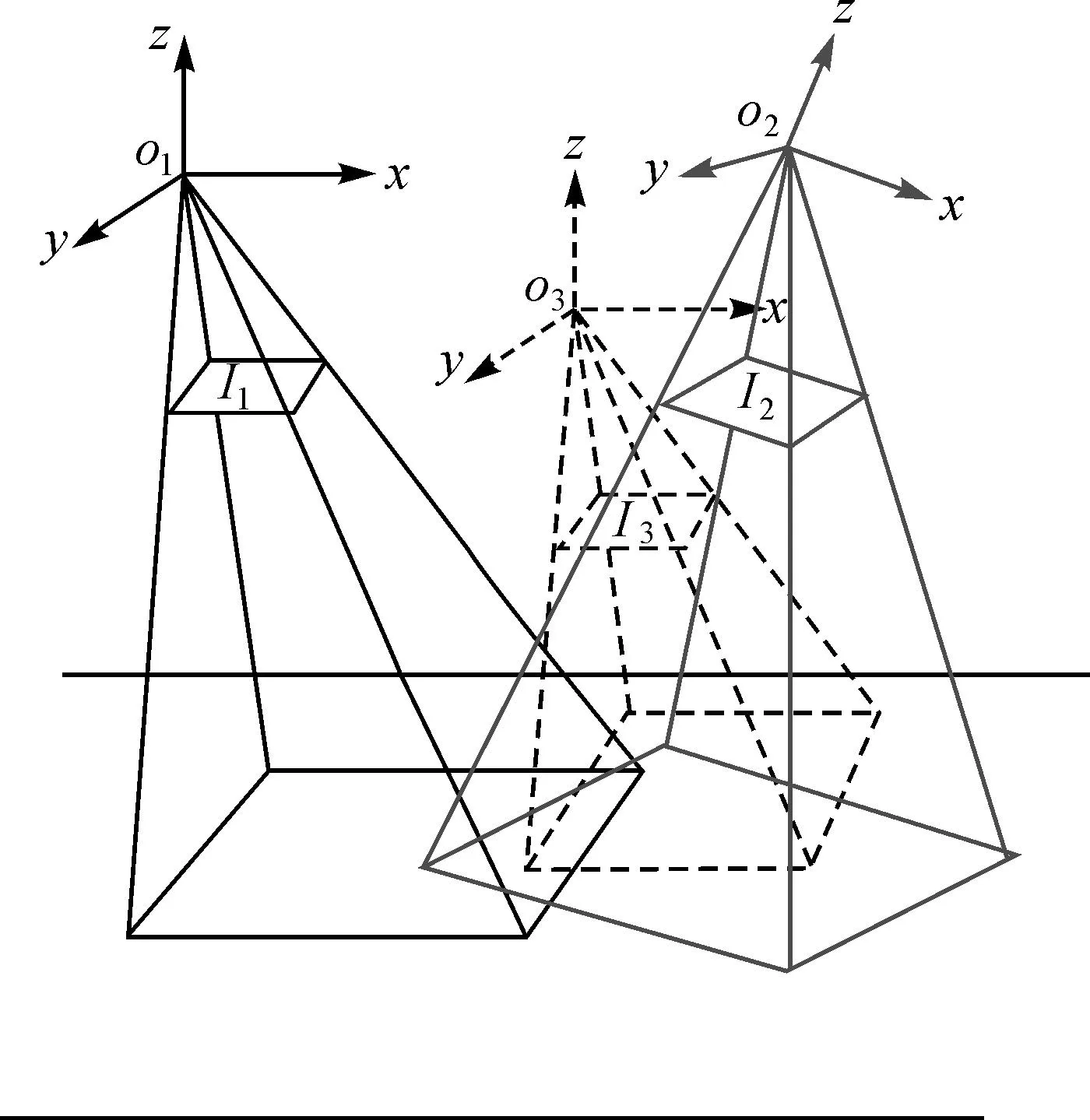

如图1所示,无人机在位置O1和O2对地面场景进行拍摄,得到图像I1和I2。M(Xw,Yw,Zw)T为场景中的一点,M1(Xc1,Yc1,Zc1)T和M2(Xc2,Yc2,Zc2)T表示M在两个位置的相机坐标。m1(u1,v1,1)T和m2(u2,v2,1)T分别为M在图像I1和I2上对应的点。如果矩阵H能满足

m2=sHm1

(1)

则称矩阵H为图像I1到I2的单应变换矩阵。其中s为非零常数项。

图1 不同视角的航拍图像Fig.1 Aerial image from different angles of view

将O1点作为世界坐标系原点,则由相机的成像原理可知

(2)

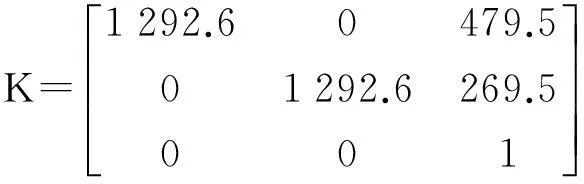

式中,K为摄像机的内参数矩阵

(3)

式中,K可以通过相机标定得到[19];dx和dy分别表示图像上每一个像素在坐标轴方向的物理尺寸,单位为mm/pixel;(u0,v0)为摄像机光轴与图像平面交点的坐标,一般位于图像的中心处;f表示摄像机的焦距。

由式(2)可得

(4)

(5)

设大地平面的方程为

nTX=d

(6)

式中,X为地面上任意一点;n为地面的单位法向量;d为坐标原点到大地平面的距离。由式(6)可得

(7)

综合式(4)、式(5)、式(7)可以得到

(8)

(9)

至此就得到了航拍图像间的单应变换矩阵。对无人机所在的拍摄位置O可以用6个参数表示,记为Oi(φi,θi,ψi,xi,yi,zi)。无人机上装有惯性导航单元(INU)和GPS,可以实时保存无人机航行时的姿态角和坐标。根据无人机在两个视点间3个姿态角的变化量φ、θ、ψ和两个视点的坐标(x1,y1,z1)、(x2,y2,z2)就可以确定R和t,其中

R=RφRθRψ

(10)

(11)

t=[x2-x1y2-y1z2-z1]T

(12)

从而两幅航拍图像之间的变换矩阵就可以通过这6个参数计算得到。由式(9)中可以看出本文对航拍图像间单应变换矩阵的推导要求图像中所有点的d相同,也就是要保证O1视点下图像里所有的场景都要在一个成像深度中,否则图像之间就不能满足单应变换。

1.2测量参数的校正

由1.1节可知,通过对航拍参数的测量就可以计算得到对应航拍图像间的单应变换矩阵。其中姿态角可以通过无人机上装有的惯性导航单元(IMU)获得,坐标可由GPS获得,飞行高度可由气压计获得。但是一般情况下,得到的测量结果会受到误差的干扰,这对于单应变换矩阵的计算影响较大。因此要得到准确的单应变换矩阵,就需要对测量的参数进行校正。

根据式(9),如果已知两幅图像的单应变换矩阵H和相机的内参数矩阵K,通过奇异值分解的方法就可以计算出摄像机参数[20]。本文首先在离线情况下对测量系统进行校准,得到参数测量误差的补偿量,然后再通过航拍参数进行图像的配准。参数校准的具体步骤如下:

(1) 在离线情况下通过特征点匹配的方法对航拍图像进行配准,得到图像之间的单应变换矩阵H。

(2) 根据文献[20]的方法由H计算出航拍参数。

(3) 将直接测量的航拍参数与参数的计算结果进行对比(试验选择比较80组结果),然后通过多项式拟合的方法得到测量参数的误差补偿量(本文选择3次多项式)。

试验结果如图2所示(以偏航角的校正为例),其中图(a)为直接测量得到的80组结果,图(b)为对应的计算结果,对比这两组结果并计算出测量误差如图(c)所示。由试验结果可以得到测量值与测量误差之间的相关系数为0.902 6,说明这两个量是高度相关的。通过RANSAC算法[15]拟合出测量误差与测量结果的关系为

e=f(c)=0.057 1c3-0.160 9c2+0.484 9c-0.083 2

(13)

式中,c为当前的测量结果;e为测量误差。这样就得到了测量结果的误差补偿量,从而就能对测量的航拍参数进行校正,保证了单应变换矩阵计算的精度。

2多幅图像的拼接

2.1多幅图像的拼接方法

多幅图像的拼接一般就是多次图像的两两拼接。假设有待拼接的图像I1~In,首先拼接图像I1和I2,得到第一次的拼接结果Im1。图像Im1包含两部分内容,一部分是I1变换后的图像I1,2(假设以I2作为基准图像),另一部分则是完整的图像I2,两部分的重叠区域进行加权平均,从而就将I1和I2融合为Im1。然后再拼接Im1和I3得到第2次的拼接结果Im2,直到拼接完所有的图像。这样不断变换基准图的拼接策略可以减少拼接误差的累积[21-22]。

图2 偏航角的校正Fig.2 Correction results of yaw angle

由上节可知根据航拍图像对应的坐标和姿态角可以直接计算出图像间的单应变换矩阵,因此H1,2可直接算出,进而可以得到第1次的拼接结果Im1。但图像Im1并没有对应的航拍参数信息,因此Im1和I3的变换矩阵Hm1,3无法直接得到。所以要实现多幅图像的连续拼接,关键就是要知道上一次的拼接图像与下一幅航拍图像之间的变换矩阵。

2.2单应矩阵的分解

设无人机在位置O1和O2分别拍摄到图像I1和I2,I1到I2的单应变换矩阵为H1,2。从O1到O2可以看作是首先从O1到O3,然后再从O3到O2,如图3所示。若I3为无人机在O3拍摄到的图像,I1到I3的单应变换矩阵为H1,3,I3到I2的单应变换矩阵为H3,2。

图3 单应变换的分解Fig.3 Decomposition of homography matrix

对于图像I1上的任意一点m1(x1,y1),其经过H1,2和H1,3变换后在I2和I3上对应的点分别为m2(x2,y2)和m3(x3,y3)。可以得到

(14)

(15)

而点m3(x3,y3)经过H3,2变换后对应为m2(x2,y2),所以有

(16)

因此

H1,2=H3,2H1,3

(17)

这样,就可以将两幅图像的单应变换矩阵分解为两个矩阵,从而可以得到

Hm1,3=H2,3Hm1,2

(18)

式中,H2,3可直接根据图像对应的姿态信息算出,因此只要确定了Hm1,2即可得到Hm1,3。

2.3推导Hm1,2

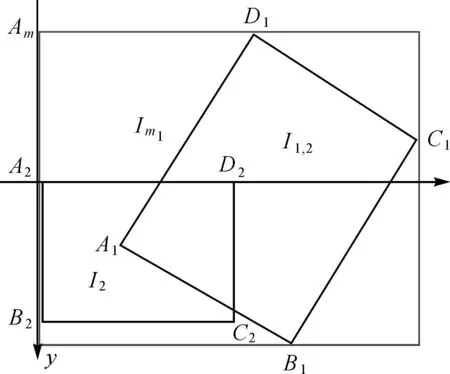

由于图像Im1是由图像I1和I2拼接得到,其中I1向I2做变换后得到图像I1,2,而图像I2本身没有发生变形。因此I2完整地包含在Im1里面,所以Hm1,2为一个三维平移矩阵。因此设

(19)

式中,平移量x和y可以取图像I2与Im1顶点的平移量。如图4所示,以A2作为坐标原点,若图像I1和I2的大小分别为m1×n1和m2×n2,则图上各点坐标分别为A2(0,0)、B2(0,n2)、C2(m2,n2)、D2(m2,0),而A1、B1、C1、D1分别可以通过(0,0)、(0,n1)、(m1,n1)、(m2,0)与H1,2运算得到。

图4 两幅图像拼接Fig.4 Sample of two images mosaic

则图像Am(xm,ym)的坐标为

(20)

因此矩阵Hm1,2的平移分量为

(21)

这样我们就得到了变换矩阵Hm1,2,进一步由式(18)可以得到矩阵Hm1,3,从而实现多幅图像的连续拼接。

3相关试验和结果分析

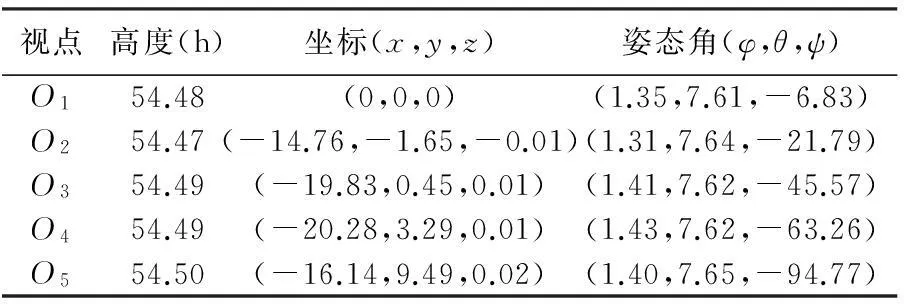

试验选取无人机在位置O1—O5所拍摄的5幅图像I1—I5,图像大小为960×540。其中5个视点之间的坐标和姿态角如表1所示(试验中将O1作为世界坐标原点,测量参数均为校正后的结果)。试验平台为IntelCore(TM)i5-4590CPU3.30GHz,16GB内存,仿真软件为MATLAB7.0。通过相机标定得到相机的内参数矩阵为

表1 各视点的坐标和姿态角

视点高度(h)坐标(x,y,z)姿态角(φ,θ,ψ)O154.48(0,0,0)(1.35,7.61,-6.83)O254.47(-14.76,-1.65,-0.01)(1.31,7.64,-21.79)O354.49(-19.83,0.45,0.01)(1.41,7.62,-45.57)O454.49(-20.28,3.29,0.01)(1.43,7.62,-63.26)O554.50(-16.14,9.49,0.02)(1.40,7.65,-94.77)

3.1图像配准和拼接试验

(1) 利用各视点的坐标和姿态信息,计算各视点与O1之间的单应变换矩阵,然后根据式(17)计算出相邻视点航拍图像之间的变换矩阵。

(2) 根据2.3节计算出Hm1,2,进而由式(18)及H2,3得到Hm1,3。

(3) 同样可以得到Hm2,4与Hm3,5。

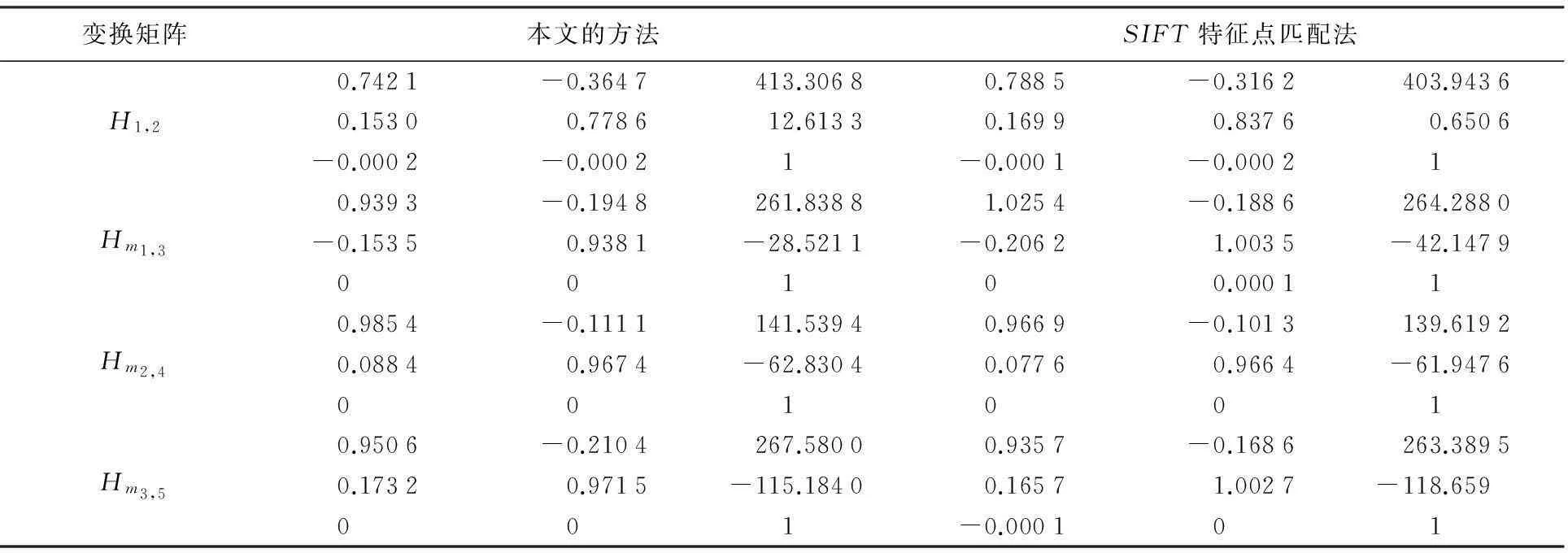

为验证本文方法的有效性,选择利用SIFT特征点匹配的方法进行对比,结果如表2所示。

表2 试验结果

图5 拼接结果Fig.5 Result of the image mosaic

3.2结果分析

图5(d)、(e)分别为本文方法和用SIFT特征点匹配法的拼接结果,可以看出本文方法与SIFT特征点匹配法的图像拼接效果基本相同,但是在场景细节中还存在一些差距(比如图(d)中篮球场区域的拼接出现错位)。这主要是因为航拍参数测量误差的原因,虽然经过了参数的校正,但是由于校正模型精确度的影响,由航拍参数计算出的单应变换矩阵不可避免地会出现误差。为更好地比较两种方法图像配准的准确程度,定义两幅配准图像中每个匹配特征点的匹配误差和平均配准误差分别为

(22)

(23)

式中,Ex(i)与Ey(i)分别表示第i个特征点匹配的坐标误差,定义如下

(24)

x1(i)、x2(i)分别表示第i个特征点在第1幅图像和第2幅图像中的横坐标;y1(i)、y2(i)分别表示第i个特征点在第1幅图像和第2幅图像中的纵坐标。

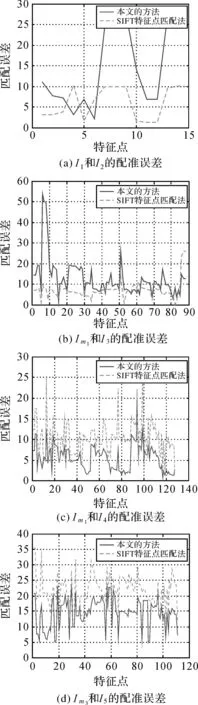

比较两种方法在4次图像拼接中的配准误差,结果如图6所示。

表3为两种方法的平均匹配误差以及最终的图像拼接时间。可以看出SIFT方法在初始的图像配准中效果好于本文方法,但是随着拼接图像的增加而带来的累积误差,之后该方法的图像配准误差明显增大,而且效果也不如本文的方法。这是因为本文方法通过航拍参数推导图像之间的变换矩阵,连续拼接时拼接图像与航拍图像之间的变换矩阵也是根据航拍图像间的变换矩阵推导而来,因此拼接的累积误差也就只与航拍图像的配准精度相关。也就是说只要得到的航拍图像之间的变换矩阵足够准确,多幅图像连续拼接的误差就不会越来越大。从试验的拼接误差可以发现用特征匹配的方法会导致拼接误差逐渐增大(从6.129增加到21.6),而本文方法的拼接误差基本不随图像的增加而变大。同时可以发现本文方法的拼接速度更快,这是因为该方法只需要进行一些矩阵的运算,而不用提取图像的特征点,因此可以极大地减少图像拼接时间。而对于基于SIFT特征的一类拼接方法,提取图像的SIFT特征极为耗时(提取特征点的耗时占总拼接时间的80%左右)。即便是一些方法采用改进的SIFT描述子(比如SURF等方法)提高特征提取速度,但其拼接耗时仍然大大高于本文的方法。

图6 图像配准误差结果 Fig.6 Error result of image registration

拼接图像特征点数本文方法SIFT方法误差时间/s误差时间/sIm11514.8951.007 6.1293.565Im28812.7151.1447.0395.244Im31295.4831.22810.2297.043Im411114.5191.33321.6008.679

4结论

本文结合无人机航拍的特点,提出了一种利用航拍参数进行图像快速配准的方法。该方法对于航拍图像的质量和场景信息要求不高,主要依赖航拍图像对应的无人机姿态和坐标的测量精度。试验结果显示,本文方法对于低分辨率的航拍视频影像能有效地降低图像拼接的时间,而且对于多幅图像连续拼接产生的累积误差更小。但是对于高分辨率的航拍图像的拼接和几何处理仍需要POS系统提供高精度的测量数据支持。下一步工作是通过建立更好的航拍参数校正模型来提高测量参数的精度,进一步提高航拍图像的拼接效果。

参考文献:

[1]阮芹, 彭刚, 李瑞. 基于特征点的图像配准与拼接技术研究[J]. 计算机与数字工程, 2011, 39(2): 141-144, 183.

RUANQin,PENGGang,LIRui.StudyonImageRegistrationandMosaicTechnologhyBasedonSurfFeature[J].Computer&DigitalEngineering, 2011, 39(2): 141-144, 183.

[2]吕金建, 文贡坚, 李德仁, 等. 一种新的基于空间关系的特征匹配方法[J]. 测绘学报, 2008, 37(3): 367-373, 379.

LÜJinjian,WENGongjian,LIDeren,etal.ANewMethodBasedonSpatialRelationsforFeatureMatching[J].ActaGeodaeticaetCartographicaSinica, 2008, 37(3): 367-373, 379.

[3]LOWEDG.ObjectRecognitionfromLocalScale-invariantFeatures[C]∥Proceedingsofthe7thIEEEInternationalConferenceonComputerVision.Kerkyra:IEEE, 1999: 1150-1157.

[4]LOWERDG.DistinctiveImageFeaturesfromScale-invariantKeypoints[J].InternationalJournalofComputerVision, 2004, 60(2): 91-110.

[5]KEYan,SUKTHANKARR.PCA-SIFT:AMoreDistinctiveRepresentationforLocalImageDescriptors[C]∥Proceedingsofthe2004IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition.Washington:IEEE, 2004: 511-517.

[6]MIKOLAJCZYKK,SCHMIDC.APerformanceEvaluationofLocalDescriptors[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2005, 27(10): 1615-1630.

[7]BAYH,TUYTELAARST,VANGOOLL.SURF:SpeededUpRobustFeatures[C]∥Proceedingsofthe9thEuropeanConferenceonComputerVision.Berlin:Springer-Verlag, 2006: 404-417.

[8]罗楠, 孙权森, 耿蕾蕾, 等. 一种扩展SURF描述符及其在遥感图像配准中的应用[J]. 测绘学报, 2013, 42(3): 383-388.LUONan,SUNQuansen,GENGLeilei,etal.AnExtendedSURFDescriptorandItsApplicationinRemoteSensingImagesRegistration[J].ActaGeodaeticaetCartographicaSinica, 2013, 42(3): 383-388.

[9]MORELJM,YUGuoshen.ASIFT:ANewFrameworkforFullyAffineInvariantImageComparison[J].SIAMJournalonImagingSciences, 2009, 2(2): 438-469.

[10]CABALLEROF,MERINOL,FERRUZJ,etal.HomographyBasedKalmanFilterforMosaicBuilding.ApplicationstoUAVPositionEstimation[C]∥Proceedingsofthe2007IEEEInternationalConferenceonRoboticsandAutomation.Roma:IEEE, 2007: 2004-2009.

[11]李岩山, 裴继红, 谢维信, 等. 一种新的无人机航拍序列图像快速拼接方法[J]. 电子学报, 2012, 40(5): 935-940.

LIYanshan,PEIJihong,XIEWeixin,etal.ANewFastAutomaticMosaicMethodonUnmannedAerialVehicleImages[J].ActaElectronicaSinica, 2012, 40(5): 935-940.

[12]XIONGPeng,LIUXianpeng,GAOChao,etal.AReal-timeStitchingAlgorithmforUAVAerialImages[C]∥Proceedingsofthe2ndInternationalConferenceonComputerScienceandElectronicsEngineering.Paris:AtlantisPress, 2013: 1613-1616.

[13]何宾, 陶丹, 彭勃. 高实时性F-SIFT图像拼接算法[J]. 红外与激光工程, 2013, 42(S2): 440-444.

HEBin,TAODan,PENGBo.HighReal-timeF-SIFTImageMosaicAlgorithm[J].InfraredandLaserEngineering, 2013, 42(S2): 440-444.

[14]杨宇博, 程承旗. 基于分块Harris特征的航拍视频拼接方法[J]. 北京大学学报(自然科学版), 2013, 49(4): 657-661.YANGYubo,CHENGChengqi.BlockHarrisBasedMosaicMethodforAerialVideo[J].ActaScientiarumNaturaliumUniversitatisPekinensis, 2013, 49(4): 657-661.

[15]FISCHLERMA,BOLLESRC.RandomSampleConsensus:AParadigmforModelFittingwithApplicationstoImageAnalysisandAutomatedCartography[J].CommunicationsoftheACMCACMHomepageArchive, 1981, 24(6): 381-395.

[16]何贝, 王贵锦, 沈永玲, 等. 结合地理参数的航拍视频实时拼接算法[J]. 应用科学学报, 2012, 30(2): 151-157.

HEBei,WANGGuijin,SHENYongling,etal.Real-timeMosaicingforAerialVideosCombinedwithGeographicalParameters[J].JournalofAppliedSciences:ElectronicsandInformationEngineering, 2012, 30(2): 151-157.

[17]徐玉华, 龚文全, 苏昂, 等. 近似平面场景多视点图像拼接算法[J]. 国防科技大学学报, 2014, 36(2): 148-155.

XUYuhua,GONGWenquan,SUAng,etal.Multi-viewpointImageMosaicingAlgorithmforRoughlyPlanarScenes[J].JournalofNationalUniversityofDefenseTechnology, 2014, 36(2): 148-155.

[18]YAHYANEJADS,WISCHOUNIG-STRUCLD,QUARITSCHM,etal.IncrementalMosaickingofImagesfromAutonomous,Small-scaleUAVs[C]∥Proceedingsofthe2010SeventhIEEEInternationalConferenceonAdvancedVideoandSignalBasedSurveillance.Boston:IEEE, 2010: 329-336.

[19]朱云芳. 摄像机径向畸变校正和内参估计的单图标定方法[J]. 光电工程, 2012, 39(9): 125-131.

ZHUYunfang.CalibrationofRadialDistortionandIntrinsicParametersUsingaSingleImage[J].Opto-ElectronicEngineering, 2012, 39(9): 125-131.

[20]丁建华, 姚明海, 赵瑜. 基于单应性矩阵的机器人视觉伺服系统研究[J]. 机电工程, 2012, 29(12): 1485-1489.

DINGJianhua,YAOMinghai,ZHAOYu.StudyofVisualServoingSystemofRobotBasedonHomographyMatrix[J].JournalofMechanical&ElectricalEngineering, 2012, 29(12): 1485-1489.

[21]唐琎, 谷士文, 蔡自兴. 图象拼接误差的理论分析[J]. 小型微型计算机系统, 2003, 24(12): 2185-2189.

TANGJin,GUShiwen,CAIZixing.TheoreticalAnalysisonImageStitchingError[J].Mini-MicroSystems, 2003, 24(12): 2185-2189.

[22]李从利, 薛模根, 冷晓艳, 等. 空中侦察序列图像连续拼接的累积误差分析与消除[J]. 中国图象图形学报, 2008, 13(4): 814-819.

LICongli,XUEMogen,LENGXiaoyan,etal.AnalysisandEliminationonAerialReconSequentialImageStitchingAccumulativeError[J].JournalofImageandGraphics, 2008, 13(4): 814-819.

(责任编辑:丛树平)

修回日期: 2016-02-02

Firstauthor:CHENGZhenggang(1988—),male,post-graduate,majorsinimageprocessing,computervisionandsoon.

E-mail:chengzhenggang2012@163.com

E-mail:chinazhangli@tsinghua.edu.cn

An Aerial Image Mosaic Method Based on UAV Position and Attitude Information

CHENG Zhenggang,ZHANG Li

Department of Electronic Engineering, Tsinghua University, Beijing 100084, China

Abstract:As the existing methods for aerial image mosaic take high computational, a fast and effective algorithm based on the position and attitude information of unmanned aerial vehicles (UAV) is proposed. Firstly, the coordinates and attitude angles of UAV can be obtained by airborne GPS and inertial measurement unit (IMU), and each aerial image has a corresponding position and attitude information. The homography matrix between two aerial images with the positions and attitude information can be calculated. Then the registration of the mosaic images is obtained by the operation of homography matrix. Finally, the multiple images can be stitched and the whole panorama got. A large number of experiments demonstrate this algorithm is efficient.

Key words:aerial image; position and attitude; image registration; homography matrix; panorama

中图分类号:P231

文献标识码:A

文章编号:1001-1595(2016)06-0698-08

基金项目:国家自然科学基金(61172125;61132007)

收稿日期:2015-11-05

第一作者简介:程争刚(1988—),男,硕士生,研究方向为图像处理、计算机视觉等。

通信作者:张利

Correspondingauthor:ZHANGLi

引文格式:程争刚,张利.一种基于无人机位姿信息的航拍图像拼接方法[J].测绘学报,2016,45(6):698-705. DOI:10.11947/j.AGCS.2016.20150567.

CHENG Zhenggang,ZHANG Li.An Aerial Image Mosaic Method Based on UAV Position and Attitude Information[J]. Acta Geodaetica et Cartographica Sinica,2016,45(6):698-705. DOI:10.11947/j.AGCS.2016.20150567.