基于双向稀疏光流融合的小目标检测方法

2016-06-24曹建文

王 华,王 倩,顾 鑫,李 潇,曹建文,夏 耘

(中国运载火箭技术研究院研究发展中心,北京 100076)

基于双向稀疏光流融合的小目标检测方法

王华,王倩,顾鑫,李潇,曹建文,夏耘

(中国运载火箭技术研究院研究发展中心,北京 100076)

摘要:针对动态背景下的小目标检测问题,提出了基于双向稀疏光流融合的目标检测方法。首先采用FAST方法提取当前帧图像中的角点,然后在连续的三帧图像中进行前、后向稀疏光流跟踪,确定正确匹配的特征点对,利用匹配的特征点对计算用于背景补偿的帧间运动参数,最后在背景补偿的基础上进行三帧差分,以检测出图像中的运动小目标。实验结果显示,本算法能够很好地解决背景和目标同时快速运动的问题,为运动目标的跟踪奠定基础。

关键词:FAST;动态背景;稀疏光流;帧差;背景补偿

在对地精确打击任务中,导引头经常需要对处于复杂背景下的移动目标进行精确的检测与跟踪,为精确打击武器的制导控制提供目标信息。在复杂地物背景下的小运动目标检测中,由于背景复杂,且对地成像装置的高速运动导致背景快速移动、旋转或缩放,对目标检测系统的性能有着至关重要的影响[1]。目前常用的方法是模板匹配方法,然而对于背景复杂且目标面积较小的情况,极易因目标模板更新使得模板出现漂移,影响目标跟踪的精度。另一种常见的方法是利用相邻两帧帧差将目标轮廓提取出来,但这种方法存在背景噪声严重,容易出现虚假目标的缺点。为了克服这种缺点,本文采用FAST角点检测、双向稀疏光流与三帧差分的方法,实现了对动态背景的实时补偿和复杂背景下的运动小目标检测。

1算法流程

利用稀疏光流实现目标检测的流程图如图1所示。

图1 算法处理流程图

主要流程如下:

1)在Icur图像中检测FAST特征点并进行特征点筛选。

2)计算当前帧特征点在中间帧内的对应位置,即进行前向光流跟踪;再验证中间帧的匹配特征点到当前帧的运动矢量,即进行后向光流跟踪;剔除经过双向光流跟踪后,与原位置距离较远的匹配点对。

3)用匹配的特征点对计算投影变换矩阵Hcur→cen。

4)利用Hcur→cen将当前帧图像变换到中间帧坐标系下,并与之作差,得到差值图Dcur→cen,从帧差图像存储队列取出Dcur→pre。

5)对Dcur→cen和Dcur→pre进行二值分割,区分出变动的像素,并将Dcur→cen存入到帧差图像存储队列作为下一帧计算时的Dcur→pre。

6)将前向差值图Dcur→cen与后向差值图Dcur→pre进行逻辑“与”运算,获得三帧差值图,此差值图的前景像素中包含有中间的完整目标区域。

2角点提取

2.1FAST特征点检测

FAST是一种最新的角点检测器,其特征检测原理如图2所示。其显著性判据很好地结合了相应的机器学习方法,使得角点检测的时间消耗达到毫秒级别。因此,FAST在具有比较高的实时要求的应用中得到越来越多的使用[2]。

图2 FAST特征检测原理与示例

本文中采用FAST角点判据如下:以p为特征点中心,取半径为3的圆上的16个点,当该圆上连续存在n个比p处灰度高(或低)的像素,且p点灰度与上述圆弧各点灰度差值累积和在图像平面的一定邻域内为最大时,就认为p为角点。本文中取n=9,t=20。

2.2FAST特征点筛选

在分辨率为384×288的可见光图像中,平均检测到FAST特征点在2 000个左右(包括非极大值抑制环节),直接用这些点进行帧间运动估计会造成算法运算量过大,降低了算法的实时性,本文采用如下策略筛选出可靠特征点:将原始图像水平和垂直方向分成固定的矩形栅格,每个栅格中保留一个FAST特征检测得分最高的点。按栅格取特征点有助于特征点在空间上散布于整个图像平面,有助于帧间背景运动参数计算的高精准度。

图3显示了连续两帧图像提取到的FAST角点,图3a为前一帧图像提取到的FAST角点,图3b为当前帧图像提取到的FAST角点。可以看出,根据筛选后的角点分布均匀,且一致性较好。

a 前一帧图像提取的角点

b 当前帧图像提取的角点

3基于双向稀疏光流的特征点帧间运动估计

3.1基于区域匹配的稀疏光流计算法

传统意义上的光流计算方法是稠密光流法,其计算复杂,因而在实时性上大多无法保证,因而在大多数实时系统中无法直接使用稠密光流进行计算[3]。稀疏光流法只需对图像中具有某些特征的像素点进行光流计算,既能够很好地反映出被检测图像的运动特征,也能极大地降低计算量。

基于区域的稀疏光流计算方法是在图像序列中寻找一种前后帧图像之间对应关系,它将光流定义为使得不同时刻图像区域之间产生最佳拟合的位移。假定有两帧连续图像分别为I1和I2,对图像I1中的每个特征点(x, y),以此点为中心,2n+1为边长形成一个正方形的相关窗口wc。在图像I2中(x, y)点处剪切一个尺寸为(x-N,y-N),(x+N,y+N)的正方形子图作为搜索窗口ws,搜索范围N可根据两幅图像间的最大可能位移来具体确定。搜索范围的大小决定了算法的运算速度,搜索范围越大则计算量越大,计算速度越慢,反之则计算量越小,计算速度越快。本文中n=3,N=15。

本文中的区域匹配算法采用互相关匹配法,其公式如

(1)

3.2双向稀疏光流融合改进策略

根据目标前一段时间在图像坐标中的运动速度,确定相应的帧数进行差分,因此导致了搜索窗口的大小不固定;其次,由于背景运动时导致图像不清晰,特征点本身的提取不够稳定、成像噪声及遮挡等问题的影响,会造成区域匹配出现错误。

本算法采用双向跟踪的处理策略:首先由Icur→Icen,得到中间帧中特征点位置,此时的搜索区域ws可与选取得比较大,保证次区域能够覆盖目标在帧间隔下的运动最大距离;再以此位置为起始完成由Icen→Icur的特征点跟踪,此时ws应取较小值,当反向跟踪与特征点原始位置重合才认为跟踪是可靠的,否则丢弃跟踪获得的特征点对。

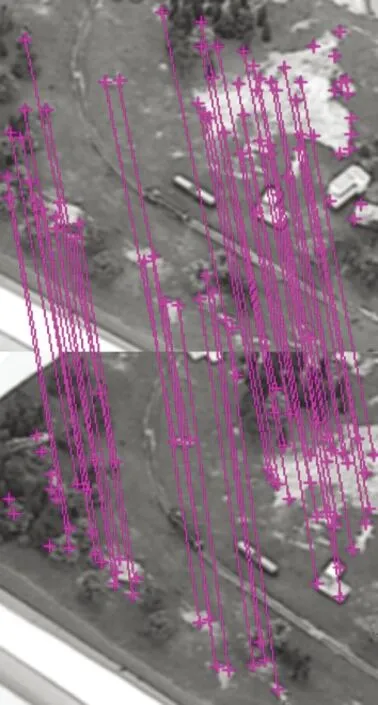

通过上述的过滤约束,可以极大地降低外点概率,以图3a和图3b两帧图像为例,采用单向稀疏光流进行匹配时,得到匹配点对为65对,其中错误匹配为21对,采用双向稀疏光流融合策略后,得到的匹配点对为55对,其中匹配错误的为4对,双向稀疏光流匹配后的点对示意图如图4所示,可见双向融合策略大大降低了匹配错误的点对数量。

3.3单应矩阵估计

图像坐标是一个典型的二维坐标,图像变换可以用一个可逆的单应矩阵来表示。令X和X′为两张图的对应特征点,令单应矩阵为

图4 特征点匹配结果

(2)

则

X′ =HX

(1)

一组对应特征点对为单应矩阵的求解提供了2个约束方程,要完全求解H,至少需要4组对应特征点对。

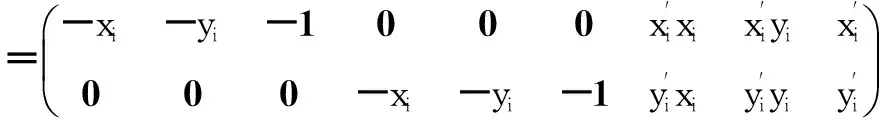

将单应矩阵写成矢量形式h=(h11, h12, h13, h21, h22, h23, h31, h32, h33)T,给定一组特征点对重写上式为

Aih=0

(3)

式中:Ai为2×9矩阵,即

(4)

计算8自由度的矩阵H,最少需要4组对应特征点对(且满足其中任意3对点不共线),相应的Ai构成8×9矩阵A。若已知对应点对n≥4,且均为精确对应点,则对于方程Ah=0,h存在非零的精确解。实际应用中,从图像中获得点位置必然存在误差,通常用最小二乘法求解

(5)

即对ATA进行特征值分解,h为零特征值(或最接近零的特征值)所对应的特征向量。

4三帧差分检测目标

4.1三帧差分

为保证差分出整个目标区域,采用三帧中相邻两帧帧差的方法。利用上述FAST角点与双向稀疏光流融合方法对间隔帧的背景运动进行补偿后进行帧差,图5给出了三帧两两帧差的示意图[4]。对于当前帧Icur,需要计算它到中间帧Icen的运动补偿,以实现Icen中的目标检测,同时还需计算中间帧Icen到当前帧Icur的运动补偿,方便当前帧作为中间帧时的三帧差处理。三帧差分处理的示意图如图5所示。

图5 三帧差分计算示意图

4.2目标检测流程

三帧差分目标检测处理环节按以下步骤进行:

1)初始化。

2)计算连续三帧图像的差分结果。

3)二值化差分值。二值化分割的阈值选取需考虑相机自动增益控制、白平衡及视频传输噪声等因素的影响。对每个像素的分割阈值选取当以总体像素值的标准差为基础,结合像素局部区域平均亮度自适应调整。

4)去噪。对于二值化后的图像,利用数学形态学方法进行滤波处理,去除二值图像中的噪声干扰。

5)目标区域提取,采用区域连通方法,对二值图像中的连同区域进行提取,并计算目标的质心点和目标面积(长、宽)。

6)目标位置映射。经过了三帧差处理环节后,若第Icen帧检测到目标,则需通过后向映射,得到目标在第Icur帧的位置。考虑到目标在当前帧Icur和中间帧Icen中的位置临近,且外观和几何参数相似,这里将Icen帧中的目标映射到Icur帧坐标系下,再在其周围临近区域搜索相似的运动区域,最终获得当前帧Icur中的目标区域。

5实验结果及分析

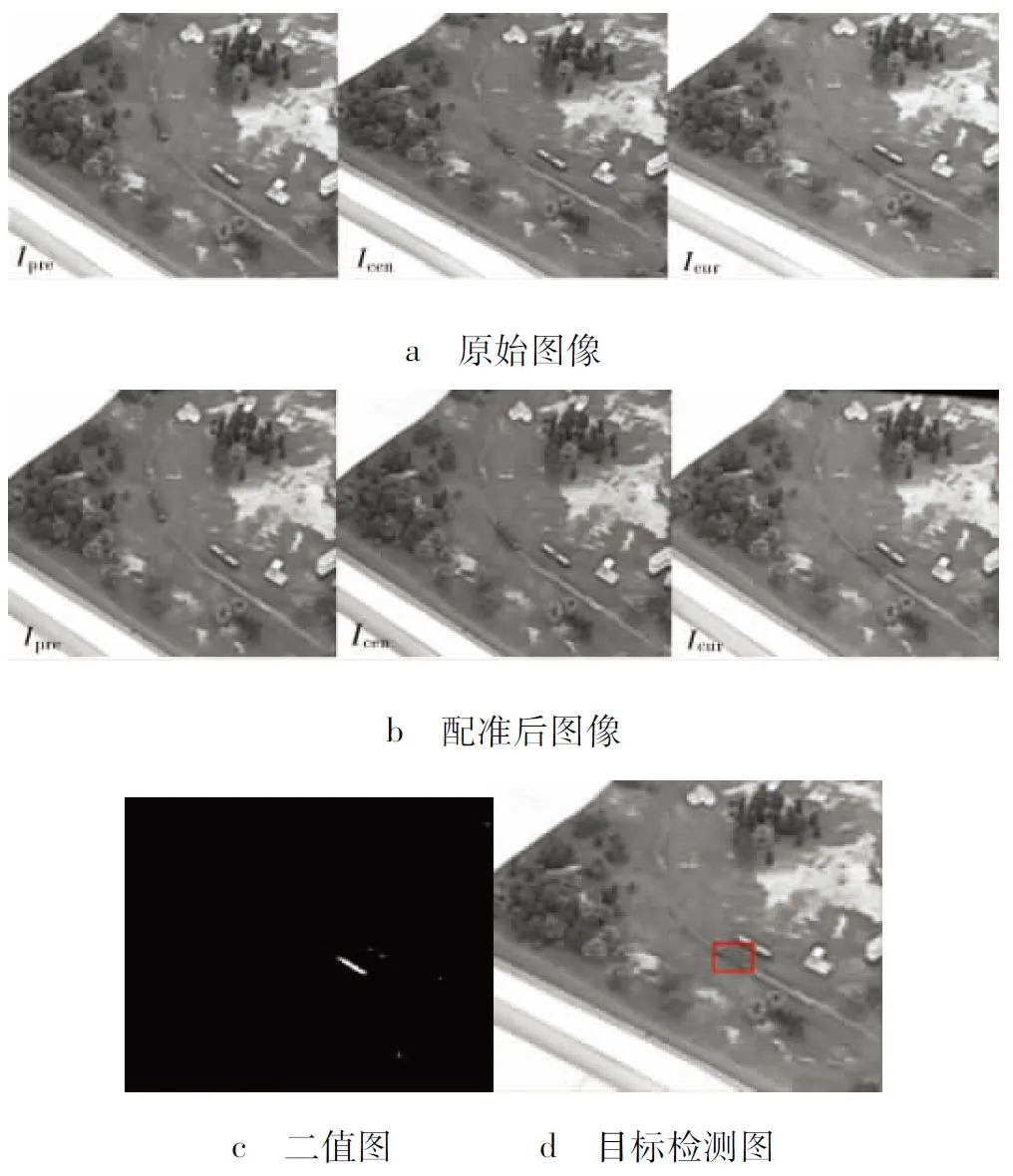

本文的算法已经在实验室仿真环境下进行了仿真验证。试验用硬件为联想8300t计算机,Intel(R)Corei7-2600,主频3.4GHz,内存为2Gbyte。试验前预先截取300帧连续的图片序列,图片大小为320×240像素。首先通过人工方式对图像序列中的目标位置、大小进行标定,然后利用本文的算法、模板检测法、相邻帧帧差法对图片中的目标进行检测,算法检测结果与人工标定的结果进行比对,图6a为仿真过程中的连续三帧图像,图6b为经过双向稀疏光流融合特征点对检测后经过背景补偿的图像,图6c为三帧差分并经过噪声滤除后的二值图,图6d为经过目标映射后的当前帧目标检测结果。从仿真结果可以看出,本文的背景补偿方式有效的消除了背景的帧间运动,并检测出了较完整的目标形状,通过中间帧的目标检测结果可以很好地映射回当前帧的目标位置。

图6 帧差图像结果

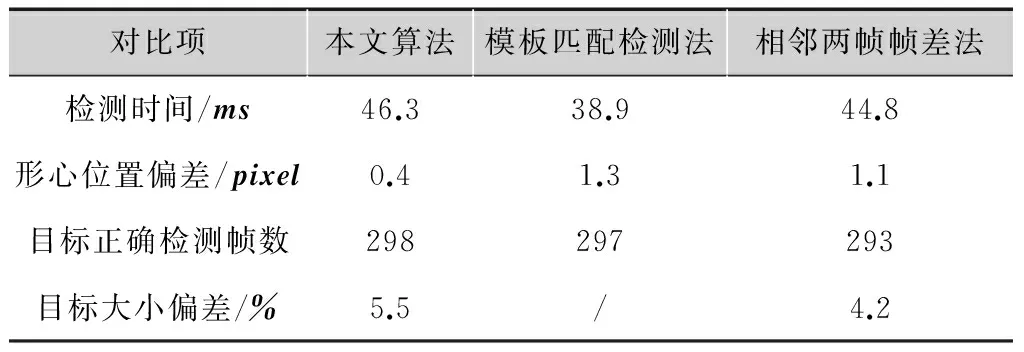

算法对比结果如表1所示。

表1算法检测结果对比

对比项本文算法模板匹配检测法相邻两帧帧差法检测时间/ms46.338.944.8形心位置偏差/pixel0.41.31.1目标正确检测帧数298297293目标大小偏差/%5.5/4.2

从表1可看出,本算法在检测的目标位置、目标检测正确帧数上比另外两种传统方法更优。在检测时间上比模板匹配法稍长,与相邻两帧帧差法相似,这是因为通过流程优化,本文算法在每一次处理流程中只需进行一次帧差计算,计算量与相邻两帧帧差法相当。检测的目标大小偏差由于本算法引入了两幅差分图,使得目标大小偏差比两帧差分略大。

6结论

本文介绍了一种基于双向稀疏光流融合的目标检测方法。在运动目标检测之前,引入了基于双向稀疏光流法计算图像的帧间运动参数,并基于运动参数对背景区域进行全局运动补偿确保背景区域的一致性,然后再进行图像的三帧差分获取中间帧目标位置及区域,再通过当前帧与中间帧之间的映射关系将中间帧的目标位置及区域映射到当前帧,从而实现了小目标的检测。该算法使用了双向稀疏光流融合策略,提高了角点匹配的准确性,而且通过流程优化,在每一次处理流程中只需进行一次帧差计算,减小了计算量。在运动小目标检测中,使用三帧差分的方法与目标位置映射方法,比模板匹配法和相邻两帧差分法提高了运动目标检测的正确性和目标位置的精确性。

参考文献:

[1]MARKANDYV,REIDA,WANGS.Motionestimationformovingtargetdetection[J].IEEEtransactionsonaerospaceandelectron.system, 1996, 32(3): 866-874.

[2]王飞宇,邸男,贾平.结合尺度空间FAST角点检测器和SURF描绘器的图像特征[J].液晶与显示,2014,29(4):598-604.

[3]牛一捷.一种基于稀疏表达和光流的目标跟踪方法[J].大连交通大学学报,2014,35(2):102-107.

[4]丁莹,范静涛,杨华民,等.基于图像配准的动态场景运动目标检测算法[J].长春理工大学学报,2013,36(1-2):4-9.

Movingtargetdetectionmethodbasedonbidirectionalsparseopticalflow

WANGHua,WANGQian,GUXin,LIXiao,CAOJianwen,XIAYun

(China Academy of Launch Vehicle Technology R&D Center, Beijing 100076,China)

Abstract:A target detection method to detect small target in dynamic background based on the fusion of bidirectional sparse optical flow is proposed. At first, corners in current image are extracted based on FAST method, and then bidirectional sparse optical flow between continuous frames are executed to determine matching points, and uses these pairs of matching points to calculate motion parameters between frames. Finally, after executing background compensation, frame difference is done to detect small moving target in image. The experimental results show that this algorithm can well deal with rapid motion both of the background and targets.

Key words:FAST; dynamic background; sparse optical flow; frame difference; background

中图分类号:TP391.4

文献标志码:A

DOI:10.16280/j.videoe.2016.03.026

作者简介:

王华(1979— ),工程师,主要研究方向为信息探测总体技术,信号处理;

王倩(1983— ),女,工程师,主要研究方向为信号处理,信息传输方向。

责任编辑:闫雯雯

收稿日期:2015-03-25

文献引用格式:王华,王倩,顾鑫,等. 基于双向稀疏光流融合的小目标检测方法[J].电视技术,2016,40(3):122-125.

WANGH,WANGQ,GUX,etal.Movingtargetdetectionmethodbasedonbidirectionalsparseopticalflow[J].Videoengineering,2016,40(3):122-125.