基于对象的监控视频摘要生成优化方法❋

2016-06-16蔡晓东梁奔香朱利伟桂林电子科技大学信息与通信学院桂林541004

吴 迪,蔡晓东,华 娜,梁奔香,朱利伟(桂林电子科技大学信息与通信学院,桂林 541004)

基于对象的监控视频摘要生成优化方法❋

吴 迪,蔡晓东,华 娜,梁奔香,朱利伟

(桂林电子科技大学信息与通信学院,桂林541004)

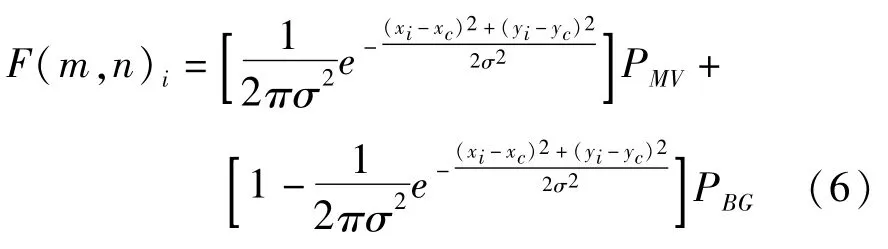

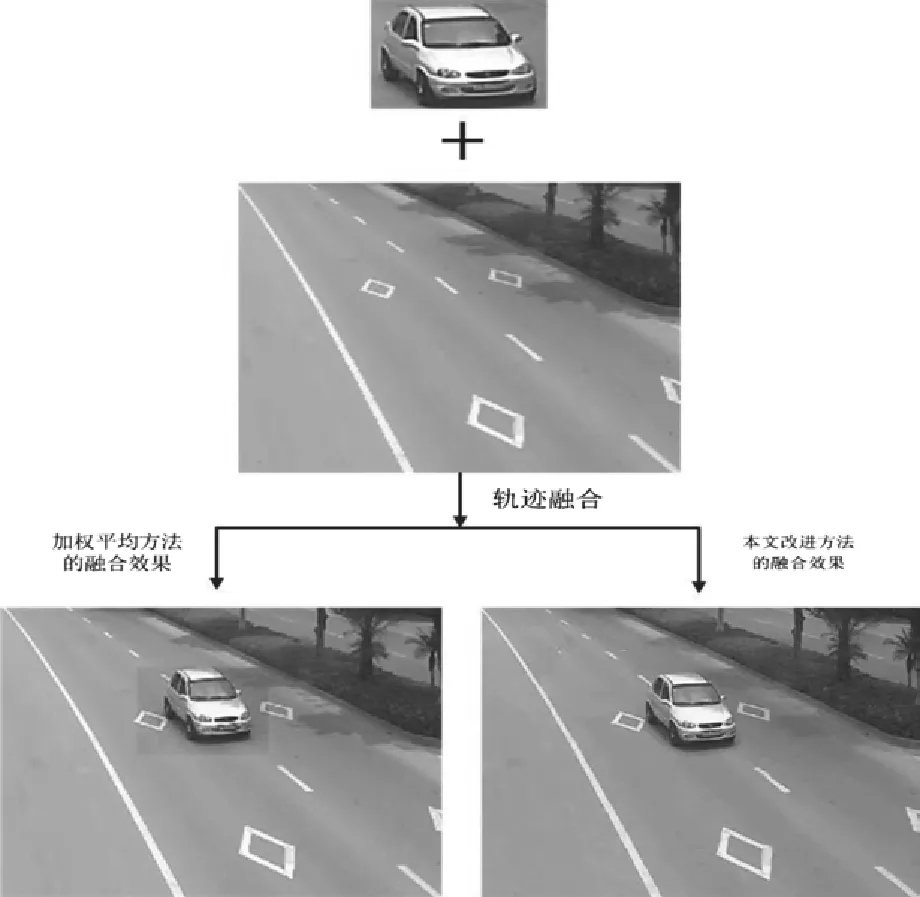

摘 要:随着监控技术和网络技术的飞速发展,高清网络监控摄像头广泛应用于各个行业。这些高清摄像头全天候工作,产生了海量的监控视频数据。如何快速完整的浏览长时间的监控视频已经成为监控行业目前亟待解决的问题。视频摘要就是解决“海量视频数据处理”的重要手段。然而,传统的基于关键帧的视频摘要生成方法采用帧采样无法完整表示每个对象的运动轨迹,从而导致大量有用视频信息的丢失。针对监控视频的特点,设计了一种基于对象的视频摘要生成处理框架,对比传统摘要生成方法分析了监控视频摘要生成框架所需的核心技术:目标检测跟踪与轨迹提取、运动目标轨迹的组合优化和轨迹融合之像素融合,得到了一个比原始视频短的多的摘要视频,实现了快速浏览且保留了原始视频中大多数运动对象的信息。 当帧背景和运动对象融合时可以看做是大图和小图的融合,可实际上参与融合计算的是小图及其粘贴后的同等大小背景部分区域图片,在这里直接当做是同等大小图像的融合。假设参加融合的运动对象的图像和摘要帧背景的图像分别为MV和BG,图像大小为M*N,经融合后得到的融合结果图像为F,那么,对于MV、BG两个图像像素值的加权平均融合过程[10]可以表示为: 当帧背景和运动对象团块差异很大时,对加权平均融合方法和本节提出的基于高斯分布的融合方法的融合效果进行比较,融合效果对比示意图如图9所示。

关键词:视频监控;视频摘要;运动目标检测;多目标跟踪;轨迹组合优化;像素融合

1 引 言

21世纪以来,随着人们对公共安全的关注和需求不断上升,视频监控系统也因此得到广泛应用,每天有数以万计的摄像头在记录着城市的一举一动,由此产生了海量的监控视频。在视频监控领域,如何将长时间的原始视频文件浓缩为简短的视频从而快速准确的从海量监控视频数据中提取有用信息已经成为亟待解决的问题。正是视频监控市场的迫切需求催生并推动了视频摘要技术。

目前监控领域的视频摘要生成方法主要有两种:一是静态视频摘要中基于关键帧的摘要;二是动态视频摘要中基于对象的视频摘要。

基于关键帧的视频摘要方法,是通过分析原始视频,首先从镜头中提取得到反映原始视频信息的关键视频帧,接着将关键帧组成相应的语义内容,实现快速浏览。顾名思义,该方法的核心内容就是关键帧的提取。现有的关键帧选取方法[1-4]主要通过图像颜色及纹理的差异性来判别是否为关键帧。基于关键帧的视频摘要的主要优点是结果简单,观看方便。对于这种静态的视频摘要方法,上文已经提到它只是对于视频中镜头的静态图像提取,结果过于简单,很难准确表达视频的内在含义,又由于其基于“帧”的特性分析,无法适应监控视频领域中需要对视频帧的“对象”进行特征分析的情况。同时,关键帧的提取依赖于图像的底层特征,而这些底层特征在不同场景中很容易受到周围环境(如光照)的影响使得图像不具有明显的区分度,且关键帧检测的计算量庞大因而无法进行在线处理。

基于对象的视频摘要方法,是目前监控视频领域常用的一种动态视频摘要。首先是提取用户的注意力目标,然后重建出用户感兴趣目标的视频摘要。通常涉及到的技术是背景建模后获取活动区域的方法,运动目标跟踪方法,多视频融合等[5-7]。这种方法可以高效动态的改变视频内容的相关特性,最小化时空冗余度,然而,基于对象的视频摘要方法存在着复杂场景下生成视频摘要困难的问题。

将基于事件分析的多目标鲁棒跟踪方法[8]、轨迹最优组合方法及图像融合技术充分的结合起来,解决了监控视频摘要压缩的问题,并降低了时空的冗余信息,为视频检索、突发事件、视频快速查看提供了支撑条件。

2 监控视频摘要处理框架

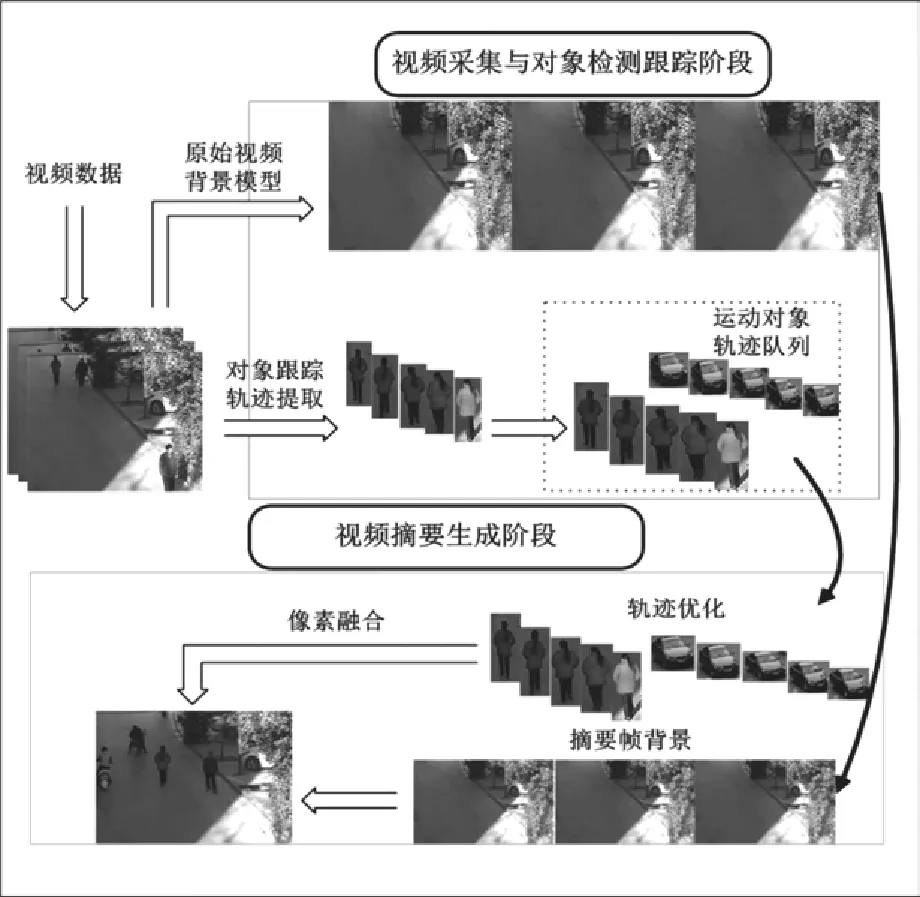

如图1所示是作者提出的监控视频摘要浏览处理流程,主要有两个处理阶段:

(1)视频采集与对象检测跟踪

在这个处理阶段,主要的核心算法是目标的检测与跟踪,对实时的要求比较高,这里主要的研究工作有:监控场景的视频流采集,高斯模型建立背景,目标的检测与跟踪。

图1 监控视频摘要浏览处理流程

(2)视频摘要生成

在这个处理阶段,主要的研究工作是轨迹优化和像素融合。

对于第一个处理阶段,文献[8]中已经做了详细说明,此文算法提出对多摄像机观察到的目标信息进行交接,从而识别出对应目标,解决了目标之间发生遮挡、分离事件后跟踪丢失的难题,具有较高的鲁棒性。

在第一个处理阶段的基础之上,本方法着重研究的是第二个处理阶段:轨迹优化和像素融合。

经过目标的检测跟踪,需要对上述提取到的运动轨迹进行重新组合。如何实现运动轨迹在时间上的压缩和空间上的平移,最大限度的去除冗余信息是轨迹组合的核心问题。文中提出一种改进的模拟退火轨迹组合优化算法,实现最大限度的时间压缩和空间对象平移。

由于受到拍摄场景、拍摄设备等的影响,直接将背景图片与生成的运动轨迹进行拼接,会看到明显的像素间断。为了实现轨迹与背景图片的无缝拼接,将高斯背景重建提取的大背景与跟踪得到的团块小前景进行了基于高斯分布的像素融合处理。

3 一种改进的模拟退火轨迹组合优化方法

3.1运动轨迹模型的建立

在三维时空模型中,原始视频中的任意一帧画面表示为I(x,y,t)。其中x、y是像素空间坐标,t是帧号。同理,摘要中的任意一帧画面表示为IA(x,y,t)。从原始视频中提取到所有运动目标的轨迹,形成运动目标轨迹集合,并表示为P ={p1,p2,p3,…,pn}。

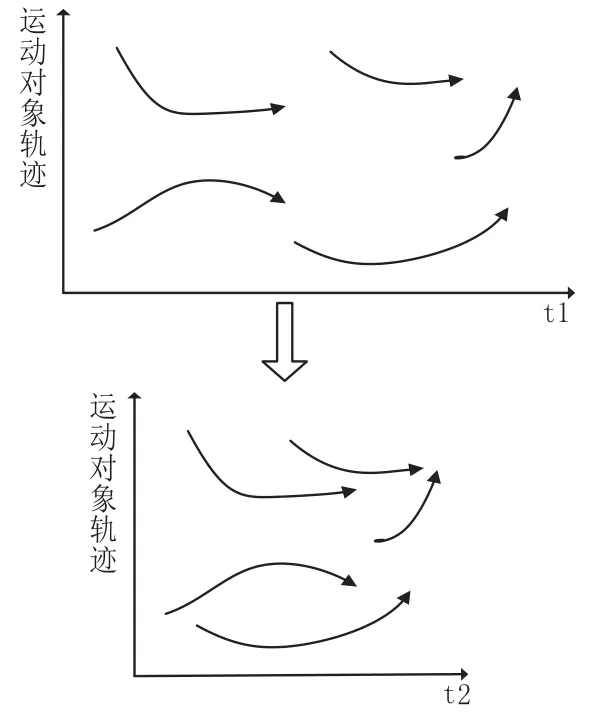

图2 轨迹组合示意图

如图2展示了原始视频运动轨迹生成视频摘要后在时间轴上平移的效果。运动轨迹集合P的重新组合也即是组合优化问题,类似集装箱模型,实现用最少的集装箱容纳更多的货物。笔者借鉴了上述模型的思想,通过建立能量模型,将组合优化问题转化成求解能量最小化的问题。接下来的一个小节是对该能量模型的进一步分析。

3.2能量函数

原视频中I(x,y,F(x,y,t))通过映射得到摘要视频的每一个像素IA(x,y,t),通过公式(1)的能量最小化函数得到映射函数F。

E(F)= Ea(F)+αEd(F)+βEc(F)(1)

其中Ea(F)表示轨迹能量损失,也即某一运动目标在原始视频中出现,而在摘要视频中没有出现。Eb(F)表示运动目标重叠代价,也即若干运动目标在摘要视频中出现了重叠的代价。Ec(F)表示运动目标时序一致性的代价,指某一些运动目标在原始视频中在某些帧一起出现,在视频摘要中应尽量保持这种关系。

假设运动目标p在原始视频中出现的时间为:tp=[ta出现的时间段为tp’=[tap’,tbp’]。如此,将原始视频中的所有运动目标通过映射函数F映射到摘要视频中,即得到P’={p1’,p2’,p3’,…,pn’}。将运动目标时间平移的组合优化问题转换成为求解下式的最小化问题。

E(F′)= Ea(F′)+αEd(F′)+βEc(F′)(2)

本节采用模拟退火方法来求解如上式所示的能量函数的最小值。然而,选择简单的映射方法很难保证模拟退火算法的初始分布足够均匀,从而导致该方法的效果不佳。

为了解决上述问题,本节提出了一种改进的模拟退火轨迹组合优化方法。该方法先采用聚类规划算法,将初始分布调整到足够均匀,然后采用模拟退火算法求解最优解。

3.3改进的模拟退火轨迹组合最优化

(1)基于聚类的规划算法

如图3所示,横轴表示该目标的起始时间,纵轴表示每一个目标。在摘要视频中间区域很稠密,而在开始和结束都会存在一个稀疏区域,没有满足均匀分布,采用基于聚类的线段树方法,来平衡摘要视频中每一帧的运动目标数目,避免目标在某一帧中过于集中,以至于难以将目标不重叠地融合到摘要视频中。采用该方法,还能将起点在相邻区域内的运动目标聚到一类,令其在摘要视频中按时间先后顺序出现在视频中。正如一个车道上发车的情景,前面车辆先离开,后面车辆不会和前面车辆有重叠的时候再发车。这样就可以避免运动目标在摘要视频中发生冲突、重叠或者交叉,有效减少了冲突的概率。如图4所示,横轴表示该目标的起始时间,纵轴表示每一个目标。与上图不同的是,在总行数一定的情况下,每行都有多个目标,这样可以保证每一帧出现的目标数一致,保证了运动目标在每一帧中的均匀分布,充分利用每一帧的空间,有效缩短了摘要视频的长度。

图4 视频空间规划分布图

(2)模拟退火算法

模拟退火算法(Simulated Annealing)得益于固体退火原理。固体加热材料粒子的不同结构对应于不同能级的粒子。在高温下,能量粒子可以自由移动和重新排列,在低温时,粒子的能量比较低。如果温度从高温开始缓慢的降到低温(这一过程称为退火),那么,粒子在每个温度可以达到热平衡。该算法最早于1953年Metropolis[9]等人提出。采用模拟退火算法求解组合优化问题,将目标随机散列在时空中当做初始解。算法从初始状态和一个随机初始温度开始,对当前解的组合进行交换求得新解的能量,如果新解的能量小于旧解,那么就接受新解的组合,否则会以一定概率接受新解。

(3)运动轨迹组合优化过程

上一小节简单介绍了模拟退火算法的基本原理,将模拟退火算法运用到求解视频摘要的组合优化问题需要确定两点:产生相邻解和选择初始解。

假设从原始视频中提取到n个运动目标轨迹P ={p1,p2,p3,…,pn},视频摘要的重视频长度为L,选择t =t降温方式,初始温度设置为t。

lg(i +1)0

本节将运动目标轨迹如何排列组合的问题转变成将运动目标映射到摘要视频中,使得能量函数取得最小的问题。每次产生新解,可以随机组合运动目标轨迹,交换其时间位置,然后计算其能量函数的能量是否比旧解小,如果小于旧解则接受新解,否者以一定概率接受新解。初始解的排列采用随机方式。为每一个目标随机选择其起始位置。求解新解也采用随机任意交换两运动目标后计算其能量。采用模拟退火的方式求解摘要视频最优排列组合的问题依赖于初始解的选取。

(4)实验结果小结

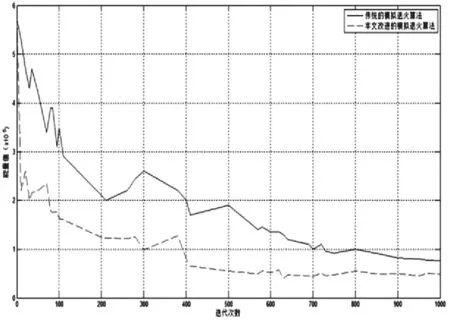

根据[8]得到场景卡口的运动轨迹个数35,原始视频时长为4分23秒,形成的摘要视频时长为2分24秒。假设初始温度为25000,终止温度为3000度,那么,传统的模拟退火算法和文中所述改进的模拟退火轨迹组合优化方法随着迭代次数的增加得到的能量趋势图如图5所示。

图5 迭代能量趋势图

由图5可知,改进的模拟退火方法收敛速度高于传统的模拟退火算法。这是由于文中首先进行了聚类规划分析,使得轨迹的初始分布足够均匀,然后又进行了基于模拟退火的能量最小求解。初始分布的足够均匀大大加快了模拟退火的收敛速度。

综上,在基于聚类分析之后结合模拟退火算法进行优化,相比传统的模拟退火算法收敛性能更好。

4 轨迹融合之像素融合

由于摄像头拍摄画面是变化的,以及摄像头自身拍摄条件的限制,再加上受到光照等环境因素的影响,从而导致对象轨迹与摘要帧背景直接粘贴会出现明显的拼接痕迹这一现象的发生。为了消除这一明显的拼接痕迹,就必须要实现摘要视频背景和跟踪的运动轨迹团块的无缝融合。

F(m,n)=ω1PMV(m,n)+ω2PBG(m,n)(3)

式中,PMV(m,n)和PBG(m,n)分别为MV和BG的像素值;m和n分别为图像中像素的行号和列号,且m =1,2,…,M,n = 1,2,…,N;w1、w2为加权系数,且w1+ w2=1;若w1= w2=0.5,则是平均融合。

通过平均融合方法对图像进行融合处理[10],它的特点是简单直观,适合实时处理,但是,在实际的视频摘要进行摘要帧背景和运动对象粘贴过程中采用该方法时,发现当两者的灰度差异很大时,还是会有比较明显的拼接痕迹。尝试加大摘要帧背景的权重w1,融合效果得到一定的改善。权重对融合效果起到这么关键的作用,这引发了作者的下一步思考——采用新的权重分配策略。接下来主要阐述的是基于高斯分布的权重分布策略。

高斯分布即为正态分布,二维正态分布的密度函数为:

其中,σ为正态分布的标准差,(xc,yc)为高斯函数分布的质心。

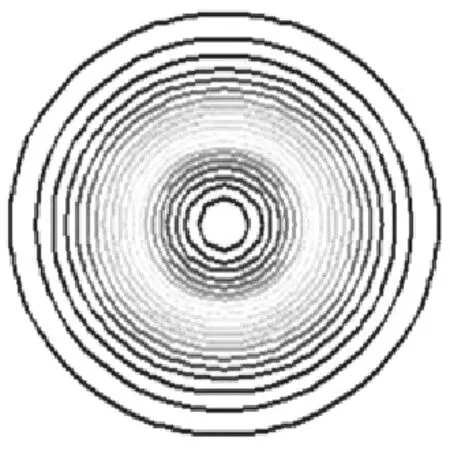

二维正态分布的密度函数是三维高斯曲面,如图6所示,曲面中心处的权值是最大的,沿着中心向两边扩散的方向,权重越来越小。将该曲面投射到二维空间,随着同心圆由内向外的过程,高斯权重越来越小,如图7所示。由于文中检测到的运动目标是矩形框形式,将同心圆的高斯分布等价转化为矩形框的高斯权重分布。同理,矩形框由里到外的权重越来越小,如图8所示。

图6 三维高斯曲面图

图7 二维投影图

图8 权重分布矩形图

该方法的基本思想是由高斯权重分布的矩形框遍历运动对象的团块,越靠近中心位置,像素的权重越大,且权重符合高斯分布。

假设运动对象团块任一像素点(xi,yi)的像素值为PMV,摘要帧背景中对应于该像素点的像素值为PBG,结合高斯权重分布策略进行像素融合的详细步骤如下:

步骤一,对于m*n的运动对象的矩形区域进行区域划分。如果m〉n,则得到n/2个矩形框,反之,则划分为m/2个矩形框。

步骤二,计算运动对象上像素点(xi,yi)的权重值。由式(4)所示的二维正态分布密度函数表达式,可知运动对象上任一像素点为(xi,yi)的高斯权重值为:

步骤三,讨论运动对象上的像素点是前景还是背景。如果运动对象上的某一像素点(xi,yi)在运动目标检测的过程中被当做前景,结合式(3),可直接将融合后的像素值F(m,n)等于PMV;如果运动对象团块上的某一像素点(xi,yi)在运动目标检测的过程中当做背景,将式(5)代入(3)可得融合后的像素值:

图9 融合效果对比示意图

5 实验结果分析

根据视频摘要画面可以容纳对象的多少,视频摘要的生成方式有两种:一是高浓缩比视频摘要,二是无损视频摘要。

在预定浓缩比之后,轨迹丢失导致的信息丢失将不是这种方法要考虑的问题,比较适用于公共场所视频监控用户进行一般的视频摘要浏览。但是对于一些机密场所下摄取的监控视频,是不允许有轨迹丢失的,那么形成的视频摘要应包含所有运动对象的轨迹信息,然后再考虑得到紧凑的短视频。文中采用模拟退火组合优化能量,不像高浓缩比视频摘要生成方式,浓缩比给定以后,生成的摘要视频长度也就确定了。对于无损视频摘要生成方式,为了保证所有运动对象轨迹不丢失,是不能够提前预测出生成的摘要视频长度的。举例说明了生成无损视频摘要的效果演示,如图10所示的交通卡口1摄取的监控视频,原始长度为14253,生成的摘要视频长度为156;如图11所示的交通卡口2摄取的监控视频,原始长度为9638,生成的摘要视频长度为123。

图10 原始视频帧与车流摘要视频帧

图11 原始视频帧与行人摘要视频帧

6 结束语

针对监控视频的快速浏览与大部分活动信息不丢失问题,结合监控视频本身的特点,提出了一种基于对象轨迹的视频摘要生成处理框架,并实现了该技术框架中的关键技术。在保持运动对象轨迹的位置不变的情况,将对象轨迹在时间上进行移动优化。采用改进的模拟退火优化方法实现生成摘要视频的时间压缩和空间平移。采用矩形高斯权重分配策略,实现了摘要视频帧背景和运动对象轨迹的无缝融合。相比传统的视频摘要生成方式中以“关键帧”为基本单位的视频结构,该文提出的以“对象”为基本单位的结构为后续的基于对象的语义内容研究奠定了基础。

参考文献:

[1]Nam J,Tewfik A H.Video abstract of video[C].Multimedia Signal Processing,1999 IEEE 3rd Workshop on.IEEE,1999:117-122.

[2]Narasimha R,Savakis A,Rao R M,et al.A neural network approach to key frame extraction[C].//Electronic Imaging 2004.International Society for Optics and Photonics,2003:439-447.

[3]Zhao L,Li S,Yang S,et al.Key-frame extraction and shot retrieval using nearest feature line[J].NFL.Proceedings of ACM Multimedia Workshop 2000,2000:217-220.

[4]Zhang S H,Li X Y,Hu S M,et al.Online video stream abstraction and stylization[J].Multimedia,IEEE Transactions on,2011,13(6):1286-1294.

[5]Pritch Y,Ratovitch S,Hendel A,et al.Clustered synopsis of surveillance video[C].//Advanced Video and Signal Based Surveillance,2009.AVSS'09.Sixth IEEE International Conference on.IEEE,2009:195-200.

[6]Vural U,Akgul Y S.Eye-gaze based real-time surveillance video synopsis[J].Pattern Recognition Letters,2009,30(12):1151-1159.

[7]Li T,Mei T,Kweon I S,et al.Video M:Multi-video Synopsis[C].//Data Mining Workshops,2008.ICDMW'08.IEEE International Conference on.IEEE,2008:854-861.

[8]吴迪,蔡晓东,华娜,等.基于事件分析的多摄像机鲁棒跟踪算法[J].电视技术,2015,39(13):53-57.Wu D,Cai X D,Hua N.Robust video tracking based on event analysis[J].Video Engineering,accepted.2015,39 (13):53-57.

[9]Steinbrunn M,Moerkotte G,Kemper A.Heuristic and Ran2 domized Optimization for the Join Ordering Problem [J].The VLDB Journal,1997,6(3):8-17.

[10]郭雷,李晖晖,鲍永生.图像融合(第1版)[M].北京:电子工业出版社,2008.Guo L,Li H H,Pao Y S.Image Fusion[M].Beijing:Electronic Industry Press,2008.

Optimization Method for Generating Surveillance Video Synopsis Based on Objects

Wu Di,Cai Xiaodong,Hua Na,Liang Benxiang,Zhu Liwei

(School of Information and Communication Engineering,Guilin University of Electronic Technology,Guilin 541004,China)

Abstract:With the rapid development of surveillance technology and network technology,high-definition network surveillance cameras are widely used in various industries.With 24 hours working per day,these cameras capture millions of video.In the field of surveillance industry,fast and completely browsing the long surveillance video become urgent requirement.Video summary generation technology is an effective means to solve this problem.However,a massive of useful video information has been lost because the traditional video summary generation method,based on the key-frame,cannot fully represent the trajectory of each object.This paper focus on surveillance video data and presents an object-based technology framework of video synopsis generation.Compared with the traditional method of generating summary,it analyzes the core technologies of surveillance video summary generation technology framework,i.e.object detection tracking and trajectory extraction,optimization of combined motion target trajectory and pixel fusion,achieves a quick overview and retains most of the original information of moving objects in video.

Key words:Video Surveillance;Video synopsis;Motion detection;Multi-target tracking;Trajectory combinatorial optimization;Pixel fusion

DOI:10.3969/j.issn.1002-2279.2016.02.012

中图分类号:TP392.4

文献标识码:A

文章编号:1002-2279(2016)01-0041-06

基金项目:❋国家科技支撑计划课题(2014BAK11B02);广西自然科学基金项目(面上项目)2013GXNSFAA019326);桂林电子科技大学研究生科研创新项目(GDYCSZ201410)

作者简介:吴迪(1989-),女,河南商丘人,硕士研究生,主研方向:智能视频处理、云计算。蔡晓东(1971-),男,硕士生导师,主研方向:智能视频处理、云计算、无线传感网络。

收稿日期:2015-05-05