基于动态阈值的帧复制粘贴篡改检测①

2016-02-20卢贺楠黄添强

卢贺楠, 黄添强, 林 晶

1(福建师范大学 数学与计算机科学学院, 福州 350007)2(福建省公共服务大数据挖掘与应用工程技术研究中心, 福州 350007)3(福建师范大学 软件学院, 福州 350007)4(大数据分析与应用福建省高校工程研究中心, 福州 350007)

基于动态阈值的帧复制粘贴篡改检测①

卢贺楠1,2,4, 黄添强2,3,4, 林 晶1,2,4

1(福建师范大学 数学与计算机科学学院, 福州 350007)2(福建省公共服务大数据挖掘与应用工程技术研究中心, 福州 350007)3(福建师范大学 软件学院, 福州 350007)4(大数据分析与应用福建省高校工程研究中心, 福州 350007)

帧复制粘贴是一种常见的时域篡改方式, 篡改者采用这种方式来移除视频中某段内容, 如犯罪现场、犯罪证据等. 针对这种篡改, 已经有不少方案被提出, 但是它们有两个缺点: 一采用固定的阈值; 二时间复杂度很高. 大部分被篡改视频会经过再压缩处理, 由于视频压缩基本是有损压缩, 可能会导致固定阈值失去应有作用.因此, 本文提出一种基于动态阈值的被动取证算法, 来增强算法的鲁棒性, 并且通过引入字典排序算法来缩小帧匹配时的搜索范围, 成功降低了时间复杂度. 文章采用精确度、召回率和平均每帧计算时间来对提出算法的性能进行评估, 结果表明本算法在这三方面都优于其他算法, 而且具有更好的鲁棒性.

帧复制粘贴; 视频取证; 时域篡改; 动态阈值; 结构相识性系数

视频已经广泛应用于新闻报道、安全监控、法庭证据等各个领域, 与图片相比, 视频传递信息更直观、生动. 然而, 近年来视频编辑技术发展迅速, 编辑软件种类多样并且容易使用, 非专业人员也能实现视频篡改, 而且不遗留任何人眼可见的篡改痕迹. 数字媒体作为当今信息传播的主要媒介, 如果视频传递的信息不真实, 有可能导致人们做出错误的决定, 甚至会给社会带来不好的影响. 例如虚假的产品商业宣传就会给购物者带来经济损失. 更危险的是当一段篡改后的视频被用于法庭证据时, 会照成严重的后果. 因此,最近十年, 视频内容完整性取证逐渐成为学者们热门领域之一, 旨在研究探索视频的处理历史[1].

随着研究的深入, 许多视频篡改取证方案被提出. Wang和Farid发现一种删帧指纹[2], 并利用它对采用固定GOP(Group of picture)组的MPEG格式视频进行双重压缩检测; 文献[3]改进了Wang等人的特征, 构建两种删除指纹, 分别用来对采用固定GOP组的视频和动态GOP组的视频进行删帧和插帧篡改检测; Stamm M C等人发现如果视频采用可变的GOP, 则可以利用P帧预测误差序列和其自身平滑处理后做差结果来进行检测[4]; Su等人采用运动补偿边缘效应(motion compensated edge artifact, MCEA)来检测删帧篡改[5]; 而Dong等人探索相邻两个P帧MCEA的差异, 检测视频帧序列经过双重压缩后其傅里叶变换域中是否存在波峰, 进而判断视频是否经过篡改[6]. 林等人提出一种基于纹理谱的时域篡改检测算法, 通过计算纹理谱序列之间的相关系数, 根据给定阈值定位视频篡改位置[7]. 为实现视频局部区域复制粘贴篡改检测, Hsu Chih-Chung等人提出一种基于模式噪声的取证方案[8].

帧复制粘贴篡改是一种时域篡改方式, 针对这种篡改取证的研究已经有不少成果[9-12], Wang等人[9]把帧序列划分成若干个重叠的子序列, 利用存在复制粘贴关系的子序列的空间域和时间域的相似性, 来进行篡改取证, 但是由于帧的数量, 特征提取时计算量很大. Subramanyam等人[10]利用HOG(Histogram of Oriented Gradients)特征进行匹配, 可是高维的HOG数据导致算法很复杂. Lin等人[11]先利用时域相似性来进行粗检测, 找到可疑的帧; 然后利用空间的相似性从可疑帧查找存在复制粘贴关系的帧序列. 文献[9-11]采用的特征比较复杂, 导致算法计算量很大, 而且精确度不够理想. 因此, Li等人[12]提出一种基于结构相似度算法, 以测量的帧间相似度系数为指标来进行篡改检测, 该方法提高了检测精度, 同时降低了时间复杂度. 但Li采用的是固定阈值, 对再压缩操作比较敏感.

本文提出的算法为每一帧设定一个动态阈值, 该阈值随着当前帧和它前后两个相邻帧相似度的变化而变化, 因此算法对再压缩有很好的鲁棒性. 此外算法引入字典排序算法, 缩小帧匹配过程中搜索范围, 有效的降低时间复杂度.

1 结构相似度系数

在传输和解压过程中, 数字图像不可避免的发生不同程度的扭曲、失真现象, 不仅会影响视觉欣赏而且影响图像传递信息的真实性. 为了得到较好质量的图片, 需要对接收的图像进行质量评估, 来优化传输系统. 图像的质量评估工作过于繁重, 由观察员来进行主观评价代价高而且浪费时间. Wang Zhou等人[13]根据人眼视觉特征提出结构相似度系数(structural similarity (SSIM) index)作为图像质量评估的指标. 该指标性与主观评价有很好的一致性, 而且计算简单,已经广泛应用于图像处理等领域.

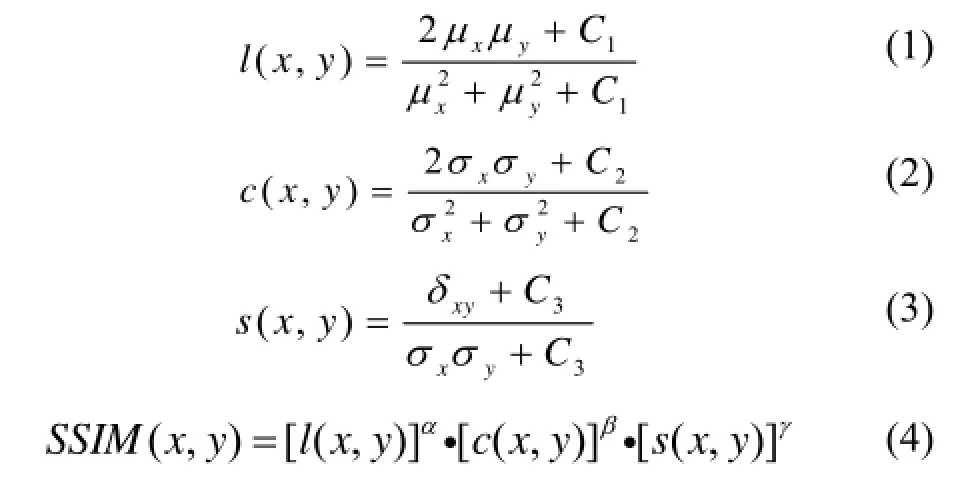

SSIM系数是衡量两幅图像相似度的指标, 其值越大表示图像越相似, 最大值为1. SSIM系数的计算分为三个部分: 亮度比较函数l(x,y)的计算, 如式(1), 对比度比较函数c(x,y)的计算, 如式(2), 以及结构比较函数s(x,y)的计算, 如式(3). 三者合并得到两幅图像全局相似度SSIM系数. 假设x、y分别代表原始图像和接收的图像, 两者的SSIM系数计算如下:

其中,μx、σx分别是x图像的均值和方差,μy、σy分别是y图像的均值和方差,δxy表示两幅图像的协方差.C1、C2、C3是用来防止分母约等于0的情况下产生不可预知的事件的发生, 即使计算结果更稳定.一般情况,是非常小的常数,L为像素最大值.α、β、γ, 是用来调整三个分量相对重要性的参数. 为使计算更简单, Wang Zhou等人设定α=β=γ=1, 得到一个特殊的SSIM系数计算式(5).

在实际应用中, 图片被分割成若干个11╳11像素大小的窗口, 用式(5)计算两幅图像中所有对应窗口的SSIM系数, 取平均得到平均的SSIM系数, 定义如式(6), 其中N是局部窗口总数,i是局部窗口序号.

2 篡改检测算法

一个视频经过帧复制粘贴篡改, 它的帧序列中至少包含一个复制粘贴帧序列片段, 而两个帧序列片段之间如果存在复制粘贴关系, 那么它们的帧之间相似度会很高. 基于这个思想, 所提算法用式(6)计算两帧之间的MSSIM系数, 并以此结果作为判定两帧之间存在复制粘贴关系的主要依据. 算法的第一步是为每一帧设定一个阈值, 与帧匹配过程中计算的MSSIM系数作比较, 进而确定两帧是否存在复制粘贴关系.本文算法与其他算法相比, 主要优势在于设定的阈值是动态的, 对视频再压缩有很强的鲁棒性. 阈值设定后, 通过与计算得到的两帧之间的MSSIM系数, 把帧分为存在复制粘贴关系的和不存在复制粘贴关系的帧对. 算法最后一步是剔除误检的帧对, 同时找到漏检的帧对, 然后把它们按视频中的顺序排列, 并利用视频内容连续性的特点, 给出原始序列和复制粘贴序列.由上述可知, 本文算法可以分成三部分, 其框图如图1所示.

图1 算法框图

2.1 阈值设定

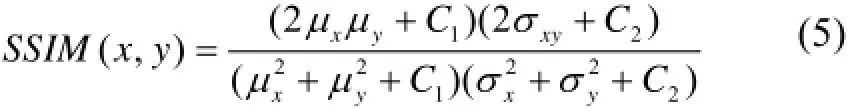

根据视像编码标准[14]可知, 视频中每一帧在编码过程中都会经过DCT(Discrete Cosine Transform, DCT)变换和量化操作, 量化操作使得DCT系数由浮点数转变为整数, 两者之间的差值被称为量化误差[15,16],重构帧图像时又有反DCT变换和反量化操作, 反量化使得反DCT变换系数转变为整数, 同时把不在[0,255]范围内的系数强制转为0或255[16]. 帧图像编码和重构过程中都有数据丢失, 整个过程不可逆, 而且这种现象在全部视像编码过程中都存在, 从而导致两帧间的相似度随着两帧间隔距离的增加而降低. 为了展现这个结论, 我们来做一个实验. 首先, 选取一个原始视频, 视频背景静止并且没有任何运动目标, 测量第90帧和视频中所有帧之间的MSSIM系数, 结果如图2.然后对该视频进行帧复制粘贴篡改, 为方便对比, 我们把83~120的帧序列复制粘贴到196~233的位置, 篡改后的视频帧序列中第90帧和第203帧之间存在复制粘贴关系, 同样测量第90帧和篡改后视频的所有帧之间的MSSIM系数, 结果如图3.

图2 原始视频帧序列第90帧和所有帧之间的MSSIM系数变换趋势

图3 篡改视频帧序列第90帧和所有帧之间的MSSIM系数变换趋势

图2 展示的是MSSIM的值随着两帧之间距离的增加的变换趋势, 我们发现随着间隔距离的增加, 两帧间相似度整体表现为下降的趋势. 虽然有一些轻微的波动, 但总体是下降的趋势, 并且下降速度先快后慢. 由图3可知存在复制粘贴关系的帧之间的相似度很高, 同时从中可以发现第90帧和第203帧之间的MSSIM系数并没有达到1, 这是因为视频篡改后进行了二次压缩, 使得两帧之间的相似度降低了.

此外, 第90帧和第203帧之间的MSSIM系数高于第90帧和它的两个相邻帧(89帧和91帧)的MSSIM系数. 为证明这一现象在视频帧序列中普遍存在, 50段不同视频的帧序列被用来做进一步的实验. 假设帧Pi和帧Pj存在复制粘贴关系, 帧Pi是原始帧V1是帧Pi和帧Pj之间的MSSIM系数,V2是帧Pi和帧Pi+1之间的MSSIM系数,V3是帧Pi和帧Pi-1之间的MSSIM系数. 分别计算每个视频相应的V1、V2、V3,部分结果如表1. 用事件A表示:V1是最大的; 用事件B表示:V1介于V2和V3; 用事件C表示:V1是最小的.

表1 部分实验结果

从表中数据可知: 事件A经常发生, 事件B偶尔发生, 事件C一次也没发生. 因为我们做实验所用视频数目很少, 不能因此而得出事件C不可能发生这一结论, 但可以得出事件C发生的概率很小. 因此可以取V2、V3中较小的一个作为帧Pi的阈值来寻找与它有复制粘贴关系的帧.

在许多篡改取证算法中, 设定阈值是一个关键问题, 也是一个难点. Lin等人[11]和Li等人[12]采用固定参数作为判定阈值. 由上文分析知: 二次压缩操作会降低复制粘贴帧之间的相似度, 继而影响设定的固定阈值的效果, 使得算法的精确度降低. 图4展示一个篡改视频经过不同比率的二次压缩后, 所有相邻帧的MSSIM系数平均值的变化趋势, 二次压缩率为0%、10%、20%、……、90%, 在图中的编号依次为1, 2, 3, ……, 10. 图4表明相邻帧相似度值会随着压缩率的增加而降低. 因此, 采用固定阈值的算法针对二次压缩的鲁棒性较弱.

图4 帧间相似度随着压缩率增加的变化趋势

针对这个问题, 本文给出一种动态阈值设定方法.根据上述实验可知: 可以取当前帧与其前后两个相邻帧之间MSSIM系数中较小的一个为当前帧的判定阈值, 即为每一帧设定一个阈值, 且阈值由该帧本身和它相邻的帧决定. 详细步骤如下.

T1. 第一步, 视频转换为帧序列:F1、F2、……、Fi、……、Fn,n是帧的总数, 然后把每一帧转换为灰度图像, 得到灰度图像序列:P1、P2、……、Pi、……、Pn.

T2. 第二步, 为每一帧设定一个判定阈值. 用Ti表示帧Pi的阈值. 分别计算Pi和Pi+1之间的MSSIM系数,Pi和Pi-1之间的MSSIM系数, 取两者中较小的为Pi的判定阈值.

T3. 最后, 计算所有阈值的平均值E和方差D, 根据式(7)更新每一帧的阈值.

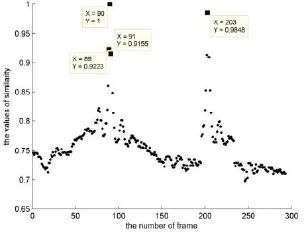

步骤T3中更新阈值操作很关键, 不能省略. 因为对某一段视频进行检测之前, 我们无法预测视频经过什么方式的处理, 也不清楚视频内容以及场景的变换规律, 但是我们要尽可能的把对算法有影响的因素都考虑到. 例如, 视频中的场景快速变换; 一个快速移动目标进入视频; 有复制粘贴篡改操作等. 我们用图5来解释刚给出的三种状况带来的问题. 假设第一种或第二种状况发生在图中的第三帧, 那么从第二帧图片到第三帧图片, 两者的内容发生了明显的变化, 两帧的相似度会急剧下降, 即两帧的MSSIM系数很小. 如果3、4、5帧是从视频中其他位置复制粘贴得到的, 那么第二帧和第三帧的MSSIM系数也很小, 因为这时两者之间的内容也存在明显的差异. 考虑到这些状况可能会发生, 为剔除步骤T2中可能存在的较小阈值,必须用式(7)对阈值进行更新. 因为某帧阈值越小, 则找到的与该帧存在复制粘贴关系的可疑帧会越多(原因将在下一节说明), 从而增加算法计算量, 而且使得后处理更加困难, 降低了算法的效率.

图5 部分视频帧序列

2.2 帧匹配

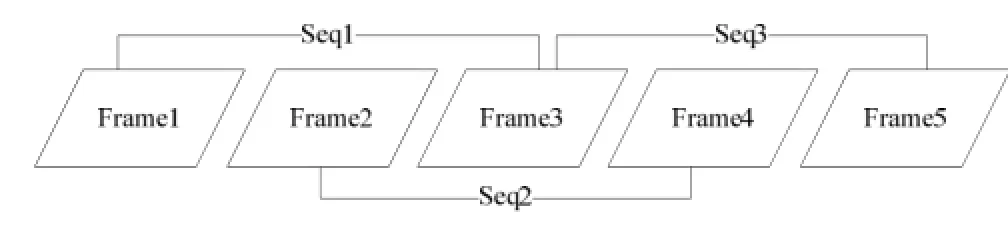

在Lin等人和Li等人提出的方案中, 都先把整个视频帧序列分割成若干个重叠的子序列, 再进行帧间相似度测量. 子序列分割方式如图6所示. 假设帧总数为n, 子序列的长度为m, 则得到的子序列共有(n-m+1)个. 每一个子序列都和其他子序列进行相似度测量, 即使每两个子序列只进行一次计算, 也需要进行(n-m-1)(n-m)/2次, 随着帧数目的增加, 计算量会快速增加.

图6 子序列分割方式

为了降低计算量, 本算法引入字典排序算法. 字典排序能有效的把相似度较高图片排序放在距离较近的地方, 而且简洁迅速. 字典排序对提取的特征较为敏感, 本方案采用图像DCT变换后系数作为特征, 为减少特征向量的维数, 只取DCT系数Zig-Zag排序后的前十个系数作为每一帧的特征向量. 详细步骤如下:

T1. 提取每一帧图像的特征向量. 对灰度图像序列:P1,P2, …,Pi, …,Pn中的每一帧进行DCT变换,得到n个DCT系数矩阵, 每个矩阵中的系数经过Zig-zag排序后取前十个系数作为对应帧的特征向量.定义M=[V1,V2,…,Vi,…,Vn], 其中Vi表示帧Pi的特征向量,n是帧的总数.

T2. 对矩阵M进行字典排序得到矩阵Morder.

T3. 根据字典排序的结果, 来搜索可能存在复制粘贴关系的帧对, 这个过程称为帧匹配. 假设帧Pi在矩阵Morder中的第j行, 那么寻找与帧Pi存在复制粘贴关系的帧时, 只需要检测在[j-10,j)∪(j,j+10]范围内的帧. 计算帧Pi和在[j-10,j)∪(j,j+10]范围内所有帧之间的MSSIM系数, 并与Pi的阈值Ti进行比较. 如果帧Pk在[j-10,j)∪(j,j+10]范围内, 且Pi和Pk两者之间的MSSIM系数Tik大于阈值Ti, 则把帧对(Pi,Pk)放入集合C中.

引入字典排序后, 缩小了帧匹配时搜寻的范围,每一帧在匹配的过程中只需要进行20次相似度测量,n帧需要计算 20n次, 与Lin和Li等人的方案相比, 所提算法有效的减少计算次数, 提高了方案的效率.

2.3 后处理

在2.2节, 匹配结果中可能会发现有一帧对应多帧的情况, 这是问题(一), 导致这种现象的原因有三个, 一是这一帧确实多次复制粘贴, 二是上文中讨论的事件B和事件C至少有一个出现了, 三是特殊情况,这两帧相似度确实很高, 但它们之间不存在复制粘贴关系; 此外, 在2.2节中采用字典排序算法来缩小搜索范围, 虽然提高了方案效率, 但是同时带来一个问题.因为字典排序不能保证把所有相似的帧都排序放在相距很近的位置, 即有可能存在一帧与Pi有复制粘贴关系, 但是经过字典排序后, 这一帧不在[j-10,j)∪(j,j+10], 导致漏检, 这是问题(二).

为了解决问题(一), 我们设计了一个分类器, 分类器由两部分组成, 第一部分是用来消除由事件B和事件C发生造成的误检测, 第二部分是用来排除特殊情况造成的误检测. 第二部分的设计原理是利用了人眼视觉特征, 因为必须连续复制粘贴15帧, 人眼才能感觉到视频内容的变化, 所以可以认为复制粘贴的帧序列长度至少为15, 如果检测到的帧序列长度小于15,则判定是特殊现象带来的误差. 问题(二)是通过检测到的帧, 按帧序号一帧一帧向外扩展解决的, 具体步骤如下.

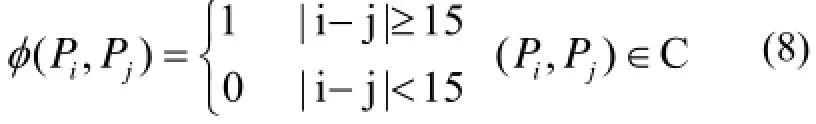

T1. 分类器第一部分定义如式(8), 其中i、j表示帧序号. 集合C中所以帧对都要经分类器处理, 如果φ(Pi,Pj)=0, 则把帧对(Pi,Pj)从集合C中移除.

T2. 集合C中的帧对经过分类器处理后, 从C中任取一帧对(Pp,Pq), 把它放入集合S中, 并从C中移除. 记录下当前这两帧的序号, 令a=p,b=q.

T3. 检测帧对(Pp+1,Pq+1)是否存在与集合C中, 如果存在, 则把它从C中移除, 放入S中, 令p=p+1,q=q+1, 跳转至T3; 如果不存在, 跳转至T4.

T4. 计算帧Pp+1和帧Pq+1两者之间的SSIM系数,如果它们的SSIM系数大于阈值Tp+1(Pp+1的阈值)或者Tq+1(Pq+1的阈值)其中一个, 则令p=p+1,q=q+1, 并跳转至T3; 否则, 把帧对(Pp+1,Pq+1))从集合S中删除, 令p=a,q=b, 然后跳转至T5.

T5. 检测帧对(Pp-1,Pq-1)是否存在于集合C中,如果存在, 则把它从C中移除, 放入S中, 令p=p-1,q=q-1, 跳转至T5; 如果不存在, 跳转至T6.

T6. 计算帧Pp-1和帧Pq-1之间的SSIM系数, 如果它们的SSIM系数大于阈值Tp-1或者Tq-1, 则令p=p-1,q=q-1, 跳转至T5; 否则, 跳转至T7.

T7. 统计集合S中帧对的总数, 记Num, 分类器的第二部分定义如公式(9). 如果U(S)=1, 则认为当前集合S中可以组成两段存在复制粘贴关系的帧序列.假设帧两段帧序列分别为Pi,Pi+1, … ,Pi+m和Pj,Pj+1, …,Pj+m. 根据复制粘贴序列和其粘贴位置连续性较弱的特点来判定原始帧序列和复制粘贴帧序列, 计算公式如(10)~(13). 如果MSSIMi+MSSIMi+m>MSSIMj+MSSIMj+m,则Pi,Pi+1, …,Pi+m是原始序列,Pj,Pj+1, …,Pj+m是复制粘贴帧序列; 否则,Pj,Pj+1, …,Pj+m是原始帧序列,Pi,Pi+1, …,Pi+m是复制粘贴序列. 如果U(S)=0, 则清空集合S, 转至T8.

T8. 重复步骤T2~T7, 直到C为空.

3 实验结果及分析

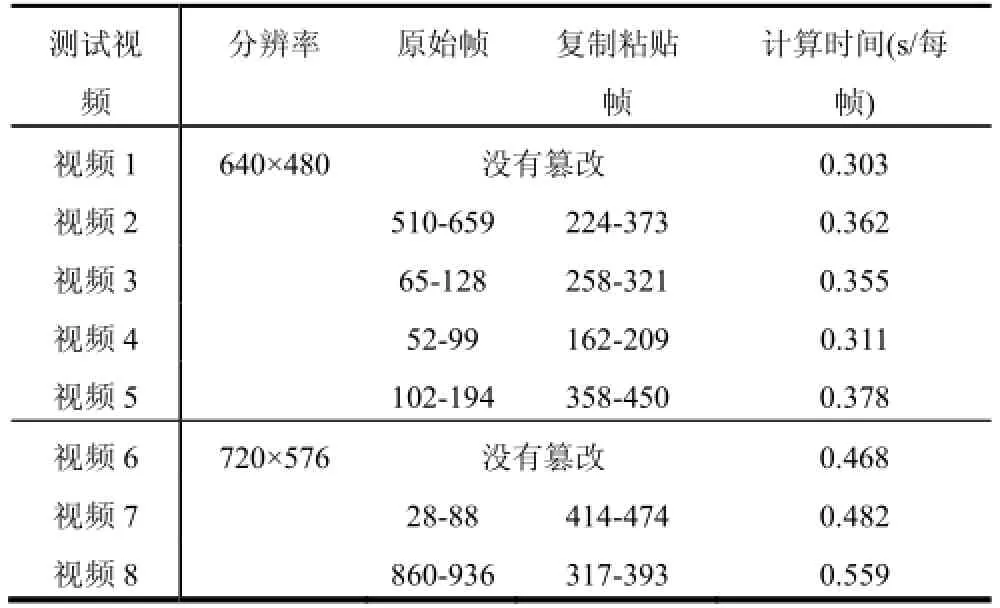

为完成实验, 我们选取15段视频, 其中包括5段分辨率为640×480的视频、5段分辨率为720×576的视频以及5段分辨率为1920×1080的视频. 篡改视频时, 复制的帧序列长度从15~150不等, 使用Adobe Premiere Pro CS5来篡改视频, 使用Free Video compression来对视频进行压缩, 电脑配置了3.20GHz的CPU, 运行软件为Matlab2012a.

3.1 算法评估参数

为评估本方案的性能, 我们统计了算法的精确度(precision)、召回率(recall)和计算时间三种参数. 精确度和召回率是比较传统的评估参数, 已经广泛应用于图片相关检查、分类研究等领域. 精确度越高表明算法的检测越准确; 召回率越高表明算法的误检率很低.精确度和召回率的定义分别如式(14)(15),Nc表示正确检测结果的数目,Nf是错误检测结果的数目,Nm是漏检帧的数目.

此外, 计算时间也被用来作为算法评估的一个重要参数, 本文采用是平均每一帧所花费的时间.

3.2 实验结果

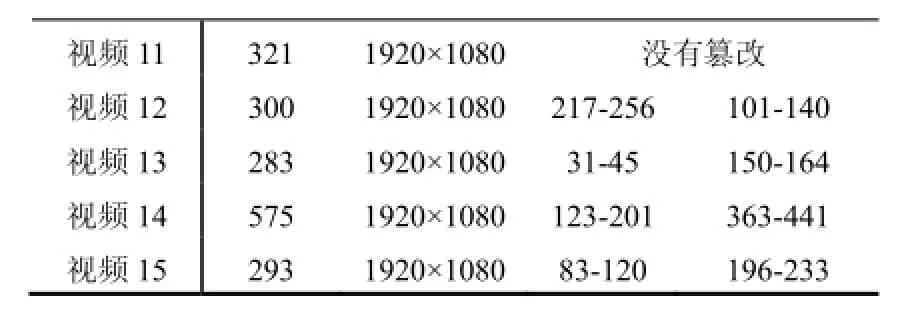

表2给出用于实验的15段视频的详细信息. 表3给出本文算法检测的结果. 为了证明算法对二次压缩有很强的鲁棒性, 我们对篡改视频进行压缩, 压缩率分别为20%、50%以及90%, 然后用所提算法对压缩后的视频依次检测, 结果分别在表4、表5和表6中展示, 从实验结果可以知: 无论篡改视频是否经过压缩,本文算法都能精确定位篡改帧序列.

表3结果显示当篡改者没有对篡改视频进行二次压缩时, 算法检测正确率达到100%, 无一帧漏检. 原因是如果视频篡改后不经过压缩, 那么存在复制粘贴关系的两帧之间的相似度值是1, 而根据给出的阈值自适应设定方法知, 阈值一定小于1, 这样自然就不会出现漏检现象.

表2 测试视频

视频11 321 1920×1080没有篡改视频12 300 1920×1080217-256 101-140视频13 283 1920×108031-45 150-164视频14 575 1920×1080123-201 363-441视频15 293 1920×108083-120 196-233

表3 本文算法对没有经过二次压缩视频检查结果

对比表3和表4发现, 当视频二次压缩率小于20%时, 所提算法几乎不受影响. 而由表5、表6可得,当压缩率达到50%时, 结果偶尔出现漏检现象, 如视频9的帧对(164,342)、视频14的帧对(123,363)未检测到. 当压缩率达到90%时, 漏检现象就很普遍了, 如视频3、5、7、9、10、13、14、15都出现漏检情况, 但是我们发现漏检的都是篡改帧序列的开始1-2帧或者后面1-2帧, 这不影响算法对复制粘贴序列的定位. 此外, 本文算法对未篡改的视频判定完全正确, 而且只有表6中视频5的帧对(195,451)是误检测的, 说明所提算法的误检率很低.

表4 算法对经过二次压缩率为20%的视频检测结果

视频9 164-220 342-398 0.477视频10 662-788 245-371 0.502视频11 1920×1080没有篡改 1.825视频12 217-256 101-140 1.971视频13 31-45 150-164 1.972视频14 123-201 363-441 1.788视频15 83-120196-233 1.984

表5 本文算法对经过二次压缩率为50%的视频检测结果

表6 本文算法对经过二次压缩率为90%的视频检测结果

3.3 算法对比

综上所述, 本文提出的算法动态设定阈值, 增强了算法的鲁棒性, 同时采用字典排序算法, 有效的降低算法的计算量. 为说明算法的有效性, 将从准确度、召回率和计算时间三方面与文献[12]所提算法进行比较, 结果如表7.

表7 准确度、召回率和计算时间比较

由表7可得, 文献[12]给出的算法随着二次压缩率的增加, 算法准确度和召回率都快速降低, 而无论视频是否经过二次压缩, 本文所提算法的准确度和召回率都没有太大的波动, 并且都高于文献[12]的算法. 结果证明本文算法对压缩有很强的鲁棒性.

表7最后一列给出每帧平均所花费的时间, 平均时间计算方法: 首先, 分别计算分辨率为640×480, 720×576, 1920×1080的视频每帧所用时间, 然后三者取平均. 相比文献[12]的方法, 所提算法有效的降低了时间复杂度.

4 结语

本文提出一种新的帧复制粘贴篡改盲取证算法,该算法为每一帧设定一个阈值, 而且阈值是由当前帧本身和它前后相邻帧MSSIM系数决定, 随着MSSIM系数的变化而动态变化. 动态阈值使得算法能很好的应对不同强度的压缩, 增强了算法的鲁棒性. 而且所提算法引入了字典排序, 字典排序简单有效, 通过缩小帧匹配过程中的搜索范围, 减少相似度计算的次数,提高算法效率. 实验结果表明所提算法优于文献[12]中的算法.

相比已经存在的算法, 所提算法时间效率有了较大提升, 但是随着视频分辨率的增加, 平均每帧所用时间也大幅增加, 为应对视频分辨率的增长, 研究并发现一个更简单、更有效的新特征来进行视频篡改检测是我们未来工作的主要目标.

1 Milani S, Fontani M, Bestagini P, et al. An overview on video forensics. APSIPA Trans. on Signal and Information Processing, 2012, 1: e2.

2 Wang W, Farid H. Exposing digital forgeries in video by detecting double quantization. Proc. of the 11th ACM Workshop on Multimedia and Security, ACM MM&SEC. New York. ACM. 2009. 39–48.

3 Stamm MC, Lin W, Liu KJ. Temporal forensics and anti-forensics for motion compensated video. IEEE Trans. on Information Forensics and Security, 2012, 7(4): 1315–1329.

4 Stamm MC, Wu M, Liu KJR. Information forensics: An overview of the first decade. Access, IEEE, 2013,1: 167–200.

5 Su Y, Zhang J, Liu J. Exposing digital video forgery by detecting motion-compensated edge artifact. International Conference on Computational Intelligence and Software Engineering. Wuhan, China. IEEE. 2009.

6 Dong Q, Yang G, Zhu N. A MCEA based passive forensics scheme for detecting frame-based video tampering. Digital Investigation, 2012, 9(2): 151–159.

7 林新棋,林云枚,林志新,等.基于纹理谱的视频帧间篡改检测.计算工程,2015,41(11):314–321.

8 Chih C, Htzu YH, Lin C, et al. Video forgery detection using correlation of noise residue. Multimedia Signal Processing, 2008 IEEE 10th Workshop on. Cairns. IEEE. 2008. 170–174.

9 Wang W, Hany F. Exposing digital forgeries in video bydetecting duplication. Proc. of the 9th Workshop on Multimedia & Security. New York. ACM. 2007. 35–42.

10 Subramanyam AV, Emmanuel S. Video forgery detection using HOG features and compression properties. 14th International Workshop on Multimedia Signal Processing (MMSP). Banff. IEEE. 2012. 89–94.

11 Lin G, Chang J. Detection of frame duplication forgery in videos based on spatial and temporal analysis. International Journal of Pattern Recognition and Artificial Intelligence, 2012, 26(7): 1250017.

12 Li F, Huang T. Video copy-move forgery detection and localization based on structural similarity. Proc. of the 3rd International Conference on Multimedia Technology, ICMT 2013. Springer Berlin Heidelberg. 2014. 63–76.

13 Wang Z, Bovik AC, Sheikh HR, et al. Image quality assessment: From error visibility to structural similarity. IEEE Trans. on Image Processing, 2004, 13(4): 600–612.

14 林福宗.多媒体技术基础.第3版.北京:清华大学出版社,2011.

15 Huang F, Huang J, Shi Y. Detecting double JPEG compression with the same quantization matrix. IEEE Trans. on Information Forensics and Security, 2010, 5(4): 848–856.

16 Yang J, Jin X, Zhu G, et al. An effective method for detecting double JPEG compression with the same quantization matrix. IEEE Trans. on Information Forensics and Security, 2014, 9(11): 1933–1942.

Frame Copy and Paste Tampering Detection Based on Dynamic Threshold

LU He-Nan1,2,4, HUANG Tian-Qiang2,3,4, LIN Jing1,2,412

(School of Mathematics and Computer Science, Fujian Normal University, Fuzhou 350007, China) (Fujian Engineering Research Center of Public Service Big Data Mining and Application, Fuzhou 350007, China)34(School of Software, Fujian Normal University, Fuzhou 350007, China) (Fujian Provincial University Engineering Research Center of Big Data Analysis and Application, Fuzhou 350007, China)

Frame duplication forgery is a very common operation for video tampering in the temporal domain. By removing some frames which contain a crime scene or crime evidence, the forger can change the video content. A lot of solutions have been proposed for detecting this type of tempering operation. However, there are two disadvantages. The first one is fixed threshold; the other is huge computation. In general, frame duplication forgery and re-compression would be performed on a video at the same time. Since re-compression will cause data lost, the fixed thresholds may lose their effects. Therefore, an algorithm based on dynamic threshold is proposed in this paper, which can improve the robustness. Additionally, the proposed method adopts dictionary order algorithm to reduce the search scope of frame matching and the time complexity. Three performance indices: precision, recall and average computation time per frame are employed to evaluate our algorithm. The results demonstrate that the proposed method outperforms the existing methods in terms of precision, recall and computation time.

frame duplication; digital video forensics; temporal forgery; dynamic threshold; structural similarity index

2016-03-14;收到修改稿时间:2016-05-12

10.15888/j.cnki.csa.005499