基于ObjectNess BING 的海面多舰船目标检测

2016-01-21郭少军沈同圣马新星

郭少军, 沈同圣, 徐 健, 马新星

(1.海军航空工程学院控制科学与工程系, 山东 烟台 264001;

2.中国国防科技信息中心, 北京 100142; 3. 91868部队, 海南 三亚 572000)

基于ObjectNess BING 的海面多舰船目标检测

郭少军1,3, 沈同圣2, 徐健1, 马新星1

(1.海军航空工程学院控制科学与工程系, 山东 烟台 264001;

2.中国国防科技信息中心, 北京 100142; 3. 91868部队, 海南 三亚 572000)

摘要:将一幅图像按照一个目标的大小进行缩放,然后计算其梯度特征,再对梯度特征进行标准化,二值化能够极大地提高目标候选区域的选择和检测计算效率,减少耗时。由于对海上舰船目标的检测是具有丰富角点的人造目标,对ObjectNess二值化标准梯度特征(binarized normed gradients, BING)方法中的目标候选区域提取算法进行改进,使其能够更加快速地进行候选区域的选择并保持较高的检测率。分析了海上多舰船目标的图像特征,提出了利用角点确定目标的候选基点,再利用ObjectNess BING检测模型训练获得的多目标尺寸进行候选区域的选择,对互联网上下载的多幅多舰船图像进行处理的结果表明,算法能够有效减少候选目标区域的数量并保持较高的检测概率。

关键词:ObjectNess二值化标准梯度特征; 角点检测; 模板训练; 海面舰船; 目标检测

0引言

海上多舰船目标检测的任务是对感兴趣的舰船进行检测与识别。目标检测的好坏对海战、海上救援、海上反恐、海岛安全防御都具有重大的影响。时间是完成任务的根本,因此减少候选目标区域和提高目标检测运算速度显得尤为重要。

文献[1]针对可见光遥感红外小目标检测问题,根据背景呈纹理状的特性,依据局部熵大处图像灰度比较均匀,局部熵小处图像的灰度离散程度较大的原理,提出了一种基于局部熵的目标检测方法;文献[2]采用小波滤波降低图像噪声,再检测海天线,确定目标潜在区域,最后采用基于行列均值的自适应阈值方法进行阈值分割,并以边界长度、目标大小、长宽比及复杂度作为目标特征进行匹配,实现目标检测。文献[3]探讨了一种基于海天线检测的舰船目标定位方法。该方法运用最大类间方差(OTSU)算法二值化图像,运用模板滤波去除离散干扰点,运用Canny算子检测边缘并扫描图像,运用阈值链接方法保留海天线上的点,去除目标边缘点和干扰点,并以一元线性回归方法拟合出海天线,确定目标潜在区域,最后运用投影法实现目标定位;文献[4]提出了基于分形特征的海上目标检测方法,分形特征能够有效区分人造目标和自然目标;文献[5]采用局部熵方法对图像进行预处理,突出目标边缘,再用Canny算子提取目标边缘,实现对目标的检测;文献[6]针对目标像素小于背景像素10%时,门限分割方法难以分割目标的问题,采用显著性特征引导方法,利用吃水线、高灰度烟囱等特征确定潜在目标区域,缩小背景范围,并通过高灰度烟囱及发动机部位像素与船体像素的比例判断是否先进行直方图像均衡化,再运用OTSU方法分割图像,实现目标的分割。以上的方法大部分需要一个条件:海天线。然而,在背景存在海岛或者其他海天线不容易检测的条件下,以上方法的检测效率将会受到较大影响。所以需要尽可能的提取候选目标区域并尽可能多地包含真实目标。

近些年,为了克服海面目标检测对海天线的依赖,海面目标检测得到了快速地发展,然而主流的方法都是基于特殊分类器进行的图像窗口区域扫描[7-8],扫描数据量庞大。因此,对减少分类器扫描窗口的研究变得越来越热门[9-15],文献[10]向我们展示了“似物性”,即表示一个窗口内存在目标的可能性。文献[16]提出用二值化标准梯度特征(binarized normed gradients, BING)来进行候选窗口的“似物性”预测,表现出了强大的多目标检测能力。

在研项目的主要任务是检测海面舰船,角点检测能够有效地对人造目标进行检测,而舰船目标属于人造目标,通过研究发现利用角点和BING相结合的方法能够有效地减少候选目标窗口从而减少目标估计检测时间。设计一个高效的多舰船目标检测方法需要满足以下几点要求:

(1) 具有较高的检测概率(detection rate, DR);

(2) 预测较少数量的候选窗口从而减少舰船检测的计算时间;

(3) 具备高计算效率使算法能够较容易地移植到不同的应用,尤其是实时应用系统;

(4) 具有检测不可见目标的能力。

到目前为止,能同时满足以上所有条件的方法几乎没有[16]。

基于上述分析本文提出了结合BING和角点的方法进行海面目标检测,该方法首先利用BING和LIB-SVM对目标样本集训练识别模板,再针对不同尺度的样本集计算模板系数与偏差,提高模板匹配精度;测试过程中利用角点检测和样本尺度数据进行候选窗口预测,有效减少候选窗口数量,再利用尺度模板进行候选窗口得分评估,完成目标检测。通过实验分析发现,本文方法能够满足以上条件中的前3点。

1基于BING的模板训练

图1给出的是本文算法流程。可以将基于BING的检测模板训练描述如下:给定一系列具有目标信息描述的数据集,从描述信息中获得目标窗口位置,利用真实目标作为正样本,同时在每幅图像中选取100个非目标窗口作为负样本,引入LIB-linear或LIB-SVM[17]来训练这些样本集,获得目标似物性检测模板。

图1 算法流程图

1.1线性模板

在文献[16]中,利用BING训练获得了目标模板,对于不同尺寸的目标窗口进行匹配得分计算,模板用w∈R64形容。

(1)

式中,sl,gl,l,i和(x,y)分别是滤波得分、标准化梯度特征、位置、尺寸和窗口坐标。用普遍的常识形容:将一幅图像重构成一个目标的大小尺寸,这个尺寸中含有这个目标的区域占整个图像比例将会增多[18-20]。同理,一个具有目标大小的候选尺寸将更有可能包含这个目标。因此,将图像按照目标尺寸重构,计算梯度特征,同时利用非最大值约束方法选择边缘点并以边缘点和目标尺寸大小进行候选目标窗口区域提取将具有更大的概率包含同尺寸目标。定义似物性得分为

(2)

式中,vi,ti∈R分别代表学习获得的尺寸i对于模板w的系数和偏移量。

1.2模板训练

模板训练包含两个阶段,第一阶段的训练是利用所有尺寸的正样本与负样本计算BING特征,再输入到LIB-SVM中进行模板训练,获得第一阶段模板;第二阶段模板训练是建立在第一阶段基础之上的,这个阶段将完成不同尺度模板相对第一阶段模板的系数与偏移量,从而使不同尺度的目标匹配得分更加精确。

1.2.1第一阶段模板训练

获得包含目标区域图像的正样本后选择和正样本具有50%重合的图像都作为目标的正样本,这样生成的模板将具有一定的局部目标检测能力。同时,在每幅图像中随机选择100个窗口作为负样本,这100个窗口不能和任意一个目标区域具有超过50%的重合区域。进一步地引入LIB-linear和LIB-SVM来进行检测模板训练。和BING一样,本文也将模板重构为一个固定的大小(8×8),这将有利于计算高效化。

1.2.2第二阶段模板训练

以上获得的模板不是最终的结果,因为每个尺寸的目标利用这个模板进行似物性计算都存在相应的偏差,因此需要进行进一步的计算,即获得如等式(2)所示的系数和偏移量。首先利用预测获得的候选窗口(见第2节),选择那些和真实目标具有超过50%叠加面积的窗口作为正样本,其他的作为负样本,同时记录样本的尺寸和数量,对不同的尺寸进行提取相对应的正样本和负样本,再一次引入LIB-linear和LIB-SVM对样本进行训练从而获得与第一阶段训练获得模板的系数vi和偏差ti,这样,利用式(1)计算候选窗口的似物性得分就变得简单。

1.3检测模板与梯度特征的二值化

检测模板训练是基于BING进行的,模板与特征的二值化将大大提高目标的检测速率。本文利用海面多目标舰船图像进行模板训练,获得模板的图形化表示如图2所示。从图形来看模板中间目标区域的BING特征值较边缘处的BING特征值亮度要低,具有特征包裹性,即目标存在图像中心的特征[21-25]。沿着模板w边缘的的高权值有效将目标从背景中分离开来,同时,基于BING的训练模板能够更具有稳定性和预见性[16]。

图2 训练模板W

文献[26-28]解释了模板二值化近似的优点,文献[16]提出了BING的快速估计,加速了特征提取和测试过程,因此本文中也使用BING的二值化模板近似估计以加速特征提取与测试。模板的二值化近似过程为:

算法 1二值化近似模板w[25]

输入w,Nw

输出{βj}Nwj=1,{aj}Nwj=1

偏移初始化ε=w

forj=1toNwdo

aj=sign(ε)

βj=〈aj,ε〉/‖aj‖2(映射ε到aj)

ε←ε-βjaj(更新偏移量ε)

endfor

(3)

算法2是用来对梯度特征计算并二值化的,以Ng个二进制位来表述正规化的梯度特征,这样一个64D的梯度特征gl可以由Ng个二值化的梯度特征来近似

(4)

在位的不同位置BING具有不同的权值,利用它能够快速高效地计算获得候选目标窗口。挡计算候选窗口的BING特征的似物性得分时,可以将得分以等式(5)来近似。

(5)

算法 2计算 W×H 的BING特征

输入二值化的正规梯度特征bW×H

输出BING特征矩阵bW×H

初始化bW×H=0,rW×H=0

for每个位置(x,y)do

rx,y=(rx,y≪1)|bx,y

bx,y=(bx,y-1≪8)|rx,y

endfor

2候选窗口预测与检验

2.1候选窗口预测

候选目标窗口的多少是目标检测耗时的一个关键因素,BING利用非最大值约束(non-maximum suppression, NMS)平均为每幅图像预测1 000+的候选窗口,是窗口扫描方式需要候选窗口的1/1 000左右[19,24,26,30]。BING利用二值化正规模板来对目标进行检测,具有强大的检测能力和检测效率,在文献[16]中显示处理VOC2007训练图像集过程中,平均每幅图像的候选目标窗口预测耗时只有0.03 s。

减少多舰船目标检测耗时具有两种方法:一种是建立一个更加高效的检测模板,二值化正规模板已经具有强大的检测能力,因此文章利用此方式训练模板;另一种是减少候选目标窗口的数量但同时保持较高的DR。本文利用了图像的角点和训练模板获得的目标尺寸进行候选窗口的构建与选择,提取的候选窗口数量只有先前BING方法中非最大值约束的一半,但同时保持了较高的检测效率(见第3节)。

2.2非最大值约束的窗口预测

利用非最大值约束进行候选目标窗口预测的方法首先需要将图像重构成训练获得的目标尺寸的大小(候选目标尺寸越多检测范围越广),再对重构后的图像进行梯度特征计算[18,30],然后在对梯度特征图像进行非最大值约束提取候选窗口基点,最后结合基点位置和训练目标尺寸构建候选窗口并进行提取,这种方式为每股图像获得的候选窗口数量在1 500~1 800。

2.3基于角点的窗口预测

利用角点的窗口预测和基于非最大值约束的方法具有一定的相似性,同样首先需要将图像重构成训练获得的目标尺寸大小,不同的是进一步计算的不再是梯度特征而是角点位置的检测,在完成了角点位置的检测后需要进一步利用非最大值约束的方法对角点的分布进行优化。角点检测原理如下。

为了定义图像中的角点,观察一个假设的特征点周围小窗口内的方向性强度平均变化。考虑到偏移向量(μ,ν),则它的平均变化为

(6)

求和过程覆盖了预定义的相邻像素点[33]。强度变化的平均值计算需要在所有可能方向上进行,因为高强度变化可能出现在任何方向。通过这个定义,进行如下测试过程:首先获取平均强度变化最大值对应的方向,在检查位于它垂直方向的变化是否也很强烈,同时满足条件的便是一个角点。

用数学语言来讲,测试这个条件时可以利用泰勒级数展开对式(6)进行近似

(7)

可以用矩阵形式重写式(7)

(8)

这是一个协方差矩阵,表现的是所有方向上强度的变化率。该定义涉及图像的一阶导数,通常利用Sobel算子来进行结果计算。协方差矩阵的两个特征值给出了最大平均强度变化以及垂直方向上的平均强度变化,如果这两个特征比较低,那么对应的特征点位于同质区域,如果其中一个高另一个低,则属于边缘区域,如果两个特征值都较高,那么可以认为特征点处于角点位置。因此,角点成立的条件是协方差的最小特征值超过阈值大小。

为了避免特征值计算带来的时间消耗,利用特征分解理论中的一些特性可以避免对特征值进行求解,这些特征包括:

(1) 矩阵的特征值之积等于它的行列式(Determinant);

(2) 矩阵的特征值之和等于矩阵对角线之和,既矩阵的迹(Trace)。

然后可以通过式(9)判断两个特征值是否都足够高。

score=Det(C)-k.Trace2(C)

(9)

可以很容易的验证,只有两个特征值都足够高的时候,式(9)的结果才会足够高。为了改进检测结果,进一步引入非最大值抑制来进行优化,从而角点不仅是具有较高得分的点,并且必须是邻域内得分最高的点。

尽管NMS能够对角点检测结果进行优化,但是角点通常在纹理丰富的区域集聚密集,在纹理稀疏的地方分布较少,为了改善这种情况,首先计算出得分最大的角点作为基点,再进行角点两两之间的欧氏距离,只有和任意角点距离都大于一定值的角点才保留下来,这样角点数量将会变少,并且分布更加均匀。

2.4窗口检验

预测一幅测试图像获得候选窗口后需要对候选窗口进行检验。首先计算候选窗口的BING特征向量,再将特征向量与候选窗口相对应的模板进行匹配得分计算,如果匹配得分值大于阈值T,则认为这个窗口内有目标,否则认为这个窗口是虚假窗口。得分计算等式为

sl=

(10)

式中,Wc是按照式(2)计算得到的不同尺度的模板;sl、gl、l、i、(x,y)分别是滤波得分、标准化梯度特征、位置、尺寸,窗口坐标。

3实验结果

本文利用Intel(R) Core(TM) i5-3317U CPU @1.7HZ进行处理,采用海面舰船目标图像进行试验,利用DR-#WIN3估计矩阵进行性能评估,并将评估结果和BING方法进行对比。按式(11)计算目标的DR:

(11)

图3给出了两种方法的检测率与候选数量之间的关系曲线图,基于角点的候选窗口预测数量不如BING多,在候选窗口少于900时,其检测效率不如BING,但是当候选窗口达到900时能够达到96.2%的检测率并在5 000时能够达到99.5%,效果和BING不相上下。表1给出了两种方法对不同尺寸的图像集处理的结果。每组采用10幅图像进行处理。

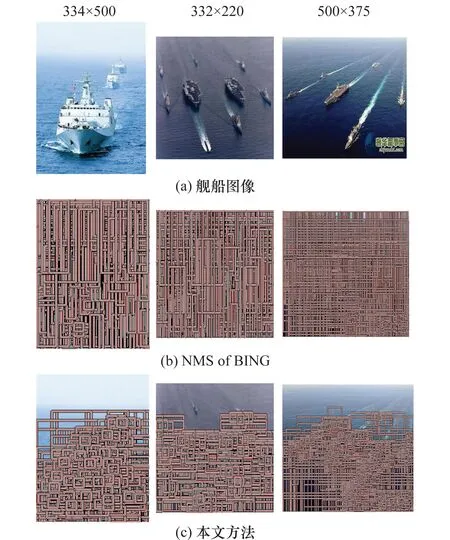

为了更加直观地观察不同尺度下两种方法的候选窗口数量的差异,考虑到篇幅问题,图4只给出了3个不同尺度图像的候选窗口预测结果来进行对比。

图3 检测率曲线

如表1所示,本文方法对整个数据图像集候选窗口的提取与目标的检测耗时为15.4 ms/幅,而BING的处理耗时为37.4 ms/图,对332×220,334×500,500×375 3个尺寸的图像集耗时只需BING的1/4。

表1 候选窗口提取与目标检测耗时表

总体来看本文方法平均耗时量是BING方法的一半不到,这归结于本文方法提取的目标候选区域较少但是覆盖目标区域较完善,减少了不必要的错误检测与判断,从而减少了时间的消耗。本文方法在检测概率上较BING稍微逊色1/1 000,但是在时间速度上能达到BING的两倍以上。

从统计结果来看,本文算法耗时比BING要少,候选窗口提取与目标检测速度大约是BING的两倍。

图5中对检测结果进行了展示。其中有多舰船目标图像的检测,也有针对单个大目标的检测结果。通过检测结果发现,本文算法对多个海面目标检测精确,检测目标在检测框中间位置,对于较大的单个目标图像,由于舰船桅杆及其他明显角点位置的干扰还存在一些误差,如图 5最后一行所示,这也是下一步需要改进的方面。

图4 两种方法提取的候选目标区域

图5 海面真实目标的检测说明

4结束语

本文提出了一种比非最大值约束更有效地候选目标提取算法,利用BING训练模型的出色检测能力,对候选窗口进行目标检测。对多舰船目标的检测结果利用DR-#WIN3进行评估,评估结果表明本文算法在耗时上较BING提升了将近1倍,同时保证了目标的检测率。

本文算法为每幅图像提取相对应的候选窗口的前提是目标具有一定的封闭轮廓。因此,该算法和BING以及窗口扫描式的检测算法[10,15,31-33]一样具有局限性。另外,该算法是为了完成海面多舰船目标检测任务而设计的,它的应用范围没有BING广泛,对于一些不具备角点的目标检测会变得困难,但是在我们的任务中,即对舰船目标的检测中,它在速度方面具有一定的优势,这对时效性要求较高的情况具有积极的意义。

较好的目标检测效果和运算效率使得该算法能够在一定程度上胜任多舰船目标的检测。算法中引入了二值化操作和存储使其可以移植到低能耗的设备上,比如为海岛安全、海面反恐、海上救援等设计的移动设备等。另一方面,对于缺乏角点的目标检测效率并不理想,这促使我们进一步地研究人工目标检测模板的训练方法,考虑各个方面的需求,针对特殊任务特殊需求进行深入研究。

参考文献:

[1] Shi P, Zhuang L S, Ao H H, et al. Ship detection based on human vision perception[J].JournalofAtmosphericandEnvironmentalOptics, 2010,5(5):373-379.(施鹏,庄连生,敖欢欢,等,基于视觉感知机理的舰船目标检测[J].大气与环境光学学报,2010,5(5):373-379.)

[2] Yang M Y, Yang W P. Automatic detection method of IR warship target in the complex sea-sky background[J].InfraedandLaserEngineering,2006,28(10):580-584.(杨明月,杨卫平.复杂海天背景下红外舰船目标实时检测算法[J].红外技术,2006, 28(10): 580-584.)

[3] Huang Y D, Li J, Fan N J. Algorithm for locating naval ship on the sea-sky-line[J].TransactionsofBeijingInstituteofTechnology, 2008,28(4):302-305.(黄英东,李杰,范宁军.海天线上舰船定位算法研究[J].北京理工大学学报,2008,28(4):302-305.)

[4] Zhang D X, He S H, Yang S Q. Ship targets detection method based on multi-scale fractal feature[J].Laser&Infrared,2009,39(3):315-318.(张东晓,何四华,杨绍清.一种多尺度分形的舰船目标检测方法[J].激光与红外,2009, 39(3):315-318.)

[5] Ai S F, Zhang G H, Lv G J. A local entrophy based algorithm for detecting IR target under sea background[J].ElectronicOptics&Control,2008,15(7):75-82.(艾淑芳,张国华,吕高杰.一种基于局部熵的海背景红外目标检测算法[J].电光与控制,2008,15(7):75-82.)

[6] Zhang F, Wang Y H. Fast IR ship segmentation guided by salient features detection[J].InfraredandLaserEngineering,2004,33(6):603-606.(张芳,王岳环.基于显著特征引导的红外舰船目标快速分割方法研究[J].红外与激光工程,2004,33(6):603-606.)

[7] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]∥Proc.ofthethe18thIEEEConferenceonComputerVisionandPatternRecognition, 2005: 886-893.

[8] Felzenszwalb P F, Girshick R B, McAllester D, et al. Object detection with discriminatively trained part-based models[J].IEEETrans.onPatternAnalysis&MachineIntelligence, 2010,32(9):1627-1645.

[9] Alexe B, Deselaers T, Ferrari V, et al. What is an object?[C]∥Proc.ofthe23thIEEEConferenceonComputerVisionandPatternRecognition, 2010: 73-80.

[10] Alexe B, Deselaers T, Ferrari V, et al. Measuring the objectness of image windows[J].IEEETrans.onPatternAnalysis&MachineIntelligence, 2012,34(11): 2189-2202.

[11] Endres I, Hoiem D. Category independent object proposals[C]∥Proc.ofthe11thEuropeanConferenceonComputerVision, 2010:575-588.

[12] Endres I, Hoiem D. Category-independent object proposals with diverse ranking[J].IEEETrans.onSoftwareEngineering, 2014, 36(2):222-234.

[13] Uijlings J R R, Van de Sande K E A, Gevers T, et al. Selective search for object recognition[J].InternationalJournalofComputerVision, 2013,104(2):154-171.

[14] Van de Sande K E A, Uijlings J R R, Gevers T, et al. Segmentation as selective search for object recognition[C]∥Proc.ofthe13thIEEEInternationalConferenceonComputerVision, 2011:1879-1886.

[15] Zhang Z, Warrell J, Torr P H, et al. Proposal generation for object detection using cascaded ranking svms[C]∥Proc.ofthe24thIEEEConferenceonComputerVisionandPatternRecognition, 2011:1497-1504.

[16] Cheng M M, Zhang Z M, Lin W Y, et al. BING: binarized normed gradients for objectness estimation at 300fps[C]∥Proc.ofthe27thIEEEConferenceonComputerVisionandPatternRecognition, 2014: 2386-2393.

[17] Fan R E, Chang K W, Hsieh C J, et al. A library for large linear classification[J].TheJournalofMachineLearningResearch, 2008,9:1871-1874.

[18] Cheng M M, Warrell J, Lin W Y, et al. Efficient salient region detection with soft image abstraction[C]∥Proc.ofthe14thInternationalConferenceonComputerVision,2013: 1529-1536.

[19] Cheng M M, Zhang F L, Mitra N J, et al. RepFinder: finding approximatelyrepeated scene elements for image editing[J].ACMTrans.onGraphics, 2010,29(4):1-8.

[20] Cheng M M, Zhang G X, Mitra N J, et al. Global contrast based salient region detection[C]∥Proc.ofthe24thIEEEConferenceonComputerVisionandPatternRecognition,2011:409-416.

[21] Itti L, Koch C, Niebur E, et al. A model of saliency-based visual attention for rapid scene analysis[J].IEEETrans.onPatternAnalysisandMachineIntelligence, 1998, 20(11): 1254-1259.

[22] Gottlieb J P, Kusunoki M, Goldberg M E, et al. The representation of visual salience in monkey parietal cortex[J].Nature, 1998, 391(6666):481-484.

[23] Koch C, Ullman S. Shifts in selective visual attention: towards the underlying neural circuitry[J].HumanNeurbiology,1985,4:219-227.

[24] Cheng M M, Zheng S, Lin W Y, et al. ImageSpirit: verbal guided image parsing[J].ACMTrans.onGraphics, 2014,34(1):1-11.

[25] Wolfe J M, Horowitz T S. What attributes guide the deployment of visual attention and how do they do it?[J].NatureReviewsNeuroscience, 2004,5(6):495-501.

[26] Chia Y S, Zhuo S, Gupta R K, et al. Semantic colorization with internet images[J].ACMTrans.onGraphics(ACMTOG), 2011,30(6):1-8.

[27] Hare S, Saffari A. Efficient online structured output learning for keypoint-based object tracking[C]∥Proc.ofthe25thIEEEConferenceonComputerVisionandPatternRecognition, 2012:1894-1901.

[28] Zheng S, Sturgess P, Torr P H S, et al. Approximate structured output learning for constrained local models with application to real-time facial feature detection and tracking on low-power devices[C]∥Proc.ofthe10thIEEEConferenceonAutomaticFaceandGestureRecognition, 2013:1-8.

[29] Cheng M M, Mitra N J, Huang X, et al. Salient object detection and segmentation[R].TPAMI-2011-10-0753.Springfield: China Tsinghua University,2011.

[30] Cheng M M, Mitra N J, Huang X, et al. Salientshape: group saliency in image collections[J].TheVisualComputer,2013:1-10.

[31] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]∥Proc.ofthe18thIEEEConferenceonComputerVisionandPatternRecognition,2005,1: 886-893.

[32] Felzenszwalb P F, Girshick R B, McAllester D, et al. Object detection with discriminatively trained partbased models[J].IEEETrans.onPatternAnalysis&MachineIntelligence,2010,32(9): 1627-1645.

[33] Bongioe K, Jihoon C, Yong W P, et al. Robust corner detection based on image structure[J].CircuitsSystemSignalProcess, 2012,31(10): 1443-1457.

郭少军(1985-),男,助理工程师,博士研究生,主要研究方向为图像融合,多目标检测与模式识别。

E-mail:guoba2000@163.com.

沈同圣(1966-),男,教授,博士研究生导师,主要研究方向为图像融合、多目标检测与识别。

E-mail:TS-SY@163.com.

徐健(1983-),男,工程师,博士研究生,主要研究方向为目标识别、图像融合技术。

E-mail:blues_coffee@163.com

马新星(1983-),男,工程师,博士研究生,主要研究方向为多目标检测识别与图像融合。

E-mail:xinxing_2006@tom.com

网络优先出版地址:http://www.cnki.net/kcms/detail/11.2422.TN.20150818.1519.006.html

Detection of multi-ship targets at sea based on ObjectNess BING

GUO Shao-jun1,3, SHEN Tong-sheng2, XU Jian1, MA Xin-xing1

(1.DepartmentofControlEngineering,NavyAeronauticalEngineeringUniversity,Yantai264001,China;

2.ChinaDefenseScienceandTechnologyInformationCenter,Beijing100142,China;

3.Unit91868ofthePLA,Sanya572000,China)

Abstract:It is found that generic objects with well-defined closed boundary can be discriminated by looking at the norm of gradients, with a suitable resizing of their corresponding image windows into a small fixes size,which can save a lot of time. Inspired by the high quality of ObjectNess binarized normed gradients (BING), it is used for the multi-ship target detection on the sea. Considering the characteristics of the ship targets and the artificial objects, a method of predicting the object candidate windows based on corner points and ObjectNess BING is proposed, which can also generates a small set of high quality ship target windows, yielding 96.2% object detection rate (DR) just like the former ObjectNess BING dose for the test of images downloaded from the internet, but with only 900+proposals. It reduces the time cost of ship targets detection and makes the ship detection more efficient than the former ObjectNess BING.

Keywords:ObjectNess binarized normed gradients (BING); detection of corner points; model training; ship target at sea; object detection

作者简介:

中图分类号:TP 391

文献标志码:A

DOI:10.3969/j.issn.1001-506X.2016.01.03

基金项目:国家自然科学基金(61303192)资助课题

收稿日期:2014-12-18;修回日期:2015-05-30;网络优先出版日期:2015-08-18。