基于激光单目视觉系统的焊缝提取

2015-12-26岳建锋杜博宇王天琪李亮玉

岳建锋,杜博宇,王天琪,李亮玉

(天津工业大学天津市现代机电装备技术重点实验室,天津300387)

基于激光单目视觉系统的焊缝提取

岳建锋,杜博宇,王天琪,李亮玉

(天津工业大学天津市现代机电装备技术重点实验室,天津300387)

将激光单目视觉传感器固定在ABB机器人上组成视觉系统,用Matlab标定工具箱实现了对摄像机参数的高精度标定,与机器人示教器结合对机器人进行了手眼标定;利用视觉系统采集焊缝图像,对获得的图像进行图像处理和特征分析,并提取计算机图像平面上焊缝特征点的图像坐标.根据摄像机内外参数、机器人的手眼关系以及焊缝的特点提出一种简便的方法将二维平面坐标转化为三维坐标,用Solidworks还原出焊缝的三维模型,提取焊缝中心线信息进行焊接实验,结果表明焊接精度满足实际要求.

激光视觉;单目视觉;图像处理;视觉标定;焊缝提取

随着工业自动化技术的不断发展,目前机器人在焊接领域得到越来越广泛的应用.在恶劣的工作条件下,机器人可以替代人进行焊接操作,大大降低了劳动成本,提高了劳动生产率.目前的工业机器人虽然装备了一些传感器用来感知周围环境以提高其适应性,但是在工业生产中,工作方式主要还是人工示教再现.操作者需要预先通过示教方式来规划机器人的路径和位姿.对于复杂的焊接工件,示教点较多,需要进行较长时间的示教工作.对于单件或混合产品的批量生产过程,需要进行反复的示教工作,且机器人的运动精度,基本上取决于编程人员在示教时的耐心程度和目测精度,不能满足柔性化焊接需求.因而研究焊缝结构和参数自动识别的焊接自动化技术是十分必要的[1-2].

目前,在焊接自动化方面所采用的传感方法有机械式、电弧式、电磁式、超声波式和视觉式等.其中,视觉式传感具有信息量大、灵敏度和测量精度高、抗电磁场干扰能力强、非接触等优点而广泛使用[3].本文采用条形激光和CCD组成视觉系统,以此系统为基础提取焊缝坡口参数的特征并进行焊接实验.

1 系统构成和原理

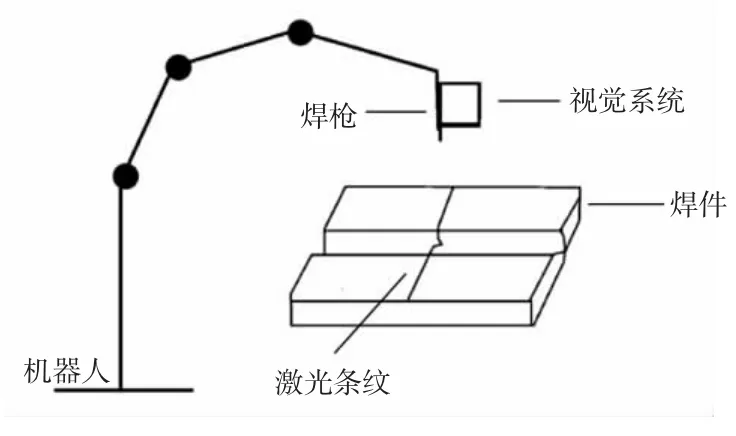

本系统由CCD摄像机、镜头、激光二极管和ABB机器人等组成.其中摄像机和激光二极管以一定角度安装在ABB机器人机器臂上.激光二极管发出条形光投射到焊接工件上,发生相应的变形并产生漫反射. CCD接收从工件上反射的条形光,通过图像处理等环节,可得工件各特征点的相平面坐标.对视觉系统进行标定,可将坡口各特征点的相平面坐标转换得到世界坐标,得到坡口的三维信息.将三维信息转化为焊枪的位置和姿态参数,传输给机器人进行焊接.其中ABB机器人重复定位精度为±0.11 mm.激光视觉传感器结构示意图如图1所示.

图1 系统结构示意图Fig.1 Structural diagrams of system

2 视觉系统标定

2.1 摄像机标定

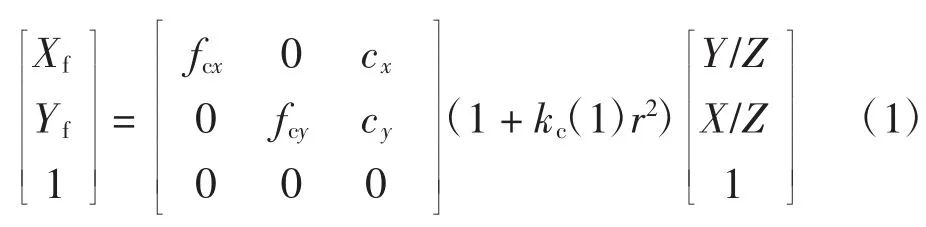

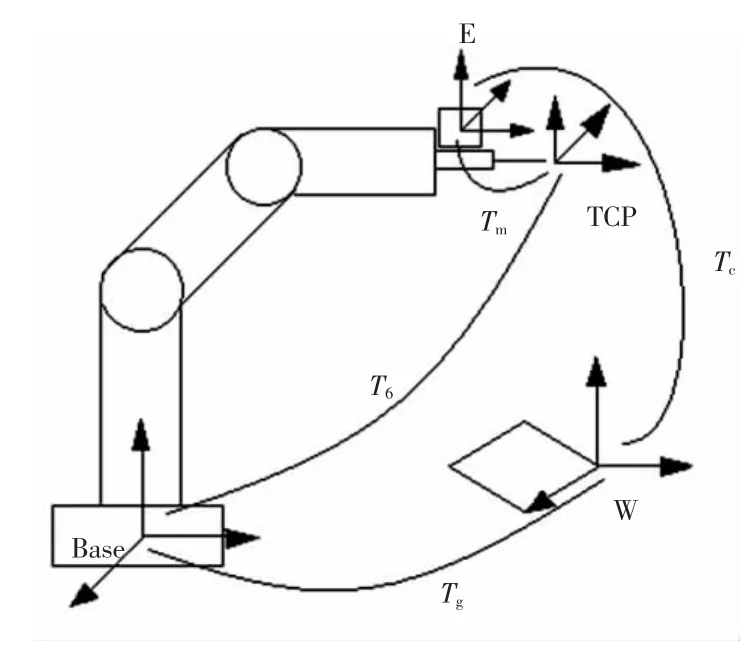

在计算机视觉中,为了从二维图像中得到三维信息,摄像机标定是必不可少的一步[4].摄像机标定是获得相机内部参数和外部参数、建立图像中像素坐标与空间位置之间关系的过程[5].针孔模型中,只考虑摄像机的一阶畸变,内参的模型如式(1):

式中:(Xf,Yf)为景物点在图像平面上的坐标;(fcx,fcy)为摄像机有效焦距;(cx,cy)为摄像机光心在图像平面上坐标;kc(1)为摄像机一阶畸变系数;r为点至成像平面原点距离,r2=(Xu/f)2+(Yu/f)2;(X,Y,Z)为点在摄像机坐标系下的坐标.外参模型如式(2):

式(2)反映了摄像机坐标系下的空间点(X,Y,Z)与世界坐标系下的空间点(Xw,Yw,Zw)之间的关系;R为3×3的旋转矩阵;T为3×1的平移矩阵.

本文采用基于平面模板的改进两步标定法[6],采用10×10的黑白棋盘作为平面标定模板,读入9幅图像,以Matlab软件作为平台计算摄像机的内部参数,标定结果如表1所示.外参数随着摄像机与标定板位置关系不同而改变,9幅标定图片对应9组不同的外参数.

表1 摄像机内部参数Tab.1 Camera′s intrinsic parameter

2.2 机器人手眼关系

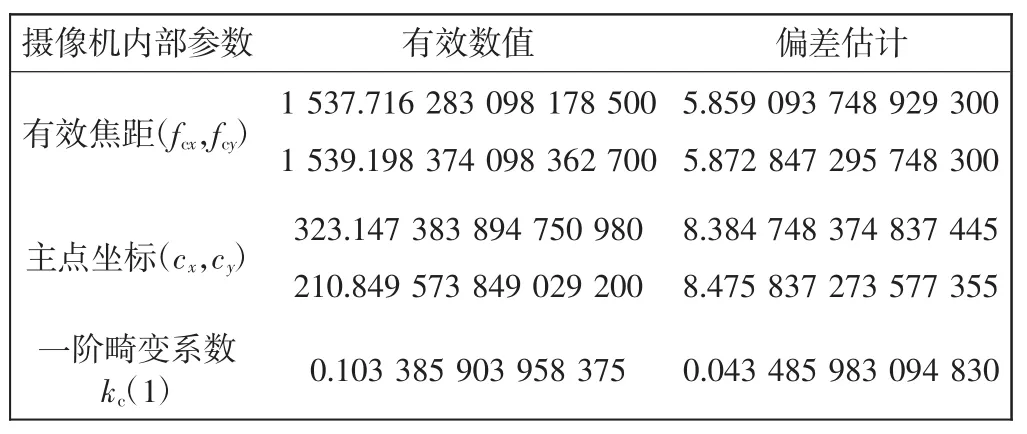

要获得计算机图像平面上的点在世界坐标系中的坐标,必须获得摄像机与机器人坐标系间的关系,称为手眼标定[7].各坐标系间关系如图2所示.

图2 坐标系间关系Fig.2 Relationship between coordinate systems

图2中,Base为机器人基坐标系,TCP为机器人末端坐标系,W为标定板世界坐标系,E为摄像机坐标系.T6为Base和TCP间的变换,Tm为TCP和E间的变换,Tc为E和W间的变换,Tg为Base和W之间变换.T6、Tm、Tc、Tg构成一个封闭解,由坐标系间的关系,可得到式(3):

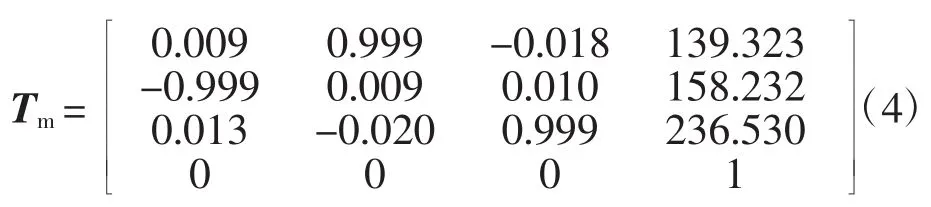

采用ABB机器人,在机器人末端安装焊枪后用五点法对工具坐标系标定,标定完成后,机器人示教盒可以显示出TCP在Base坐标系下位姿,即T6.用三点法对其进行工件坐标系标定,根据三点成面公式可以得到W和Base间的关系,即Tg.标定摄像机的外部参数,得到摄像机坐标系与标靶坐标系间的关系Tc,在摄像机标定实验中共取得外参9组.选取任意一组参数,代入式(3)可求得摄像机相对于机器人末端的参数Tm.经计算,本系统中的手眼关系为[8]:

3 焊缝图像的处理

为了准确获得焊缝特征信息,必须要对CCD采集到的焊缝图像进行处理,去除干扰信息提取激光条纹中心线,进而提取焊缝特征点.以60°V型坡口焊件为例,采集焊缝图像,图像处理的基本流程如图3所示,图像处理结果如图4所示.

图3 图像处理流程Fig.3 Image processing

图4 图像处理结果Fig.4 Result of image processing

滤波是减少图像中噪声的有用工具.中值滤波法是一种非线性平滑技术,它将每一像素点的灰度值设置为该点某领域窗口内的所有像素点灰度值的中值.考虑到滤波效果和运算速度等因素,选用3×3矩形中值滤波器,用快速排序法搜索9个像素的灰度中值来替代当前像素的灰度值.中值滤波效果图如图4(b)所示.经过中值滤波的图像包含不同级别的灰度值,阈值变换可以将一幅灰度图像转换成黑白二值图像.在编程中必须根据图像的统计分布性质来选择合适的阈值.目前有多种阈值选取方案,如微分直方图法、双峰法等.由于CCD采集到的原始图像中激光带的亮度很高,其灰度值接近于255,为了获得更好的二值化图像,可以适当加大设定的阈值,将激光带和背景很好的分离开,保留了激光带的特征.二值化效果如图4(c)所示.

经过一系列处理得到的二值化图像,对其进行特征值提取仍比较困难,需要先对激光带的中心线进行提取.目前主要方法有2种:一种是对目标图像进行边缘检测[9],采用上下轮廓取平均法;另一种是采用中轴变化法直接进行骨架提取[10].采用中轴变化法提取出的激光条纹中心线如图4(d)所示.

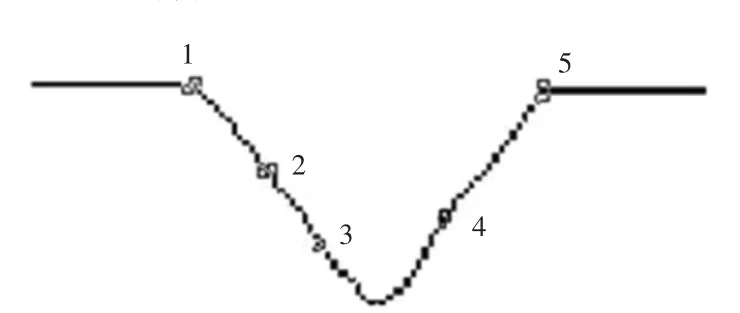

对于焊缝中心线图像,计算特征点方法如下:图像上每一个点都是像素点,设激光条纹中心线点集为p{(xi,yi),i=1,2,...,n},起点为(x0,y0),从起点开始搜索,对于第i列上的点,计算第i+M列上的中心点行坐标与第i列上中心点行坐标的差值,若这个差值大于给定阈值,则认为到达了激光条纹的转折点[11].为了便于观察特征点,对激光条纹中心线进行了反色处理.经实验发现,左右两个拐点检测效果较好,但是一些无关点也被检测出.选取其中一次检测结果如图5所示,检测出点坐标如表2所示.

图5 提取的数据点Fig.5 Data points

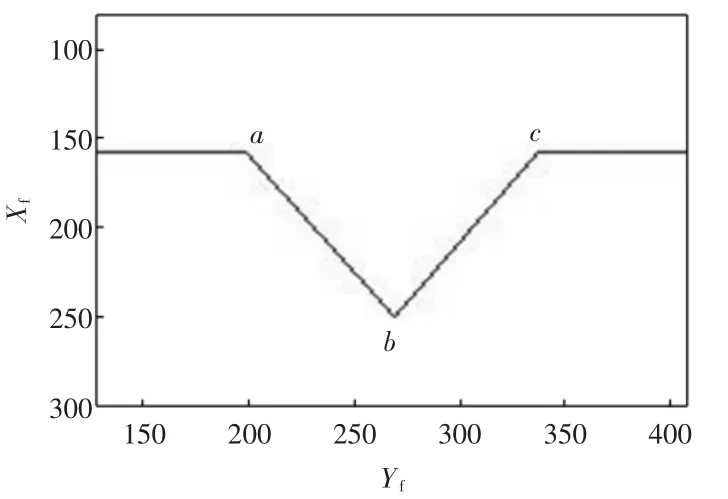

表2 数据点坐标Tab.2 Data points′coordinates

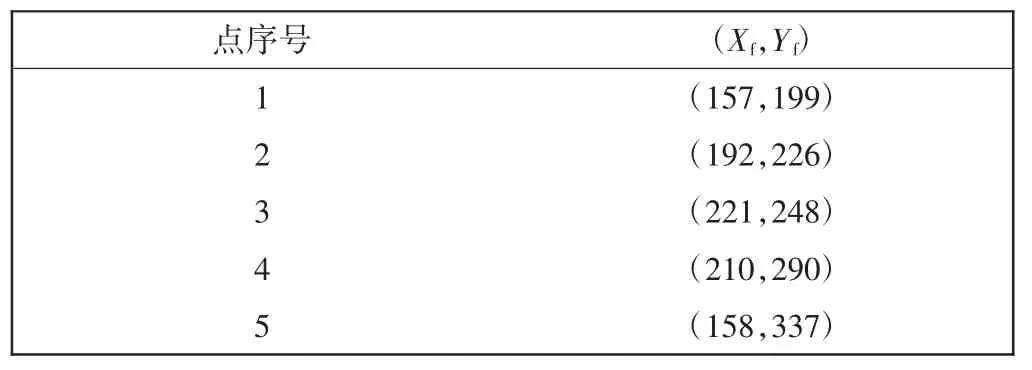

用最小二乘法分别对检测出的数据点做线性拟合,得到两条段直线方程,求出两直线交点即可得到特征b点坐标,如图6所示,a、b、c为3个拐点.

将特征点在计算机图像中的坐标和摄像机内部参数分别代入式(1),可以得到过摄像机光心和特征点的直线在摄像机坐标系下的方程,即:

此外,还需求得激光平面的方程才可解得特征点在摄像机下的坐标(X,Y,Z)[12].由于激光平面方程求解较为复杂,在此提出一种简单的求取特征点坐标的方法.

图6 特征点图像坐标Fig.6 Feature points′image coordinates

在获取图像过程中,操纵机器人使得摄像机Z坐标轴与焊缝垂直且与工件距离不变,通过机器人示教盒读取在TCP坐标系下的坐标,转换为在摄像机坐标系下的坐标Z,代入直线方程(5),可求得特征点在摄像机坐标系下的坐标.至此,图像坐标点与机器人基坐标系空间点映射完成.

4 实验验证

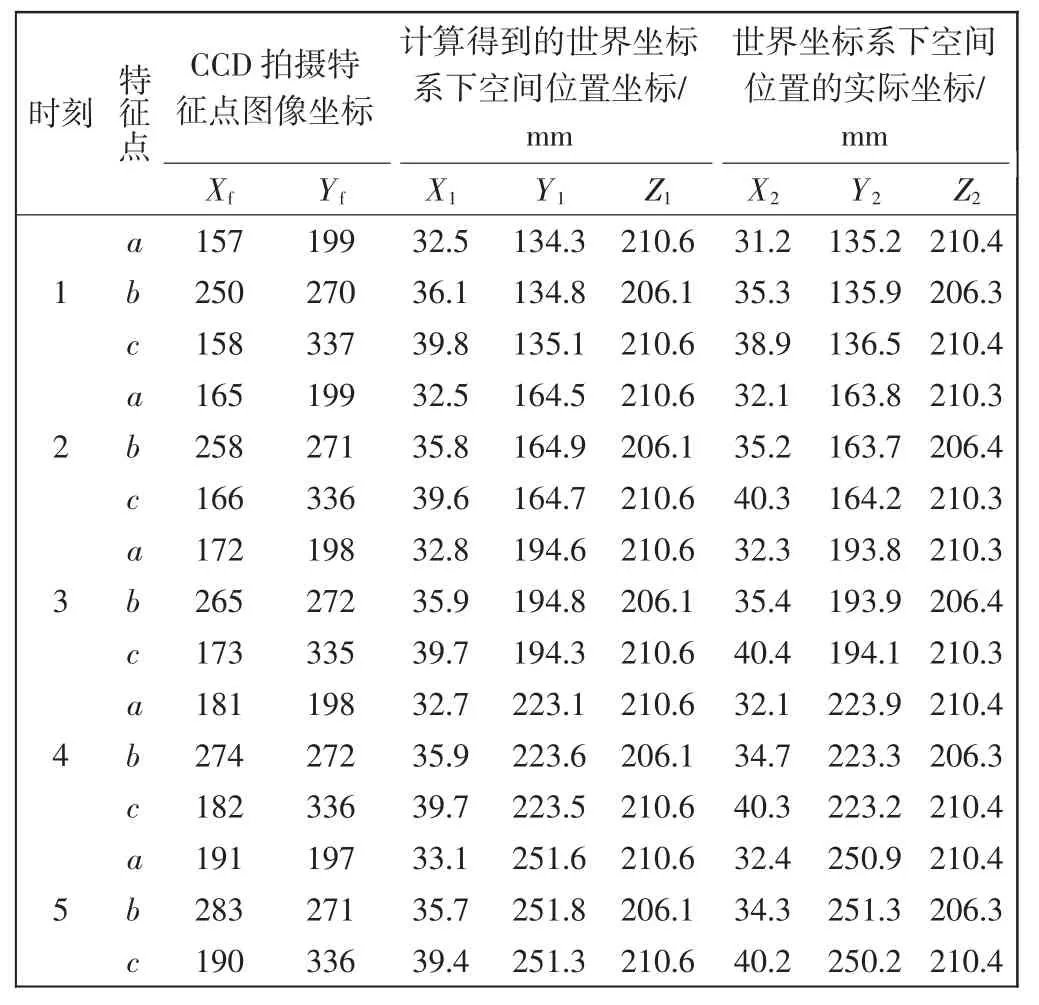

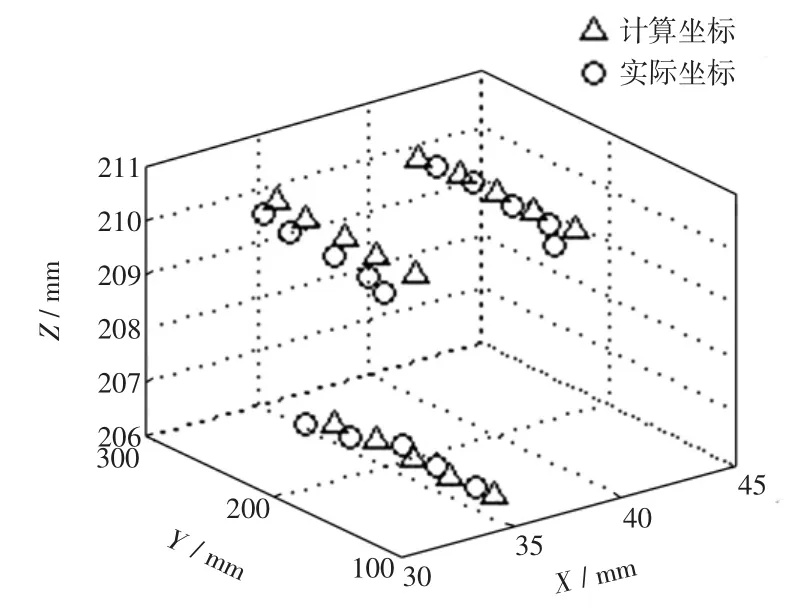

将V型坡口焊件水平固定在工作台上,操纵机器人末端沿着焊缝方向行走,每隔一定时间采集焊缝图像,共采集3次.对每次采集的图像进行处理,得到V型坡口3个特征点的图像坐标,通过上述算法计算得到对应特征点的世界坐标值并通过示教得到特征点的实际坐标,如表3所示.绘制出的特征点实际坐标和计算坐标如图7所示.经计算,特征点实际坐标和计算坐标在各坐标轴上的误差在±1.5 mm内.

表3 特征点坐标的求取结果Tab.3 Feature points′coordinates

图7 特征点的计算坐标和实际坐标Fig.7 Feature points′calculated coordinates and actual coordinates

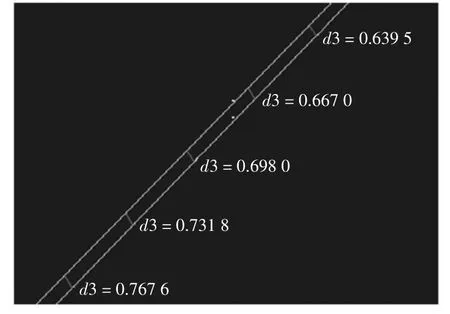

根据坐标点b数据,拟合焊缝中心线信息后进行焊接实验,用三维逆向软件Image ware进行线性拟合并分析误差.计算得到的焊缝与实际焊缝直线偏差在1 mm内,如图8、图9所示,焊接精度满足要求.

图8 两条拟合线段误差Fig.8 Error between two fitting lines

图9 基于焊缝三维数据的焊接实验Fig.9 Welding experiments based on 3D data of welding seam

5 结语

本文基于激光单目视觉系统,对以下几方面的内容进行了研究:

(1)对摄像机进行标定实验,确定摄像机内外参数,提出一种简单方法对机器人进行手眼标定.

(2)提取CCD获取的激光条纹图像的特征点.在消除图像噪声、阈值处理、轮廓提取等方法的基础上,结合焊缝的特征对图像进行处理,获取特征点的图像坐标.

(3)由特征点图像坐标计算获得特征点在世界坐标系下的三维坐标,并用三维绘图软件绘制出焊缝三维图像并进行了焊接实验,满足精度要求.

[1]SUN Yu,CAI Yong-tian.Market analysis galva-nized sheet and current situation of the technology development[J].AISC Techniques,2001(4):12-18.

[2]TIAN J S,LIN Wu.A general algorithm of rotating/tilting positioner inverse kinematics for robotic arc welding off-line programming[J].J of Materials Science Technology,2001,17(1):161-162.

[3]何方殿.用于电弧焊接的跟踪传感(上)[J].电焊机,1990(2):4-9.

[4]何方殿.用于电弧焊接的跟踪传感(下)[J].电焊接,1990(3):3-7.

[5]刘苏宜,王国荣,石永华.激光视觉机器人焊接中摄像机和手眼的同时标定[J].华南理工大学学报:自然科学版,2008,36(2):74-77.

[6]BISHOP Bradley E,SPONG Mark W.Adaptive calibration and control of 2D monocular visual servo systems[J].Control Engineering Practice,1999(7):423-430.

[7]毛剑飞,邹细勇,诸静.改进的平面模板两步法标定摄像机[J].中国图象图形学报,2004,9(7):846-852.

[8]杨广林,孔令富,王洁.一种新的机器人手眼关系标定方法[J].机器人,2006,28(4):400-405.

[9]王卿,岳建锋,杨方兴,等.锻压线机器人的视觉标定[J].天津工业大学学报,2014,33(2):66-69.

[10]LIAO T Warren,LI Damin,LI Yueming.Extraction of welds from radiographic images using fuzzy classifiers[J].Information sciences,2000(126):21-40.

[11]赵相宾,李亮玉,夏长亮,等.激光视觉焊缝跟踪系统图像处理[J].焊接学报,2006,27(12):42-48.

[12]谢春晖.基于结构光的焊缝视觉检测技术研究[D].武汉:华中科技大学,2006.

[13]秦涛.基于结构光视觉传感器的焊缝实时跟踪控制[D].上海:上海交通大学,2012.

Extraction of welding seam based on monocular vision of laser

YUE Jian-feng,DU Bo-yu,WANG Tian-qi,LI Liang-yu

(Tianjin City Key Laboratory of Modern Mechatronics Equipment Technology,Tianjin Polytechnic University,Tianjin 300387,China)

The vision system consists of monocular vision sensor of laser and ABB industrial robot.The camera is calibrated by calibration toolbox of Matlab with high precision.And robot hand-eye calibration is also finished.The welding seam images is captured by vision system,and the captured images are processed and analyzed.Subsequently,the feature points′image coordinate of welding seam are extracted.Then the feature points′world coordinate are also calculated by a simple arithmetic based on camera parameters,relationship of the eye-in-hand and characteristics of welding seam.According to the data,3D model of the welding seam is reconstructed and basing on the data of weld center line,welding experiments is done.The result shows that this method can meet the precision requirement.

laser vision;monocular vision;image processing;visual calibration;weld seam extraction

TQ409;TP391.41

A

1671-024X(2015)06-0084-05

10.3969/j.issn.1671-024x.2015.06.018

2015-09-29

国家自然科学基金资助项目(U1333128);天津市科技计划项目(14ZCDZGX00802);天津市科技特派员项目(15JCTPJC58400)

岳建锋(1973—),男,博士,副教授,硕士生导师,主要研究方向为焊接自动化.E-mail:billyue7303@sina.com