基于“分布式多活”的高校数据中心网络设计研究

2015-11-26江湍

江湍

摘 要:随着高校信息化的发展,校园的日常运营越来越离不开数据中心的支撑。为数据中心提供一个稳定、安全、高效的网络环境成为当前高校网络建设的一个重要课题。 “分布式多活”数据中心的网络是一个实现前端业务多活、后台资源共享和数据互为备份的网络基础平台,能够有效保证高校数据中心的业务连续性和数据安全性。本文以厦门大学为例介绍了基于“分布式多活”高校数据中心网络的研究与设计。

关键词:分布式多活;数据中心;网络设计

中图分类号:TP393 文献标志码:A 文章编号:1673-8454(2015)13-0069-04

一、引言

随着云计算、大数据技术的广泛运用,人们对数据中心和网络的依赖程度越来越高。“分布式多活”数据中心具备零中断的业务连续性、零丢失的数据安全性和灵活的服务扩展性,因而成为当前大中型数据中心建设的热点模式。[1]所谓“分布式多活”数据中心指的是将分布在多个地点的数据中心整合起来,多个中心之间地位均等,在逻辑上将它们视为一个全局的大数据中心,建立基于全局大中心的统一管理平台实现跨多个数据中心的资源调度。正常情况下多个数据中心协同工作,并行地为业务访问提供服务;当某个中心发生故障时,其他中心可以正常运行并对故障中心的业务进行接管。[2]与传统“主/备”或“两地三中心”模式的数据中心相比,“分布式多活”数据中心具有明显的优势:

1.资源利用率大幅提高

传统模式下,备份中心在网络、存储、服务器、系统等软硬件配置上与主数据中心相同,但仅在主数据中心出现故障时产生作用,资源平时无法复用,建设成本高,利用率却很低。“分布式多活”模式下,多个数据中心地位均等,并行地协同工作,每个数据中心的资源都得到了充分利用,避免了资源浪费。

2.灾难恢复能力等级[3]高

传统模式下,数据中心发生故障时,RTO(Recovery Time Objective,恢复时间目标)与RPO(Recovery Point Objective,恢复时点目标)一般为数小时或更长时间,容易造成业务访问的长时间中断和数据的丢失。“分布式多活”模式下,当故障发生时,各个数据中心间的业务接管和切换几乎是实时的,即RTO≈0,多个中心之间的数据实时互为备份,即RPO=0。其灾难恢复能力等级达到最高级别第6级。[4]

3.业务系统的高可用性

传统模式下,主数据中心正常运行时,灾备中心一般只做数据备份,不承担业务应用。主中心故障时,业务应用切换时间长,造成业务访问的中断,严重影响用户体验。“分布式多活”模式下,相同的业务系统可以部署在多个数据中心内并行地提供服务,实现业务访问的前端多活。一般情况下,其服务能力往往双倍甚至数倍于主备模式。[5]充分保证了业务系统的高可用性。

鉴于“分布式多活”数据中心的先进性,厦门大学计划将校园数据中心转型为“分布式多活”模式。首当其冲的任务就是对原有数据中心的网络进行“分布式多活”的设计与改造。

二、案例数据中心情况简介

本文以厦门大学校园数据中心为例。目前厦门大学现有三个B级[6]数据中心机房,其中主数据中心位于思明校区,拥有服务器400多台,运行着包括校园信息化、教务、金融一卡通等40多个业务系统;同城灾备中心位于翔安校区,负责对主中心的业务系统数据进行定期备份;异地灾备中心位于漳州校区,当厦门发生区域性灾难时能将思明校区主中心的核心业务系统切换至漳州校区灾备中心。在数据中心的部署上厦门大学采用了传统的“两地三中心”模式。网络方面三个校区数据中心机房的网络核心交换机均通过专线连接到思明校区主中心机房的某品牌企业级核心交换机上,其中思明、翔安由两条万兆专线连接,漳州由六条千兆专线连接。三个中心之间的交换数据实时转发,交换带宽最高可达720Gb。

近年来随着校园各项业务数字化的不断深入,学校的日常运营和广大师生的工作生活都已离不开数据中心和网络的服务与支撑。尽管校方不断加大对数据中心的建设投入,可由于数据中心采用的传统部署模式,其灾难恢复能力等级只能达到第4级,即RTO与RPO需要数小时至一天,这已不能满足当前和未来学校对数据中心业务连续性的需求;[3]而且随着建设资金的持续投入,两个灾备中心的资源利用率却始终很低,无法达到预期的投资回报。为了解决上述问题,厦门大学将建设“分布式多活”校园数据中心列入工作计划。这是一项复杂的系统工程,需要对原有数据中心的网络、数据、系统、应用等各个方面进行设计和改造。本文中笔者对“分布式多活”数据中心的网络平台的设计与建设进行了分析与阐述。

三、“分布式多活”网络的建设要素

“分布式多活”的网络环境是一个能够满足数据中心有效扩展、分支部门灵活接入和业务系统快速部署的弹性高可用网络。建设中应考虑以下四个要素:①核心网,核心网是“分布式多活”数据中心的基础支撑网络,是多中心资源调度和互访的高速通道,负责实现各个业务部门与数据中心的互联。②数据中心架构,数据中心架构分为数据中心内部网络和数据中心间互联两个部分。前者描述单一中心内部网络架构,后者描述各中心之间网络如何互联以实现多中心间资源的最优调度。③业务接入选择,业务接入选择应考虑业务接入的高可用性、接入最优路径选择和业务流量的合理分配。④终端接入方式,终端接入方式主要解决两方面问题。一是保证业务部门的终端用户能够快速便捷安全地接入核心网络;二是保证业务部门内部终端能够灵活扩展。

1.核心网设计

“分布式多活”数据中心的核心网是多个数据中心与业务部门的互联网络,是各项业务的主要承载网络。从拓扑上主要分为星型网络和环状网络两种。

星型网络多应用于“两地三中心”灾备模式,即厦门大学现有灾备模式。主要特点是以主数据中心和同城、异地灾备中心为主要节点,分支部门作为边缘节点与主要节点之间采取双线进行全冗余星型连接。该类网络的主要特点是网络全冗余,可实现单点故障情况下的业务自动切换,可靠性较高。

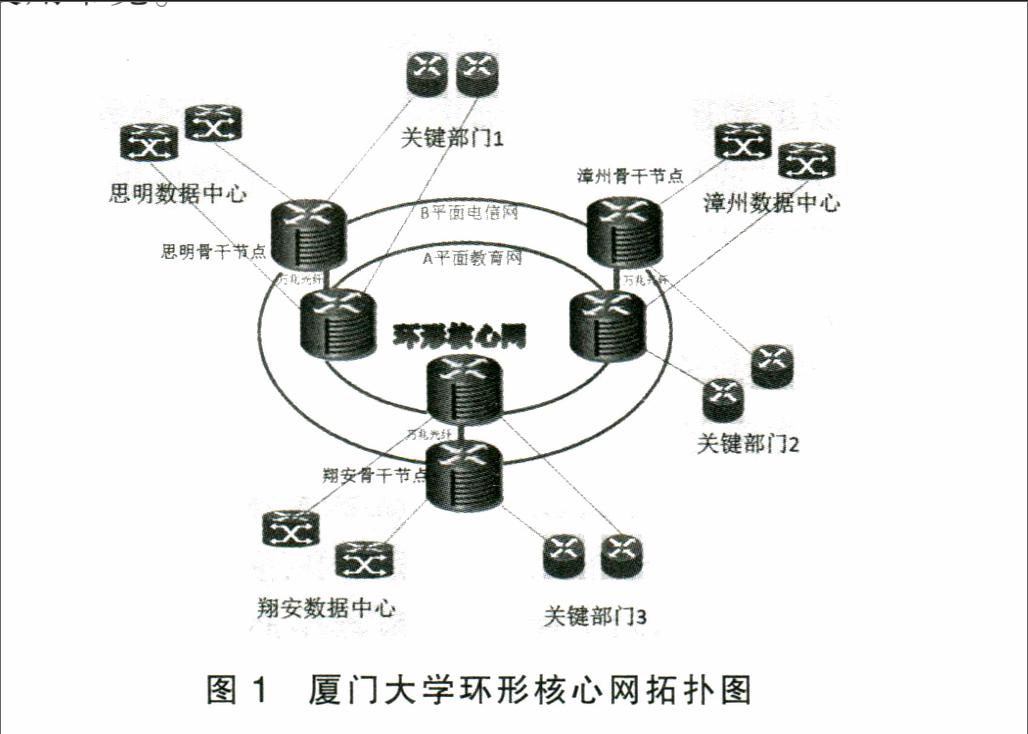

“分布式多活”模式下的核心网一般采用环形网络设计,细分为“单网/单平面”、“双网/双平面”、“单网/多平面”、“一网双平面”四种类型。在本文案例中,考虑到数据中心现有的设备和网络状况,笔者采用了“一网双平面”的设计。主要思路是要将原有广域骨干网络从传统的数据中心功能区提取出来,挑选若干个节点为骨干节点,在各骨干节点中部署两台骨干路由器,分属A、B两个平面,同时将骨干节点内的两台路由器之间利用万兆或千兆光纤互连。通过SDH(Synchronous Digital Hierarchy,同步数字体系)或MSTP(Multi-Service Transfer Platform 多业务传送平台)等主流专线将同平面的骨干路由器环形连接起来。使广域骨干网络形成了两个相对独立的转发平面A和接入平面B,同时平面间互为备份的高带宽、高速度核心环网。[7]主要优点在于高扩展性、高安全性和高业务可控性。[8]

案例核心网络设计如图1所示,笔者选取思明、翔安、漳州三个数据中心作为骨干节点构建“一网双平面”的核心环网。将机房原有的核心路由器和同型号冗余路由器作为核心网的骨干路由器,部署到不同的平面A、B,两个路由器间由万兆光纤相连。利用教育网专线和电信专线将同平面的骨干路由器互连,形成“一网双平面”的核心环网。采用不同的动态路由策略将转发和接入的业务数据分流到相应的承载平面。将全校的各关键业务部门设为一级分节点,均通过两台接入路由器以双链路方式接入核心环网的两个不同平面,并在所有线路上配置QoS(Quality of Service,服务质量)策略保障关键业务的使用带宽。

2.数据中心网络架构

数据中心网络架构设计包括单个数据中心的内部架构、数据中心之间的互联。

(1)“分布式多活”单个数据中心内部架构

传统的数据中心一般采用“二层+三层”的接入汇聚分层组网模式,即根据业务种类将服务器接入到不同的二层VLAN,通过生成树技术来防止环路。[9]在将不同区域业务流量汇聚到高性能的汇聚交换机后,通过核心层的三层路由转发到其他中心。该模式一般应用于主/备数据中心。

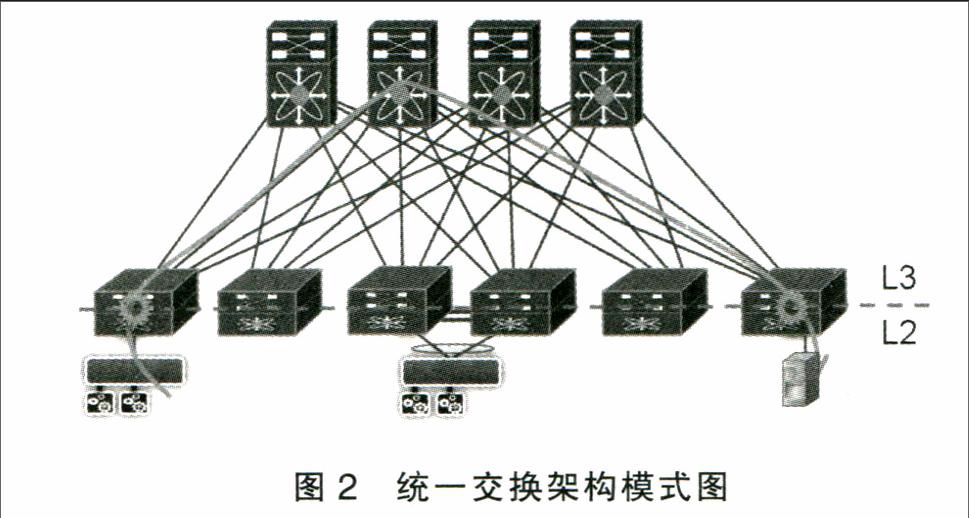

“分布式多活”模式下单个数据中心内部的服务器之间需要进行大量的协同工作,这就要求数据中心内部网络有着更高的吞吐量和更灵活的业务部署能力。一般采用统一交换架构实现数据中心的内部组网,使用虚拟化和分布式网关技术从根源上消除了二层环路和广播风波,在保障业务高可靠性的同时大幅度提高了线路利用率。具体如图2所示。

(2)“分布式多活”数据中心之间的互联

传统的数据中心之间一般采用三层方式通过IP进行互联。在“分布式多活”模式下,为了实现后台资源共享的目标,可以利用OTV(Overlay Transport Virtualization)技术在数据中心之间已经三层互联的基础上快速实现二层互通。[10] OTV是一种基于MAC的路由,其工作原理为: 2个数据中心之间的边界设备建立OTV邻居,邻居之间共享自己的MAC地址表,最终建立各自的MAC路由表;建立数据中心A的MAC1和数据中心B的MAC3通信,MAC1首先查找自己本地边界设备的MAC路由表,根据路由表发现下一跳指向对端边界设备;在本端边界设备的OTV接口将MAC1到MAC3的帧进行封装,发送到对端数据中心的边界设备,在对端数据中心边界设备的OTV接口进行解装;对端边界设备查找本地的MAC地址表,将解封装后的帧发往对应的接口,因此建立了MAC1到MAC3的通信。[9]

OTV技术将两个三层互联的数据中心的2个分散二层域(VLAN)叠加起来形成一个完整的、大的二层网络,从而实现跨数据中心之间的互联。

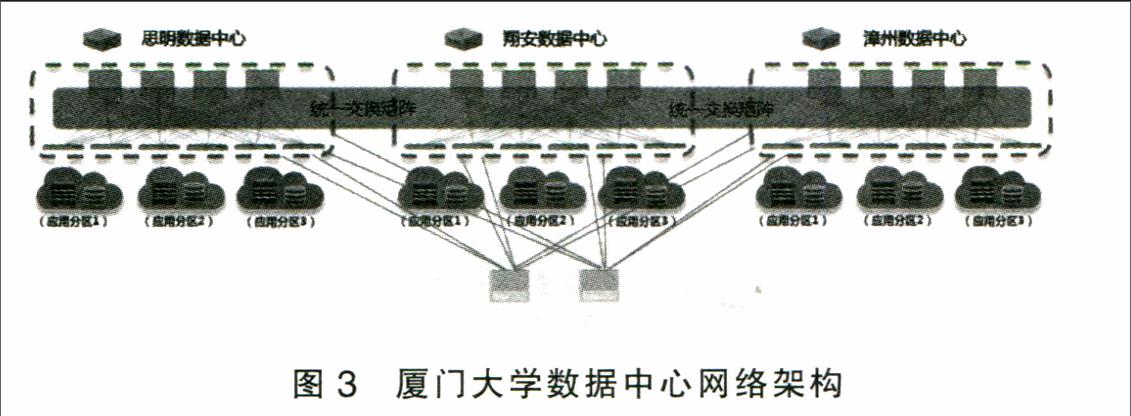

(3)案例数据中心网络架构

在厦门大学数据中心网络架构方案中,笔者采用统一交换架构实现三个校区数据中的内部组网,利用OTV技术在原先已三层互联的数据中心之间实现大二层互通,为数据中心内部和穿越数据中心的数据流提供了最优转发路径。具体如图3所示。

3.业务接入选择

业务接入选择方案中需要考虑利用多路径来保证业务访问的高可用性;通过选择合适的流量调度模式实现业务访问的最优路径并实现流量的合理分配。

(1)业务的多路径接入

在“分布式多活”数据中心的网络中同一类型业务系统可以根据需要部署在不同数据中心的不同网段内,服务器可以配置不同的网关地址并独立设置自身的网络策略。通过全局负载均衡、路由注入等技术保证部署在不同骨干节点上的某一类业务系统在全网的唯一访问IP,所有系统均可独立响应用户请求。由此实现业务的多路径接入,保证了业务系统的高可用性。

(2)业务流量调度模式

业务流量调度模式用于解决业务接入时的最优路径选择和全局流量合理分配的问题。目的是让用户能够更加快捷地获得服务并充分利用线路带宽,保持各数据中心的负载均衡。常用的流量调度方式有纯IP和DNS解析两种。

纯IP流量调度模式,就是在两个异地的数据中心内部各部署一组相同的业务系统,利用流量管理设备检查本地业务系统的健康情况,系统可用时对外发布业务路由,通过调整路由条目在自治域中的优先级,控制分支节点访问不同核心节点上的业务系统来完成流量的灵活调度,系统故障时对应数据中心的业务路由消失,流量通过次优路径自动牵引至其他数据中心,某一业务繁忙时也可通过调整相关参数访问资源较多的中心。

DNS流量调度模式是基于智能DNS解析的GSLB(Global Server Load Balance,全局负载均衡)技术来实现域名类型业务的前端双活,同时提供DNS解析请求的负载均衡、服务器状态监控、用户访问路径优化的功能。[11]当业务需要接入时,由全局负载均衡设备负责处理域名解析请求,它通过预先定义好的策略将最接近用户的节点地址提供给用户,使其可以得到快速的服务;同时全局负载均衡设备与分布在各数据中心的所有GSLB节点保持通讯,搜集各节点的健康状态,以保证用户的请求不会被分配到不可用的节点上。

(3)案例业务接入选择方案

在厦门大学的业务接入选择方案中,由于校内的大部分关键业务系统是基于域名访问,因此笔者将这些关键业务系统同时部署在三个校区数据中心的两台不同的服务器上,将同一中心内的两台服务器部署于教育网和电信网两个不同的运营网络,从而实现业务访问的多路径接入。采用DNS流量调度模式将来自不同运营网络的业务访问通过智能DNS解析后接入到相应网络的服务器上,实现业务访问的最优路径选择和流量的合理分配。具体如图4所示。

4.终端接入方式

网络终端作为数据中心服务的末梢,其接入方式的研究目的是为了保证各业务部门能够快速安全地接入“分布式多活”的核心网,同时兼顾业务部门内网络终端的灵活扩展。

“分布式多活”数据中心中业务部门内部一般采用星型的组网模式,网络终端以有线方式连入业务部门的网络交换中心,再向上接入核心环网。星型组网模式的终端扩展性较好,终端的增加和移除不会对整个架构造成影响。

在厦门大学的终端接入方式设计当中,笔者将学校各关键业务部门设为一级分节点,向上就近接入核心环网,向下连接至部门内部的网络终端。一级分节点内采用星型组网模式以保证网络终端良好的扩展性。将各关键业务部门的网络交换中心设为一级分节点的核心区域,各个终端作为边缘区域;核心区域负责数据交换,只提供高速转发功能,安全控制在边缘区域中实现。在各个终端预设好路由策略对业务数据进行分流并配置QoS策略以保证业务的可用性。具体如图5所示。

参考文献:

[1]肖良华.云数据中心双活技术浅析[J].金融电子化,2012(2):59-61.

[2]柏海涛.从“两地三中心”到“分布式多活”——企业多数据中心架构演进[J].ip领航,2013(28):2-3.

[3]中华人民共和国国家质量监督检验检疫总局,中国国家标准化管理委员会.信息安全技术信息系统灾难恢复规范[S].GB/T20988-2007.

[4]马继波.数据中心向“双活”云数据中心转型浅析[J].山东社会科学,2013(S1):244-245.

[5]孟繁锦.构建金融分布式多活数据中心[J].中国金融电脑,2014(8):87.

[6]中华人民共和国电子工业部.电子计算机机房设计规范[S].GB50174-92,1993.

[7]韩海波.“一网双平面”——一种新的广域骨干网络架构[J].计算机系统应用,2013(8):23-28.

[8]毕锦雄.一网双平面——承载新型政务云平台的网络架构设计[J].信息系统工程,2014(10):31-34.

[9]卢小强.双活数据中心的网络架构[J].金融科技时代,2013(7):63-65.

[10]Xiaojie Zhang,Azeem Suleman.Layer 2 Everywhere: Overcoming Overlay Transport Virtualization (OTV) Site Limitations Within and Between Data Centers[R]. cisco white paper, 2012,3[29].

[11]云计算第一门户.GSLB[EB/OL].http://www.zdnet.com.cn/wiki-GSLB.

(编辑:王天鹏)