低视角单目摄像机下3D空间的运动轨迹提取

2015-10-15赵倩倩宋焕生徐晓娟彭玲玲

赵倩倩,宋焕生,2,徐晓娟,彭玲玲

(1.长安大学 信息与工程学院,陕西 西安 710064;2.陕西省道路交通智能检测与装备工程技术研究中心,陕西 西安 710064)

低视角单目摄像机下3D空间的运动轨迹提取

赵倩倩1,宋焕生1,2,徐晓娟1,彭玲玲1

(1.长安大学 信息与工程学院,陕西 西安 710064;2.陕西省道路交通智能检测与装备工程技术研究中心,陕西 西安 710064)

由于摄像机安装高度和角度的限制,采集到的视频图像有时存在车辆之间的遮挡和尺度变化等问题。提出一种低视角单目摄像机下3D空间的运动轨迹提取方法,利用垂足信息求得特征点的三维信息,再由高度区分稳定特征点和不稳定特征点。对稳定特征点进行跟踪,根据三维信息形成空间轨迹。实验结果表明,该方法可以较好地解决车辆之间存在遮挡和尺度变化等情况下的轨迹分析问题。

遮挡;特征点跟踪;车辆跟踪;3D轨迹提取

基于视频的交通行为分析和安全预警由于安装和维护方便,以及高效的检测性能成为当前研究的热点。其中,车辆的运动轨迹是交通行为分析和理解的基础[1]。因此,如何获得真实反映目标运动情况的轨迹是交通领域的研究重点。

在以往的研究中,获取运动目标轨迹的方法有多种,主要有减背景法[2]、基于车辆3D模型的跟踪方法[3]、基于轮廓的跟踪方法[4]以及基于特征点的跟踪方法[5]。当摄像机的安装高度距离地面较高时(一般在15~100m之间),车辆之间的遮挡和图像尺度变化较小,车辆的高度信息可以忽略,用以上的这些跟踪方法一般可以取得较好的跟踪效果,跟踪出的运动轨迹可以较真实地反映车辆的运动状态。但是在实际应用中,由于工程上的限制,摄像机一般安装在离地面较低的位置(一般在6~9 m之间),且通常在道路的两侧,此时,车辆高度造成的车辆之间的遮挡和尺度变化显得尤为严重,在图像平面对运动车辆进行跟踪得到的运动轨迹不能真实地反映车辆的运动状态。鉴于此,在近几年的研究中,空间轨迹由于可以较真实地反映车辆的运动状态,应用于低视角摄像机情况下的交通行为分析中。Beymer[6]等假设车辆的高度为0,将图像上对特征点跟踪形成的轨迹投影到路平面上,由于摄像机距离地面较高,因此图像到路平面之间单一的映射关系就可以很好地解决拥堵、光线变化及阴影等复杂环境下车辆的跟踪问题,然而当摄像机距离地面较低时,仅靠这样单一的映射关系是不够的。为此,本文提出一种低视角单目摄像机下3D空间的运动轨迹提取方法,即首先建立图像坐标系与世界坐标系之间的转换关系,通过减背景法得到运动目标的二值化图像,然后在二值化图像中对提取到的特征点向下作垂直投影,根据投影点的世界坐标值求得特征点的世界坐标值,再由高度信息进行特征点的筛选。在图像平面上对稳定特征点进行跟踪,求得每一个跟踪点对应的三维信息,并对跟踪点的高度进行中值滤波。最后根据滤波后的高度信息对跟踪点的三维信息进行修正形成空间轨迹。

1 稳定特征点的选取

由摄像机的成像模型可知,通过世界坐标系中的点Q可求得其在图像坐标系中对应的点q的坐标,点Q与q之间的转换关系可通过变换矩阵C得到,即

(1)

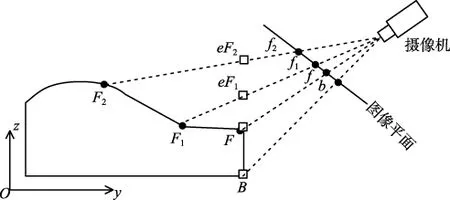

图1 现实空间点与在图像上的投影点之间的关系

本文采用改进的Moravec特征点提取算法,利用灰度方差提取特征点,并在图像平面上通过跟踪模板设计和模板匹配、更新等操作进行特征点的跟踪[8]。

如图2所示,图2a为采集到的原始视频图像,点F与点B在同一条垂线上,图2b中特征点f的垂足为点b,点b对应到现实空间中是车辆的底部,其高度为0,根据图像平面与现实空间的对应关系求得点b对应的现实空间点为点B,由点b、f和B的坐标值即可求得特征点f对应的现实空间点F的坐标值。

图2 由垂足信息求得特征点的三维坐标

当现实空间中的特征点与垂足原本就在一条垂线上时,得到的高度是正确的,但实际的情况是并不是所有的特征点都满足这样的条件,当特征点分布在车辆的其他地方时,例如车窗或者车顶,由于误差的存在,得到的高度并不是完全正确的。

如图3所示,点F,F1和F2为选取的车身上的特征点,这3个特征点并不在同一条垂线上。F,F1和F2投影到图像平面上的点为f,f1和f2,得到的垂足均为点b。点b对应的现实空间上的点为B,由点B的高度值(为0)可求得B点的三维信息,结合平面图像上点f,f1和f2的坐标值求得它们对应的现实空间上的点分别为F,eF1和eF2。由于F与B在一条垂线上,F1和F2与B不在一条垂线上,因此求得F的世界坐标信息是正确的,F1和F2的世界坐标信息是错误的。

图3 空间特征点与在图像上的投影点之间的关系

误差产生的原因主要是假设条件下的特征点都与车辆的前部在同一个垂面上,观察可知此条件下计算得到的高度都不低于特征点的真实高度,且特征点的真实高度越高,计算误差越大[9]。鉴于此,本文选取高度较低的特征点作为稳定特征点,即稳定特征点所对应的高度信息误差较小。稳定特征点的判断条件为

(2)

式中:Hth为高度信息的判断阈值,将满足此条件的特征点作为稳定特征点进行跟踪,一般选取Hth为0.4W,W为车道宽度。

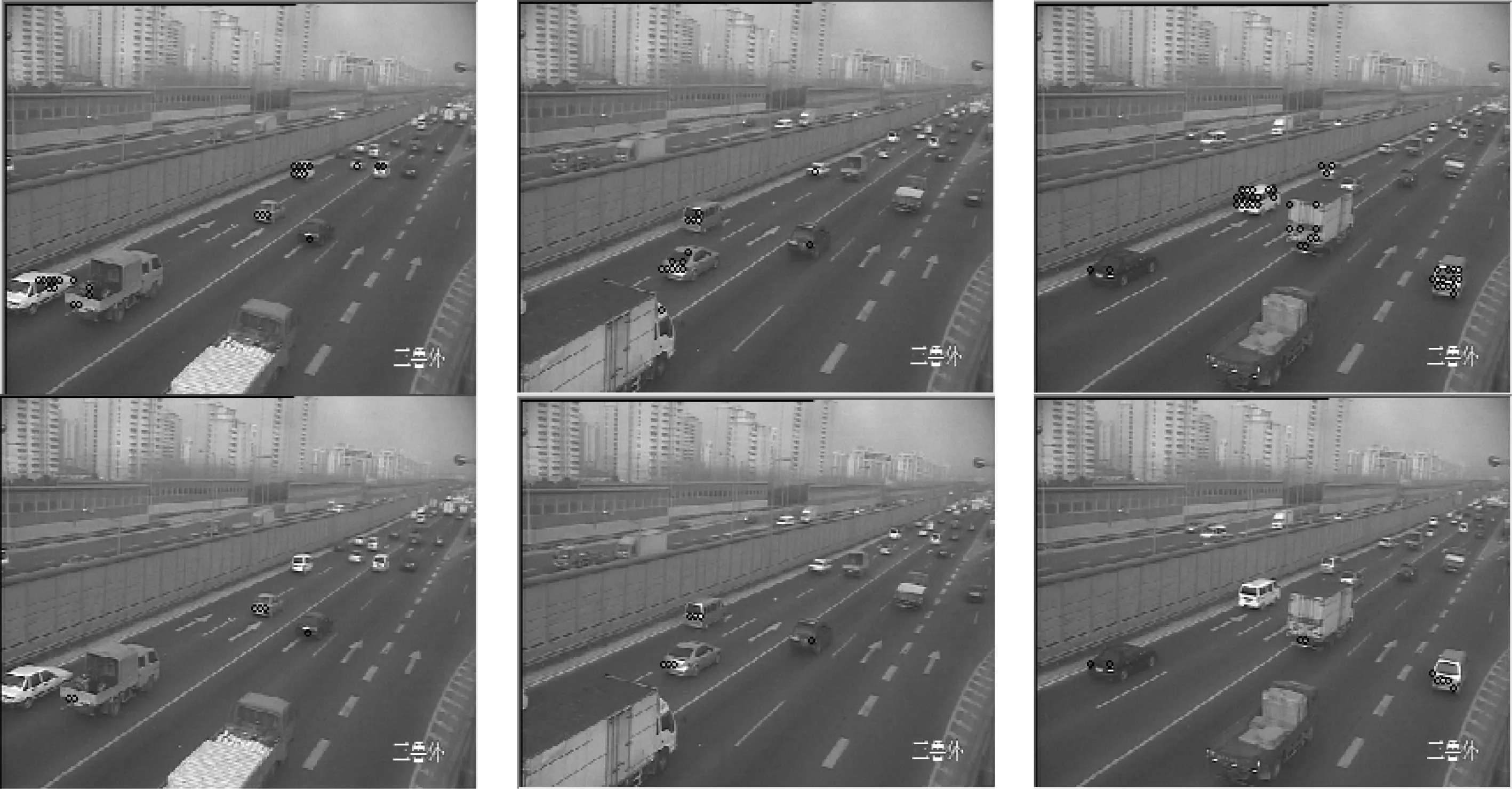

如图4所示,第1行圆圈表示的点为采用改进的Moravec特征点提取算法提取到的特征点,第2行圆圈表示的点为满足稳定特征点的判断条件筛选出的稳定特征点。

图4 初始特征点与筛选出的稳定特征点

2 空间轨迹的形成

对提取到的稳定特征点在二维图像平面上进行跟踪得到的跟踪轨迹即图像轨迹,在现实空间中画检测线作为空间轨迹形成的时间基准,当有轨迹(此处为图像轨迹在世界坐标系的表示即空间轨迹)通过检测线时,对其高度信息进行中值滤波,并对其历史跟踪点的世界坐标信息进行修正。

具体判断步骤为:

2)在现实空间中,当有空间轨迹经过检测线时,对该轨迹上的所有跟踪点的高度信息进行中值滤波求得该轨迹的高度zi;

4)重复步骤1)~3)对所有通过检测线的空间轨迹的世界坐标进行修正,修正后的空间轨迹即为最后分析用的空间轨迹。

3 实验结果

图5所示为两个摄像机高度较高场景下的跟踪效果图。当摄像机架设高度较高时,车辆的高度信息可以忽略,可以近似认为车辆是贴近路面行驶的,因此跟踪得到的轨迹线可以较好地反映车辆的运动信息。每个运动车辆的跟踪轨迹被限制在了它所行驶的车道内,不会出现由于车辆之间的相互遮挡而引起的轨迹误判为相邻车道的情况。

在本实验过程中,摄像机的安装采用相对于运动车辆远离的方式,即运动车辆从进入视野开始是渐渐远离摄像机的安装位置行驶的。如图6所示为摄像机低视角下的场景图,摄像机的安装高度为8m,且安装在道路的右侧约3m处,实际交通场景中的车辆相互遮挡现象较为严重,检测结果如图6所示,对本文提出的低视角单目摄像机下3D空间的运动轨迹提取算法进行验证。由于摄像机架设的高度较低,车辆之间的相互遮挡和尺度变化较为严重,运动车辆的跟踪轨迹有时会被误判为相邻的车道。因此仅仅利用在二维图像中跟踪出的轨迹对车辆的运动行为进行分析,很容易出现错误的结果。图6a中属于车道3的跟踪轨迹T1被误判为属于车道2;图6b中属于车道4的跟踪轨迹T2被误判为属于车道3;图6c中属于车道3的跟踪轨迹T3被误判为属于车道2。

图5 高摄像机架设条件下的跟踪效果图

图6 低摄像机架设条件下的跟踪效果图

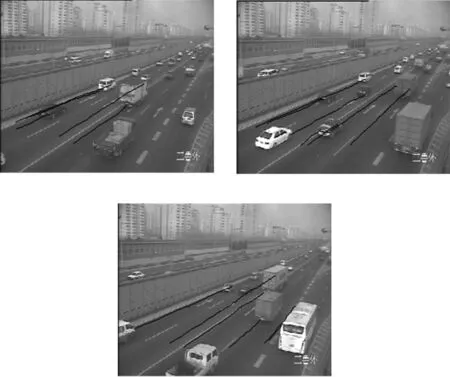

利用本文所提出的算法对稳定特征点进行跟踪,并将图像轨迹转换为空间轨迹,空间轨迹可以较好地解决车辆之间的遮挡引起的轨迹误判。

如图7所示,第1行实线为稳定特征点跟踪出的图像轨迹,虚线为空间检测线在二维图像上的投影。第2行为利用本文算法得出的空间轨迹。

图7 图像轨迹与空间轨迹的对比图

4 结论

由于摄像机安装高度和角度的影响,本实验所展现的实际场景中,高度信息造成的遮挡和尺度变化使得传统的利用图像轨迹对车辆运动行为进行分析的方法显得力不从心,因此本文提出一种低视角单目摄像机下3D空间的运动轨迹提取方法。首先对稳定特征点进行跟踪,在图像平面上形成图像轨迹,然后利用跟踪点的高度信息,将二维图像平面上跟踪出的轨迹逆投影到三维世界坐标系中,得到现实空间的轨迹,在现实空间中利用空间轨迹对车辆的运动行为进行分析。实验结果表明,该方法针对摄像机安装高度较低且安装在路侧所造成的车辆之间的遮挡和粘连能取得较好的跟踪轨迹。此方法得到的空间轨迹可用于后续的车辆计数、交通行为分析及交通安全预警等方面。

[1]MIN J, KASTURI R.Activity recognition based on multiple motion trajectories[C]//Proc.17th International Conference on Pattern Recognition.[S.l.]:IEEE Press, 2004: 199-202.

[2]MAGEE D R.Tracking multiple vehicles using foreground, background and motion models[J].Image and vision Computing, 2004, 22(2): 143-155.

[3]HU W, XIAO X, XIE D, et al.Traffic accident prediction using 3-D model-based vehicle tracking[J].IEEE Trans.Vehicular Technology, 2004, 53(3): 677-694.

[4]查宇飞,张育,毕笃彦.基于区域活动轮廓运动目标跟踪方法研究[J].中国图象图形学报,2007, 11(12): 1844-1848.

[5]SAUNIER N, SAYED T.A feature-based tracking algorithm for vehicles in intersections[C]//Proc.The 3rd Canadian Conference on Computer and Robot Vision.[S.l.]:IEEE Press, 2006: 59.

[6]BEYMER D, MCLAUCHLAN P, COIFMAN B, et al.A real-time computer vision system for measuring traffic parameters[C]//Proc.1997IEEE Computer Society Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE Press, 1997: 495-501.

[7]李华, 吴福朝.一种新的线性摄像机自标定方法[J].计算机学报, 2000, 23(11): 1121-1129.

[8]SONG H, LU S, MA X, et al.Vehicle behavior analysis using target motion trajectories[J].IEEE Trans.Vehicular Technology,2013,63(8):3580-3591.

[9]KANHERE N K, BIRCHFIELD S T.Real-time incremental segmentation and tracking of vehicles at low camera angles using stable features[J].IEEE Trans.Intelligent Transportation Systems, 2008, 9(1): 148-160.

赵倩倩(1990— ),女,硕士生,主研视频检测技术、图像处理;

宋焕生(1964— ),教授,博士生导师,主研智能交通、图像处理及计算机视觉;

徐晓娟(1988— ),女,硕士生,主研视频检测技术;

彭玲玲(1990— ),女,硕士生,主研图像处理。

责任编辑:薛 京

Trajectory Extraction in 3D Space from Low Camera

ZHAO Qianqian1, SONG Huansheng1,2, XU Xiaojuan1, PENG Lingling1

(1.DepartmentofInformationEngineering,Chang’anUniversity,Xi’an710064,China;2.ShaanxiEngineeringandTechniqueResearchCenterforRoadandTrafficDetection,Xi’an710064,China)

Due to the limitation of camera’s height and angle, occlusion and perspective between vehicles can be seen in video images.A method for trajectory extraction in 3D space using a camera that is low to the ground is presented.The 3D information of feature point is obtained by utilizing pedal information.The stable feature point and unstable feature point can be distinguished using height information.Trajectories in 3D space are formed by 3D information when the stable feature points are tracked.Experimental results show that occlusion and perspective between vehicles can be settled successfully with this method.

occlusion; feature tracking; vehicle tracking; 3D trajectory extraction

【本文献信息】赵倩倩,宋焕金,徐晓娟,等.低视角单目摄像机下3D空间的运动轨迹提取[J].电视技术,2015,39(3).

国家“863”计划项目(2012AA112312)

TN911.73;TP317.4

A

10.16280/j.videoe.2015.03.029

2014-05-20