一种服务机器人的实时物体识别与跟踪系统

2015-07-18薛翠红齐立萍杨鹏贾超

薛翠红,齐立萍,杨鹏,贾超

(1.河北工业大学控制科学与工程学院,天津 300130;2.河北工业大学研究生院,天津 300401;3.天津理工大学聋人工学院,天津 300384)

一种服务机器人的实时物体识别与跟踪系统

薛翠红1,3,齐立萍1,杨鹏1,贾超2

(1.河北工业大学控制科学与工程学院,天津 300130;2.河北工业大学研究生院,天津 300401;3.天津理工大学聋人工学院,天津 300384)

针对室内复杂环境下对家居服务机器人识别与跟踪物体的可靠性与实时性要求,提出了把Adaboost算法和Camshift算法相结合的新思路,并引入一种基于视频帧间相关性分析的新的检测策略,通过设定相邻视频帧中检测到的物体区域的重合率来剔除误检窗口.将其应用于家居服务机器人的实时物体识别与跟踪领域,既充分利用了Haar特征检测实时性好的特点,又解决了传统Camshift方法需要手工选取跟踪物体的缺点.在分辨率为1024×768,帧速率为30帧/s的视频上进行测试,每帧图像的检测率由原来的77.2%提高到92.4%,平均用时由原来的70.546 3 ms减少为23.9851ms.

家居服务机器人;物体识别与跟踪;Adaboost算法;Camshift算法;帧间相关性

0 引言

中国正逐步进入老龄化社会,老龄化问题已经成为中国面临的巨大挑战,因此,家居服务机器人[1]的应用前景极为广阔.在物体操作前机器人首先要从复杂的家庭背景中迅速准确地找到目标物体,完成物体识别与跟踪[2].假如物体识别错误,则会产生很严重的影响.实现准确、快速的物体识别与跟踪是一项重要而艰巨的任务.

在国内外,许多科研工作者在物体识别与跟踪方面做了大量研究.文献[3]采用的是基于模型的方法,首先利用CAD对物体建模,然后在图像中对物体进行描述并匹配,达到了一定的识别效果,但是建模的过程工作复杂度很高.美国卡耐基梅隆大学的MOPED系统[4]是基于局部特征的物体识别系统的典型代表,该方法被广泛应用.主要应用局部特征点及其空间位置关系进行匹配从而达到识别物体的目的.但是该方法的实现需要在输入的整幅高分辨率图像上提取SIFT特征,特征提取过程中,计算复杂度很高,所以导致系统速度过慢,不能满足服务机器人的实时性要求.文献[5]提出来一种基于压缩感知的跟踪算法,需要利用随机矩阵去降维高维信号,然后在降维后的特征上选择朴素贝叶斯分类器进行分类,通过在线学习不断更新分类器,效果好,但是跟踪窗口不能自适应调节大小,容易产生目标丢失现象,并且需要人工指定被跟踪物体.

目前,虽然在物体识别与跟踪领域已经取得了很大进展.但是由于室内环境的复杂性,服务机器人因为运动带来的图像模糊性,以及对识别跟踪实时性的要求,给服务机器人的物体识别带来了很大的困难.Viola将Adaboost[6]算法用于人脸识别,从而使人脸检测技术可以真正意义上从测试阶段转换到应用阶段.本文提出了一种基于Adaboost和Camshift[7]的物体识别与跟踪方法,采用Adaboost和Cascade[8]的方法可以在家居环境背景下完成物体定位,为了在视频中可以准确地跟踪物体,引入基于颜色特征的目标跟踪方法Camshift,当物体与机器人的相对位移发生变化时,该算法可以自动调节跟踪窗口大小.因为已经由基于Haar特征的Adaboost算法检测到物体,所以不需要人为手动选取待识别物体.该系统保证了识别性能的同时具有了良好的实时性,在室内复杂环境下,甚至是机器人快速移动情况下,都达到了很好的识别跟踪效果.

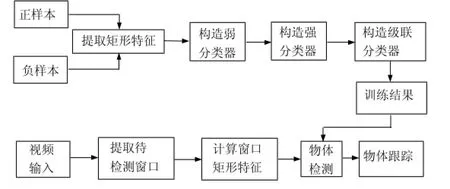

1 系统总体框图

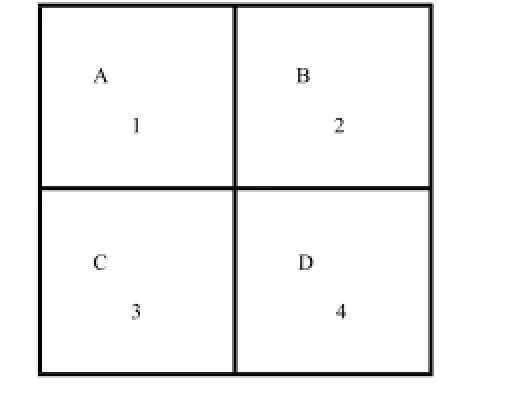

本系统分为离线训练分类器和在线进行物体的识别与跟踪2个方面.离线时,提取数据库中物体的Haarlike特征,训练Adaboost强分类器.在线时,系统摄像头实时采集室内视频图像,调用已经训练好的Adaboost强分类器,采用基于视频帧间信息分析的检测策略来完成物体检测,之后触发Camshift物体跟踪算法,完成物体的跟踪,如图1所示.

图1 物体识别与跟踪系统Fig.1 Objectrecognitionandtrackingsystem

2 基于Adaboost的物体检测

采用基于Haar特征的Adaboost级联算法来完成室内物体的粗略检测.不同大小、不同位置产出的Haar特征库数量庞大,利用Adaboost算法可以选择出最能表征物体特征的Haar特征.

2.1 Adaboost学习算法

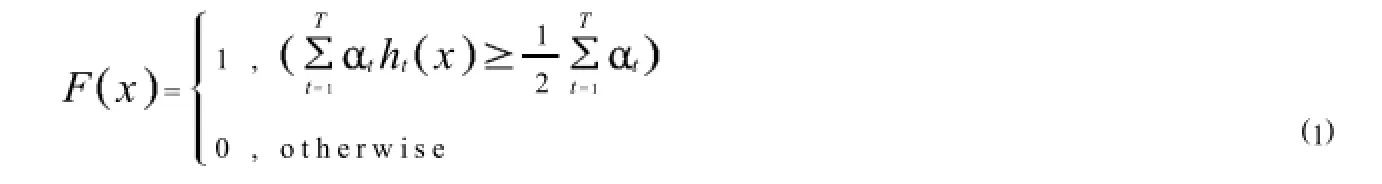

采用投票加权的方式对每一轮迭代产生的最优弱分类器进行线性组合,形成性能良好的强分类器.每个弱分类器的权重由其本身的分类性能来决定.最终生成的强分类器的表达式如下:

弱分类器的分类性能一般,只要其准确率大于50%即可.传统的弱分类器的数学形式如下:

其中:x代表输入图片;代表阈值;p用来控制不等号的方向.

通过改变样本权重来产生不同的弱分类器,样本权重受分类结果的影响.

其中:Dti代表样本权重;t为加权错误率.若样本分类正确,则i= 0;若分类错误,则i=1.可知,样本权重受分类结果的影响.如果样本分类正确,则样本权重减少;如果分类错误,那么相应的样本权重会增加,这样就可以使分类器更加侧重对难分样本的训练,从而可以不断提高分类器的可靠性.

图2 Haar-like特征Fig.2 Haar-likefeatures

图3 积分图的构造Fig.3 Integralimage

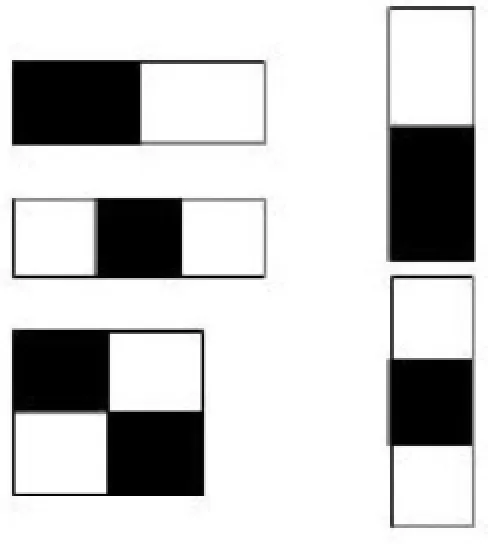

2.2 Haar-like特征

Haar-like[9]具有广泛的适用性,可以表征局部的灰度变化情况.特征由

2个或者多个相同大小的矩形组成,如图2所示.Haar特征定义为

其中:RsctSum ri是矩形ri处内所有灰度像素值之和;Wi是矩形ri的权值;N是矩形个数.通过改变Haar特征的大小以及位置,可以获得庞大的矩形特征库.本文采取基于扫描窗口的像素级移动方法进行Haar特征的提取.最小的Haar特征大小为2×2,所以最小的扫描窗口也是2×2大小,然后逐渐增大扫描窗口得到不同大小的Haar特征.在边缘检测方面该特征具有明显优势.

2.3 加速策略

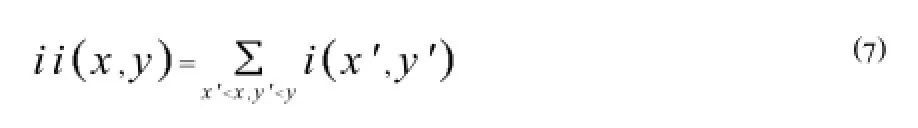

为了提高Haar特征的计算速度,采用积分图的方法.对于图像内任何一点A(x,y),定义其积分图为

其中,i x',y'代表(x',y')处的像素值.

引入积分图之后,要想计算某个矩形区域内的像素和,只要求得4个点处的积分图即可,这样可以使计算变得非常简便.如图3所示,只要求得1、2、3、4四点处的积分图,就可以迅速计算区域D中的像素值.

由上图可知,D中的像素值=ii 4+ii 1 ii 2 ii 3,引入积分图之后,只要对图像进行1次遍历,就可以快速计算不同大小、不同类型的Haar特征值.由此可知,在不提高Haar特征的计算复杂度的情况下,可以在不同尺度上快速计算Haar特征值,得到不同尺度的弱分类器,进而可以在不同分辨率大小的图像上进行检测.可以满足家居服务机器人在移动过程中进行识别的实时性要求.

在移动机器人的实时检测过程中,目标物体只是占据了图像中的一小部分,背景占据了图像的绝大部分区域.因此,在级联分类器的前几层,可以设置结构相对简单一点、检测率相对较高的强分类器.对于和目标物体区分度很大的背景区域,可以通过比较简单的强分类器进行排除.在级联分类器的后面几层,特征数量会增加,结构也会更加复杂,从而可以辨别与目标极为相似的负样本.通过级联策略,进行了由粗到精的检测,只有正样本和与正样本极其相似的负样本才会进入层数较高的分类器,大量的负样本在级联分类器的前几层就被排除掉,这样可以有效地减少计算复杂度.

对于一个K级的分类器,定义其检测率和误检率如下:

其中:D代表级联分类器的检测率;F代表级联分类器的误检率;di,fi分别代表某一层的检测率和误检率.

3 改进的检测算法

尽管Adaboost分类器识别效果很好,由于集成算法本身的局限性影响,在复杂背景下,数据分布极其复杂,对错分样本的权重的过分增大会造成分类性能下降.为了提高Adaboost算法的检测率,可以加入一些预处理环节,比如颜色检测方法[10]、运动检测方法[11],但是都有一定的局限性,颜色检测方法对光照的变化比较明显,运动检测方法只能用来检测动态的物体.所以,本文提出来一种基于帧间相关性的方法来提高检测率.

由于相邻帧之间存在很强的相关性,本文通过设定相邻视频帧中检测到的物体区域的重合率来剔除误检窗口.对于动态视频序列,帧与帧之间具有很强的联系.在实际视频信号中,相邻2帧之间的差距非常小.只有当相邻帧中检测到的物体的重合率达到一定要求,才认为成功检测物体.否则,则认为该区域为非物体区域.对于读入的视频,只有在连续的3帧图像中,都可以保证在一定范围内可以检测到物体,才认为真正检测到物体,当检测到物体之后,即可开启camshift[8]跟踪算法,从而解决了Haar特征检测的误检测和漏检测问题.

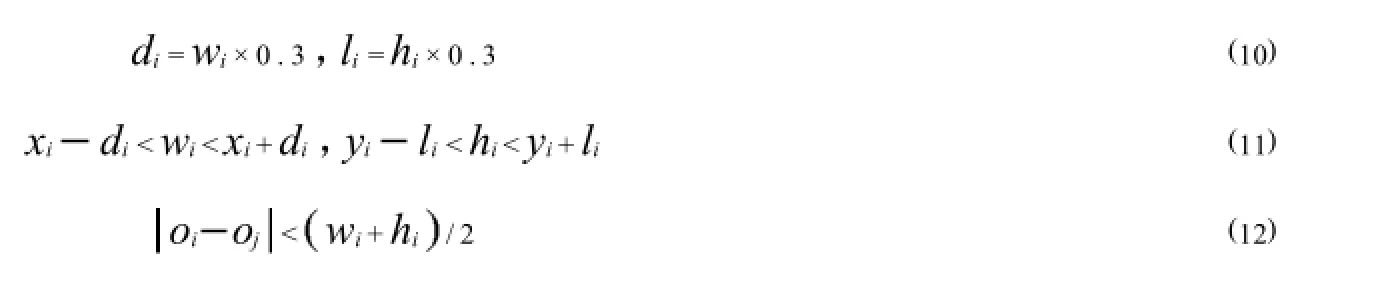

考虑到在连续的3帧图像中,物体在图像中的位置变化很小.采取以下方式来定义窗口的重合率.假设在第i帧图像中存在检测窗口ri=xi,yi,oi,wi,hi,其中,xi,yi分别代表矩形检测框左下角坐标,oi代表矩形检测框的中心坐标,wi,hi分别代表矩形检测框的宽度和长度.在3帧图像中,如果每相邻2帧中的检测窗口满足如下条件

则认为检测到了物体,这样可以大大降低误检率.

4 基于改进的全自动Camshift的物体跟踪

Camshift算法是一种有效的颜色跟踪方法.但是,传统的Camshift算法是一种半自动跟踪算法,必须在第1帧手动标记待跟踪物体,这无法满足人们对于家居服务机器人的要求.本文中,采用基于Haar特征的Adaboost算法来实现物体的自动检测.解决了传统Camshift跟踪方法的缺陷.

4.1 颜色直方图

颜色特征是物体的一个显著性特征.最常见的2个色彩模型是RGB色彩模型和HSV色彩模型.人眼对RGB彩色空间的感知程度很容易受到光照变化的影响.HSV色彩模型中的Hue分量滤掉光照产生的明暗信息,可以更好的体现物体本身的颜色属性,因此选择Hue分量作为特征的1个典型优势是可以在很大程度上减少光照变化对识别与跟踪的影响.

4.2 改进的Camshift算法

本文提出了一种基于检测的跟踪方法.基于Adaboost实现目标物体的最初定位,只有检测到物体信息并且达到一定的阈值之后才开启Camshift跟踪.计算检测到物体信息的颜色直方图,将其作为目标模板.

Camshift算法是Meanshift[12]算法的扩展.Meanshift算法的本质是自适应梯度上升搜索峰值.Meanshift会逐渐收敛于样本的概率密度函数的局部最大值,从而使检测中心越来越逼近图像质心.传统的Camshift跟踪算法实时性好,但是需要人工选择待跟踪物体,这个Camshift算法的应用带来了很大的局限性,因此本文根据利用Adaboost分类器的检测结果来确定目标模板并初始化跟踪窗口.

其算法步骤如下:

1)利用Adaboost分类器的检测结果来确定目标模板并初始化跟踪窗口.

2)计算初始窗口关于H分量的颜色直方图,通过对颜色直方图进行反向投影得到颜色概率分布图.

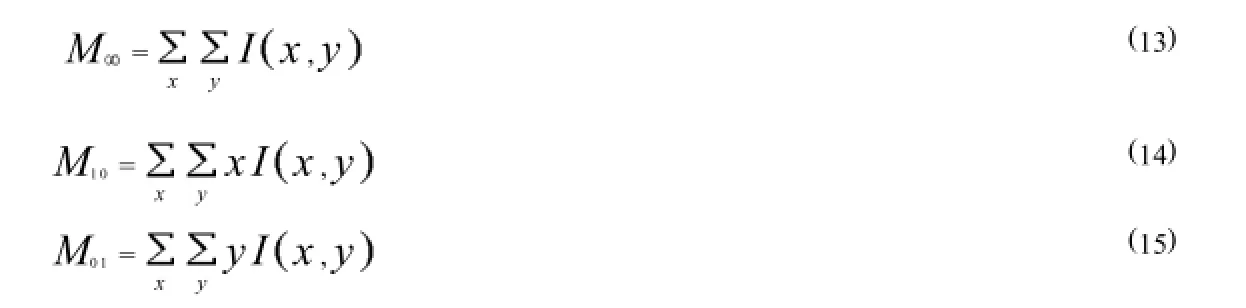

3)计算搜索窗口质心位置.在反向投影图中计算搜索窗口的各阶矩

其中:x,y为搜索窗口内位置坐标;I x,y为颜色概率分布图中对应点的像素值.

根据0阶矩和1阶矩可以求得搜索窗口的质心坐标

4)调整搜索窗口大小,计算如下

5)在颜色概率分布图中利用Meanshift迭代算法将搜索窗口的几何中心通过均值平移到质心位置.如果窗口中心与质心距离小于预先设定值或者迭代次数满足预先设定值则进入下一帧.否则返回步骤3)继续执行.

6)利用步骤5)中的值获得新的搜索窗口的大小和位置信息,再跳转到2)继续进行.将Meanshift算法引入到视频序列中,得到Camshift算法,该方法可以实现搜索窗口的自适应调节,不断更新跟踪模板.当机器人与物体的距离发生变化或者是视角发生变化时都可以实现可靠的跟踪.甚至在机器人运动速度很快的情况下,也可以达到很好的识别跟踪效果.可以满足移动机器人跟踪的鲁棒性要求.除此之外,在每帧图像上搜索物体时,只在目标可能出现的区域内进行搜索,大大减小了搜索时间,从而可以达到很高的跟踪速度,可以满足移动机器人跟踪的实时性要求.

5 实验及结果分析

5.1 实验平台

本文的机器人平台如图4所示,主要硬件结构如下:底盘左右两端各设有1个驱动轮,前端设有1个万向轮;计算部件为ARK-3500无风扇嵌入式工控机,处理器为Intel Core i7-3610QE,主频2.3 GHz,带6 MB三级缓存,内存最高可达16GB,运行WIN7系统.摄像机为UI-6230-C.

5.2 样本准备

为了降低光照的影响,需要具备不同光照条件下的正样本图像,所以选择从早晨7:00至夜晚10:00每隔1个小时进行1次拍摄,从而可以涵盖各种光照下的正样本图片.在不同光照强度下,对于每种物体,各自获得顺光和逆光条件下的正样本图片共计2 999张,如图5所示.将正样本图片进行归一化,图像存储格式为jpg格式.

负样本图片中不可以包含任何正样本特征,即不可以包含待识别的物体,在物体经常出现的场景中拍摄视频,截取视频中的帧获得负样本,这样可以降低物体的误检率.负样本的数量对系统精度有重要的影响,只有足够多的负样本才能较准确地反映出自然界的随机事物在图片中的灰度分布情况.在大尺寸图中,通过Bootstrap的方式可以获得许多负样本,从而适应系统的需求.

5.3 实验结果分析

为测试本文改进算法在家居服务机器人物体识别与跟踪的有效性,在VisualStudio2010基于C++编程语言进行软件开发.

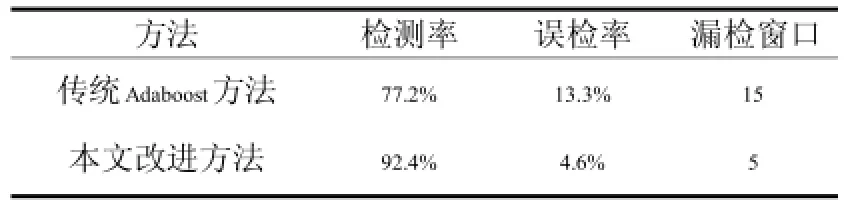

实验1:对比实验.将传统的基于Haar特征的adaboost算法和本文改进算法相比较,由表1可知,检测正确率大幅度上升.测试视频大小为1024×768,帧速率为30帧/s.

由表1可知,本文的改进算法可以大大提高检测率,有效地降低了误检率和漏检率.

图4 机器人平台Fig.4 Robotplatform

图5 正样本图Fig.5 Positivesamples

由表2可知,本文的改进算法可以大大提高实时性.在本文的改进算法中,最大用时出现在Haar检测过程中,由于Camshift算法只是在上一帧检测到物体的区域附件进行搜索,所以检测速度可以大幅度提高.

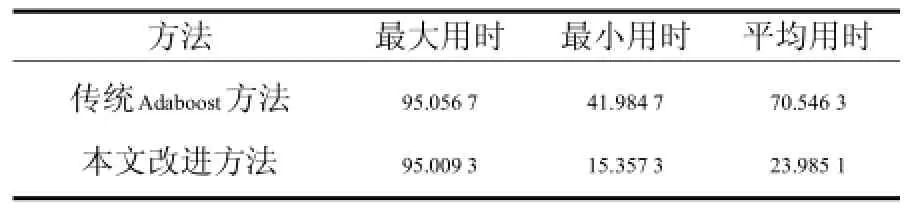

实验2:在复杂背景下进行物体识别与跟踪实验.视频大小为1024×768,帧速率为30帧/s.检测效果如图6所示.

为了测试本文改进算法的可靠性,选取室内杂乱环境为实验条件,图a)为利用Haar特征检测效果图,图b)、图c)依次为第45帧、90帧的检测效果图.在视频分辨率大小为1 024×768,帧速率为30帧/s的情况下,可以达到实时可靠的检测效果,可以达到家居服务机器人物体识别与跟踪的实时性与可靠性要求.当机器人快速移动时,当摄像头与物体的距离发生变化时,跟踪窗口可以自适应调节大小,满足实际需求.

表1 不同算法检测结果比较Tab.1 Comparison of the detection results of different algorithms

表2 同算法方法用时对比m sTab.2 Comparison of the detection speed of different algorithms

图6 视频中物体识别与跟踪结果Fig.6 Theresultsofobjectrecognitionandtrackinginthevideo

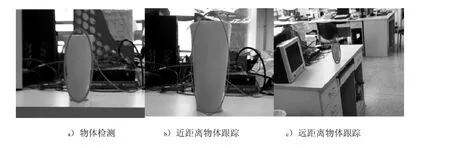

实验3:进行干扰目标下目标检测实验.选取桌面上常见物体(茶叶罐)为干扰对象,视频大小为1024×768,帧速率为30帧/s,检测结果如图7所示.

由图7可知:在相似物体茶叶罐的干扰下,达到了比较好的检测效果.可以看出,本文的改进算法具有很好的抗干扰能力,具有很好的鲁棒性.

实验4:进行其他物体检测试验.为了验证该算法的通用性,选取室内其他物体进行检测,检测结果如图8所示.本文的方法具有广泛的适用性.

图7 干扰下检测结果Fig.7 Thedetectionresultsininterference

图8 检测结果Fig.8 Thedetectionresults

6 结论

选取Haar特征,训练Adaboost级联分类器,采用基于视频帧间关联性的检测策略实现物体的检测,从而在很大程度上降低了物体的误检率和漏检率,引入基于颜色特征的Camshift跟踪算法,解决了传统Camshift算法需要人工指定跟踪窗口的缺陷,该方法可以自适应调节跟踪窗口大小,实时性好,实验证明,该方案可以很好的应用于家居服务机器人物体识别与跟踪系统,在检测速度与精度方面都有了很好的提升.

[1]XuQ,Ng JSL,TanOY,etal.Needsand attitudesof Singaporeanstowardshomeservice robots:amulti-generationalperspective[C]//Universal Access in the Information Society,2014.

[2]Kehoe B,Matsukawa A,Candido S,et al.Cloud-based robot grasping w ith the google object recognition engine[C]//Proceedings of IEEE International Conference on Robotics&Automation.IEEE,2013:4263-4270.

[3]Chen Y,Ji Z C,Hua C J.3-D model matching based on distributed estimation algorithm[C]//Proceedings of 2009 Chinese Control and Decision Conference.IEEE Computer Society,2009:5036-5067.

[4]Collet A,MartinezM,Srinivasa S S.TheMOPED framework:Object recognitionand poseestimation for manipulation[J].International Journal of Robotics Research,2011,30(10):1284-1306.

[5]Zhang K,Zhang L,Yang M.Real-time com pressive tracking[J].Lecture Notes in Computer Science,2012,7574(1):864-877.

[6]Viola P,Jones M J.Robust real-time face detection[J].International journal of computer vision,2004,57(2):137-154.

[7]M ahalakshmi M.Real time vision based object tracking using CAMSHIFT algorithm w ith enhanced color im age segmentation[C]//Proceedings of Computing Communication and Networking Technologies,2010 International Conference on.IEEE,2010:1-8.

[8]蔡灿辉,朱建青.采用Gentle AdaBoost和嵌套级联结构的实时人脸检测[J].信号处理,2013,29(8):956-963.

[9]Landesa-Vzquez I,A lba-Castro J L.The Role of Polarity in Haar-like Features for Face Detection[C]//Proceedings of International Conference on Pattern Recognition,2010:412-415.

[10]Ge K,Wen J,Fang B.Adaboost Algorithm Based On MB-LBP Features With Skin Color Segmentation For Face Detection[C]//Proceedings of Wavelet Analysis&Pattern Recognition International Conference,2011:40-43.

[11]Du S,Shehata M,Badaw y W.Hard hat detection in video sequences based on face features,motion and color information[C]//Proceedings of International Conference on Computer Research&Development.IEEE,2011:25-29.

[12]Comaniciu D,M eer P.M ean Shift:A Robust Approach Toward Feature Space Analysis[J].IEEE Transactions on Pattern Analysis&M achine Intelligence,2002,24(5):603-619.

[责任编辑 代俊秋]

Areal-timeobjectrecognitionandtrackingsystemfor homeservicerobots

XUECuihong1,3,QILiping1,YANGPeng1,JIAChao2

(1.SchoolofControlScienceandEngineering,HebeiUniversityofTechnology,Tianjin300130,China;2.GraduateSchool,HebeiUniversityofTechnology,Tianjin300401,China;3.Technical CollegefortheDeaf,TianjinUniversityofTechnology,Tianjin300384,China)

Tomeettherequirementsofreal-timeandreliabilityintheobjectrecognitionandtrackingsystem forthehomeservicerobotsincomplexindoorenvironments,anew ideaofcombiningtheAdaboostandCamshiftalgorithmwasproposedandanewdetectionmethodbasedon frame-to-framecorrelationwasused.Bysettingthe regionoverlaydetected inadjacentframes,wrongdetectionwindowswereeliminated.ThismethodnotonlymadefulluseoftheHaarfeatures,butalsosolvedthe problemofCamshift,inwhich the trackingwindowmustbeselectedmanually.Theexperimentresultsinthevideoat30fpswitharesolutionof1024×768showthatthedetectionrateincreasesfrom77.2%to92.4%, whiletheaveragetimereducesfrom70.5463msto23.9851ms.

homeservicerobots;objectrecognitionandtracking;Adoboostalgorithm;Camshiftalgorithm;frame-to-framecorrelation

TP242.6+2

A

1007-2373(2015)06-0001-07

10.14081/j.cnki.hgdxb.2015.06.001

2015-05-25

国家自然科学基金(61305101);天津市科技计划项目(14RCGFGX00846);河北省自然科学基金(F2015202239,F2014202121,F2010000137)

薛翠红(1980-),女(汉族),讲师,博士.

数字出版日期:2015-11-24数字出版网址:http://www.cnki.net/kcms/detail/13.1208.T.20151124.0901.002.html