数据质量成为大数据应用的“拦路虎”

2015-06-01

IT界正在被云计算、社交计算和移动计算这三个相关联、且百年一遇的技术趋势而重塑,这些大趋势正在改变数据世界,刺激数据爆炸式增长——更大数量、更广泛的数据种类、更高速度和更多商业价值。数据是企业数据中心的重要资产,获取并维护高质量数据,对高效的IT和业务运营至关重要。

数据量越来越大,有价值的信息获取难度就越大。获取不到有用的信息,就不能继而进行数据挖掘和数据分析。但有许多因素会导致这些“数据资产”的贬值,比如数据的冗余和重复导致信息的不可识别、不可信,信息时效性不强,精确度不够;结构或非结构数据整合有困难;人员变动引发的影响;数据标准不统一,相关规范不完善造成对数据理解的不充分等等。

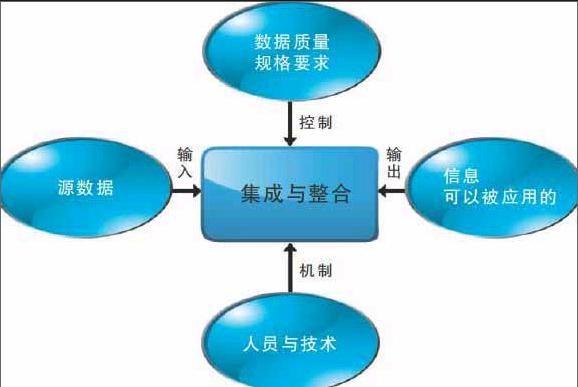

在BI (Business Intelligence,商业智能)时代,很多企业进行了巨大的BI项目投入,但依然不能逃脱项目失败的惨痛教训,其最根本的原因,就是用于商业智能分析的数据源头不能提供高质量的数据。那么在大数据时代到来之时,如何从海量数据中获取高质量的信息则成为大数据应用成败的关键因素之一。数据质量管理拥有一个完整的生态链,而数据集成以及整合是提高数据质量的第一道关键手段。

获取源数据后,需要根据使用的人员需求以及技术能力,定义数据质量的规格要求。因此,针对不同行业、业务和技术,数据质量的规格要求也是不一样的,例如,已经广泛用于制造企业的元数据标准就是有针对性的行业数据质量规格标准。

我们以统一集成监控为例,来说明数据集成与整合的基本方法。惠普新一代总控中心的集成平台逻辑架构包括四个层面,自下而上分别为:监控采集层、数据集成层、业务应用层和信息展示层。

监控采集层:使用监控、采集、感知等技术对IT系统、资源及环境对象进行信息采集;

数据集成层:主要包括对底层监控采集的数据进行集成和整合,包含了监控数据集成、集中告警、KPI(关键绩效指标)及数据分析模型、流程管理及报表管理等;

业务应用层:在数据集成和整合后,可以提供不同的解决方案应用;

信息展示层:提供人机交互的统一门户,除了提供安全控制以外,为不同类型角色和不同访问手段提供不同的视图。

在这四个层面中,数据集成层完成了“集成与整合”的功能,其中 “监控数据集成”完成了对不同类型监控数据的格式转换和集成,“资产及配置模型”以及“KPI及数据分析模型”完成了第一道数据整合的工作。

总而言之,数据的整合和优化是一个任重而道远的过程,数据质量管理是一个综合的治理过程,不能只通过简单的技术手段解决,需要从企业的高度加以重视,才能在大数据世界里博采众长,抢占先机。