人脸检测的继承式集成学习方法*

2015-04-01文佳宝熊岳山

文佳宝,熊岳山

(1.国防科学技术大学计算机学院,湖南 长沙410073;2.湖南大学信息科学与工程学院,湖南 长沙410000)

1 引言

以能够快速计算的类Haar特征为起点,以极为简单的决策树桩(Decision Stump)弱分类器为基础,以善于解决高维样本分类问题的集成学习算法AdaBoost为核心,以能够极大地加快检测速度的层叠结构(Cascade Structure)为翅膀,维尔纳(Viola P)和琼斯(Jones M)[1]在2001年提出的人脸检测器取得了该研究领域中的飞跃性进展。他们用AdaBoost算法在多个不同的训练集上训练出多个强分类器,再用层叠结构将它们组织成层叠分类器,大大地加快了人脸检测的速度。在这样的基本层叠分类器BCC(Basic Cascade Classifier)中,前后层次的强分类器没有任何直接联系,可以认为是一种“完全变异”的继承模式。基于基本层叠分类器的人脸检测器检测率高(95%以上),误检率极低(10-6以下),检测速度非常快(15fps)[1],基本上达到了实时人脸检测的要求。

其后,许多研究者对这个人脸检测器的设计方法进行了深入细致的研究,从多个方面作出了改进,其中最重要的改进之一就是进一步提高检测速度。这方面的典型工作之一就是链接式集成学习CBL(Chained Boosting Learning)方法[2]。该方法采用“全部遗传”的继承模式,把在前面层次学习到的知识(包括特征、弱分类器及其信度)直接应用于后续层次中,经过简单的公式推导,就得到了前后层次依次连接、连续不断的链接式(也称嵌套式或嵌入式)层叠分类器CCC/NCC/ECC(Chained/Nested/Embedded Cascade Classifiers),进一步加快了人脸检测速度,并应用于实时多视角人脸检测中[3],获得了很好的检测性能。后来,许多研究者基于CBL 方法做出了许多优秀的人脸检测器[4~8]。到目前为止,该方法已经成为人脸检测器的经典设计方法之一。最近,有研究者进一步讨论了基于CBL方法的嵌入式层叠分类器的最优设计方法[9]。

具体地说,在嵌入式层叠分类器中,后面层次的强分类器完全继承了在前面层次中学习到的所有特征、弱分类器及其信度。因为训练不同的强分类器的训练集各不相同(主要是负样本不同),训练目标的难度差别较大,所以通过CBL 方法继承的特征、弱分类器及其信度对后面层次来说就不再是最优的。这就有可能导致用CBL方法训练的嵌入式层叠分类器的整体检测性能有所下降。当然,这是完全遗传的必然结果,其好处是检测速度大大加快了。

本文基于“遗传+变异”继承模式,提出继承式集成学习方法的一般框架GF-IBL(General Framework of Inherited Boosting Learning),简称IBL,可用于训练多种形式的继承式层叠分类器ICC(Inherited Cascade Classifiers)。具 体 说 来,IBL方法有四种形态,可以训练出四种不同形式的层叠分类器:

(1)全变异、无遗传方法,用于训练基本层叠分类器[1]。

(2)全遗传、无变异方法:即CBL 方法。用于训练嵌入式层叠分类器[2,3]。

(3)少遗传、多变异方法:只继承特征的继承式集 成 学 习IBL-FI(Feature Inherited Boosting Learning)方法。用于训练特征继承层叠分类器ICC-FI(Feature Inherited Cascade Classifiers)。这种层叠分类器在文献[10]中称为“Fea-Accu Cascade”。

(4)多遗传、少变异方法:继承弱分类器(含特征)的继承式集成学习IBL-WCI(Weak Classifier Inherited Boosting Learning)方法。用于训练弱分类器继承层叠分类器ICC-WCI(Weak Classifier Inherited Cascade Classifiers)。这是本文新提出的方法。

显然,这四种方法各有利弊:

(1)基本层叠分类器:速度最慢,但检测性能最好。

(2)嵌入式层叠分类器:继承最多,不存在任何额外的计算代价,因而其检测速度可能最快,但检测性能可能最差。

(3)特征继承层叠分类器:继承的信息较少,只有特征,因而其额外的计算代价最大,其检测速度可能最慢,但其检测性能可能仅次于基本层叠分类器。

(4)弱分类器继承层叠分类器:继承的信息较多,包括特征和弱分类器,其额外的计算代价相当小,因而其检测速度接近嵌入式层叠分类器,而其检测性能可能接近基本层叠分类器。

对于后两种方法来说,因为未继承的“变异信息”在后续层次中需要重新计算,所以或多或少存在一些额外的计算代价。当然,因重新计算的“变异信息”对后续层次的训练集的拟合性更好,故新的继承式层叠分类器可能具有更好的收敛性和可扩展性,可以减少需要新增的弱分类器的数量。因此,从总体性能上说,新的继承式层叠分类器与嵌套式层叠分类器在检测速度上相差不大,但有可能具有更好的扩展性,因而无需使用复杂的模型调整方法[4,5]。

一般说来,弱分类器继承层叠分类器的性能可能最好,因为其额外的计算代价很小,且性能提高的可能性很大。基于RAB、GAB 算法、查找表LUT 弱分类器与类Haar矩形特征的正面直立人脸检测实验结果表明了新的继承式集成学习方法的有效性。

2 集成学习算法与LUT弱分类器

继承式集成学习方法适用于任意的集成学习算法与弱学习算法。下面考虑实值集成学习算法,包括 实 值RAB(Real AdaBoost)与 温 和GAB(Gentle AdaBoost)自适应集成学习[9]算法。进一步,考虑使用的弱分类器为查找表(LUT)分类器,特征为类Haar矩形特征。

对于两分类问题,训练集由N个样本(x1,y1),… ,(xN,yN)组成,其中样本xi∈χ(样本空间),样本类别标记yi∈{+1,-1}。每个LUT 分类器h(x):χ→R 都是用LUT 弱学习器L基于某个特征f∈Sf(特征集)学习得到的。因此,h(x)也可一般地书写成h(f(x),θ),其中θ是参数,特征f(x)为类Haar矩形特征。假设LUT 分类器的分区个数为B个,每个分区的特征值范围分别表示为[Li,Ui),则LUT 分类器可以表示为:

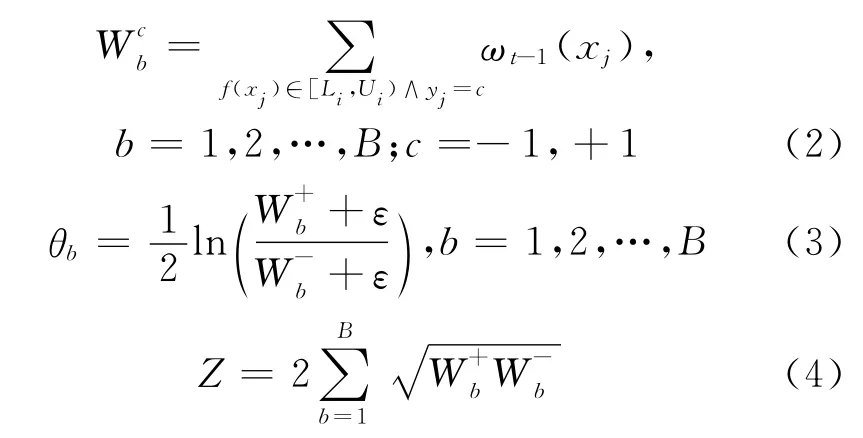

学习含T个LUT 弱分类器的强分类器的RAB算法如下:

步骤1 设置初始样本分布:ω0(xi)=1/N,i=1,2,…,N。

步骤2 对当前的样本分布ωt-1(xi),t=1,2,… ,T,基于每个特征f∈Sf,学习一个LUT分类器h(x)。其计算过程如下:

其中,ε是一个微小正数(如10-10),用于规避过拟合与数值计算错误。

步骤3 选取最优LUT 分类器h*(x)作为强分类器的第t个弱分类器,改记为ht(x):

更新与归一化样本分布:

步骤4 输出强分类器:H(x)=sign[(h(x)-b],其中,b为可调整的阈值,默认值为0;sign()表示符号函数:若x≥0,则sign(x)为1;否则为-1。

GAB算法与此类似。只需要把以上的(3)、(4)两式改成以下的两式即可。

3 层次结构与链接式集成学习——CBL方法

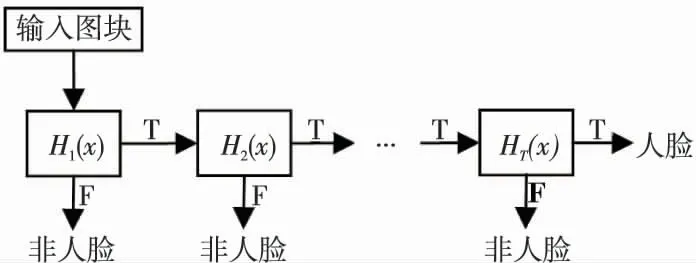

维尔纳和琼斯于2001年提出的人脸检测器[1]的层次结构如图1所示。它由若干个层次(Layer,也称为阶段Stage)叠加而成,每个层次都是用AdaBoost算法训练出来的强分类器。我们称之为基本层叠分类器BCC。

Figure 1 A face detector of cascade structure with Tlayers图1 一个包含T 个层次的层叠结构的人脸检测器

在图1 中,Hi(x)代表第i个强分类器。其中,前面层次的强分类器较为简单,由少量弱分类器组成,确保整个人脸检测器的速度足够快;后面层次的强分类器较为复杂,由相对较多的弱分类器组成,可以区分与人脸较为相似的非人脸图块,对整个人脸检测器的检测性能与扩展性能提供了必要的保障。基本的层叠分类器可表示为:

其中的强分类器Hi(x)是用集成学习方法训练出来的,它由若干个弱分类器组成:

进一步研究发现,用于检测人脸的弱分类器hi,t(x),如决策树桩(Decision Stump),大多相对较为简单,其区分性只是略好于随机猜测。这样,在训练第i个强分类器Hi(x)时,在前面已经训练好的i-1个强分类器Hj(x)[j=0,…,i-1]中的所有弱分类器hj,t(x)[j=0,…,i-1;t=0,…,mj]可以直接移植到当前的强分类器中,其中mj表示第j个强分类器所包含的弱分类器的个数。这样,既可以大大降低当前强分类器的复杂度,又不会显著降低其检测性能。这就是采用“完全遗传”继承模式的链接式集成学习CBL方法。这样得到的人脸检测器被称为嵌套式层叠分类器NCC[3]或嵌入式层叠分类器ECC[9],如图2所示。

Figure 2 A face detector of chained cascade structure with Tlayers图2 一个包含T 个层次的嵌套式层叠结构的人脸检测器

图2中,在第i个强分类器中植入了其前面所有的i-1 个强分类器的所有历史信息。具体地说,第i个强分类器Hi(x)继承了其前面所有的i-1个强分类器Hj(x)[j=0,…,i-1]中的所有弱分类器hj,t(x)及其信度αj,t[j=0,…,i-1;t=mj-1,…,mj]。当然,它也还需要增加一些新的弱分类器hi,t(x)[t=mi-1,…,mi]以满足本层次的训练要求。

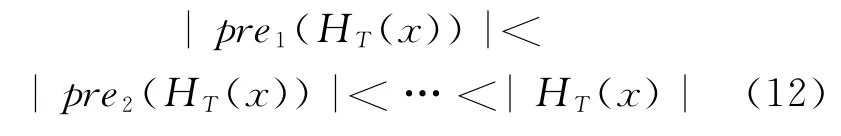

从最后一个层次往前看,整个嵌入式层叠分类器中其实只有一个强分类器,即最后层次的强分类器HT(x),前面层次的强分类器只是它的一部分。具体地说,只是它的不同前缀。因此,嵌入式层叠分类器可以表示为:

其中,Prei(H(x))表示分类器H(x)的第i个前缀,满足前缀递增的条件:

按式(10),将前面的强分类器H1(x),…,Hi-1(x)代入到第i个强分类器Hi(x)中,可得到如下的计算公式[2]:

以上两式分别表示未阈值化和已阈值化的强分类器,其中符号x、f(x)、h(x)、θ、α、H(x)、m和b分别表示训练样本、样本的特征、基于特征和有关参数的弱分类器、弱分类器的参数、弱分类器的信度、由若干弱分类器组成的强分类器、强分类器中的弱分类器的个数和二值化强分类器~H(x)的阈值。由此可知:第i个强分类器从其前面的i-1个强分类器中继承了几乎所有的历史信息,包括:所有特征、所有弱分类器及其参数、所有弱分类器的信度。唯一未被继承的只有强分类器的阈值,因为无法继承。因此,对第i个强分类器Hi(x)来说,其前面的mi-1个弱分类器及其信度均源自继承,新训练的弱分类器只有(mj-mj-1)个。后者通常远小于前者,这说明CBL方法是非常有效的。

这种“完全遗传”的继承模式产生“近乎完美”的继承结果:所有前面层次的强分类器一个接一个地被完全嵌入到后续的强分类器当中。后续的强分类器有了这些“遗传”信息,就无需从零开始,只需训练少量的新弱分类器就可满足本层次的训练要求。因此,CBL 方法大大地加速了层叠分类器的训练过程,大大地简化了层叠分类器的规模,提高了层叠分类器的检测速度。

当然,CBL方法也有其不足之处,主要是“完全遗传”的继承模式只有遗传,没有变异。它忽视了后续层次所面临的训练集已经不同于前面层次的训练集(主要是负样本不同),其分类任务不同于前面层次,分类难度也会逐渐加大。这样,继承的弱分类器一般不再是最优的,因而其区分能力和扩展能力均会有显著下降,从而影响了最终的层叠分类器的检测性能。一般说来,嵌入式层叠分类器的检测率与“非遗传”的基本层叠分类器相比有所下降。

设想一下,如果只是进行部分的遗传,保留必要的变异,也就是说采用“部分遗传+部分变异”的继承模式,那么就有可能提高最终的层叠分类器的检测性能,缩小与基本层叠分类器的差距。同时,一方面由于“遗传”了部分信息,减少了后续层次的弱分类器数量,检测速度较基本层叠分类器要快得多;另一方面由于存在部分“变异”,使得继承的弱分类器虽也非最优的,但其区分能力与扩展能力都比“完全遗传”的CBL 方法会有所提高。这样,就有可能取得比CBL方法更好的综合性能。

4 继承式集成学习的一般框架——IBL方法

在基本层叠分类器中的各个强分类器之间并无任何“遗传”信息,因此可以认为是“完全变异”的继承模式,其结果是扩展性能最好,但收敛速度相对较差。CBL方法采用的是“完全遗传”的继承模式。也就是说,在后续层次中完全遗传了前面层次中的所有信息,并无任何“变异”。这样做的最大好处是不会给训练阶段与检测阶段带来任何的额外计算代价,从而大大地提高了检测速度,虽然扩展性有可能略有下降。从均衡收敛性与扩展性的角度来考虑,这两种方法都是重点强调某一个方面,都不是最佳选择。

为此,本文提出的继承式集成学习方法的一般框架GF-IBL,用于训练多种形式的继承式层叠分类器ICC。它采用一般的“遗传+变异”的继承模式,也就是说,在后续层次中遗传前面层次中的部分信息,而另一部分信息则需要在被继承层次中重新计算(这就是所谓变异的含义)。显然,前面两种方法——基本层叠分类与嵌入式层叠分类器——都只是继承式层叠分类器的特例,它们分别对应于“零遗传”和“零变异”的情况。若遗传与变异信息都不为零,则可以得到新的继承式集成学习方法。由于新的继承式集成学习方法存在“变异信息”,这就会给训练阶段与检测阶段都带来一定的额外计算代价,有可能会影响其检测速度。所获得的补偿是由于重新计算的“变异信息”很可能导致相应的分类器具有更好的区分能力与扩展能力。这样,收敛速度与扩展性能都会变得更好。综合起来,新的继承式集成学习方法产生的继承式层叠分类器的收敛性可能与嵌入式层叠分类器相差不多,而扩展性与基本层叠分类器相差不多,从而能取得收敛速度与扩展性能更好的均衡效果。

由第2节可知,用集成学习方法训练一个强分类器的一般步骤如下:

步骤1 准备若干训练样本组成的训练集S=〈x1,…,xN〉。

步骤2 寻找合适特征f,计算每个训练样本x的特征值f(x)。

步骤3 基于特征f学习弱分类器h,计算每个训练样本x的弱分类器响应值h(f(x))。

步骤4 计算弱分类器h的信度α,计算每个训练样本x的信度加权弱分类器响应值αh(f(x))。

步骤5 组合若干个弱分类器,形成强分类器H,计算每个训练样本x的强分类器响应值H(x)=∑αh(f(x))。

步骤6 寻找合适的阈值b,当训练样本x的强分类器响应值H(x)>b时,判决为目标,否则判为非目标。

因此,一般说来,继承式集成学习方法有四种继承策略:

(1)不继承:无遗传,全变异,可训练基本层叠分类器。

(2)继承特征f(x):未继承弱分类器h(x)及其信度α,可训练特征继承层叠分类器。

(3)继承弱分类器h(x)(含特征f(x)):未继承信度α,可训练弱分类器继承层叠分类器。

(4)全部继承:包括特征f(x)、弱分类器h(x)及其信度α,相当于链接式集成学习,可训练嵌入式层叠分类器。

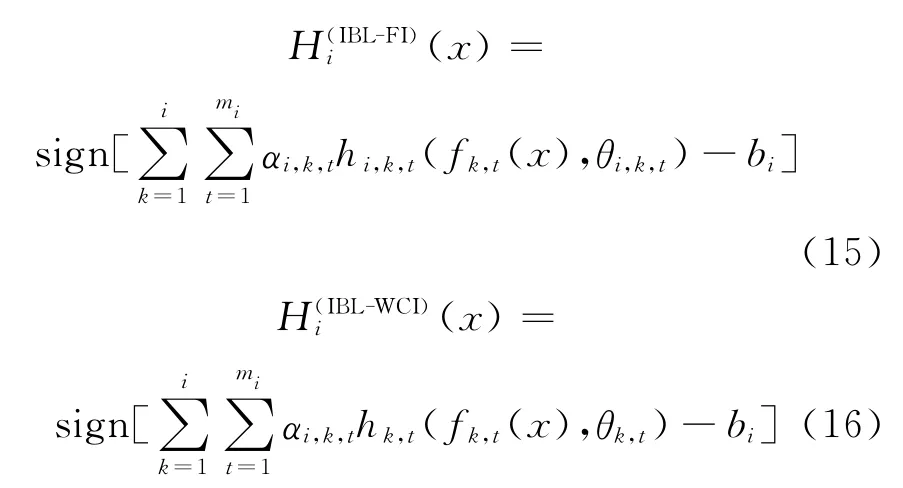

两种新IBL方法分别称为特征继承集成学习IBL-FI方法和弱分类器继承集成学习IBL-WCI方法。用它们训练的特征继承层叠分类器ICC-FI和弱分类器继承层叠分类器ICC-WCI的计算公式如下:

其中下标不带i者表示“遗传信息”,带i者表示“变异信息”,需要在被继承层次的训练集上重新计算相应的值。

下面来考虑新IBL 方法带来的额外计算开销问题。对训练阶段来说,多一些计算开销对检测阶段没有影响,因为通常情况下检测过程与训练过程是分开进行的。事实上,由于新IBL 方法至少都继承了前面层次所用到的所有特征。对这些继承的特征无需进行最费时间和空间的特征选择过程,而只需要做一些不费力气的信度计算或弱分类器参数计算,因此新IBL 方法给训练阶段带来的影响是微不足道的。具体说来,下面的实验表明,用以训练一个新的LUT 弱分类器需要几秒钟,而继承一个LUT 弱分类器的时间不到1ms,所以后者可以忽略不计。

对检测阶段来说,新IBL 方法由于“变异信息”所需的计算会对检测速度带来或多或少的影响。下面以最简单的由两个矩形组成的类Haar矩形特征和LUT 弱分类器为例,估计新IBL 方法的继承代价。基本的计算代价为:

(1)计算Haar特征:8次计算,8次查积分表;

(2)光照归一化:1次计算,1次查方差;

(3)计算所属分区:2次计算,2次分别查最小特征值与分区长度;

(4)计算累计信度:1次计算,1次查累计信度。

从而1个非继承的LUT 弱分类器(含信度累计)的计算代价为12个单位,其中1次浮点计算加上1次查表称为1个代价单位。用IBL-FI方法继承1个弱分类器,可节省9个单位,还有3个单位需要重新计算。此时,一个继承的弱分类器相当于新增加了0.25个非继承的弱分类器。而用IBLWCI方法继承1个弱分类器,可节省11个单位,还有1个单位需要重新计算。此时,一个继承的弱分类器相当于新增加了0.083个非继承的弱分类器。

显然,IBL-WCI的继承代价相对较小(只是IBL-FI的继承代价的1/3)。人脸检测中所使用的弱分类器功能相对较弱,因此继承的弱分类器虽然已不再是最优的,甚至可能连次优都算不上,但是它们的区分能力相差却并不太大。而且,自适应集成学习算法的精髓就在于基于最优化模型来集成多个弱分类器,单个弱分类器的区分能力弱一点并无关紧要。所以,继承弱分类器是完全可行的。最重要的是,针对被继承层次的不同的训练集,IBLWCI方法修正了信度。新的信度对新层次的强分类器应该是最为重要的。所以,IBL-WCI方法完全可能获得超出其它方法的最好的性能权衡。

单纯从继承代价上来看,新IBL 方法当然不如CBL方法。但是,新IBL方法还是有所补偿的。因在被继承的层次上重新计算“变异信息”,故继承的弱分类器可以更好地拟合被继承层次上的新训练集,因而可能减少在该层次上需要新增加的弱分类器的数量,而且还有可能提高最终的层叠分类器的区分性和扩展能力。这就有可能在不影响收敛性的前提下提高最终的层叠分类器的扩展性,可以解决软层叠结构[4]与动态层叠结构[5]带来的复杂训练问题。

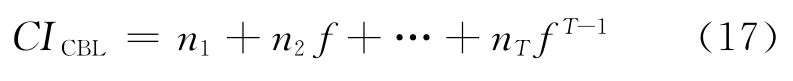

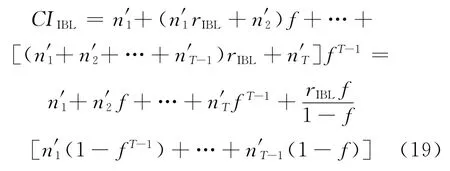

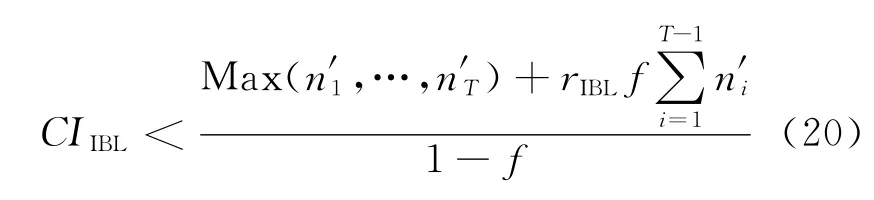

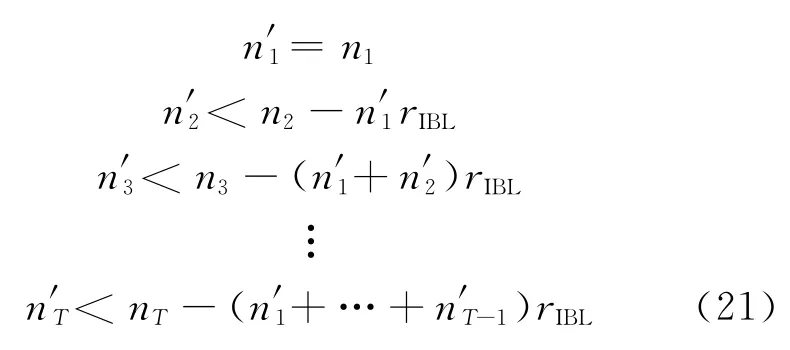

对于一个包含T个层次的层叠分类器,可以用收敛性指数CI(Convergent Index)来衡量其在检测人脸时的收敛速度。用CBL方法构造的层叠分类器的CI计算公式如下:

其中,ni是各层次新增加的弱分类器数量,f是各层次的检出误检率(为简化讨论,假定它们都相同)。假设每个非继承的弱分类器的基本计算代价为1。容易得到上式的上界为:

用新IBL方法构造的继承式层叠分类器的CI计算公式如下:

为了比较嵌入式层叠分类器与继承式层叠分类器的收敛速度,比较式(17)与式(19)可知,后者优于前者的充分条件如下:

其中第一个显然成立,因为在相同条件下,第一层不涉及继承,所以弱分类器个数相同。前面的几个不等式也是必要的,但后面的不等式并非必要,因为前面层次对收敛速度影响较大,而后面层次对收敛速度则几乎没有影响。考虑到IBL-WCI方法的相对代价较小,故它比IBL-FI方法更有可能获得比CBL方法更快速的继承式层叠分类器。

5 实验及其结果分析

下面用正面直立人脸检测为例来验证新IBL方法的有效性。这里采用的集成学习方法是RAB算法和GAB算法,弱分类器是LUT 弱分类器,特征是类Haar矩形特征。因为LUT 弱分类器用局部信度代替全局信度((或者说全局信度为1),所以IBL-WCI方法解释为在继承弱分类器时只保留分区状况不变,改变所有分区的局部信度值,而CBL方法保留整个LUT 弱分类器。为了确保实验结果的高效性,这里使用MSL 算法[11]训练每个层叠分类器。

5.1 实验配置

为完成以下实验,总共收集了22 856 个直立人脸样本。其中9 832个从网络下载(称为基本人脸集,主要作为训练集),1 376个来自BioID 人脸库,3 391个来自Feret人脸表情库,其余的8 260个也是从互联网上收集来的。为了生成MSL 算法所需要的庞大人脸样本集,对所有人脸样本进行了进一步的处理,包括:镜面反射、平面旋转±6°和±12°等。然后还将所得到的人脸样本用另一个人脸检测器进行过滤。最后得到了146 458个人脸样本供MSL算法使用,称为扩展人脸集。

非人脸样本从15 000个不包含人脸的图像中取得。为了获得更多非人脸样本,对以上图像进行逆时钟旋转45°或镜面反射操作,总共得到60 000个这样的非人脸图像。每个训练集中总是包含10 000个非人脸样本。不同层次的训练集中的非人脸样本通过“自举法”(Bootstrapping)从以上非人脸图像中取得。所有训练样本全部用24×24像素的图块表示。特征集采用扩展的类Haar矩形特征[12]。这样的特征共有238 356个。

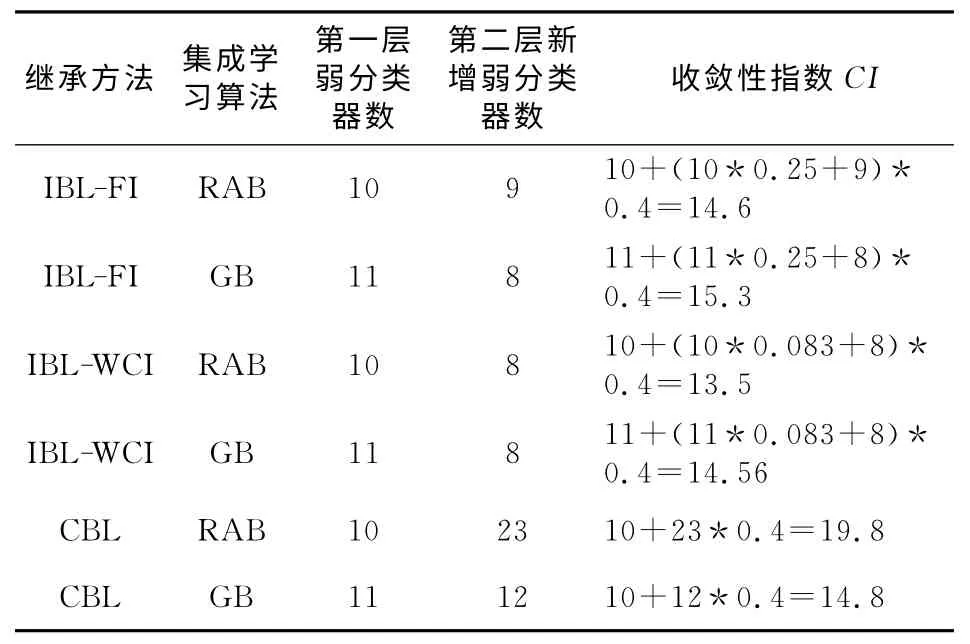

5.2 用CBL与IBL方法训练二层分类器

为了比较CBL 与IBL 方法的性能,本实验训练了若干个二层分类器。具体地说,针对IBL-FI、IBL-WCI和CBL三种继承方法和RAB、GB 两种增强算法总共训练了六个二层分类器。训练集的设置如上所述,但只选取了特征集中的1/5,共47 671个特征。测试集中的人脸样本从扩展人脸集中选取约1/3,共48 629个人脸;非人脸样本从以上非人脸图像中随机选取,也是48 629个。最小检出率DR(Detection Rate)设为100%。最大误检率FAR(False Alarming Rate)为40%。训练结果如表1和图3所示。

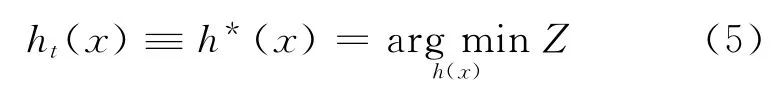

Table 1 Comparison of convergent speed of two-layer cascade classifiers trained with IBL表1 用IBL方法训练的二层分类器收敛速度比较表

从表1可以得出如下结论:

(1)IBL方法在后续层次中需要新增的弱分类器比CBL方法要明显少许多,其中RAB算法减少61% ~65%,GAB算法减少33%。

(2)一般情况下,IBL 方法的收敛性指数比CBL 方法小或相当,因而前者的收敛速度与后者相当或更快。

(3)对GB 算法,三种方法的收敛性指数相差很小,说明其收敛速度差别不大。

(4)对RAB 算 法,IBL 方 法 明 显 优 于CBL 方法,且IBL-WCI方法最好。

Figure 3 Comparison of detection performance of two-layer cascade classifiers trained with IBL图3 用IBL方法训练的二层分类器检测性能比较图

从图3可知:

(1)对GB算法,在训练集与测试集上CBL 方法都稍微优于两种IBL 方法。考虑到它们之间在收敛速度上的差别也是细微的,故而它们在整体上差别不大。

(2)对RAB 算法,在训练集与测试集上两种IBL方法都明显优于CBL方法。考虑到它们之间在收敛速度上的差别也是如此,故而在整体上IBL方法好于CBL方法。但是,两种IBL方法之间差别不大。综合收敛性与扩展性,IBL-WCI性能最好。

(3)GB 算 法 在 整 体 性 能 上 明 显 优 于RAB 算法。

5.3 用IBL方法训练高性能正面直立人脸检测器

下面使用IBL方法训练若干高性能正面直立人脸检测器。

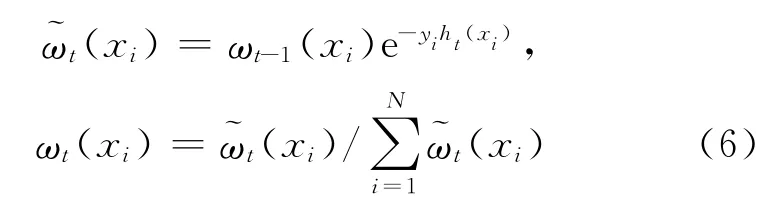

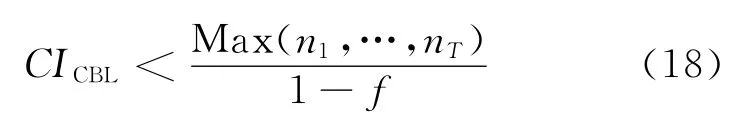

训练集如上所述。将所有特征划分成2~4组,在各个层次中轮流使用,以尽可能地保证不同层次间特征的差异性。各个层次的DR与FAR分别设置成100%与40%。为了进一步提高检测性能,自适应平滑LUT 分类器(AWSLUT)[13]取代一般的LUT 分类器。测试集为标准的MIT+CMU 正面直立人脸库,其中有130 张灰度图像,包含508个标记好的人脸[14]。图4只给出其中基于IBL-WCI方法的两个人脸检测器的ROC曲线。

在图4中,第一个分类器由19层787个AWSLUT 分类器组成,第二个分类器由18层508个AWSLUT 分类器组成。在检测过程时,检测窗口总是保持24×24不变,检测窗口和移动步长为1,待检测图像以0.833 3 的比例依次缩小。基于RAB的检测器末端(误检数<7)稍差,但其后性能很好。基于GB 的人脸检测器末端好,但其后较差。基于RAB的人脸检测器末端较差,但其后较好。注意到后者使用的弱分类器更多。ROC曲线数据取得方式同文献[1]。在每个图块上使用的平均特征数(不含继承的)分别为15.2和14.5,分别比文献[15]、文献[14]和文献[13]中的类似人脸检测器少75%、58%和32%。

Figure 4 Comparison of detection performance of upright frontal face detector trained with IBL图4 用IBL方法训练的正面直立人脸检测器的检测性能比较图

6 结束语

本文针对通过一般集成学习方法产生的基本层叠分类器与通过链接式集成学习产生的嵌入式层叠分类器的简要分析,指出其分别使用“全部变异”与“全部遗传”的继承模式。前者无遗传,后者无变异,且都没有额外的计算代价。在此基础上,本文基于“遗传+变异”的继承模式,提出继承式集成学习方法的一般框架。前两种方法只是该框架下的两个特例:前者强调扩展性能,收敛速度较差;后者则刚好相反。为了更好地均衡收敛速度与检测性能,本文提出两种新的继承式集成学习方法,即继承特征与继承弱分类器(含特征),分别用于训练特征继承层叠分类器与弱分类器继承层叠分类器,并给出了其计算公式。新的继承模式只继承部分遗传信息,另外的变异信息需要重新计算,因而存在或多或少的额外计算量。但是,因为变异信息的拟合性更好,在收敛速度上有所补偿。基于RAB和GB两种集成学习算法和LUT弱分类器的实现表明新继承方法在多数情况下优于原方法。当然,还需要更多的实验来验证新继承方法的有效性,如针对离散Ada-Boost算法与决策树桩组合的实验、针对CART 树的实验、针对非人脸对象检测的实验等等。

[1] Viola P,Jones M.Rapid object detection using a boosted cascade of simple features[C]∥Proc of the 2001IEEE Conference on Computer Vision and Pattern Recognition,2001:511-518.

[2] Xiao R,Zhu L,Zhang H J.Boosting chain learning for object detection[C]∥Proc of ICCV,2003:709-715.

[3] Huang C,Ai H,Wu B,et al.Boosting nested cascade detector for multi-view face detection[C]∥Proc of the 17th International Conference on Pattern Recognition,2004:415-418.

[4] Bourdev L,Brandt J.Robust object detection via soft cascade[C]∥Proc of the International IEEE Conference on Computer Vision and Pattern Recognition,2005:236-243.

[5] Xiao R,Zhu H,Sun H,et al.Dynamic cascades for face detection[C]∥Proc of the 11th IEEE International Conference Computer Vision,2007:1-8.

[6] Pham M T,Hoang V D D,Cham T J.Detection with multiexit asymmetric boosting[C]∥Proc of the 2008IEEE Conference on Computer Vision and Pattern Recognition,2008:1-8.

[7] Sochman J,Matas J.WaldBoost-learning for time constrained sequential detection[C]∥Proc of the 2005IEEE Conference on Computer Vision and Pattern Recognition,2005:150-157.

[8] Masnadi-Shirazi H,Vasconcelos N.High detection-rate cascades for real-time object detection[C]∥Proc of ICCV,2007:1-6.

[9] Saberian M J,Vasconcelos N.Learning optimal embedded cascades[J].IEEE Transactions on PAMI,2012,34(10):2005-2018.

[10] Yan S Y,Shan S G,Chen X L,et al.Fea-Accu cascade for face detection[C]∥Proc of the 2009International Conference on Image Processing,2009:1217-1220.

[11] Yan S Y,Shan S G,Chen X L,et al.Matrix-structural learning(MSL)of cascaded classifier from enormous training set[C]∥Proc of CVPR,2007:1-7.

[12] Lienhart R,Maydt J.An extended set of haar-like features for rapid object detection[C]∥Proc of the 2002IEEE International Conference on Image Processing,2002:900-903.

[13] Wen J B.Empirical study of smoothed LUT classifiers for fast and robust face detection[C]∥Proc of ICIIP,2013:1.

[14] Wen J B,Xiong Y S.Smoothing LUT classifiers for robust face detection[C]∥Proc of the 2013International Conference on Information and Technology,2013:930-936.

[15] Wen J B,Xiong Y S,Wang S L.A novel two-stage weak classifier selection approach for adaptive boosting for cascade face detector[C]∥Proc of the 7th International Conference on Intelligent Computing,2013:122-135.