基于变换域边缘检测的双源交通图像融合方法研究

2015-03-21樊东燕

樊东燕,蔡 宇

基于变换域边缘检测的双源交通图像融合方法研究

樊东燕1,蔡 宇2

(1. 山西大学 商务学院信息学院,太原 030031;2. 山西大学 物理电子工程学院,太原 030006)

针对交通图像在恶劣天气及夜间成像质量较差的问题,通过研究红外传感器和可见光传感器的成像原理,设计了一种基于变换域边缘检测的双源交通图像融合方法。首先将红外源图像与可见光源图像利用小波变换分别进行分解,再对所得结果中的高频成分边缘检测,通过设计不同的融合规则对变换域不同频率子图像分别进行融合处理,然后通过逆变换得到特征信息丰富的融合图像。

双源交通图像;融合规则;边缘检测;小波变换;图像融合

0 引言

随着经济的发展,道路上的车辆数量与日俱增,行驶速度也越来越快,交通监控技术亟待改进,智能交通系统(intelligent traffic system,ITS)技术应运而生。ITS主要基于视频图像实现目标检测,其中涉及到的视频车辆检测技术是以摄像机作为检测装置,基于计算机视觉技术从视频序列中提取运动的车辆对象,从而进行车辆信息检测[1]。近年来,随着模式识别技术的快速发展,基于计算机图像处理技术的ITS视频车辆检测系统成为了研究热点[2]。在ITS的视频检测系统中,可以利用数字图像处理技术,把来源于不同传感器采集的多路图像信号通过融合处理,进而消除冗余、增加互补、降低不确定性、提高信息的可靠度[3]。

多源图像融合(multi-source image fusion)是近些年新兴的图像处理研究方向,主要针对多聚焦图像或多传感器获得的图像进行融合[4]。利用设计融合算法提取多源图像的特征信息,通过对不同的特征信息进行有机合成后得到信息全面、准确的融合图像[5]。在多源图像融合技术的研究中,尝试将图像分解到具有多尺度性质的变换域中进行融合处理是国内外相关学者的研究热点[6]。随着小波变换(wavelet transform,WT)数学理论在信号处理领域的兴起,其在多源图像融合中作为一种多尺度分解算法扮演着重要的角色[7]。

可见光成像传感器和红外成像传感器是ITS中较常用的成像设备[8],其中可见光成像传感器的工作波长范围是380~780nm,与人眼可识别的波段相同,能够获取场景中的反射信息,其图像的特点是能够提供清晰的细节,含有丰富的颜色,图像含有大量信息,具有较高的时空分辨率,有利于人眼对整个场景及重要目标的认知[9]。但这种传感器抗干扰性差,在恶劣天气及夜间成像能力较差。红外成像传感器将物体辐射的热红外功率信号形成的红外辐射图样转换成人眼可识别的热像图[10]。由于红外线具有穿透性,因而传感器可发现烟雾遮挡的目标或在树木后的车辆等。因此在夜间,人眼不能很好地辨别场景中的目标时,利用不同景物之间存在着一定的温度差,可以利用红外传感器来进行探测。但这样所成的图像不利于人眼判读[11]。因此在原来的道路监控摄像机旁新增一个红外摄像机,调整其拍摄角度与CCD摄像机保持一致,这样就可同时获得拍摄目标相同的红外与可见光源图像[12]。然后将两路源图像进行融合,可以有效地提高系统的工作效率。基于上述研究本文设计了一种基于边缘检测与小波变换相结合的双路传感器交通图像融合方法。

1 双路传感器交通图像融合方法设计

1.1 小波图像融合的处理流程

二维小波变换是一种图像的多尺度分解,而且小波分解是非冗余的。图1通过图示描述了小波图像融合的处理流程[13]。

1.2 源图像的转换

在不影响图像识别的前提下,为了减少图像处理的运算量,通常在小波分解之前需要先将源图像转换为灰度图像[14]。首先计算源图像中每个像素点的亮度值,然后把亮度值进行量化,表示成0~255的灰度等级,通过匹配像素亮度值将源图像转换为灰度图像。

1.3 设计图像融合规则

源图像经过小波分解后得到一系列不同分辨率(频率)的子图像。其中高频子图像反应的是诸如图像的边缘、区域边界等细节特性;低频子图像是能量集中的主要部分,表现的是图像的概貌和平均特性[15]。因此对于低频子图像的融合通常应用加权平均法,即低频融合小波系数可由所有低频系数进行加权平均后得到。由于边缘是图像很重要的部分,虽然边缘像素很少却包含着很多信息,因此先对图像的高频部分进行边缘检测,然后再融合[16]。

图像边缘的检测一直是图像融合的研究热点,Canny算子被认为是比较好的边缘检测方法[17]。这种方法不仅能够检测出图像中真正的弱边缘,而且抗噪声干扰能力较强,因此可以在图像处理过程中在检测边缘与抑制噪声之间的此消彼长中取得最佳平衡状态,检测得到较完整的边缘,减少模板检测中边缘出现中断的情况[18]。所以本文对高频子图像的边缘检测采用最佳边缘检测算子Canny算子进行边缘检测[19]。算法设计流程为:

第1步:设A、B分别为可见光图像和已配准的红外图像,对其分别进行小波变换,得到各自的分解结构:低频成分AL、BL;高频成分AHh1、AHv1、AHd1、BHh1、BHv1、BHd1。

第2步:对分解后得到的A、B图像的低频近似分量AL、BL,取加权平均值后作为融合图像的低频分量。融合结果为:

(,)=1×AL(,)+2×BL(,) (1)

式中:1、2为权值,且1+2=1。由于传感器位置相近且针对同一目标,所以两幅图像低频部分所含信息量相差不是很多,因此本文中取1、2都为0.5。即:

(,)=0.5×[AL(,)+BL(,)] (2)

第3步:对高频子图像在对应的垂直、水平、对角线方向上分别进行边缘检测,得到对应方向高频子图像的边缘图像,用AHh2、AHv2、AHd2、BHh2、BHv2、BHd2表示。

第4步:设计高频子图像的融合算法:由于传统的高频子图像的融合规则是采用系数绝对值取大的方法,其算法为:

从式(3)可以看出:这种基于单独像素点度量细节信息强度的方法是不稳定的,特别是当多尺度变换缺乏平移不变性时,由于源图像的平移、旋转等规则变化会导致分解系数的能量发生剧烈的不规则变化,使得融合后的图像缺乏一致性。而且在融合过程中会传递并放大源图像中的噪声和死点。

Fig.1 The process of image fusion based on wavelet

因此本文设计了一种采用基于局部方差的方法来得到融合系数,以(,)点为中心,取大小为×的邻域,文中具体设置为3×3的方阵区域。定义点(,)的局部方差:

式中:为点为中心时各点对应权值,权值可通过行和列的高斯分布加权相加而得。离点越近,其对应权值越大。

定义两幅高频子图对应区域匹配度1,2(,):

设阈值为0.5,当匹配度小于阈值时,融合图像的分解系数取区域方差大的相应点的分解系数:当图A区域方差大于图B区域方差时,(,)=AH(,);否则,当图A区域方差小于图B区域方差时,(,)=BH(,)。

若匹配度大于阈值,则采取加权平均方法得出相应的分解系数:当图A区域方差大于图B区域方差时:

(,)=×AH(,)+×BH(,)

否则,当图A区域方差小于图B区域方差时:

(,)=×AH(,)+×BH(,)

第5步:对通过上述步骤得到的低频子图像和3个方向的高频子图像实施小波逆变换,具体流程如图1所示,即可获得理想的融合图像F。

2 仿真实验

为了验证该算法的融合效果,本文以MATLAB为平台,选取小波函数bd6进行小波分解,分别对3对不同尺寸已经配准的可见光图像和红外图像进行了测试。

测试1:图2为第1对图像融合测试结果。其中(a)图为可见光图像,(b)图为红外图像。应用算法融合后的图像如(c)图所示。可见,图2中(a)图环境光线较暗,肉眼看不清楚人站的具体位置。(b)图由于人体热量高,人能很清楚地成像。融合图像(c)图综合了(a)图、(b)图的特点,能比较全面的看到整幅图像。

测试2:图3为第2对图像融合测试结果。其中(a)图为可见光图像,(b)图为红外图像;应用算法融合后的图像如(c)图所示。可见,图3中(a)图中飞机的大部分轮廓清晰可见,但周围的树木却看不清。(b)图恰恰相反。(c)图所示的融合图像综合了(a)图、(b)图的特点,既能基本看清飞机,又能看到旁边的树木,具有很好的融合效果。

测试3:图4为第3对图像融合测试结果。其中(a)图为可见光图像,(b)图为红外图像;应用算法融合后的图像如(c)图所示。

图2 图像融合测试1

图3 图像融合测试2

Fig.3 Image fusion test 2

图4 图像融合测试3

Fig.4 Image fusion test 3

可见,图4(a)中可见光图像中道路标线清晰可见,但部分车辆看不清楚。图4(b)图红外图像中看不到路面标线,车辆外形却能大致看到。图4(c)图所示的融合图像综合了二者各自的特点,包含了两幅图像的信息量,达到了较好的融合效果。

3 融合图像质量的比较与评价

通常从主观和客观两个角度分别对融合图像评价,因此作者分别对图像采用传统的小波变换融合算法和本文设计的融合算法进行了对比。其仿真结果如图5所示。

1)主观评价

事先给予观察者一定的评价尺度或者给出参考图像,然后由观察者直接来判断融合图像的品质。图6给出了国际上通用的五分制主观评价体系。根据其评价尺度表,从图5可以明显看出,左侧图像(图5(a)、图5(c)、图5(e))得分明显高于右侧图像(图5(b)、图5(d)、图5(f))。即本文设计的融合规则明显优于传统的小波变换通和规则。但是主观评价的结果带有观察者的主观性和不确定性,因此,只采用主观方法进行融合算法优劣性能的比较是不合适的。

图6 主观评价体系

Fig.6 Subjective evaluation system

2)客观评价

为了客观、定量的评价融合图像的效果,采用了目前通常采用的3类评价指标即信息熵、平均梯度和标准差[20]。通过计算两种融合图像的不同的统计参数,比较来判断融合算法的效果。表1给出了3个传统客观评价指标得出的结果。

表1 客观评价参数表

其中:

①信息熵():反映了图像携带信息量的多少,当熵值越大时,则表示包含的信息就越多,融合效果就越好。

式中:p()为图像中像素灰度值为的概率,通常取灰度为的像素数与总像素数之比;为图像灰度级数。

式中:Ñ(,)、Ñ(,)分别为(,)分沿和方向的差分。

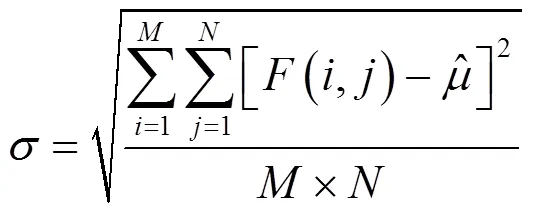

③标准差:是表征图像各像素灰度值相对于平均灰度值的离散情况的参数,当的值越大时图像的灰度级分布越分散,则对应的图像融合效果越好。

表1中图5(a)、图5(c)和图5(e)是采用本文算法,即小波变换结合边缘检测,高频融合采用系数绝对值取大的方法得到的结果;图5(b)、图5(d)和图5(f)为对应图像用小波变换得到的融合图像。从表1可以看出本文所用图像融合方法与传统小波变换融合方法比较有一定优势,融合效果比较理想。

4 结论

通过上述实验数据可以证明本文设计的融合算法对ITS视频检测系统中的红外图像与可见光图像具有较好的融合效果,特别是光线较暗的可见光图像和其对应红外图像。此方法基于小波变换,对不同分辨率下的图像的低频和高频分量分别进行融合。在进行高频分量融合时,首先对高频部分采用最佳边缘检测算子Canny算子进行边缘检测,然后采用基于局部方差的方法得到融合系数,因此最终应用小波逆变换重构获得的融合图像,不仅涵盖了可见光和红外图像的有效特征信息,而且由于融合算法中对边缘处理的改进,提高了图像信息的表述和重构质量,使得融合图像信息量增大,分辨效果增强,提升了ITS视频检测系统对交通车辆场景目标的识别和处理能力。

[1] 程英蕾, 赵荣椿, 李卫华, 等. 基于像素级的图像融合方法研究[J]. 计算机应用研究, 2004(5): 169-172.

[2] 刘建伟, 郭平. 一种基于边缘检测的图像融合新方法[J]. 北京师范大学学报:自然科学版, 2007(5): 518-521.

[3] 李茜, 郭佳, 郭小云. 基于边缘检测小波变换的红外与可见光图像融合方法[J]. 光学仪器, 2013(1):18-21.

[4] 刘倩, 杜宏, 薛庆增. 一种基于小波变换的可见光与红外图像融合算法研究[J]. 车辆与动力技术, 2011(3): 48-51.

[5] 李伟林. 结合方向边缘检测的红外与可见光图像融合算法[J]. 激光与红外, 2014(6): 682-686.

[6] Sumeet Dua, U.Rajendra Acharya, Pradeep Chowriappa, et al. Wavelet- based energy features for glaucomatous image classification[J]., 2012, 16(1): 80-87.

[7] 李洋. 红外图像与可见光图像融合研究[D]. 哈尔滨: 哈尔滨工程大学, 2013: 19-23.

[8] 李佳奇. 图像融合在视频交通信息检测中的应用研究[D]. 天津: 天津大学, 2009: 36-43.

[9] 孔韦韦, 雷英杰, 雷阳, 等. 基于改进型NSCT变换的灰度可见光与红外图像融合方法[J]. 控制与决策, 2010(11): 1607-1612.

[10] 陈木生. 基于Contourlet变换和模糊理论的图像融合算法[J]. 激光与红外, 2012(6): 695-698.

[11] NannanYu, TianshuangQiu, FengBi, et al. Image features extraction and fusion based on joint sparse representation[J]., 2011(5): 1074-1082.

[12] YANG B, LI S. Multifocus image fusion and restoration with sparse representation[J]., 2010, 59(4): 884-892.

[13] 艾超. 基于方向小波变换的图像边缘检测算子研究[D]. 西安: 西安电子科技大学, 2013: 47-5 8.

[14] 赵青, 何建华, 温鹏. 基于平均梯度和方向对比度的图像融合方法[J]. 计算机工程与应用, 2012, 48(24): 165-168.

[15] 徐萌萌. 基于小波变换的图像融合算法研究[D]. 哈尔滨: 哈尔滨理工大学, 2014: 1-17.

[16] Li Shu-tao, Yang Bin, Hu Jian-wen. Performance comparison of different multi-resolution transforms for image fusion[J]., 2011, 12(2): 74-84.

[17] 许宏科, 秦严严, 陈会茹. 一种基于改进Canny的边缘检测算法[J].红外技术, 2014, 36(3): 210-214.

[18] 徐萌兮. 红外与可见光数字图像融合技术研究[D]. 南京: 南京理工大学, 2014: 1-27.

[19] Li Shutao, Yin Haitao, Fang Leyuan. Remote sensing image fusion via sparse representations over learned dictionaries[J]., 2013, 51(9): 4779-4789.

[20] 王宇庆, 王索建. 红外与可见光融合图像的质量评价[J]. 中国光学, 2014, 7(3): 396-401.

Research on the Fusion of Dual-source Traffic Image Based on Transform Domain and Edge Detection

FAN Dong-yan1,CAI Yu2

(1.,030031,; 2.;030006,)

The paper puts forward a kind of image fusion method of infrared image and visible light image based on wavelet transform and edge detection, which is through study the imaging principle of infrared sensor and visible light sensors to solve the traffic image quality problems which get in bad weather or at night. First the image is decomposed by wavelet transform, and then high frequency components are edge detected, and the low frequency and high frequency parts are fused through the different image fusion rules respectively. Finally, the fused image is obtained through inverse wavelet transform.

dual-source traffic image,fuse rules,edge detection,wavelet transform,image fusion

TN911.73

A

1001-8891(2015)09-0740-06

2015-03-02;

2015-04-17.

樊东燕(1965-),女,山西太原人,教授,主要研究方向为图像处理。

山西省科技厅基础研究项目,编号:2014011018-1;山西大学商务学院科研基金项目,编号:2012013。