设备主动视觉的模板匹配自标定

2015-01-17粟明李迪李松东梁

粟明 李迪 李松 东梁

(华南理工大学机械与汽车工程学院,广东 广州 510640)

设备主动视觉的模板匹配自标定

粟明 李迪 李松 东梁

(华南理工大学机械与汽车工程学院,广东 广州 510640)

为简化自动化设备视觉定位平台的标定流程,减少对标准块的依赖并实现标定自动化,本文提出了基于模板匹配的主动视觉自标定方法,依靠平台运动时拍摄到的图片,实现任意场景目标的识别,然后建立模型对运动位置进行标定;给出了视觉自标定的原理、流程和容错方法,适用于多目标的情形;整个过程由粗到精分3圈进行,根据匹配位置自动计算标定结果,使标定更加实用化与通用化。所提方法成功应用于LED平面固晶机中,结果表明该方法精度可达13.947μm,能满相关自动化设备的视觉标定要求。

模板匹配;主动视觉;自标定;固晶机;定位精度

1 引言

鉴于计算机视觉系统的非接触、速度快、精度高、成本下降等优点,自动化设备整合视觉系统提升设备的智能化水平已是必然趋势。视觉标定技术作为设备精定位及其离线编程的基础,是融合视觉的自动化设备中不可或缺的关键技术。视觉标定的目的是确定三维空间与二维图像之间的映射关系,基于这种映射关系,可获得二维图像中的机构精确运动的位置信息。视觉标定有三种不同形式:传统标定方法、自标定方法和基于主动视觉的标定方法。传统标定利用加工精度很高的已知标定块作为参照物,通过空间点和图像之间的对应关系来建立标定模型,采用优化算法提取参数,典型的方法有Tsai的方法[1,2]、Weng的迭代法[3]以及简易标定法[4,5]等,传统法可使用任意摄像机模型、精度高,但过程复杂且需标定块,视觉定位平台的场景、位姿和光学参数等易变动,要经常标定,若每次都用标定块,费时且不方便。自标定技术则直接利用多幅场景图像特征信息进行标定,无需标定块、灵活性强,但鲁棒性差[6]。主动视觉的自标定是已知某些运动信息的条件下的视觉标定方法,基于运动信息,可以线性求解模型参数,鲁棒性更高[7]。

2 基于视觉的平面定位系统

考虑一种典型的由一个相机和2个电机组成的平面定位系统,如图1所示。平台负责物料运载,相机则进行识别,相机固定在机架且静止不动,平台做运动定位。

运动平台的精确位置通过目标在图像中的位置运算得出,图像运算的坐标都基于图像坐标系,考虑到像素阵列精度高,且不同品牌相机内部参数不同,实际计算时,忽略相机内部误差,主要考虑外部位姿误差。假设平台运动是基于电机脉冲的,那么需将图像位置转化成对电机控制的脉冲值,即计算像素的脉冲当量。对于图1所示的平面定位系统,图像坐标系至电机坐标系的转换主要考虑以下问题:①旋转,相机的安装位置和电机的安装位置的角度偏差;②平移,图像原点和电机坐标系原点平移偏差;③缩放,两个坐标系物理尺度不一致。④轴夹角,电机坐标系的双轴安装垂直度偏差;⑤仿射,相机投射平面和电机平台平面的平行度偏差。

图1 视觉平面定位系统图

3 模板匹配技术

图像识别技术是主动视觉的自标定的基础,利用模板匹配技术,可实现自标定的任意场景目标识别。模板匹配就是模板在搜索图中进行滑动,对滑动的点进行相似度运算,当模板在搜索图目标区内的匹配度大于预设值时,可判定为匹配[8]。设搜索图S大小为M×N,模板图T为m×n,NCC算法作为基于灰度的典型模板匹配方法,其在滑动位置(i,j)的相似度可定义为:

图2 多目标处理前识别结果

图3 多目标处理后识别结果

图4 最优位置

针对模板匹配速度慢的问题,采用快速归一化相关性、积分图像和快速傅里叶变换等[9-12]方法对模板识别速度进行优化,采用曲面拟合[8,13]方法对匹配结果进行亚像素定位。

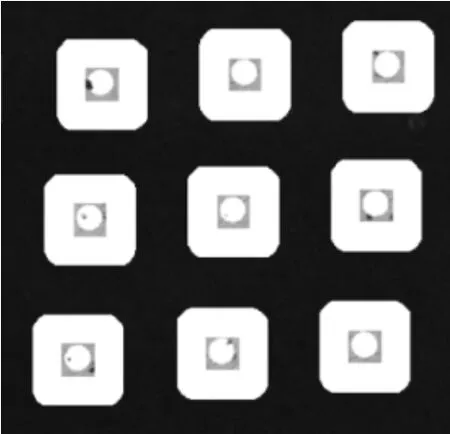

单目标模板匹配预知搜索图中最多1个目标,只需在搜索图中找到大于相似度阈值Q的最高相似度的匹配点,就可确定目标的有无及其位置。当视野内有多个目标,则不一定得出正确的结果。相似度为0.8的LED晶元的实际匹配结果如图2所示,可以看出,结果把最佳区域邻域都囊括进来了,相似度阈值Q越低,邻域越多,如果只取最高匹配,则只能找到一个目标。为此,对算法稍加改进,自标定的多目标识别分4步进行。

第1步:按照相似度阈值Q寻找符合要求的所有点。

第2步:分割目标,根据几何特征对所得的点进行分类与分割。几何特征是指欧式距离,设第1步获得k个点,第i点设置归类标记hi,初始值hi=0。用x表示横向位置,y表示纵向位置,q表示相似度,则对于搜索图S大小为M×N,模板图T为m×n的匹配,点(xi,yi,qi)和点(xj,yj,qj)的像素距离为

其中i,j=1,2,…,k;i≠j。若L(i,j)<min(m,n),则将i,j点归为同类,已经归类的点其标记置为1,即hi=1,hj=1。设分割后的总类数为Tn,则第i类的点集为

第3步:取最大相似度的点作为每类最终识别目标。即

改进后的多目标识别结果如图3所示,不再如图2那样有很多白色堆叠框,目标被准确识别出来,不存在邻域匹配的现象。

第4步:自标定由粗到精分3圈进行,根据自标定的初步结果获取目标的理论位置,取距离理论位置最近目标为最终识别对象。假定目标的理论位置为(xThe,yThe),则最优目标位置

其中i,j=1,2,…,n。最优位置和理论位置如图4所示。

4 视觉自标定

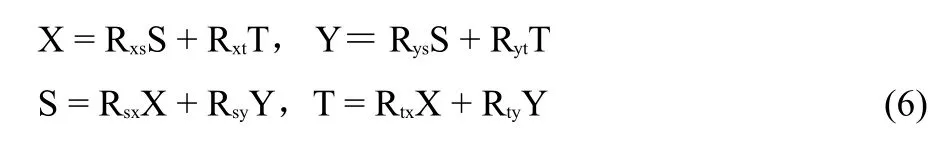

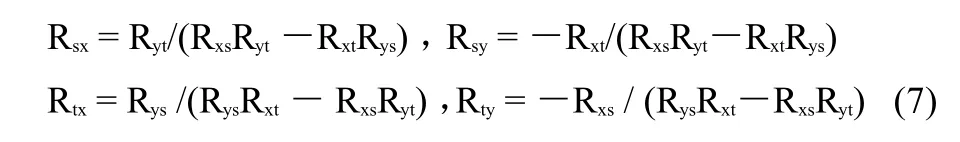

视觉自标定通过运动到不同位置自动求取向量之间的关系来反应图像坐标系和电机坐标系的映射关系,实际应用中需从图像确定平台的目标位置,也需从平台确定图像的目标位置。定义脉冲当量表示为图像移动1个像素对应的平台运动脉冲移动数,定义像素当量表示为平台运动1个脉冲对应的像素移动数。建立标定模型如图5所示,XOY为电机坐标系,SOT为图像坐标系,假定二者单位向量的映射为

图5 视觉标定运动位置

式中X、Y表示电机坐标系的单位向量,S、T表示图像坐标系的单位向量,Rxs、Rxt表示电机X方向的像素当量,Rys、Ryt表示电机Y方向的像素当量,Rsx、Rsy表示图像S方向的脉冲当量,Rtx、Rty表示图像T方向的脉冲当量。根据公式(6)求取当量之间的关系,可得

标定时,中心实线框做成模板,确保在中心开始移动。然后分别沿着X-、X+、Y-和Y+这4个方向移动一个步长,对每次移动做图像识别,计算移动后的模板位置偏移。用A(tai, sai),B(tbi,sbi),C(tci,sci),D(tdi,sdi),表示这4个位置,其中i=1,2,3。可得脉冲像素当量

按照公式(7)和(8)可求得像素当量Rxs、Rxt和Rys、Ryt。自标定遵循先粗后精的过程,运动流程如图6所示,全过程分成3圈进行,每一圈都有4个方向的移动,最后进行自动验证,防止得到错误结果。整个自标定需要设定的参数有:①P0-第1圈的起始微脉冲;②L1-第2圈的像素距离;③L2-第3圈的像素距离;④W-模板的宽;⑤H-模板的高;⑥K0-匹配相似度;⑦Le-自动校验的脉冲数。其中,W、H和K0是用户设置参数,W、H的值只能取偶数,K0能准确而快速识别目标即可,其余参数都是调试获得;P0在多目标情形时,保证第1圈不超过模板大小;L1、L2和Le不能使模板目标走出视野范围,L2越大越好。

图6 视觉标定流程图

为保证视觉自标定算法成功,必须有容错处理:①用户选择的模板区无特征导致识别失败时的处理;②工业PC控制系统中常用的PCI或USB相机易受带宽影响,会偶尔丢帧,必须进行丢帧处理;③进行图像计算位置的超行程报警处理;④标定速度不宜过大,定位延时不能太短。

5 标定实验验证

基于模板匹配的主动视觉自标定算法,是针对自动化设备的视觉平面定位系统的标定,标定实验在深圳某自动化设备有限公司的LED固晶机结构平台基础上进行,平台采用2个德国Imaging Source黑白USB相机,分辨率640×480,采用广州某公司的12轴高性能运动控制卡进行运动控制,试验平台机械结构如图7所示和视觉控制系统如图8所示。

图7 固晶平台视觉控制系统

图8 固晶平台控制方法

按照上文标定方法,视觉平面定位系统的重复定位精度尤为关键,因此依据工业机器人性能及相关测试方法的国家标准GB-T12642-2001所提供的位置准确度和重复性测试方法,对平台重复精度进行测试。首先测试模板匹配的图像识别精度,按照不同模板大小,在不同光照强度条件下,拍照间隔1秒,重复识别30次,测得图像重复识别精度为0.05像素且具备抗光照能力,表明图像识别精度对标定误差的影响非常小。为验证辨识参数的有效性和准确性,采用图像识别的像素位置和平台直线电机的光栅尺读数作为基准进行误差测量,平台的光栅尺精度为1μm。试验平台视野行程小于10mm,测试动作不超出视野内,运动时采用标准规定的低速250mm/s。位置稳定性延时根据平台结构的不同而选择设定,本测试平台的定位后延时为300ms。对平台单向和多向的不同位置重复定位30次,按照标准规定的方法计算偏差,结果如表1所示。

表1 自标定重复定位精度

由结果可知,标定算法在固晶平面定位系统中的重复定位精度为13.947μm,能满足设备的精度要求。系统辨识结果如表2所示。

表2 系统辨识结果

6 结论

本文基于图像模板匹配技术,介绍了设备主动视觉自标定的原理,给出了整个标定的运动过程和注意事项,适用于多目标的情形,并在LED固晶机的视觉平台上进行验证。结果表明,基于模板匹配的主动视觉自标定算法精度达到13.947μm,仅需辨识几个参数,避免了传统采用标定块的方法或者手动输入标定参数试验等复杂过程。一旦算法标定工艺参数调试通过,对于最终设备用户而言只需要设置模板大小和相似度即可一键标定,对模板要求低,大大简化标定过程。

[1]Tsai R Y.An efficient and accurate camera calibration technique for 3D machine vision[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition,Miami Beach,Florida,June 22-26,1986.Washington:IEEE Comput.Soc.Press,1986:364-374.

[2]Tsai R Y,Lenz R K.A new technique for fully autonomous and efficient 3D robotics hand/eye calibration[J].IEEE Transactions on Robotics and Automation(1042-296X),1989,5(3):345-358.

[3]Weng J,Cohen P,Herniou M.Camera calibration with distortion models and accuracy evaluation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence(0162-8828),1992,14(10):965-980.

[4]Zhang Y Z.Flexible camera calibration by viewing a plane from unknown orientations[C]//the Seventh IEEE International Conference on Computer Vision,Kerkyra,Greece,September 20-27,1999.Los Alamitos: IEEE Comput.Soc.,1999:666-673.

[5]Meng X Q,Li H,Hu Z Y.A new easy camera calibration technique based on circular points[C]//the 11th British Machine Vision Conference,Bristol,United Kindom,September 11-14,2000.Bristol:Univ.Bristol,2000:496-505.

[6]雷成,吴福朝,胡占义.Kruppa方程与摄像机自定标[J].自动化学报,2001,27(5):621-630.

[7]胡占义,吴福朝.基于主动视觉摄像机标定方法[J].计算机学报, 2002,25(11):1149-1156.

[8]邹广华.基于几何特征的快速模板匹配算法[D].哈尔滨:哈尔滨工业大学,2010:50-58.

[9]Di Stefano L,Mattoccia S.Fast template matching using bounded partial correlation[J].Machine Vision and Applications(0932-8092), 2003,13(4):213-221.

[10]Wei S D,Lai S H.Fast Template Matching Based on Normalized Cross Correlation With Adaptive Multilevel Winner Update[J].IEEE Transations on Image Processing(1057-7149),2008,17(11):2227-2235.

[11]Kawanishi T,Kurozumi T,Kashino K,et al.A fast template matching algorithm with adaptive skipping using inner-subtem-plates'distances[C]//The 17th International Conference on Pattern Recognition.Cambridge,England,Augest 23-26,2004.Los Alamitos:IEEE Computer Soc.,2004:654-657.

[12]Briechle K,Hanebeck U D.Template Matching using Fast Normalized Cross Correlation[C]//Conference on Optical Pattern Recognition XII,Orlando,Florida,April 19,2001.Bellingham:Spie-int Soc Optical Engineering,2001:95-102.

[13]李帅,卢荣胜,史艳琼,等.基于高斯曲面拟合的亚像素边缘检测算法[J].工具技术,2011,45(7):79-82.

Self-calibration of EquipmentActive Vision Using Template Matching

Su Ming Li DiLi Song Dong Liang

(College of Mechanical Engineering,South China Univ.of Tech.,Guangzhou 510641,Guangdong)

act】To simplify the visual positioning platform calibration process of automation equipment,reduce the reliance on the standard block and realize the automatic calibration,this paper presents a visual self-calibration method based on template matching, relying on the platform motion captured images to recognize the target of any scene,and then builds a mathematical model to calculate the calibration results;Gives the principle,process,and fault tolerance method of self-calibration,suitable for multi-objective situation.The whole process calculates the calibration results from coarse to fine points with 3 laps automatically,making calibration more practical and generalization.The proposed method is successfully applied to the LED die bonder.The results show that positioning accuracy can reach 13.947 um based on the method,which can meet the calibration requirements of the relevant equipment.

template matching;active vision;self-calibration;LED die bonder;positioning accuracy

TH744.1

:A

1008-6609(2015)03-0025-04

粟明,男,湖南怀化人,硕士研究生,研究方向:机器人及先进运动控制。

广东省科技计划项目,项目编号:2012A090100012;广东省战略性新兴产业核心技术攻关专项资金项目,项目编号:2012A010702004。