基于地铁复杂场景下异常行为的视频分析研究

2014-09-18张起贵

张起贵,张 妮

(太原理工大学信息工程学院,山西太原 030024)

近几年,由于中国城市人口数量的快速增长,加快地铁建设迫在眉睫,但伴随而来的是在地铁公共场所下乘客的安全隐患,如何快速辨识乘客异常行为,克服客观环境因素造成的影响,成为视频分析研究领域面临的一大挑战。目前,行为识别大多没有针对某一种特定场景,而且检测精度不够。常用的行为辨识法主要有模板匹配法、基于规则识别法及状态转移图模型法等,不仅计算量大,且需花大量时间训练样本库,不具有对特定场景下异常行为检测的针对性。

本文通过摄像机快速标定和鲁棒性背景建模,基于轨迹关联区域特征点的时空特性对异常行为进行表征,结合时空特性与形状特性的方法来描述这一异常行为,提出了针对晕倒这一异常行为检测模型,降低了计算量。

1 系统设计

针对地铁复杂场景下乘客的多变性行为,采用自适应混合高斯背景建模减少环境因素影响,为得到监控画面的精确度量,采用摄像机快速定标。如图1所示,利用camshift算法实时跟踪“轨迹关联”区域的特征点,“轨迹”即为在连续视频序列场景下轨迹关联区域的特征点在时间序列上的点集,反映了个体特征点在时间序列上的时空位置及运动趋势。“关联”则是针对于同一运动个体由于遮挡等问题产生的轨迹间断,根据时空模板上的时空相关性,“关联区域”即为同一运动个体在二维图像像素坐标系中提取的时空兴趣区域(轮廓、面积等),根据实际需求,选取轨迹关联区域的特征像素点对异常个体行为进行表征。

图1 异常行为辨识系统框图

2 场景建模与标定

通过统计计算运动个体轨迹集合Ti,得到地铁复杂场景下的运动轨迹区间,以此来建立上下文场景模型(见图2)。空间上下文指在地铁特定场景下某些静态设施,如地铁站进口、出口、警戒黄线、场景内遮挡物等(结合半监督方式标注)。时间上下文指在地铁正常运行时间段内,视频监控与事件相关联的各种时间约束,如列车的停靠、出发等。对象上下文指个体在运动轨迹区间,被表征的特征属性集,如速度、运动方向等。约束参数上下文指约束监测个体产生轨迹属性集中所包含的特殊参数信息。

图2 异常行为辨识系统框图

为得到真实世界个体位移信息,及时得到监控个体在轨迹区域的坐标[1],相机坐标建立如下:选定实际监控的运动轨迹区域后,其与世界坐标系完全重合,H为相机高度,β为其绕X轴角度,X轴平行于XwYw平面,Zw轴垂直于XwYw平面,两者坐标系关系为

在实际运动轨迹区间,利用真实世界坐标系的通道标记线等参考物由上式可自动获取相机内部参数a与b,设2条长度为l,l'的运动轨迹区间的标记线,其两端在像素坐标下的坐标为 (x1,y1),(x2,y2),(x3,y3),(x4,y4),世界坐标为(xw1,yw1),(xw2,yw2),(xw3,yw3),(xw4,yw4)。

3 轨迹关联区域跟踪

3.1 时空关联

在现实世界中,任何个体的运动都是时空关联的,如图3所示,设监控画面大小为m×n,视频长度为t0,在t1与t2时刻,pi与p'i分别是轨迹关联区域l×s的2个特征像素点。在连续跟踪视频帧中,若2个像素点经二值化后像素为1,则2个特征像素点是时空关联[2]。

在此基础上,将个体轨迹用Ti表征,Ti表示在轨迹关联区域各像素点特征属性集,根据实际需要,可选取其中部分特征像素点(轮廓质心等)来表征运动个体轨迹,其轨迹特征属性集为

图3 轨迹关联的camshift跟踪

式中:pi为特征像素点;pisf和pief分别为特征像素点的起始帧与终止帧;pix和piy为特征像素点的坐标;pivx和pivy分别是特征像素点在监测过程中x轴与y轴的速度分量;在某时刻ti,pisa为特征像素点在轮廓区域累积的面积;pih是特征像素点在不同色彩模式下的颜色分量;pia为各像素点时空特性在像素坐标系间的欧式距离。

3.2 camshift跟踪

在地铁监控场景下,由于建筑物的遮挡或目标运动速度过快,造成轨迹间断,如图3中的虚线,系统无法自动恢复跟踪。为提高跟踪效果,采用改进camshift算法[3-4]:

1)选取轨迹关联区域pisa为tk-1时刻运动个体轮廓面积,经过实验,在380×240视频图像中,pisa≈3 000,在tk时刻,若pisa<thresholdarea,判定目标由于遮挡丢失,此时进行全局搜索,结合相比下的联合多特征,利用帧间差分法进行轨迹填补。

可得到个体运动速度过快,需要重新调整搜索窗位置并实时跟踪,在第k+1帧时,令

4 异常个体行为建模与检测

任何复杂异常个体行为是基本个体行为模型单元的集合,即底层目标检测与跟踪不可再细分的轨迹特征点。针对地铁特定的场景下,常见异常行为主要包括:晕倒,可疑物品(超长超宽物品)携带入车站,跳跃刷卡器,乘客大量拥堵进、出口等。

本文针对因身体特殊原因或其他原因突然晕倒的异常行为进行检测,以防引起踩踏事件,及时通知管理人员采取紧急措施。通过轨迹间断、人体几何形状特征长宽比、形状复杂度及轮廓匹配度对晕倒行为进行建模[5-6],建立其轨迹属性集

1)在380×240图像像素坐标系下,对视频帧进行标定,如图4所示,采用camshift算法搜索窗中心标定运动个体轨迹关联区域特征像素点轮廓质心(picx,picy),当人体晕倒,质心发生变化,产生轨迹间断pih=null。在连续视频帧中,当监控个体的运动方向满足pic(x+i)<picx,pic(y+i)>picy或pic(x+i)>picx,pic(y+i)>picy,如图5所示,在第114,128,145,172,185 帧中,Picc值逐渐增大且 ∑picc>threshold=60时,如表1所示,则判定人体重心连续下降,其中定义人体轮廓质心picc为

图4 目标轨迹区域

图5 camshift算法连续跟踪

表1 监控个体检测数据表 像素

2)人在突然晕倒时,人体姿态发生剧烈变化,采用piawh与piscs分别度量人体几何形状特征长宽比与形状复杂度。利用Snake[7]算法提取人体轮廓,pisa与pisc分别为其轮廓面积及周长。在第k+i帧时,设hk+i与wk+i分别为该时刻人体跟踪外接矩形的高与宽,在第k帧时,其高与宽分别为hk与wk,则人体姿态变化程度为

经实验验证,如图6所示,在第114~185帧中,piscs较正常行走时姿态变化曲线出现较大波动,检测数据如表1所示,在第128帧后,piawh<threshold=1。

图6 连续视频帧piscs值

3)为排除因跌倒或其他因素干扰,提高检测准确度,通过Hausdorff算法获得人体晕倒轮廓在连续时间段内匹配度。其中Hausdorff距离[8-10]是点集间相似量度,设有2 组点集 pia={pia1,pia2,pia3,…,piam},pib={pib1,pib2,pib3,…,pibn},其定义为

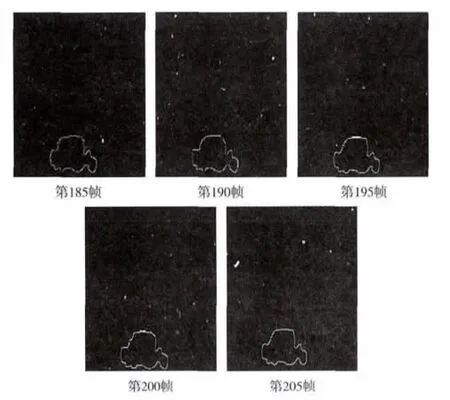

图7 所示为人体晕倒原图,取pif=185,190,195,200,205,连续提取人体轮廓边缘(见图8),本实验设定匹配阈值为10,经 Hausdorff计算获得其匹配度分别为0,2,4,1,说明此人长时间处于静止状态,判断晕倒行为已发生。经实验验证,本文对20个不同个体的晕倒行为样本进行检测,检测率为89.9%。

5 结论

针对地铁场景下的异常行为,本文详述了视频分析系统设计方案,选取轨迹关联区域的特征像素点对运动个体行为进行表征,针对地铁场景下的晕倒行为,通过轨迹属性集对晕倒个体行为进行建模与检测,经实验验证,本文所提出的算法较为实用。但在晕倒行为检测率方面还有待进一步提高。

图7 人体晕倒原图

图8 经snake处理后人体轮廓图

:

[1]钟志.基于异常行为辨识的智能监控技术研究[D].上海:上海交通大学,2008.

[2]SALIGRAMA V,KONRAD J,JODOIN P M.Video anomaly identificationa statistical approach[J].IEEE Signal Processing,2010,27(5):18-33.

[3]YANG Bo,ZHOU Hongjun,WANG Xue.Target tracking using predict Camshift[C]//Proc.the World Congress on Intelligent Control and Automation.Chongqing:IEEE Press,2008:8501-8505.

[4]ZHANG Qigui,LI Bo.Research on tracking algorithm of moving target in complex background[C]//Proc.Third International Conference on Lecture Notes in Artificial Intelligence.Taiyuan:[s.n.],2011:433-439.