目标跟踪技术综述

2014-05-16贺柏根吴笑天

高 文,朱 明,贺柏根,吴笑天

(1.中国科学院长春光学精密机械与物理研究所,吉林长春130033;

2.中国科学院航空光学成像与测量重点实验室,吉林长春130033)

1 引言

目标跟踪技术一直是计算机视觉研究领域中的热点之一,其在军事侦察、精确制导、火力打击、战场评估以及安防监控等诸多方面均有广泛的应用前景。目标的不定向运动改变了目标和场景的外观模式、非刚性目标结构、目标间及目标与场景间的遮挡、摄像机的运动等情况使目标跟踪任务变得更加困难。跟踪常应用于那些需要了解目标每帧的位置及形状的应用环境中,并常用假设来约束特定应用环境中的跟踪问题。

跟踪可简单地定义为估计物体围绕一个场景运动时在图像平面中轨迹,即一个跟踪系统给同一个视频中不同帧的跟踪目标分配相一致的标签。目标跟踪是一个颇具挑战性的问题。在计算机视觉领域目标跟踪是一项重要工作。随着高性能计算机的增多,物美价廉摄影机的普及,对自动视频分析与日俱增的需求引起人们对目标跟踪算法浓厚兴趣。

本文主要就单目标跟踪问题展开论述,目标不定向运动使跟踪目标变得困难,因为它改变了目标和场景的外观模式、非刚性目标结构、目标间及目标与场景间的遮挡。常用假设来约束特定应用中的跟踪问题,如几乎所有跟踪算法都假设物体运动是平滑不会突变的。还可以根据推理信息将物体约束为匀速或等加速运动。利用先前物体数量和大小或外观和形状知识也可简化问题。

本文将从目标跟踪的应用、目标表示法、跟踪方法研究现状、难点及趋势等方面进行展开讨论。

2 跟踪技术的应用

目标跟踪应用于以下相关工作中:

(1)智能视频监控:基于运动识别(基于步法的人类识别,自动物体检测等),自动化监测(监视一个场景以检测可疑行为);交通监视(实时收集交通数据用来指挥交通流动)。

(2)人机交互:传统人机交互是通过计算机键盘和鼠标进行的。而人们期望计算机更智能地以自然方式与人交流。实现这一目标的方式之一是使计算机具有识别和理解人的姿态、动作、手势等能力,跟踪是完成这些任务的关键一步。

(3)机器人视觉导航:视觉传感器是智能机器人一种重要的信息源,为能自主运动,智能机器人须认识和跟踪环境中的物体。在机器人手眼应用中,跟踪技术用安装在机器人手上的摄像机拍摄物体,计算其运动轨迹,选择最佳姿态抓取物体。

(4)虚拟现实:虚拟环境中3D交互和虚拟角色动作模拟直接得益于视频人体运动分析的研究成果,可给参与者提供更加丰富的交互形式。从视频中获取人体运动数据,用新的虚拟人物或具有类似关节模型的物体替换原视频中的人物,以得到意想不到的特殊效果。其关键技术是人体运动跟踪分析。

(5)医学诊断:超声波和核磁共振技术已被广泛应用于病情诊断。跟踪技术在超声波和核磁序列图像的自动分析中有广泛应用。由于超声波图像中的噪声经常会淹没单帧图像有用信息,使静态分析十分困难,如果利用序列图像中目标在几何上的连续性和时间上的相关性,则得到的结果将更加准确。

3 目标表示法

跟踪目标可被定义成任何便于进一步分析的目标,如船、鱼、车、飞机、行人等,在特定领域是一系列重要跟踪目标。首先描述跟踪常用目标形状表示法,然后描述节点形状和外观表示法。

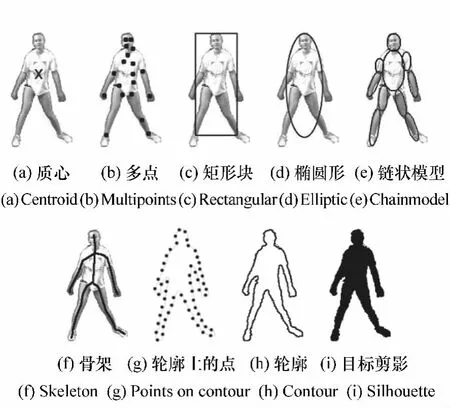

(1)点。如图1(a)质点和图1(b)多点。一般情况下,适合于图像占很小区域的目标。

(2)简单的几何形状。目标的形状用矩形、椭圆表示,如图1(c),(d)。通常用转移、仿射或投影(单应性)转换来构造这些表现形式的物体的运动模型。

图1 目标表示Fig.1 Object representations

(3)链状模型。目标由主体各部分组成,各部分通过节点连在一起。如人是腿、头、脚等由节点链在一起的物体。各部分由运动学模型支配。可用圆柱或椭圆构造表示链状物体部分模型,如图1(e)。

(4)骨骼模型。目标的骨骼可以通过对物体剪影进行中间轴转换提取出来。这种模型通常作为识别目标的一种形状表示法。见图1(f)。

(5)物体的剪影和轮廓。轮廓表示法定义了物体的边界,如图1(g),(h)。轮廓的中间区域被称作物体的剪影,见图1(i)。该法适合跟踪复杂非刚性目标。

物体外观特征有很多的表示方式,在跟踪中形状表示法也可以与外观表示法相结合。在目标跟踪环境中一些常见的外观表示法有:

(1)物体外观的概率密度。物体外观的概率密度分为参数形式(如高斯分布和高斯分布的混合形式)和非参数形式(如密度评估窗体[1]或直方图)。

(2)模板。模板由简单的几何形状或轮廓构成。模板的优势在于它可以同时包含空间和外观信息。但是模板只能编码从单一视角产生的目标外观。

(3)主动外观模型。对物体形状外观同时建模。通常由一系列标记定义。该模型要求能从一系列样本中识别形状和相应外观瞄准位,如主成分分析。

(4)多视角外观模型。该模型对物体不同视角编码。一种方法是从给定视角中产生一个子空间。另一种是通过一系列分类器(支持向量机[2]和贝叶斯网络[3])。该模型需要提前形成所有视角外观。

通常目标表示法与跟踪算法密切联系。根据应用领域选择目标表示法。对于非常小的目标适合用点表示法。文献[4]用点表示法跟踪移动盘子序列中的种子。文献[5]用点表示法跟踪遥远鸟群。简单几何形状表示法适合形状近似矩形或椭圆的目标。文献[6]用椭圆形表示法从椭圆区域计算颜色直方图来对外观建模。文献[7]用特征向量表示外观。对于复杂形状的目标(如人体),适合用轮廓或剪影表示法。文献[8]在监视应用中用剪影进行目标跟踪。

4 目标跟踪技术的研究现状

目标跟踪的目的[9]是定位目标在每帧视频图像中的位置,产生目标运动轨迹。跟踪器能得到目标在每帧中的图像区域。目标跟踪可以依据目标类型分为点目标跟踪和对于目标占有一定区域有纹理、轮廓等特征的目标跟踪两种情况,下面分别介绍,后者可分为基于特征点检测的方法、基于背景相减的帧差法、基于分割思想的方法、基于监督学习的方法及基于目标形状轮廓等特征的方法。

4.1 点目标跟踪

跟踪可以表述为不同帧中检测目标间的通信。在目标阻塞、误检测、进入和退出情况下,点通信是复杂问题。其可分为两大类:

(1)通信的确定性方法

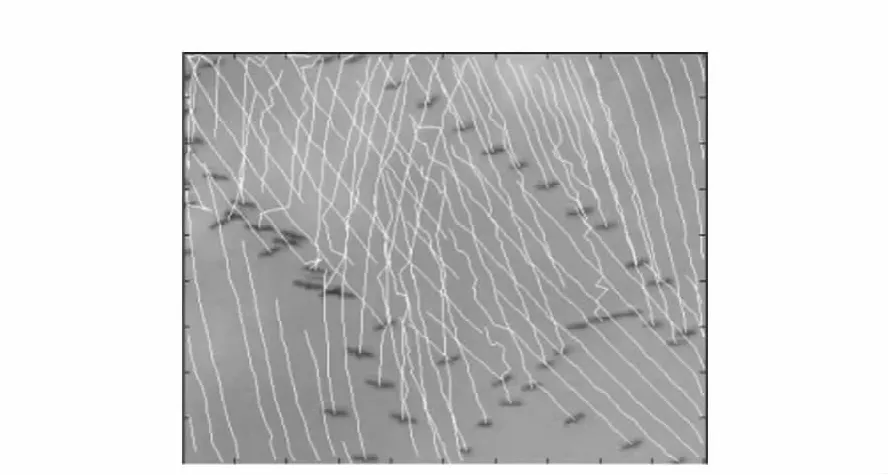

确定性方法使用定性运动启发法来约束通信问题,其定义了用运动约束将t-1帧中的目标与t帧中的目标结合起来的成本。通信成本最小化是组合优化问题。Shafique[5]提出了一种多帧方法来保持速度和位置的当前一致性,将通信表示成一个用曲线图表示的理论问题。多帧通信是为了发现到达每个点最好的唯一路径。对于误检测或阻塞目标,路径将包含相应帧的失踪位置。产生定向图表,然后通过贪婪算法建立通信。图2为此算法跟踪鸟的结果。

图2 Shafique方法跟踪鸟群Fig.2 Tracking birds using the Shafique's algorithm

(2)通信的统计学方法

概率统计方法进行目标测量,其通过在目标状态估计中考虑测量和模型不确定性来解决跟踪问题。统计学通信方法使用状态空间方法对目标性能(如位置、速度和加速度)进行建模。对于单个目标且初始状态和噪音是高斯分布,则可以用滤波器进行理想状态估算。滤波分预测和改正。如果不是线性函数,可用Taylor展开来得到扩展滤波器,从而使其线性化。当使用卡尔曼或质点滤波器跟踪多重目标时,须将特定目标最可能的测量与目标状态连接起来,即在这些滤波器应用前需解决通信问题。但是如果目标彼此距离太近,往往会导致通信不准确。联合概率数据关联(JPDAF)和多假设跟踪(MHT)是两种广泛应用于数据关联技术的方法。

4.2 基于特征点检测的目标跟踪方法

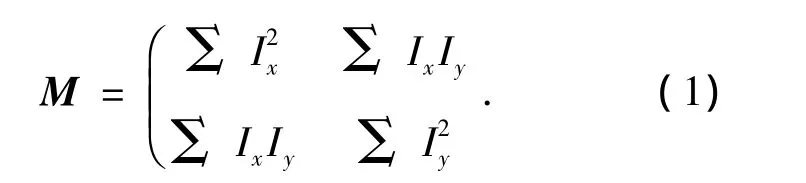

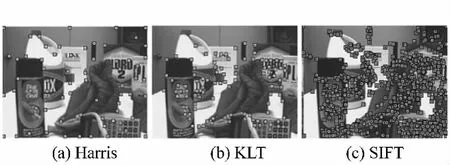

特征点在跟踪问题中已广泛使用。其特性是不随光照和照相机视角的改变而改变。常用的特征点包括 Moravec 特征[10],Harris[11],KLT[12]和SIFT[13]。

Moravec工具计算4×4区域内水平、垂直、右斜线线和左斜线方向的图像灰度差,选择4个值中的最小值作为窗口的代表值。若该值在一个12×12的区域中是局部最大值,则为特征点。

Harris计算图像水平和垂直方向的一阶导数表示各方向上的灰度差,可用一个二维矩阵M表示。

特征点可由M行列式识别,M的迹用来测量局部邻域R=del(M)-k·tr2(M)中的差值,其中k是常量。特征点通过R与指定的值进行比较得到,效果见图3(a)。方程(1)中的矩阵M在KLT跟踪方法特征点探测中也用到。特征点置信度R由M的最小特征值计算出。候选特征点通过阈值选出。KLT去掉了空间距离很近的候选点(图3(b))。本质上Harris和KLT相似都强调灰度差。Harris中R与计算M特征值的特征多项式有关,KLT直接计算特征值。实际上他们找到的特征点几乎相同,唯一不同的是KLT预先定义了被检测特征点的空间距离。理论上M矩阵对旋转和移动不变,但在仿射和投影变换中并非一成不变。

图3 感兴趣点检测Fig.3 Interest points detected by applying

考虑不同转换中特征点的稳定性,Lowe提出SIFT(尺度不变性特征)方法,分4步:首先用高斯滤波器以不同比例对图像滤波产生尺度空间,从最大和最小高斯图像中选出特征点。然后内插入邻近像素点的颜色值以更新每个候选点坐标;差别小的候选点和沿边缘的候选点被去除;最后根据候选点周围邻近区域的梯度方向直方图安排特征点方向。相对其他特征点,SIFT[14]产生更多特征点是因为其以不同比例和分辨率累加的。文献[15]表明SIFT比大部分特征点对图像变化适应性更好。

4.3 基于帧差法的目标跟踪方法

通过找出构造的背景模型中每帧差异进行跟踪。背景模型中图像区域的任何显著变化都可能是运动物体。为进一步处理,对区域中正在变化的像素点做标记,用相关联算法来获得与目标相一致的关联区域,这个过程为背景减法。Wren[16]用3D(YUV空间)高斯算法对静态背景中各像素点颜色建模。标记背景模型中偏离的像素点为显著像素点。但单高斯分布不适合用于户外场景[17],因为在某一坐标点上由于重复的物体运动、阴影或反射可能会观察到多重颜色。通过使用多统计模型来描述每个像素的背景颜色使背景模型获得很大改善。

Elgammal[18]使用无参数内核密度估计来对各像素背景建模。减法过程中当前像素点不仅与背景模型中相应像素点匹配,还和邻近像素坐标位置相匹配,可以处理背景中的照相机抖动或微小运动。

Rittscher[19]用隐式马尔科夫模型(HMM)按照像素属于背景、前景或阴影进行图像分块。Stenger[20]使用HMMs对光源时亮时暗的事物进行背景相减。HMMs优势是用训练样本获得某些用无监督背景建模方法很难精确建模的事物。

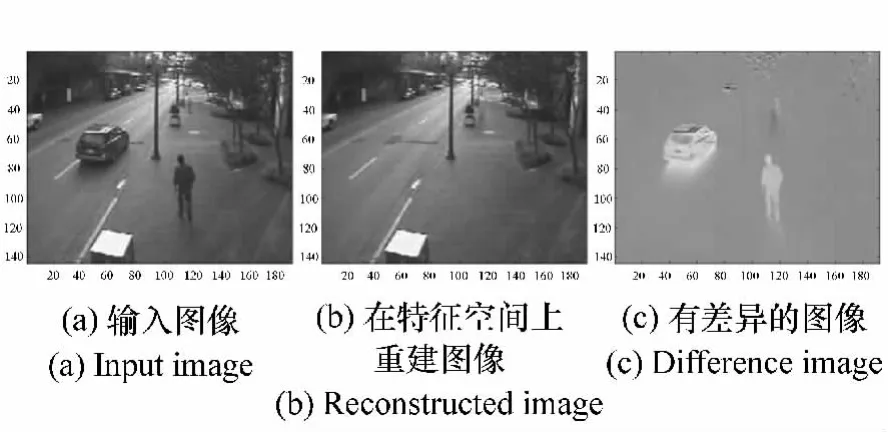

Oliver[21]不是根据单个像素的差值建模,而提出使用特征空间分解的一种整体方法。背景由特征矢量描述,实现视角(FOV)中所有可能的光照。因此,该方法对光照更不敏感。通过当前图像到特征空间并发现重建图像和实际图像的不同来检测前景目标。图4中为目标检测结果。

图4 特征空间基于分解的背景相减Fig.4 Eigenspace decomposition-based background subtraction

Monnet[22]和 Zhong[23]提出的方法可处理随时间变化的背景,其图像区域采用自回归运动平均(ARMA)进行建模,可以预测场景中的运动模式。

4.4 基于分割思想的目标跟踪方法

图像分割算法的目的是有感知地将图像分成相似的区域。每个分割算法都强调了一个好的分割标准和获得有效分割的方法。本文在这个部分将讨论近代与目标跟踪相关的分割技术。

(1)Mean-Shift聚集

对于图像分割问题,Comaniciu[24]提出 meanshift方法用以发现空间和颜色交接点的空间中的簇[l,u,v,x,y],其中[l,u,v]表示颜色,[x,y]表示空间位置。mean-shift矢量迭代计算直到簇中心的位置不再改变。在mean-shift迭代期间,一些簇可能发生合并。图5(b)为mean-shift方法分割的图像。基于分割的Mean-shift算法各参数(如颜色选择、空间内核带宽和区域最小化阈值)对分割结果有很大影响。

图5 分割结果Fig.5 Segmentation result

(2)使用Graph-Cuts的图像分割

图像分割也可表达成一个图表分割问题,通过修剪图表权重边缘将其分解成N个分离子图表(区域)。两个子图之间的修剪边缘权重总和成为切口。权重通过两个节点间的颜色、亮度或纹理相似性计算出。使用最小化切口标准实现切口最小分割方式。

最小化切口的局限性在于它的斜纹朝向图像切割的上部分。这种效果是因为随着横跨两个切割块的边缘的增加,切口的成本增加。在图5(c)展示了通过标准化切口的方法得到的分割结果。

(3)主动轮廓

该结构中,可通过将封闭轮廓演变成目标边界,将轮廓紧紧围绕目标区域,从而获得目标分割。轮廓演变由轮廓对于假定目标区域的合适性决定。

基于轮廓方法的一个重要问题是轮廓初始化;另一个是选择正确轮廓表示法。目标轮廓Γ可明确地用控制点V或含蓄地用等值面φ表示。明确表示法,控制点间的关系定义成曲线等式。含蓄法定义成等值面网格的0交叉口。含蓄法比明确法的优势是能灵活适应拓扑变化(分离和合并)。

4.5 基于监督学习的目标跟踪方法

通过监督学习方法从一系列样本中自动学习不同的物体视图,从而进行目标检测跟踪。不同的目标视图的学习不需要一个完整系列的模板。通过一系列学习样本,监督学习方法产生一个输入到输出的映射函数。对目标检测,学习样本由成对的目标特征和相关联的目标种类组成,样本数量手动定义。

特征选择在分类中起着重要作用,如面积、方向、外观和直方图等。一旦特征被选择,可通过监督学习目标的不同外观(包括神经网络[25]、自适应推进[26]、决策树[27]和支持向量机[28])计算出一个超曲面用以在高维度空间将目标类与其他类分离。

监督学习方法要求从目标种类中收集大量样本,这些样本须手动贴标签。减少手动标签量的一种方法是协同训练[29]。事实表明,从两个有独立特征的标签数据集中的一个小集合开始,协同训练可提供一个非常精确的分类原则,以减少自适应增强环境中训练时手工交互的数量[30]。下面将讨论自适应增强和支持向量机。

(1)自适应增强

增强[31]是一种迭代方法,它通过结合众多比较精确的基本分类器发现一个非常精确的分类器。在自适应增强算法训练阶段,第一步是在训练集上构造权重初始分布;然后增强设备选择一个错误最少的基本分类器,其中错误与错误分类数据的权重成比例;其次,与通过选择的基本分类器错误分类的数据相联系的权重增加。因此,这个算法鼓励在下一次迭代中选择在错误分类数据上表现更好的其他分类器。Viola[26]使用自适应增强框架检测行人。

(2)支持向量机

作为一个分类器,支持向量机(SVM)通过找到将类别区分开的最大边缘的超曲面将数据聚簇成两种类别。最大化的超曲面边缘定义成超曲面和最近数据点间的距离。在超曲面边缘的数据点称为支持矢量。在目标检测的环境中,这些种类与目标种类(真实样本)和非目标种类(底片样本)一致。从手动产生的标签训练样本作目标和非目标,通过二次规划编程计算大量超曲面。

尽管SVM是线性分类器,它也可用核方法从输入中提取输入特征矢量作为非线性分类器。Papageorgiou[28]用 SVM 检测图像中的行人和脸部。

4.6 基于目标的形状轮廓等特征的目标跟踪方法

内核跟踪是通过计算简单目标每一帧运动状态来实现的,一帧代表一个运动状态。目标的运动状态由运动参数(平移、旋转、仿射变换等)或者由后面帧的密集流场组成。从外观表示、跟踪目标的数目、估计目标运动的方法来区分内核跟踪算法的不同。从外观表示这个角度,内核跟踪算法分成:模板和基于密度的外观模型、多视角的外观模型、形状匹配和轮廓跟踪。

(1)模板和基于密度的外观模型的跟踪

由于相对简单和低计算成本,模板和基于密度的外观模型被广泛应用。根据被跟踪目标是否是单独还是联合把该跟踪方法再分成两个子类。

跟踪单目标最常用的方法是模板匹配。模板匹配是一种穷尽搜索方法。当前图像在模板中的位置用相似度测量方法(例如交叉相关)。

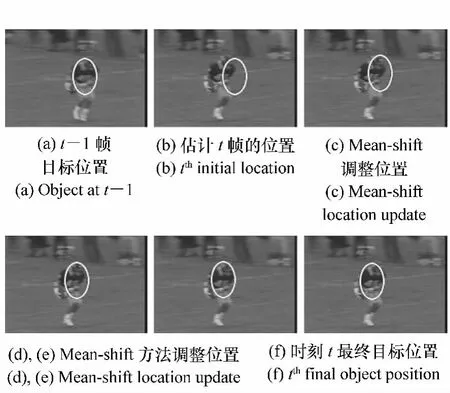

Comaniciu[6]从一个圆形区域计算出一个加权[32]直方图来表示目标。用Mean-shift方法去定位目标,通过反复对比目标直方图Q和假设目标位置窗口P来最大化外观相似性Bhattacharya系数。图6为mean-shift跟踪结果。其与标准模板匹配相比,最明显优点是未采用穷尽搜索方法而是用几次迭代方法来计算目标区域的变换。

图6 Mean-shift跟踪迭代Fig.6 Mean-shift tracking iterations

另一个跟踪简单形状区域的方法是光流法。光流法是在灰度恒定的约束条件下通过代数或者几何方法计算每个像素点的流失量用来生成密集的流场。Shi和Tomasi提出了KLT跟踪器,一旦捕捉到兴趣点的新位置,在接下来的多帧中KLT跟踪器在这个新位置的相应区域通过计算仿射变换来估计被跟踪区域的特性。如果当前区域和仿射区域的平方差总和小,将继续跟踪特征;否则特征就会被排除。

Isard[33]提出了前景和背景的联合模型跟踪。背景的外观是由混合高斯模型表示的,所有的前景目标的外观同样如此。用圆柱体为这些目标的形状建模。假设地平面是已知的,三维目标的位置可以计算出来。用粒子滤波器[34-35]中的状态向量(包括场景中所有3D目标位置、形状和运动速度)实现跟踪。他们为粒子滤波器提出了一个修正预测和校正计划方案,这个方案可以增加或减少状态向量的大小从而添加或删除目标,同时也可以忽略目标间的遮挡。但是场景中目标最大数目需预先设定,另外一个缺陷是对所有的前景目标使用同样的外观模型,因此对前景区域的建模需要培训。

(2)用多视觉的外观模型跟踪

前面介绍的跟踪方法中,外观模型如直方图、模板等通常在线生成。目标从不同角度看各不相同,如果在跟踪过程中某个目标的视角变化较大,那么它的外观模型将不再有效,跟踪可能丢失。为克服这个问题目标不同视角可离线学习并用来跟踪。

Black[7]提出了一个基于子空间的方法,用特征向量计算目标的当前图像到目标的重构图像的仿射变换。首先,用主成分分析来建立子空间上目标的外观表示。然后,用一个子空间不变方程估算利用特征向量重构的图像和原始图像的差别,计算图像到其特征方程的转换。找到子空间的系数,计算仿射参数。反复估算仿射参数,直到原始图像和预计图像之间的差别达到最小,跟踪完成。

(3)形状匹配

形状匹配方法是查找当前帧目标的轮廓和它相关联的模型,根据上一帧中生成的虚拟目标轮廓模型计算目标的相似度来完成查找,轮廓仅仅从上一帧平移到下一帧,因此并不能很精确的处理非刚性物体的运动。对于用边缘图像表示的目标模型,每帧被定位后再重新处理目标的外观变化。这种方法不仅可以克服视角变化和光照环境变化引起的跟踪问题,同时可以处理非刚性目标的运动。Li[36]提出用 Hausdorff距离来验证运动轨迹和姿态匹配问题。计算内部的虚拟轮廓来估算光流矢量,根据平均的光流失量得到目标的新的位置,这样就可以完成跟踪。

(4)轮廓跟踪

轮廓跟踪方法是相对于形状匹配方法来说的,其迭代逐步形成了前一帧中初始轮廓在当前帧中的新位置。这个轮廓逐步形成的过程要求前一帧中的目标区域和当前帧目标区域有部分重叠。轮廓跟踪用两种方法可以实现,第一种方法用卡尔曼滤波或粒子滤波实现状态空间模型对轮廓的形状和运动建模;第二种方法是直接演变轮廓,即通过直接最小化方法(如梯度下降法)来最小化轮廓能源。

图7 用水平集方法对车辆进行跟踪Fig.7 Car tracking using the level sets method

Mansouri[37]用水平集方法进行轮廓跟踪,用于半径为r的环形邻近的完整目标区域内穷尽搜索每个像素计算流失量。一旦流失量计算出来,基于恒定亮度约束的轮廓能源也被估算出来。这个过程反复进行直到轮廓能源达到最小。图7为轮廓跟踪结果。

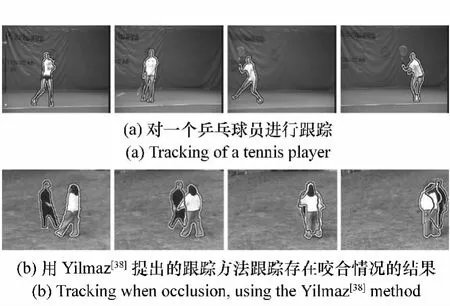

Yilmaz[38]用基于形状模型的水平集方法为目标形状和变化建模。基于形状模型的水平集解决了跟踪期间目标相互咬合遮挡的问题(图8(b))。

图8 轮廓跟踪的结果Fig.8 Contour tracking results

5 目标跟踪研究的难点及未来发展方向

近年来目标跟踪技术发展取得了很大进步[62]。研发出了多个性能优良的跟踪器,可以在简单场景中实时跟踪目标。应用假设可以使跟踪的问题简单化(如平滑的运动、少量阻塞、光照恒定性、高对比度背景等),但这些假设在现实场景中是不存在的,限制了其在自动化监控、人机交互、视频检索、交通监控、车辆导航等应用领域的应用。跟踪的难点在于:

(1)目标外观随时间而变化,如尺度变化、旋转、超平面旋转、光照变化引起的目标颜色剧烈及不均匀变化、非刚体形变、视角变化引起的外观变化等;

(2)背景复杂多变,使建模难度增加且目标容易淹没在背景中;

(3)多个目标出现咬合阻塞现象的处理;

(4)由于相机不稳、相机帧频、传感器等原因造成高速运动目标的模糊;

(5)完全遮挡或丢失后造成的时间不连续,而后目标重新出现;

发展不受约束、长期稳定的目标跟踪算法是未来的发展趋势也是挑战。因此,研究更有效的目标表示方法以及目标相似性度量方法以适应目标的外观变化是重要的研究方向。同时对于基于学习的智能算法仍需研究并引入以应对目标随时间的变化,监督学习需要大量人工干预,半监督学习近年来已被众多学者所研究并在目标跟踪方面有很高的研究和应用价值。另外,无论是基于检测思想的还是基于时间关联性跟踪的方法,对于目标的有效搜索都是一个关键问题,基于粒子滤波、均值漂移、金字塔搜索等跟踪算法仍有进一步研究的价值,同时对于其他学科中np问题的解法等也可以引入跟踪搜索,以提高算法效率和执行速度,针对特定的场景利用一些附加信息,进行上下情景信息的融合,可以使跟踪更有效。

6 结束语

本文阐述了目标跟踪的基本概念以及其应用领域与价值[39-41],详细分析了目标表示方法、目标跟踪的研究现状,最后指出了难点和趋势,相信通过众多学者的共同努力,更多鲁棒、高效、长期稳定的目标跟踪算法会不断涌现。

[1] ELGAMMAL A,DURAISWAMI R,HARWOOD D,et al..Background and foreground modeling using nonparametric kernel density estimation for visual surveillance[J].IEEE,2002,90(7):1151-1163.

[2] AVIDAN S.Support vector tracking[J].IEEE Trans.Patt.Analy.Mach.Intell.,2004,26(8):1064-1072.

[3] PARK S,AGGARWAL J K.A hierarchical bayesian network for event recognition of human actions and interactions.Multimed[J].Syst.,2004,10(2):164-179.

[4] VEENMAN C,REINDERS M,BACKER E.Resolving motion correspondence for densely moving points[J].IEEE Trans.Patt.Analy.Mach.Intell.,2001,23(1):54-72.

[5] SHAFIQUE K,SHAH M.A non-iterative greedy algorithm for multi-frame point correspondence[J].IEEE Trans.Patt.Analy.Mach.Intell.,2005,27(1):110-115.

[6] COMANICIU D,RAMESH V,MEER P.Kernel-based object tracking[J].IEEE Trans.Patt.Analy.Mach.Intell.,2003,25:564-575.

[7] BLACK M,JEPSON A.Eigentracking:robust matching and tracking of articulated objects using a view-based representation[J].Int.J.Comput.Vision,1998,26(1):63-84.

[8] HARITAOGLU I,HARWOOD D,DAVIS L.W4:real-time surveillance of people and their activities[J].IEEE Trans.Patt.Analy.Mach.Intell.,2000,22(8):809-830.

[9] 冯小勇,赵忠华,刘新明.日间恒星实时探测的视频图像处理[J].中国光学,2011,4(6):622-628.FENG X Y,ZHAO ZH H,LIU X M.Video image processing of real-time star detection in daylight[J].Chinese J.Optics,2011,4(6):622-628.(in Chinese)

[10] MORAVEC H.Visual mapping by a robot rover[C].Proceedings of the International Joint Conference on Artificial Intelligence(IJCAI),San Francisco,USA,August 20,1979:598-600.

[11] HARRIS C,STEPHENS M.A combined corner and edge detector[C].In 4th Alvey Vision Conference,August 31-September 2,1988:147-151.

[12] SHI J,TOMASI C.Good features to track[C].IEEE Conference on Computer Vision and Pattern Recognition(CVPR),Seattle,WA,June 21-32,1994:593-600.

[13] LOWE D.Distinctive image features from scale-invariant keypoints[J].Int.J.Comput.Vision,2004,60(2):91-110.

[14] 郝志成,高文.多模跟踪技术在轮式侦察车图像处理器的应用[J].中国光学,2011,4(5):480-488.

HAO ZH CH,GAO W.Application of multi-pattarn tracking technique in image processor of wheel type scout car[J].Chinese J.Optics,2011,4(5):480-488.(in Chinese)

[15] MIKOLAJCZYK K,SCHMID C.A performance evaluation of local descriptors[J].IEEE Trans.Patt.Analy.Mach.Intell.,2005,27(10):1615-1630.

[16] WREN C,AZARBAYEJANI A,PENTLAND A.Pfinder:Real-time tracking of the human body[J].IEEE Trans.Patt.Analy.Mach.Intell.,1997,19(7):780-785.

[17] GAO X,BOULT T,COETZEE F,et al..Error analysis of background adaption[C].IEEE Conference on Computer Vision and Pattern Recognition(CVPR),Hilton Head Island,SC,June 13-15,2000:503-510.

[18] ELGAMMAL A,HARWOOD D,DAVIS L.Non-parametric model for background subtraction[C].In European Conference on Computer Vision(ECCV),Dublin,Ireland,June 26-July 1,2000,2:751-767.

[19] RITTSCHER J,KATO,JOGA S,et al..A probabilistic background model for tracking[C].In European Conference on Computer Vision(ECCV),Dublin,Ireland,June 26-July 1,2000,2:336-350.

[20] STENGER B,RAMESH V,PARAGIOS N,et al..Topology free hidden markov models:application to background modeling[C].IEEE International Conference on Computer Vision(ICCV),Vancouver,BC,July 7-14,2001:294-301.

[21] OLIVER N,ROSARIO B,PENTLAND A.A bayesian computer vision system for modeling human interactions[J].IEEE Trans.Patt.Analy.Mach.Intell.,2000,22(8):831-843.

[22] MONNET A,MITTAL A,PARAGIOS N,et al..Background modeling and subtraction of dynamic scenes[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:1305-1312.

[23] ZHONG J,SCLAROFF S.Segmenting foreground objects from a dynamic textured background via a robust kalman filter[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:44-50.

[24] COMANICIU D,MEER P.Mean shift:a robust approach toward feature space analysis[J].IEEE Trans.Patt.Analy.Mach.Intell.,2002,24(5):603-619.

[25] ROWLEY H,BALUJA S,KANADE T.Neural network-based face detection[J].IEEE Trans.Patt.Analy.Mach.Intell.,1998,20(1):23-38.

[26] VIOLA P,JONES M,SNOW D.Detecting pedestrians using patterns of motion and appearance[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:734-741.

[27] GREWE L,KAK A.Interactive learning of a multi-attribute hash table classifier for fast object recognition[J].Comput.Vision Image Understand,1995,61(3):387-416.

[28] PAPAGEORGIOU C,OREN M,POGGIO T.A general framework for object detection[C].IEEE International Conference on Computer Vision(ICCV),January 4-7,1998:555-562.

[29] BLUM A,MITCHELL T.Combining labeled and unlabeled data with co-training[C].11th Annual Conference on Computational Learning Theory,July 24,1998:92-100.

[30] LEVIN A,VIOLA P,FREUND Y.Unsupervised improvement of visual detectors using co-training[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:626-633.

[31] 颜佳,吴敏渊.遮挡环境下采用在线Boosting的目标跟踪[J].光学 精密工程,2012,20(2):439-446.

YAN J,WU M Y.On-line boosting based target tracking under occlusion[J].Opt.Precision Eng.,2012,20(2):439-446.(in Chinese)

[32] 匡金骏,柴毅,熊庆宇.结合标准对冲与核函数稀疏分类的目标跟踪[J].光学 精密工程,2012,20(11):2540-2547.

KUANG J J,CHAI Y,XIONG Q Y.Visual object tracking combined normal hedge and kernel sparse representation classification[J].Opt.Precision Eng.,2012,20(11):2540-2547.(in Chinese)

[33] ISARD M,BLAKE A.Condensation-conditional density propagation for visual tracking[J].International J.Computer Vision,1998,29(1):5-28.

[34] 王国良,刘金国.基于粒子滤波的多自由度运动目标跟踪[J].光学 精密工程,2011,19(4):864-869.

WANG G L,LIU J G.Moving object tracking with multi-degree-of-freedom based on particle filters[J].Opt.Precision Eng.,2011,19(4):864-869.(in Chinese)

[35] 龚俊亮,何昕,魏仲慧,等.采用改进辅助粒子滤波的红外多目标跟踪[J].光学 精密工程,2012,20(2):413-421.

GONG J L,HE X,WEI ZH H,et al..Multiple infrared target tracking using improved auxiliary particle filter[J].Opt.Precision Eng.,2012,20(2):413-421.(in Chinese)

[36] LI B,CHELLAPPA R,ZHENG Q,et al..Model-based temporal object verification using video[J].IEEE Trans.Image Process,2001,10(6):897-908.

[37] MANSOURI A.Region tracking via level set pdes without motion computation[J].IEEE Trans.Patt.Analy.Mach.Intell.,2002,24(7):947-961.

[38] YILMAZ A,LI X,SHAH M.Contour based object tracking with occlusion handling in video acquired using mobile cameras[J].IEEE Trans.Patt.Analy.Mach.Intell.,2004,26(11):1531-1536.

[39] 丘文涛,赵建,刘杰.结合区域分割的SIFT图像匹配方法[J].液晶与显示,2012(6):827-831.

QIU W T,ZHAO J,LIU J.Image matching algorithm combining SIFT with region segmentation[J].,2012(6):827-831.(in Chinese)

[40] 王田,刘伟宁,韩广良,等.基于改进MeanShift的目标跟踪算法[J].液晶与显示,2012(3):396-400.

WANG T,LIU W N,HAN G L,et al..Target tracking algorithm based on improved meanshift[J].,2012(3):396-400.(in Chinese)

[41] 李丽,李平,杨明,等.基于SIFT特征匹配的电力设备外观异常检测方法[J].光学与光电技术,2010,8(6):25-31.

LI L,LI P,YANG M,et al..Research on abnormal appearance detection approach of electric power equipment[J].Opt.Optoelectronic Technol.,2010,8(6):25-31.(in Chinese)