基于PageRank的中文多文档文本情感摘要

2014-04-14林莉媛王中卿李寿山周国栋

林莉媛,王中卿,李寿山,周国栋

(苏州大学计算机科学与技术学院,江苏苏州215006)

1 引言

随着互联网的发展,网络上积累了海量的产品评论,这些评论表达了用户的观点和情感。这些评论可以帮助用户在购买产品时做决定,也可以帮助产品供应商对产品做出改进。然而,由于网络中存在的产品评论量太大,同时在评论中还存在大量广告等无意义的评论,使得完整的阅读与分析这么多的评论显得相当的费时费力。因此,本文提出基于多文档的文本情感摘要将这些评论进行浓缩、提炼,帮助用户消化网络上大量的观点。

文本情感摘要(Opinion Summarization)可以在很大程度上帮助用户更好的理解网络上大量的情感信息,是自然语言处理研究中的一个重要课题。文本情感摘要可以应用在很多方面。例如,对搜索引擎返回结果的支持,对问答系统的支持,对话题检测与跟踪的支持等。由于人工的抽取文本情感摘要耗时耗力,自动的文本情感摘要就成了迫切需要解决的问题。

文本情感摘要,通常指从评论语料中抽取一系列有序的能够代表评论广泛意见的句子[1-4]。借鉴主题文本摘要任务[5-6],我们将文本情感摘要看成是所有评论中句子的排序问题。与文本主题摘要不同的是,文本情感摘要不仅需要考虑所抽取句子的主题相关性,而且还需要考虑句子中是否带有情感。以前的关于文本情感摘要的研究大部分都是简单的将句子的主题和情感倾向分别打分并进行线性求和[7-8]。事实上,在评论文本中,句子间的主题与情感表达密切相关,他们之间的关系对摘要的产生有很大的影响。

在本文中,为了充分考虑评论的句子间的基于主题与基于情感的联系,我们提出了一种基于情感的PageRank框架从产品评论语料中抽取文本情感摘要。具体来讲,我们首先构建一个基于主题和情感的双层图模型,并应用PageRank算法将图模型中主题信息和情感信息有效的融合在一起,进而抽取出最有代表性的句子作为某个产品评论的文本情感摘要。一般而言,PageRank算法本身已经考虑到句子的主题相关性,因此在本文中没有特别考虑主题相关性。实验证明,我们的方法和已有的方法相比在ROUGE值上能有显著的提高。此外,针对中文的文本情感摘要的研究并未涉及。因此,为了充分的分析如何解决中文文本情感摘要问题,我们收集和标注了一个基于产品评论的中文多文档文本情感摘要语料。

本文其他部分的组织结构为:第二部分介绍了摘要的相关工作;第三部分描述了我们所收集和标注的语料;第四部分提出基于PageRank的多文档文本情感摘要方法;第五部分详细介绍了实验结果;第六部分对本文进行了总结并提出了下一步工作。

2 相关工作

自动文摘的目的在于通过机器对大规模的电子文本快速地进行浓缩、提炼,生成文章的主旨。已有的相关研究主要集中在主题的文本摘要,即文本主题摘要。该任务旨在抽取多文本中与某一固定主题相关的文本摘要。文本主题摘要的研究已经经历了很长一段时间。文献[9]中提出通过打破特征独立性的假设,使用决策树来建立句子摘要的问题模型;文献[7]中使用基于中心向量的方法给文本集中的句子排序,在排序过程中该方法使用了聚类中心、位置关系和TFIDF等特征;文献[10]给出了一种无监督的概率的方法用于建立所有文本的隐式抽象内容的模型,通过内容之间的关系生成连贯的、无冗余的摘要,基于图模型的方法也被用到了自动文摘的句子排序中;文献[11]中提出基于聚类的PageRank和HITS算法来充分利用聚类的信息给句子排序。

文本情感摘要属于情感分析研究里面的一个基本问题。然而,现有的关于情感分析的研究主要集中在文本的情感倾向分类研究上面[12-13],而对于文本情感摘要的研究还比较少。文献[14-15]通过抽取评论文本中的评价对象,评价词,评价持有者等信息来构建评论的文本情感摘要,但这种方法还是很难让用户对产品的评价有深入的理解,例如,“为什么某个方面会有较高的评分”。为了进一步帮助用户理解评论的的观点,我们需要生成简洁的文字总结,找出主要的观点、情感,这也就是文本情感摘要需要研究的任务。

文献[11]中给出了一种基于称为Opinosis的图模型,该模型通过计算图中各个节点的权值生成冗余度很低的基于理解的文本情感摘要;文献[9]根据句子的信息量和可读性对句子进行排序,然后选择和排序多个评论文本里面的句子生成摘要;文献[10]针对抽取对话语料中的文本情感摘要进行的初步研究,主要针对基于线性模型和图模型两个方式抽取对话语料的文本情感摘要;文献[16]提出了一种基于情感的PageRank模型和HITS模型用来进行挖掘与分析问题和答案两者之间的关系。

3 语料标注

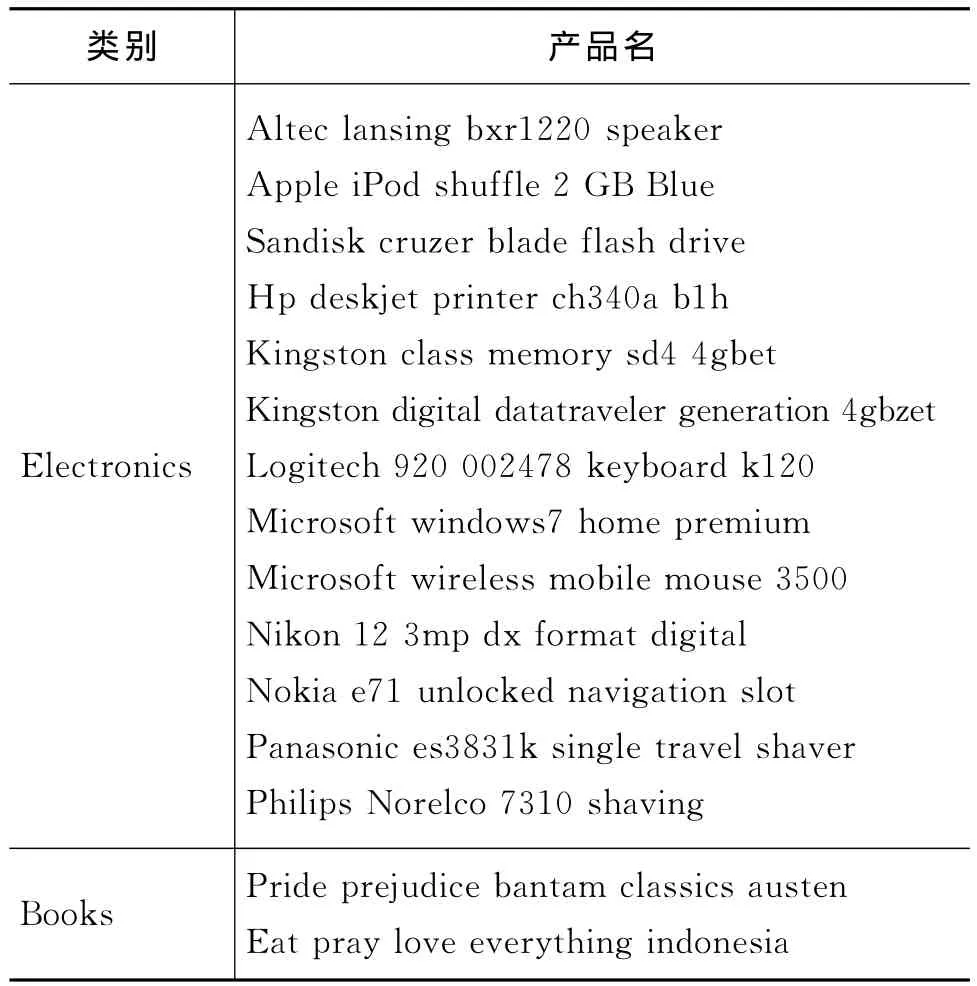

由于针对中文文本情感摘要的研究较少,公共语料缺乏,我们从亚马逊中文网①http://www.amazon.cn中收集15个主题(产品)的评论语料。表1中列出了该15种产品。每个主题包含200篇评论,其中包含褒义评论和贬义评论。在这15个主题中,每个主题平均包含12 690个单词。我们将在每个主题的200篇评论中抽取最有代表性的句子作为每个主题的文本情感摘要。

为了抽取每个主题的产品评论的文本情感摘要,我们挑选了3名标注者,从每个主题的评论中抽取4~8句的句子作为该主题的摘要。每名标注者的标注过程都是相互独立的。我们抽取的文本情感摘要的标准是选择观点和内容在整个评论中出现频率较高,且覆盖面较广的评论语句。由于我们关注的是对产品的评论,所以如果评论中出现不是对于产品本身的观点的评论将不予考虑。例如,“评论亚马逊的客服太差”,“快递很慢”等。

表1 15种产品

我们计算了这15个主题的文本情感摘要和原始文档的平均压缩比,压缩比为0.9%。

4 基于PageRank的文本情感摘要

不同于传统的文本摘要[7,14],文本情感摘要不仅仅要考虑抽取出的句子的主题相关性,同时还要考虑其中包含的情感,并且句子与句子间的主题相关性和情感并不是相互独立的,为了将情感和主题信息更好的融合到文本情感摘要中,我们提出了一种基于PageRank的文本情感摘要的方法。具体来讲,我们通过将PageRank算法应用到一个基于主题和情感的双层图模型,将主题信息和情感信息有效的融合在一起,从而抽取出最有代表性的句子作为产品的文本情感摘要。

4.1 基于PageRank的文本摘要方法

PageRank是一种被广泛应用的随机游走(Random Walk)模型[14,17-18]。在文本摘要中,该模型首先构建一张有向图表示句子之间的关系,接着利用基于图的排序算法计算每句话的排序值。排序值大的句子被认为具有代表性的句子,将被选中为文本的摘要。

设S是某个主题的所有句子的集合。我们构建一张有向图G,其中顶点集VS是集合S中的句子,边E是句子之间的关系。节点i到节点j的转移概率p(i→j)用来定义两节点之间的边的权重。表示为式(1):

其中f(i→j)为节点i和节点j之间的相似度,本文中使用余弦相似度(Cosine)[19]作为相似度计算方式,如式(2)所示:

如果两个节点的转移概率大于0,则表示这两个节点之间存在关系,为了避免自身转移我们设置f(i→j)=0。值得注意的是一般情况下p(i→j)不一定等于p(j→i)。

以图G为基础,句子si的打分c(si)可以由其他和si有关联的句子推导出,在PageRank算法中它可以以递归的方式表现出来,如式(3)所示:

在计算过程中μ是一个阻尼因子,在PageRank算法中常被设置为0.85[18]。所有句子的初始值都设为1,算法采用迭代的方式直至收敛[14]。

当迭代结束,所有句子的打分被确定后,排序值高的句子我们就认为具有较高的信息量且与主题相关度高,并选择这样的句子作为构建摘要的句子。

4.2 面向情感的PageRank文本摘要方法

我们提出一种新的基于双层图模型的PageR-ank框架用来将主题信息和情感信息融合到文本情感摘要中。在我们的双层图模型中,上层为句子间的情感联系,下层为通过基于主题的PageRank模型计算得到的句子间的主题联系。图1描述了基于双层图模型的PageRank框架。

图1 双层图模型的PageRank

上述双层图模型可以表示为图G′=〈VS,E,Θ〉,其中VS={si}代表句子集合,E={eij|si,sj∈Vs}代表句子与句子间的关系,Θ代表句子与句子间的情感联系。

我们在句子与句子间的转移概率上增加一个因子θij用来代表句子si和sj间的情感联系。因此,新的句子si和sj间的转移概率被定义为式(4):

计算句子i和j的转移概率的关键在于计算i和j的相似度f(i→j,θij),而直接计算f(i→j,θij)一般比较困难,因此我们通过扩展每个句子的特征向量的方式计算f(i→j,θij)。通常的,句子是基于Unigram或者Bigram构建其特征向量。为了加入情感因子θij,我们先判断每个句子是否带有情感,如果带有情感则为该句的特征向量加入一个opinion特征。所加入的opinion特征值λ大于0。我们通过词计数(Term-counting)的方式判断一句话是否为情感句。具体来讲,如果句子s包含情感词,我们认为该句带有情感;如果s不包含情感词时,我们认为该句没有情感。通过为情感句加入opinion特征可以使两个带有情感的句子联系更加紧密,同时两个同样极性的情感句i和j的相似度f(i→j,θij)也随之增大。在判断句子是否包含情感词时,本文使用实验室已经收集并标注好的中文情感词集,正面情感词数量为846个,负面情感词数量为809个。

5 实验结果与分析

5.1 实验设置

本文收集了15个主题的产品评论,每个主题有200篇评论,并由3人对其进行标注。语料中的每一个语句使用基于词的Unigram构建的特征向量表示。我们把人工标注的结果作为评价标准,评测的工具是ROUGE-1.5.5[19]。在以下的实验结果中,分别给出了基于ROUGE-1、ROUGE-2、ROUGE-W指标的结果。其中ROUGE-N中的N表示n元语法,ROUGE-N的值是指候选的摘要与参考的摘要集合之间的n元语法召回率。ROUGEW的含义为加权最长公共子序列。在实验中,首先比较了不同文本情感摘要方法的效果,其次分析了抽取的不同数量的句子对文本情感摘要结果的影响,最后分析情感特征opinion的特征值也即情感信息对文本情感摘要结果的影响。

5.2 实验结果

由于情感文本摘要任务还比较新,相关工作比较少。因此,本文只是和基于主题的PageRank算法及随机抽取的方法进行比较(表2)。

·Random:在每个主题中随机选择5句作为该主题的文本情感摘要,由于结果存在随机性,所报告的结果是重复20次的平均值。该Random结果作为本实验的基准系统(Baseline)。

·PageRank:传统的基于主题的PageRank算法。通常情况下,PageRank算法可以在文本摘要中获得比较好的效果。

·Bi-Rank:本文提出的融合主题和情感信息的基于双层图模型的PageRank算法。

·Human:人工抽取每个主题的文本情感摘要的结果。

表2 四种方法的实验结果

从实验结果来看,由于没有考虑句子间的主题相关性和情感信息,Random的实验效果不理想。PageRank考虑到了句子间的主题相关性,由ROUGE-1,ROUGE-2和ROUGE-W的实验结果与Random比具有明显的提升。而我们的方法中,既考虑了句子间的主题相关性又考虑句子的情感信息,实验效果比PageRank也有明显的提高并且虽然在ROUGE-2和ROUGE-W这两列中比人工标注差,但在ROUGE-1上接近了人工标注的效果。表2的结果也证实了文本中的句子不仅具有主题相关性,并且句子间的主题相关性具有一定的联系。而且在摘要中我们不能忽略情感这一重要信息。

从上面的例子可以看出,Bi-Rank抽取的句子与人工抽取的结果最相近,同时也最能表达用户的情感信息。

图3给出了opinion特征值在不同取值时的实验结果。在图3中给出当特征值达到6时,实验效果最好。在评论中人们的情感是一个很强烈的信息,我们不能忽略它在摘要中的重要作用,但是也不能只考虑情感信息。特征值6表明我们将情感信息摆在了一个重要的位置,但其在文本情感摘要方法中需结合主题信息一同起作用(即也不能让其起主导作用,特征值不能过高)。

图3 不同的特征值的实验结果

6 总结与展望

本文提出了一种新的基于情感信息的PageR-ank的方法,应用于中文的多文档文本情感摘要任务。该方法的特色在于其同时充分考虑句子之间的主题相关性和情感相关性。实验结果表明该方法取得了一定的效果,能够得到具有一定总结性的摘要。在接下去的工作中我们将收集更多其他领域的评论语料用于测试本文的方法,并且我们将考虑如何把情感信息更好的融合到PageRank中,使其效果有进一步提升。

[1] Hu M,Liu B.Mining and Summarizing Customer Reviews[C]//Proceedings of SIGKDD-04.2004.

[2] Titov I,Mc-donald R.A Joint Model of Text and Aspect Ratings for Sentiment Summarization[C]//Proceedings of ACL-08.2008.

[3] Carenini Giuseppe,Ng Raymond,Pauls Adam.Multi-Document Summarization of Evaluative Text[C]//Proceedings of EACL-06,2006:305-312.

[4] Carenini Giuseppe,Cheung Jackie Chi Kit.Extractive vs.NLG-based Abstractive Summarization of Evaluative Text:The Effect of Corpus Controversiality[C]//Proceedings of the 5th International Natural Language Generation Conference(INLG),2008:33-41.

[5] Kevin Lerman,Sasha Blair-Goldensohn,Ryan McDonald.Sentiment Summarization:Evaluating and Learning User Preferences[C]//Proceedings of EACL-09,2009:514-522.

[6] Kevin Lerman,McDonald Ryan.Contrastive Summarization:An Experiment with Consumer Reviews[C]//Proceedings of Human Language Technologies:the 2009Annual Conference of the North American Chapter of the Association for Computational Linguistics(NAACL-HLT),Companion Volume:short Papers,2009:113-116.

[7] Radev D,Jing H,Stys M,et al.Centroid-based Summarization of Multiple Documents[J].Information Processing and Management.2004(40):919-938.

[8] Wan X.Using Bilingual Information for Cross-Language Document Summarization[C]//Proceedings of ACL-11.2011.

[9] Hitoshi Nishikawa,Takaaki Hasegawa,Yoshihiro Matsuo,Genichiro Kikui.Opinion summarization with integer linear programming formulation for sentence extraction and ordering[C]//Proceedings of COLING.2010.

[10] Wang D,Liu Y.A Pilot Study of Opinion Summarization in Conversations[C]//Proceedings of ACL-11.2011.

[11] Ganesan K,Zhai C,Han J.Opinosis:A Graph-Based Approach to Abstractive Summarization of Highly Redundant Opinions[C]//Proceedings of COLING-2008.2008.

[12] Lin,C.Training a Selection Function for Extraction[C]//Proceedings of CIKM-99.1999.

[13] Celikyilmaz A,Hakkani-Tur D.Discovery of Topically Coherent Sentences for Extractive Summarization[C]//Proceedings of ACL-11.2011.

[14] Wan X,Yang J.Multi-document Summarization using Cluster-based Link Analysis[C]//Proceedings of SIGIR-08.2008.

[15] Pang B,Lee L,Vaithyanathan S.Thumbs up?Sentiment Classification using Machine Learning Techniques[C]//Proceedings of EMNLP-02.2002.

[16] Li S,Huang C,Zhou G,et al.Employing Personal/Impersonal Views in Supervised and Semi-supervised Sentiment Classification[C]//Proceedings of ACL-10.2010.

[17] Li F,Tang Y,Huang M,et al.Answering Opinion Questions with Random Walks on Graphs[C]//Proceedings of ACL-10.2010.

[18] Page L,Brin S,Motwani R,et al.The PageRank Citation Ranking:Bringing Order to the Web[J].Technical Report,Stanford Digital Libraries.1998.

[19] Baeza-Yates R,Ribeiro-Neto B.Modern Information Retrival[M].ACM Press and Addison Wesley.1999.

[20] Lin C.ROUGE:a Package for Automatic Evaluation of Summaries[C]//Proceedings of ACL-04Workshop on Text Summarization Branches Out.2004.

[21] 张瑾,王小磊,许洪波.自动文摘评价方法总述[J].中文信息学报,2008,2(3):81-88.