视觉假体图像处理中降采样算法的优化设计与评估

2013-12-05古陨吴开杰雷旭平吴昊柴新禹

【作 者】古陨,吴开杰,雷旭平,吴昊,柴新禹

上海交通大学生物医学工程学院,上海市,200240

0 引言

作为人类最为重要的感官,视觉系统为人类认识世界提供了80%以上的外界信息,因此失明是人类最严重的残障之一。以视网膜色素变性(RP)、老年黄斑变性(AMD)为代表的视网膜退行性疾病,主要是视网膜中的光感受器细胞受损伤,是目前最主要的致盲疾病[1-2],到目前为止,还缺乏有效的治疗措施。视觉假体是当今国际上对RP 和AMD 失明患者进行视觉功能修复的研究热点。它主要由外置微摄像头采集外界图像信息,通过图像处理器把图像转换为对应的电刺激模式,再由微电流刺激器将多路电脉冲加载到微电极阵列,对视觉神经系统进行电刺激,在视觉中枢产生光幻视,从而实现视觉功能修复[3-4]。视觉假体硬件系统如图1所示。

图1 视觉假体硬件系统Fig.1 The visual prosthesis hardware system

目前,至少有八个国家的二十个研究小组致力于视觉假体的研究,并涌现了多种视觉假体系统。其中,最具代表性的是Second Sight公司的Argus II型视觉假体,该产品具备60通道的刺激电极,并于2011年在欧洲通过临床测试,成为世界上首例商品化的视觉假体系统[5]。电极数量直接影响光幻视点的空间分辨率,下文中提出的分辨率均指空间分辨率。目前电极数量达到200以上的视觉假体仍在研制中,但即使微电极阵列的电极数量达到32×32,即1024电极,其诱发的光幻视点分辨率(1024像素)仍远远低于视频采集图像的分辨率(2~30万像素)。所以,降采样是视觉假体图像处理中必不可少的环节。

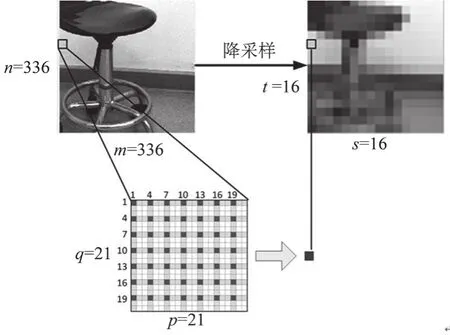

图2 对应32×32电极阵列的降采样结果Fig.2 Down-sampling result for 32×32 microelectrode array

以图2为例,左图为分辨率336×336(约11万像素)的待降采样图像,右图为对应32×32电极阵列(光幻视点分辨率1024像素)的降采样结果。降采样时将左图分割为32×32个小区块,每个区块对应右图的一个像素点,然后应用降采样算法,根据左图每个区块的图像信息计算右图对应像素点的灰度值。

近年来,国际上多个视觉假体小组在视觉假体图像处理系统研发过程中,非常注重整体系统的实时性(以最终输出帧率为衡量标准)。本文以澳大利亚新南威尔士大学(University of New South Wales,UNSW)2009和2011年的视觉假体图像处理系统[6-7],以及美国加州理工大学(California Institute of Technology,CIT)2010年的视觉假体图像处理系统为例[8],对比了不同降采样算法对系统输出帧率(frames per second,fps)的影响。

表1 降采样算法对帧率的影响Tab.1 The influence of down-sampling algorithm on frame rate

由表1分析可知,降采样环节是影响视觉假体实时性的重要因素,算法复杂度越高,系统实时性越差。目前视觉假体图像处理中应用的降采样算法一般有如下三种[9]。

(1)临近采样(Impulse Sampling)是直接选取每个区块中心像素的灰度值作为降采样值。该算法复杂度低,但丢失了区块中大部分的图像信息。

(2)区域均值(Regional Averaging)是计算每个区块中所有像素的灰度均值作为降采样值。该算法涵盖的像素信息全面,权重单一,复杂度中等。相关心理物理学研究表明,该算法处理后的图像具有较好的辨识度[10],因此区域均值法应用最为广泛。

(3)高斯加权均值(Gaussian Sampling)是在区域均值的基础上,根据每个像素与区块中心的距离d分配权重w,w=e-dˆ2/(2*σˆ2),(σ为自定义参数),由此计算加权均值作为降采样值。该算法权重复杂,复杂度高,严重影响系统的实时性。

针对以上三种降采样算法的不足,本文提出了间隔抽样均值算法,并以区域均值降采样算法为参照,统计分析了间隔抽样参数对图像处理效果和算法复杂度的影响。

1 基于间隔抽样的降采样算法优化设计

1.1 间隔抽样算法的提出

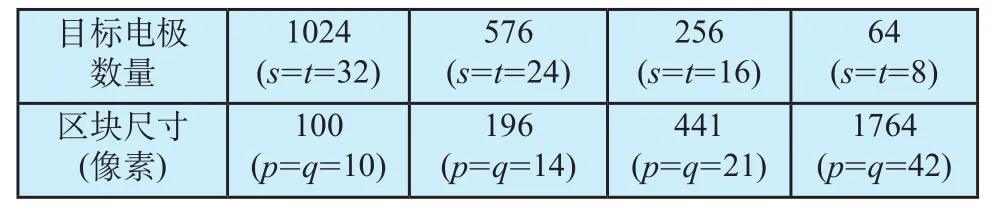

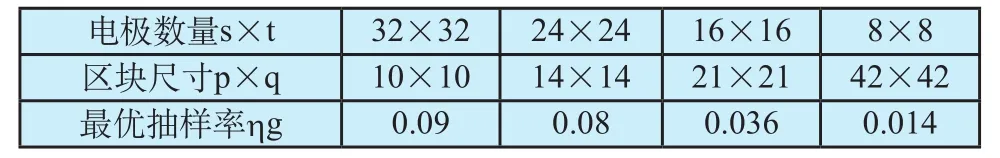

本文基于DSP开发平台,构建了视觉假体图像处理系统。该系统摄像头的分辨率为720×576,处理后得到待降采样的图像分辨率为336×336(记为m×n),灰度范围为[0,255]。目标电极数量记为s×t,分4种类型:32×32、24×24、16×16和8×8。降采样的区块尺寸记为p×q,对于不同微电极阵列,区块尺寸如表2所示:

1.2.4 术后有效咳嗽指导 ①指导患者坐在床上,上身微向前倾,双手手指交叉横压在伤口上,采用横膈呼吸,口微开,深吸气,再以两次短促的呼吸,呼出所有气体,然后维持嘴微张,快速吸一口气再用力咳嗽一两次,把痰液咳出来。②术后常规雾化吸入每日2次,持续1周。每次雾化治疗结束半小时内护理人员协助患者进行拍背咳痰。

表2 不同微电极阵列对应的降采样区块尺寸Tab.2 The block size for different microelectrode arrays

以s=t=16,p=q=21的情况为例,如使用区域均值算法进行降采样,总共要计算s×t=256个区块,每个区块要对p×q=441个点进行均值统计,算法复杂度为OR=O(p×q×s×t),运算量非常大。如使用临近采样算法,复杂度为OI=O(s×t),运算量大大降低,但处理效果不好。

如图3所示,每个的区块相对待降采样图像而言,只是很小的一部分,且区块内部的灰度变化一般不会过于剧烈。由此我们提出了间隔抽样均值算法,该方法按固定间隔对每个区块抽样后再计算灰度均值,在大幅降低算法复杂度的同时取得与区域均值算法几乎相同的图像处理效果。间隔抽样均值算法选取区块中特定行、列的交叉点作为抽样点。记抽样率为η,则算法复杂度OG=η×OR。

图3 间隔抽样算法示意图Fig.3 Schematic diagram of grid sampling algorithm

间隔抽样算法选取区块中行坐标=1+i×r,列坐标=1+j×c 的点作为抽样点,其中r表示行间隔,c表示列间隔(i,j,r,c∈Z,0≤i<[p/r],0≤j<[q/c],1≤ r ≤ p-1,1≤c≤q-1,[x]表示对x向上取整)。对于给定的r,c,抽样率η=([p/r]×[q/c])/(p×q)。图3表示了p=q=21,r=c=3时的抽样情况,区块中浅色阴影表示选定的抽样行和抽样列,深色阴影表示选定的抽样点。此时选取行列坐标均在[1,4,7,10,13,16,19]中的49个点作为抽样点,抽样率η为11%,算法复杂度OG为0.11×OR。相比区域均值法,此时降采样的运算负担降低了近90%。

1.2 间隔抽样算法的参数设计

为了分析间隔抽样参数对图像处理效果和算法复杂度的影响,对于4组不同尺寸的区块,设计了4组不同的行间隔r和列间隔c。s=t=32,p=q=10时,抽样率η设计为[0.5,0.4,0.25,0.16,0.09,0.04]。其他区块尺寸设计抽样参数时,抽样率η都尽可能与之类似,同时区块尺寸越大,抽样率η划分越细致。例如当s=t=16,p=q=21时,抽样参数设计如表3所示。

表3 间隔抽样参数设计(s=t=16,p=q=21)Tab.3 Grid sampling parameter design (s=t=16,p=q=21)

2 抽样参数对图像处理效果的影响

统计分析时,共选取了45幅生活中常见场景和物体的图像,原始分辨率都是720×576。部分原始图像如图4所示。

图4 统计分析使用的原始图像Fig.4 The image source for statistical analysis

在图像处理过程中,首先将原始图像转换为灰度图片并进行灰度增强,然后通过视野剪裁获得分辨率为336×336的图像,随后直接应用区域均值算法和间隔抽样均值算法进行降采样,得到与目标电极阵列对应的低像素图像。

对于每幅图像,以区域均值算法的降采样结果为标准,计算同一区块尺寸时不同抽样参数下,间隔抽样均值算法降采样结果的误差,记为D,则有D∈Z且|D|∈[0,255]。记某幅图像在给定区块尺寸和抽样参数下,得到的一组|D|为一组结果,则每组结果中|D|的概率分布,反映了此时间隔抽样算法处理结果与区域均值算法处理结果的接近程度。|D|的概率分布越向0集中,表示两种算法的处理结果越接近。

在统计学中,若两组数据间差异不超过5%,一般认为两组数据无显著差异。由此在本文中,若|D|≤13,即255的5%取整,则认为两算法的处理结果无显著差异。一组结果中,记某阈值为T,若|D|≤T的概率P≥0.95,则认为此时|D|集中在T以内。据此,本文提出两个参数考察|D|的概率分布。

(2)|D|P=0.95,一组结果中,|D|有95%以上概率集中在T以内的最小阈值T。该值越接近0,表示|D|的概率分布越向0集中,也就是间隔抽样均值算法的结果越接近区域均值算法的结果。

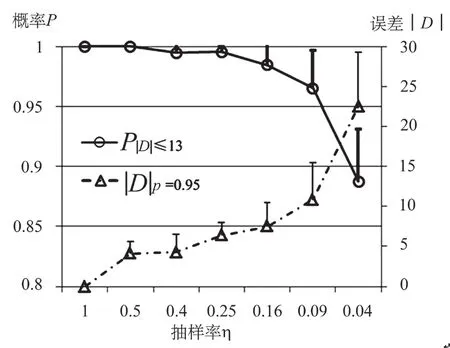

在给定区块尺寸和抽样参数下,对图像的45组结果,统计P|D|≤13和|D|P=0.95的均值和标准差。当s=t=32,p=q=10时,统计分析结果如图5所示:

图5 抽样率对P|D|≤13和|D|P=0.95的影响(s=t=32,p=q=10)Fig.5 Effect of sample rate on P|D|≤13 and |D|P=0.95 (s=t=32,p=q=10)

由图5可知,P|D|≤13与抽样率η呈正相关,|D|P=0.95与抽样率η呈负相关。抽样率η不小于0.09时,P|D|≤13的均值都在0.95以上,也就是说两算法降采样结果的误差在5%范围内的概率都不小于0.95。据此可以认为间隔抽样均值算法的降采样结果与区域均值算法相比没有显著差异。同时注意到此时,|D|P=0.95不大于10,说明|D|显著集中在4%以内,这同样证明两种算法的处理结果没有显著差异。此时,间隔抽样算法的复杂度仅为OG=0.09×OR,相比区域均值算法降低了约90%的运算负担。不同抽样率时,间隔抽样算法的降采样结果如图6所示。

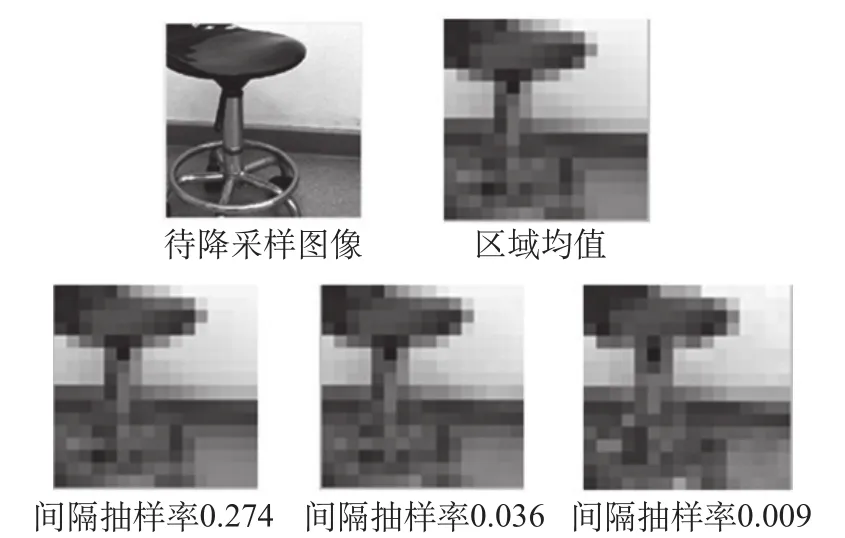

由图6可看出,抽样率η为0.25和0.09时,间隔抽样均值算法降采样的结果图与区域均值算法几乎完全相同;而抽样率η=0.04时,图中椅子支脚处和地面的处理效果与原始算法相比有明显差异。综上所述,在两算法处理效果无显著差异前提下,记最小的抽样率η为最优抽样率ηg。

图6 抽样率对降采样结果的影响(s=t=32,p=q=10))Fig.6 Effect of sample rate on down-sampling result (s=t=32,p=q=10)

对不同区块尺寸下处理结果的统计分析也有类似的结果:P|D|≤13与抽样率η呈正相关,|D|P=0.95与抽样率η呈负相关。这也就是说,抽样率越高,|D|的概率分布越向0集中,两算法的处理结果越接近。当s=t=16,p=q=21时,统计分析结果和降采样结果如图7和图8所示。

图7 抽样率对P|D|≤13和|D|P=0.95的影响(s=t=16,p=q=21)Fig.7 Effect of sample rate on P|D|≤13 and |D|P=0.95 (s=t=16,p=q=21)

图8 抽样率对降采样结果的影响(s=t=16,p=q=21))Fig.8 Effect of sample rate on down-sampling result (s=t=16,p=q=21)

由图8可知,当s=t=16,p=q=21时,最优抽样率ηg为0.036。对于4种不同的区块尺寸,最优抽样率ηg如表4所示:

表4 不同区块尺寸下的最优抽样率ηgTab.4 The optimal sample rate ηg for different block sizes

由表4可知,对于相同分辨率的待降采样图像,随着目标电极数量的减少和区块尺寸的增加,应用间隔抽样均值法的最优抽样率ηg逐渐降低,算法复杂度OG=η×OR也逐渐降低。相比区域均值算法,在处理结果无显著差异的前提下,间隔抽样均值算法至少可以降低90%的运算量。

3 总结与讨论

在视觉假体图像处理中,视频采集图像的分辨率通常远远高于光幻视点阵列的分辨率,因此降采样是视觉假体图像处理中的必要环节。对视觉假体图像处理系统的实时性分析表明,降采样环节的运算量是影响图像处理实时性的重要因素。为此,本文提出了基于间隔抽样均值的降采样算法,并以区域均值降采样算法为参照,统计分析了间隔抽样参数对降采样处理效果和算法复杂度的影响。通过研究误差|D|的概率分布,找出不同区块尺寸下的最优抽样率ηg。统计结果表明,相比区域均值算法,在处理结果无显著差异的前提下,间隔抽样均值算法至少可以降低90%的运算量。

[1]Avi Caspi,Jessy D.Dorn,Kelly H.McClure,et al.Feasibility study of a retinal prosthesis: spatial vision with a 16-electrode implant [J].Arch Ophth, 2009,127 (4): 398-401.

[2]Kichul Cha,Kenneth W.Horch,Richard A.Normann,et al.Reading speed with a pixelized vision system [J].Opt Soc of Am A,1992,9 (5): 673-677.

[3]Thomas Guenther,Nigel H Lovell,Gregg J Suaning.Bionic vision:system architectures – a review [J].Expert Rev Med Devic,2012,9(1): 33-48.

[4]Mark S.Humayun,James D.Weiland,Gildo Y.Fujii,et al.Visual perception in a blind subject with a chronic microelectronic retinal prosthesis [J].Vision Res,2003,43(24): 2573-2581.

[5]Rodrigo A.Brant Fernandes,Bruno Diniz,Ramiro Ribeiro,et al.Artificial vision through neuronal stimulation[J].Neurosci Lett,2012,519(2): 122-128.

[6]D.Tsai,J.W.Morley,G.J.Suaning,et al.A wearable real-time image processor for a vision prosthesis [J].Compu Meth Prog Bio,2009,95(3): 258-269.

[7]Paul.B.Matteucci,Philip Byrnes–Preston,Spencer C.Chen,et al.ARM-based visual processing system for prosthetic vision [J].EMBS 2011,3921-3924.

[8]Wolfgang Fink,Cindy X.You,Mark A.Tarbell.Microcomputerbased artificial vision support system for real-time image processing for camera-driven visual prostheses [J].J biomedi opt,2010,15(1): 016013.

[9]Spencer C.Chen,Gregg John W.Suaning,et al.Simulating prosthetic vision: I.Visual models of phosphenes [J].Vision Res,2009,49(12): 1493-1506.

[10]Spencer C.Chen,Luke E.Hallum,Nigel H.Lovell,et al.Visual acuity measurement of prosthetic vision: a virtual reality simulation study [J].J Neural Eng,2005,2(1): 135-145.