多摄像机场景下的目标匹配比较研究

2013-08-13陆小锋朱民耀王晓丽

戴 玥,陆小锋,朱民耀,王晓丽

(上海大学视频与空间信息学科组,上海 200072)

智能视觉监控是当今计算机领域的一个研究热点,其中的一个关键问题是实现多摄像机场景下的运动目标识别。而目标识别问题可以通过目标之间的特征匹配来解决。

常用于目标匹配中的特征主要有颜色特征、点特征、纹理特征等。经典的基于颜色直方图(Color-histogram)的目标匹配方法的基本思想是将目标之间的匹配转换为对应的直方图之间的距离相似度衡量。基于点特征的目标匹配法则是将目标匹配转换为稳定关键点的描述子之间的相似性度量。相似性度量即通过计算目标特征之间的巴氏距离、欧氏距离或者马氏距离来判定目标间的相似性。D.Comaniciu在文献[1]中采用将Color-histogram与巴氏距离相结合的方法来寻找最佳匹配目标的位置。Lowe提出了一种基于尺度空间的图像局部特征描述算子—尺度不变特征变换(Scale Invariant Feature Transform,SIFT)[2],该算法对于目标旋转、尺度缩放、亮度变化及噪声等具有较好的鲁棒性,但是计算较复杂。因此,H.Bay[3]等人在此基础上又提出了加速鲁棒特征(Speeded Up Robust Features,SURF)算法,该算法对目标的特征提取部分进行了改进,在保持良好的鲁棒性的同时又提高了运算速度。A.Alahi将Color-histogram、梯度方向直方图、SIFT和SURF等几种不同的特征相结合[4],该方法提高了目标的识别性能,但是速度降低,很难达到实时跟踪的需求。

针对现已存在的这些特征提取与匹配方法,本文将Color-histogram、SIFT和SURF这三种不同的特征分别应用于条件不同的场景视频中进行实验,通过对实验结果的比较可以分析出每种基于不同特征的匹配方法各自较适用的场景条件,为此领域的研究人员提供一种关于特征选择的参考。

1 多摄像机目标识别

多摄像机场景下的目标匹配的算法思想是:首先对视频帧图像进行背景建模,然后采用背景相减法将运动目标从场景中完整的检测出来,接着进一步提取感兴趣区域目标的特征,最后进行特征匹配,实现目标识别。

1.1 运动目标检测

背景建模是对图像中每个像素点的颜色值进行建模。每当获取到新一帧图像后需要及时更新已存在的混合高斯模型,即将当前图像中的每个像素点与混合高斯模型进行匹配,若匹配成功则判定该点为背景点,反之则为前景像素点。Zivkovic在文献[5]中提出了一种自适应的背景建模算法,该算法中图像的每一个像素点由M个高斯分布构成的混合模型来表征,它的优点在于这种混合高斯模型的分布参数会自动更新且每个像素所能选的高斯分布分量数M也会自适应地随着图像变化而变化。这种M维的混合高斯分布模型定义为

生成背景模型后,则可利用背景减除法从视频帧中提取出前景目标。本文在文献[5]的基础上,又结合了一种基于轮廓检测和最大连通域搜索的方法,先利用由OpenCV库提供的cvFindContours()函数检测出前景目标中的所有轮廓,再进一步通过搜索其中的最大连通域来滤除一些误检区域的干扰,这样就可以得到完整的感兴趣目标。

1.2 运动目标的特征提取与匹配

特征提取和匹配是目标识别的关键技术。特征提取是指通过某种特定的方法得到相应的一种图像特征[6],特征匹配即对于某种特征之间的相似度进行测量[7]。

1.2.1 Color-histogram特征提取与基于巴氏距离的匹配

Color-histogram是在许多图像检索系统中被广泛采用的颜色特征,它所描述的是不同色彩在整幅图像中所占的比例[8]。Color-histogram 对于平移、旋转、尺度变化和部分遮挡是相对不变的。通常先选择一个合适的颜色空间来描述颜色特征。由于人眼对色彩细节的分辨能力远低于对亮度细节的分辨能力,所以在进行图像处理时,通常会将彩色图像从RGB空间变换到HSV空间[9]。HSV颜色模型包括三要素:色调、饱和度和亮度。本文主要选用了其中的H和S分量,先将H和S颜色分量分别量化为Nh和Ns级,然后将由此创建出的Nh×Ns级二维直方图作为目标的Color-histogram,本文中的Nh和Ns的取值分别为16和8。此方法相比较于HSV三维直方图的准确性并未降低且大大减少了计算量。

得到归一化的直方图分布后,即可用一种客观度量法来计算它们之间的相似度。巴氏距离(Bhattacharyya distance)可以测量两离散概率分布的特性,本文选用它来计算直方图间的距离。测出的直方图距离和相似性是成反比的,距离越小,则相似性越大。一般当计算得到的距离值小于某个阈值时,就判定为匹配,本文中此阈值取0.5。巴氏距离的公式为[10]

式中:H1和H2分别为两个待匹配目标对应的归一化的直方图。

1.2.2 SIFT特征提取与基于欧氏距离的匹配

SIFT是由Lowe于1999年提出的局部特征描述子,并于2004年得到进一步的发展和完善[2]。基于SIFT特征的匹配算法同样也包括两个阶段:一是SIFT特征的提取,即从多幅图像中提取出对尺度缩放、亮度变化、旋转保持不变的特征向量;第二阶段是对于生成的SIFT特征向量进行相似性度量。SIFT特征向量的生成一般包括以下4个步骤:

1)构建尺度空间并检测出局部极值点;

2)精确确定关键点的位置和尺度,同时滤除低对比度的关键点和不稳定的边缘响应点;

3)为每个关键点分配方向值,至此每个关键点应有3个信息——位置、所处尺度和方向;

4)对每个关键点使用4×4共16个种子点来描述,而每个种子点又有8个方向向量信息,因此对于一个关键点就可以生成128维的SIFT特征向量。

当分别生成两幅图像的SIFT特征向量后,对于下一步的匹配阶段本文采用欧氏距离来度量两幅图像中关键点的相似性。欧氏距离是一个通常采用的距离定义,它是在m维空间中两个点之间的真实距离[2]。欧氏距离公式为[10]

式中:xi1表示图像1上某一点的第i维坐标,xi2表示图像2上某一点的第i维坐标。取图像1中的某个关键点,并找出其与图像2中欧式距离最近的前两个关键点,在这两个关键点中,如果最近的距离除以次近距离后所得的值小于某个比例阈值,则接受这一对匹配点。当总的匹配点对数超过一定阈值时,就认为二者匹配。本文中的比例阈值取0.49,匹配点对阈值取3。

1.2.3 SIFT特征提取与基于欧氏距离的匹配

SURF特征是一种图像的局部特征,它与SIFT特征一样,对于目标图像的旋转、尺度缩放、亮度变化也保持不变性,并且运算速度更快[3]。基于SURF特征的匹配算法的流程主要包括:特征点检测、特征点描述和特征点匹配3个部分[11]。它的整体思想流程实际上类似于SIFT特征匹配算法,主要的改进之处在于:SURF算法在建立图像的尺度空间时采用了方框滤波近似代替二阶高斯滤波,并运用了积分图像加速卷积;特征点检测部分则采用了基于Hessian矩阵的检测器,其在稳定性和可重复性方面都优于基于Harris的检测器;对于特征点的描述,选择利用Haar小波代替直方图来计算特征点的主方向并由此生成一个16×4=64维的SURF特征描述子。

2 多摄像机场景下的测试数据集

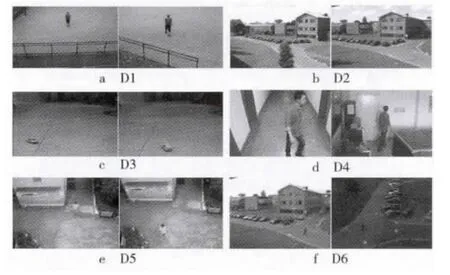

本文所选用的测试视频主要来源于PETS监控视频库和实验录制视频集。PETS是国际著名的开放监控视频库,依据实验所需仅选取了PETS2001[12]中的Dataset1和Dataset3两个视频数据集。另外的4个视频组均是根据实验所需的不同场景条件所录制。根据场景分类,视频组D3和D4为室内场景,其他视频组均为室外场景;根据视频目标分类,视频组D3中的目标是小车,其他视频组中的目标都为行人。6个视频组(用D1~D6分别表示)的具体信息如表1所示。

表1 实验所选用的6个视频数据集的相关信息

图1所示为6个视频组的实际场景。从图中可以看出,D1视频组背景简单,目标大小适中、衣着颜色鲜亮,且目标为正面朝摄像头,所以是比较理想的场景;D2视频组中目标较小且其颜色与背景色彩难以区分;D3视频组中两辆小车面对着摄像头的部分分别为车头和车尾,视角变化很大;D4视频组中的两个场景完全不同,目标人物的衣服颜色与背景颜色差别也不大,且目标间视角差异明显,分别为侧面和背面;D5视频组中虽然也存在目标视角变化,但目标的颜色却极易与背景色彩区分开;D6视频组两个视频间的光线差异相比其他的视频组则更明显。

图1 D1~D6视频组的实际场景图

3 实验结果与分析

3.1 实验环境及方法

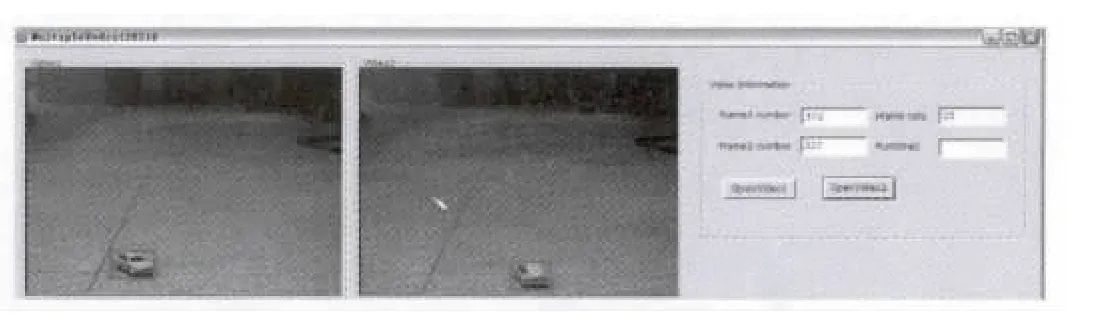

本文实验环境为CPU Intel Core i3-380M,909 MHz,1.92 Gbyte内存,软件开发工具为Windows XP操作系统,VS2008+OpenCV2.1。实验视频帧的大小为352×288,帧率为25帧/秒(f/s)。为了得到实验的比较结果,首先需要利用VS2008和OpenCV2.1在一个MFC的界面框上逐一地实现Color-histogram、SIFT和SURF这三种特征匹配法应用于多摄像机场景下的目标匹配效果,如图2所示。然后,选取6个不同的视频组,分别用Color-histogram、SIFT和SURF方法对每个视频组中的两个视频进行目标匹配实验。最后再将实验得到的数据,如目标识别率和运行时间,进行相互比较。

图2 MFC界面中的实验效果(截图)

3.2 实验结果及比较

3.2.1 同一视频组中基于不同特征的目标匹配方法的效果比较

图3是3种特征提取及匹配方法在每个视频组中的匹配效果对比图。从图中可以看出,总体的匹配效果是Color-histogram算法最佳,SIFT算法次之,最后是SURF算法。其中,D1视频组由于录制的时候选取的是比较理想的场景条件,所以3种方法的应用效果都很好。而第二个视频组中,SIFT算法的效果却优于Color-histogram算法,这是由于D2视频组中2个视频间的光线差异大、目标颜色不鲜明,Color-histogram法显然不适用于这种条件下的场景,并且因为2个视频间的视角变化微小,所以比较利于SIFT算法。D3和D5视频组中SIFT算法和SURF算法的效果相比Color-histogram算法的效果差很多,这是因为这2组视频中的目标颜色都十分鲜明但是视频间的视角变化却比较大。D4视频组的特点是目标颜色不鲜明,同时视频间的视角变化也很大,可以看出在这种情况下,相比较而言还是Color-histogram法呈现的效果更佳。

图3 同一视频组中不同特征匹配方法的效果比较

3.2.2 基于同一特征的目标匹配法应用于不同视频组时的效果比较

图4为采用同一特征匹配法时不同视频组间的效果比较。从这张图表中可以看出,对于Color-histogram算法,D2视频组由于受两视频间光线差异大且目标颜色不鲜明这两种不利因素影响而导致应用效果最差;对于SIFT算法,则是D6视频组的识别率最低;而对于SURF算法,D5视频组的效果最不好。由此可分析出,光线差异大且目标颜色不鲜明的情况最不适合采用Color-histogram算法,视角变化较大时最不适合用SIFT算法,而目标很小且视角有变化的最不适合选用SURF算法。

图4 采用同一特征匹配法时的不同视频组间的效果比较

3.2.3 不同视频组所对应的三种目标匹配方法的各自运行时间比较

表2中是三种目标匹配算法应用于不同视频组时平均每帧视频图像的运行时间,平均每帧视频图像的运行时间是由每种算法的总运行时间除以视频的总帧数所得。从中可以看出,运算速度从快到慢依次是Color-histogram,SIFT和SURF算法。由此可知,本文中SURF算法用于视频目标匹配时并未比SIFT算法的运行时间更少。

表2 不同视频组所对应的3种匹配方法的各自运行时间

综合以上的所有比较结果,可以看出:基于Color-histogram特征的目标匹配算法较适用于光线差异很小、背景简单、目标大小适中且颜色鲜明、视角变化小的场景中,而且它的运行速度比较快;而基于SIFT特征的目标匹配算法比较适用于光线差异大、背景复杂、目标颜色不鲜明且视角变化小的情况;对于视角变化较大的情况,一般选择Color-histogram特征所得到的匹配效果会更好;但对于光线差异很大的场景,基于SIFT或SURF特征的目标匹配算法通常所呈现出的匹配效果更佳。图5为实验的匹配效果图直接对比。

图5 实验效果图

4 小结

本文选取了三种较经典的特征Color-histogram,SIFT和SURF,并将它们分别应用于多摄像机场景下的目标匹配。通过对比这三种方法应用于同一组视频时的目标识别率的高低可分析出不同的特征匹配法各自较适用和不适用的场景,该研究的结论可以为此领域的其他研究提供一种关于特征选择方面的参考。在这些比较分析结果的基础上,后续还可以考虑将其中的一些特征通过某些方式进行有效地融合运用,从而实现更好的匹配效果。

[1]COMANICIU D,RAMESH V,MEER P.Real-time tracking of non-rigid objects using mean shift[C]//Proc.IEEE Conference on Computer Vision and Pattern Recognition 2002.Hilton Head Island,SC:USA,2000:142-149.

[2]LOWE D G.Distinctive image features from scale-invariant keypoints[J].Computer Vision,2004,60(2):91-110.

[3]BAY H,TUYTELAARS T,GOOL L V.Speeded-Up Robust Features(SURF)[J].Computer Vision and Image Understanding,2008(110):346-359.

[4]ALAHI A,VANDERGHEYNST P,BIERLAIRE M,et al.Cascade of descriptors to detect and track objects across any network of cameras[J].Computer Vision and Image Understanding,2010(6):624-640.

[5]ZIVKOVIC Z.Improved adaptive gaussian mixture model for background subtraction[C]//Proc.the 17th International Conference on Pattern Recognition.[S.l.]:IEEE Press,2004:28-31.

[6]蔡荣太,吴元昊,王明佳,等.视频目标跟踪算法综述[J].电视技术,2010,34(12):135-138.

[7]JEONG K,JAYNES C.Object matching in disjoint cameras using a color transfer approach[J].Machine Vision and Application,2008(19):443-455.

[8]ORAZIO T,MAZZEO P,SPAGNOLO P.Color brightness transfer function evaluation for non-overlapping multi camera tracking[C]//Proc.International Conference on Distributed Smart Cameras.Rome,Italy:[s.n.],2009:1-6.

[9]王娟,孔兵,贾巧丽.基于颜色特征的图像检索技术[J].计算机系统应用,2011,20(7):160-164.

[10]于丽莉,戴青.一种改进的SIFT特征匹配算法[J].计算机工程,2011,37(2):210-212.

[11]RUBLEE E,RABAUD E,KONOLIGE K,et al.ORB:An Effecient Alternative to SIFT or SURF[C]//Proc.International Conference on Computer Vision.Barcelona,Spain:[s.n.],2011:2564-2571.

[12]MAKRIS D.PETS2001[EB/OL].[2012-11-20].http://www.cvg.cs.rdg.ac.uk/PETS2001/pets2001-dataset.html.