基于Kinect深度图像信息的手势轨迹识别及应用

2013-07-17石曼银

石曼银

(宁德师范学院计算机系,福建宁德352100)

基于Kinect深度图像信息的手势轨迹识别及应用

石曼银

(宁德师范学院计算机系,福建宁德352100)

本文提出了一种新型的利用Kinect获取深度图像并进行手势轨迹识别的应用方法,该方法称为HMM(隐马尔可夫)手势轨迹识别方法,具体操作步骤为:首先利用Kinect传感器获取深度图像,然后通过OpenN I的手势生成器的手势分析模块获取完整的手势信息,对手部进行形态学处理,识别并跟踪手势,提取手势轨迹,最后运用HMM手势轨迹识别方法进行识别.实践证明,该方法可快速有效地实现手势轨迹的识别.

Kinect;手势轨迹识别;OpenN I;HMM;应用

手势不失为直观而自然的人机交互模式,近年来,手势识别在智能手机、虚拟键盘、智能互联网电视、体感游戏、机器人控制系统等领域得到了广泛地运用,这也是人机交互中面向社会大众面最广的一种识别方法.例如三星UA55F8000AJXXZ智能电视采用智能互动技术,让消费者的操作方式变得更加直观和简便.该智能电视可以识别更自然的手势动作,用户还可以用两手操作来实现图片的放大和缩小,以及旋转图片,也可以轻松挥手在不同的智能应用中心界面之间随意切换[1];再如业界近年来研究出的肤色信息手势识别法,也就是该技术可利用人体的肤色信息进行手部图像的获取,并对采集的手势信息进行识别处理,但该方法由于易受与肤色较近的其他颜色信号的干扰;再如HOG(梯度直方图手势识别法)解决了手势旋转与光照条件对于手势信息提取时的影响,但由于该方法计算量繁复,而且只能对数据库中事先存有的手势进行识别[2].

本文作者结合自身工作经验并查阅相关资料的基础上,采用微软公司的Kinect感应处理器采集深度图像数据,并对图像进行识别与分割处理,规避了背景、光照等外界环境对图像采集的影响,大大提高了手势识别轨迹的稳定性与系统的健壮性.作者基于Kinect获取了深度图像信息后,再使用OpenNI的手部分析系统获取手心部位,对手心点进行去抖动处理以获得开始点及结束点,追踪手势轨迹,并采用HMM系统对所追踪到的手势轨迹进行训练与识别,本文通过五个不同的手势的旋转检验了人机交互的运用效果.

1 基于Kinect手势图像信息的获取

该方式的作用机制是将手部图像与背景图像进行分离,而OpenNI为其提供的API接口可连接硬件,可与此连接的硬件包括Audio Device、3D Sensor、IR Camera、RGB Camera四种,另外,OpenNI的中间层空间主要用于追踪和识别手势,其中间层对于以下几种中间件进行了定义:(1)手部分析:只要为追踪手部位置;(2)全身分析:Kinect获取到深度图像信息后,会对周身部位的信息做出显示,如位置、角度等细节问题;(3)背景分析:对场景内的信息进行分析,包括前景分离、图像背景、坐标轴、场景内的所有物体等[3],手心位置的检测主要是通过Open CV与Open NI相结合的方法,手势的检测为事先议定好的手势,如摆手,实验时让手部位于身体的前方,五指打开,指尖朝上并正对Kinect感应器,距离维持于25-100cm之间,手部摆动的速度与幅度要维持于匀速适中的状态,直至检测到手部清晰的图像,程序接收到布尔讯号并追踪手部的位置,对手心点进行去抖动处理,对前帧检测的手心圆圈的数据进行保存,再将当前帧的数据与前帧进行对比,本次测验的阈值设定为2.4mm,若两组间数据的差异在此范围内则可继续显示前帧的手心圆圈,反之,若差异超过阈值范围以外则需重新绘制手心圆圈的位置,这样可避免手心的细微抖动[4].在对图像绘制轨迹时可能会出现无效帧或无实际意义的帧序列,这中情况多发生于手势输入时或手势输入结束时,中间帧基本有效,无效帧对于手势特征的采集而言无实际意义,且会增加运算量,降低系统的分辨力,本文对手势的开始点与结束点提出了新的判断,通过实验证明,当对手势进行输入时,系统检测到手心后即开始追踪手心点,当检测时检测到连续波动5帧的情况且范围较小时,则提示我们当前手心点处于静止点,可作为有效的手势轨迹输入的起始点,第二次则为输入结束.

2 基于隐马尔可夫模型(HMM)的手势轨迹识别

2.1 HMM隐马尔可夫模型的概述

隐马尔可夫模型(HMM)是一种用于统计分析的模型,对于信号的处理具有重要的意义.

现已成功地用于语音辨识,行为识别,文字辨识以及故障排查等领域.HMM模型包括3个概率矩阵以及2个状态集合,HMM模型的表达方法为:

2.1.1 隐含状态S:例如S1、S2、S3等等,这些状态符合隐马尔可夫的性质,是隐马尔可夫模型中实际中所隐含的状态,一般情况下,这些状态无法通过直接观测而得到.

2.1.2. 可观测状态O:例如O1、O2、O3,在HMM模型中与上述的隐含状态有关联,不同的是其可通过直接观测而得到,其可观测状态的数目不一定和隐含状态的数目一致.

2.1.3 初始状态概率矩阵π:例如t=1时,P(S1)=p1、P(S2) =P2、P(S3)=p3,则初始状态概率矩阵π=[p1,p2,p3],表示隐含状态在初始时刻t=1的概率矩阵.

2.1.4 隐含状态转移概率矩阵A:描述了HMM模型中各个状态之间的转移概率,其中Aij=P(Sj|Si),1≤i,j≤N.表示在t时刻、状态为Si的条件下,在t+1时刻状态是Sj的概率.

2.1.5 观测状态转移概率矩阵B:也叫Confusion Matrix,令N代表隐含状态数目,M代表可观测状态数目,则Bij=P (Oi|Sj),1≤i≤M,1≤j≤N,表示在t时刻、隐含状态是Sj条件下,观察状态为Oi的概率.

一般情况下用λ=(A,B,π)三元组来表示隐马尔可夫模型,隐马尔可夫模型实际上是标准马尔可夫的拓展[5],其较标准马尔可夫增加了可观测状态集合及可观测状态集合与隐含状态间的概率关系.

3 动态手势特征的选择与采集

动态手势不同于静态手势仅仅是在空间形态及位置上的变化,动态手势涉及到空间与时间上的变化,手势轨迹采集的基本特征是速度、角度与位置,即使是同一个手势,若速度不同也会造成极大的差异[6],手势识别的显著特点为手势轨迹曲线上的坐标位置的变化,考虑到即使是相同的手势,其坐标点也会有变化,在实际运用中建议采用手势轨迹的不同时刻的切线角度的变化为手势轨迹的特征[7].

4 实验结果分析

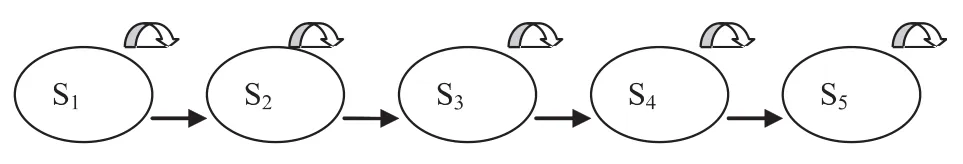

4.1 前文提及过本文通过五个不同的手势的旋转检验了人机交互的运用效果,分别为手部向左旋转、向右旋转、向上运动、向下运动及画圈五个手势.HMM手势识别实验采用由左至右的有序序列,连续多帧停留在一起,如下图所示,在建模初期每条轨迹应对应一个HMM,模型状态数的选择应尽量增加,因为状态数越多,HMM模型越能真实地反应手势轨迹,但是这也在一定程度上加大了计算量[8].

如图,由左至右无跳转HMM模型

4.2 本文分别采集了10个手势轨迹,每人将每种手势重复两次,选取其中50个手势轨迹作为检测样本,下表是5种手势的识别率,可以看出HMM具有较高的识别率.

手势轨迹向左向右向上向下画圈准确次数48 49 49 50 49识别率96%98%98%100%98%

4.3 系统健壮性检测

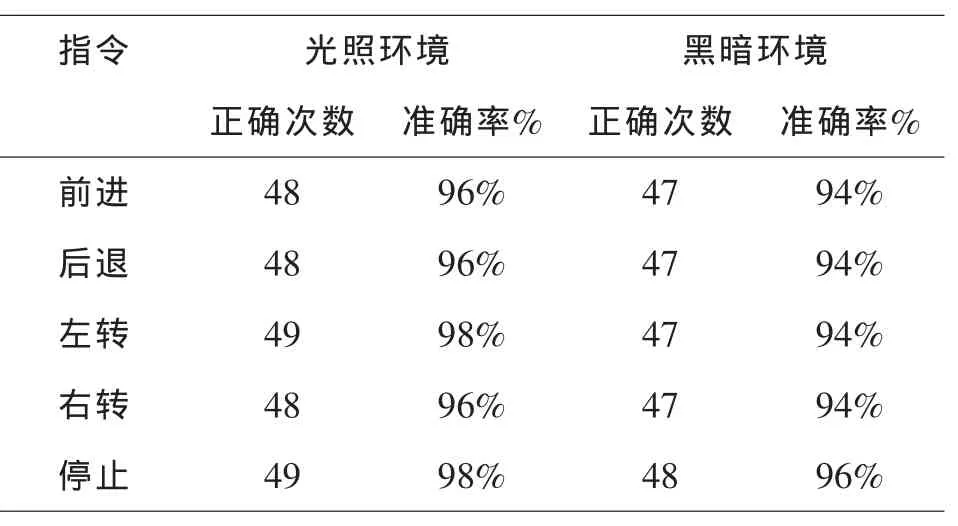

未检验本系统在不同光照下的系统健壮性,实验分别于不同光照环境下的指令分别做了50次试验,下表为在光照环境下及黑暗条件下各做50次的试验后的各自被正确识别的次数及准确率,实验结果表明,本文研究的HMM手势轨迹识别系统在应对光照变化及外界环境复杂,干扰较强的条件下的系统健壮性较高.

指令光照环境黑暗环境正确次数准确率%正确次数准确率%前进48 96%47 94%后退48 96%47 94%左转49 98%47 94%右转48 96%47 94%停止49 98%48 96%

5 结论

本文通过深度图像信息通过视频流分割手势并检测到手心点,有效地避开了光照及复杂外界条件的干扰,准确地提取到了手势轨迹的特征[9],适时引入HMM系统对手势轨迹进行识辨与判断,实验结果表明,利用Kinect获取深度图像的并进行手势轨迹识别的应用方法,即HMM(隐马尔可夫)手势轨迹识别方法具有较高的识别率,系统较为完善,但是仍存有许多有待改进的地方,如今后的实验可继续添加新的手势的变化,完善手势输入起始点的确定法,旨在进一步提高系统的健壮性,提高该系统的使用与推广价值.

〔1〕曹雏清,李瑞峰,赵立军.基于深度图像技术的手势识别方法[J].计算机工程,2012(08).

〔2〕SILANON K,SUVONVORN N.Hand motion analysis for Thai alphabet recognition using HMM[J].International Journal of Information and Electronics Engineering,2011,1(1):65-71.

〔3〕张青苗,李鹏,赵勇,何宝富,孙彧.一种基于OpenCV实现的运动目标检测算法的研究[J].舰船电子工程,2010 (07).

〔4〕孔晓明,陈一民,陈养彬,殷烨.基于视觉的动态手势识别[J].计算机工程与设计,2005(11).

〔5〕张毅,张烁,罗元,徐晓东.基于Kinect深度图像信息的手势轨迹识别及应用[J].计算机应用研究,2012(09).

〔6〕王万良,马庆,王鑫,汪晓妍.基于Kinect的高维人体动画实时合成研究[J].计算机应用与软件,2011(11).

〔7〕KAO M C,LITHS.Design and implementation of interaction system between humanoid robot and human hand gesture[C]//Proc of SICE Annual Conference.[S. l]:IEEE Press,2010:1616-1621.

〔8〕杨诚.基于视觉的动态手势识别研究[D].西北大学,2012.

〔9〕IKEMURA S,FUJIYOSHI H.Real-time human detection using relational depth sim ilarity features[C]// Proc of the 10th Asian Conference on Computer Vision,2011:25-38.

TP311.52

A

1673-260X(2013)09-0027-02