多特征融合的新型火灾图像探测方法研究

2013-01-11,,,,,

, , , , ,

(1.中国舰船研究设计中心,武汉 430064;2.中国科学技术大学 火灾科学国家重点实验室,合肥 230027)

传统感烟、感温、感光等火灾探测器存在一些固有缺陷和使用上的局限。考虑到火焰和烟雾在可见光领域具有一定的颜色、纹理和形状等图像特征[1],能够直接监测火灾图像的探测技术受到越来越多的关注。

近年来,国内外很多研究人员对火灾图像探测技术作了许多研究工作,随着火焰特征模型的不断完善,火灾图像探测技术得到不断发展[2-8]。

目前火灾图像探测技术还处于起步阶段,现有的探测技术在复杂场景中尚难以有效地去除干扰,存在一定的误报漏报情况。本文以现有的火灾图像探测技术和图像分析算法为基础,拓展了一种融合火焰图像多种特征的火灾图像探测方法,以期有效提高探测的准确率和可靠性。

1 多特征融合的火灾图像探测方法

火焰图像一般具有多种特征,如位置移动、面积变化、边缘尖角、色彩特性以及频闪脉动等。利用其中的一种或两种特征来监测火焰,实现方法较为简单,运算速度快,但容易出现漏报和误报。多特征融合的探测方法[9],就是基于火焰图像特征的多样性,以一定的步骤和算法,不断消除干扰信息,减少漏报误报,提高探测的可靠性。

1.1 疑似火焰区域检测

监控场景中多数物体在摄像机固定情况下所采集的视频序列中是静止的,而火焰则呈现运动特性。所以,首先采用运动检测提取前景运动目标,以消减监控场景中大量与火焰颜色相似的静止目标的干扰。

背景消减法是一种常用于检测图像变化和运动物体的图像处理方法,能够得到比较精确的目标图像。参考文献[7]的方法,本文使用阈值背景消减。设数字化的序列图像为fi(x,y);对于每通道的图像信号,有一稳定的基准图像,令其为fo(x,y)。系统以基准图像表示该通道的正常情况,则对于图像序列的各帧图像有

Δfi(x,y)=fi(x,y)-

(1)

图1是对图像进行背景消减运算的结果,可见阈值背景消减可以得到比较准确的目标图像,并且能够较为有效地排除电灯、装饰图案等具有火焰颜色的静止干扰因素。

1.2 图像预处理

在复杂监控环境中,天气、光线、阴影、灯光以及随机噪声等都会降低采集图像的质量,要想准确分割火焰目标,首先要利用图像预处理排除各种干扰因素影响,然后再对实时视频图像进行火焰目标的识别和提取。图像的预处理过程主要分为4步。

1)格式转换。通过视频采集设备得到的数字图像是 YUV 格式的,为分析研究火焰图像的色彩特征等信息,首先需要进行格式转换,将其转化为 RGB 格式,YcbCr 格式,以及灰度图像。

图1 经过背景消减的图像与初始图像的比较

2)图像二值化。二值化图像是在灰度图像的基础上生成的,设定一个阈值,认为灰度大于阈值的是火焰,小于阈值的是背景。二值化图像中只有两种颜色:“黑”或“白”,这样可以进一步将火焰与背景分离,为深入研究统计火焰图像的特征提供技术支撑。

3)图像过滤。图像的过滤,是抑制或消除噪声而改善图像质量的过程。本文中采用Turky 提出的中值过滤来平滑图像,抑制二值化图像中的一些无关信息,即所谓的噪声,以实现对火焰图像的比较准确的剪取。

4)火焰目标提取。通过上述步骤,实现对火焰目标比较精确的剪取。然后利用二值化图与 RGB 图像、二值化图与 YcbCr 图像、二值化图与灰度图像的位置映射关系,完成 RGB 图像、YcbCr 图像以及灰度图像中的火焰的提取。

1.3 形态特征分析

火焰图像具有独特的形态学特征[10],例如面积变化、火焰尖角等。对火焰的形态学特征进行分析研究,采用形态学特征判据,可以比较有效地消除移动车灯、行人等动态干扰因素。

1.3.1 火焰面积检测

火焰面积的检测是在图像二值化的基础上实现的。在二值化图像中,火焰显示为 1,背景显示为 0,因此可以通过对二值化的图像矩阵进行求和运算,来实现对火焰面积的计算,即

(2)

通过对火焰面积的检测,可以比较方便地判断火焰面积是否随时间变化。前后两帧图像的火焰面积的差值应满足一定条件,这个差值可以随火焰面积的变化而调整下限值。经实验分析发现,下限阈值取为 4% 时比较合理,即火焰面积的判据为

(3)

1.3.2 火焰尖角检测

不稳定火焰本身有狭而长的突起,这些狭而长的突起可以称之为火焰的尖角。火焰和其它高温物体的尖角有明显的区别,因此可以将火焰尖角作为火灾图像探测的一个重要部分 。

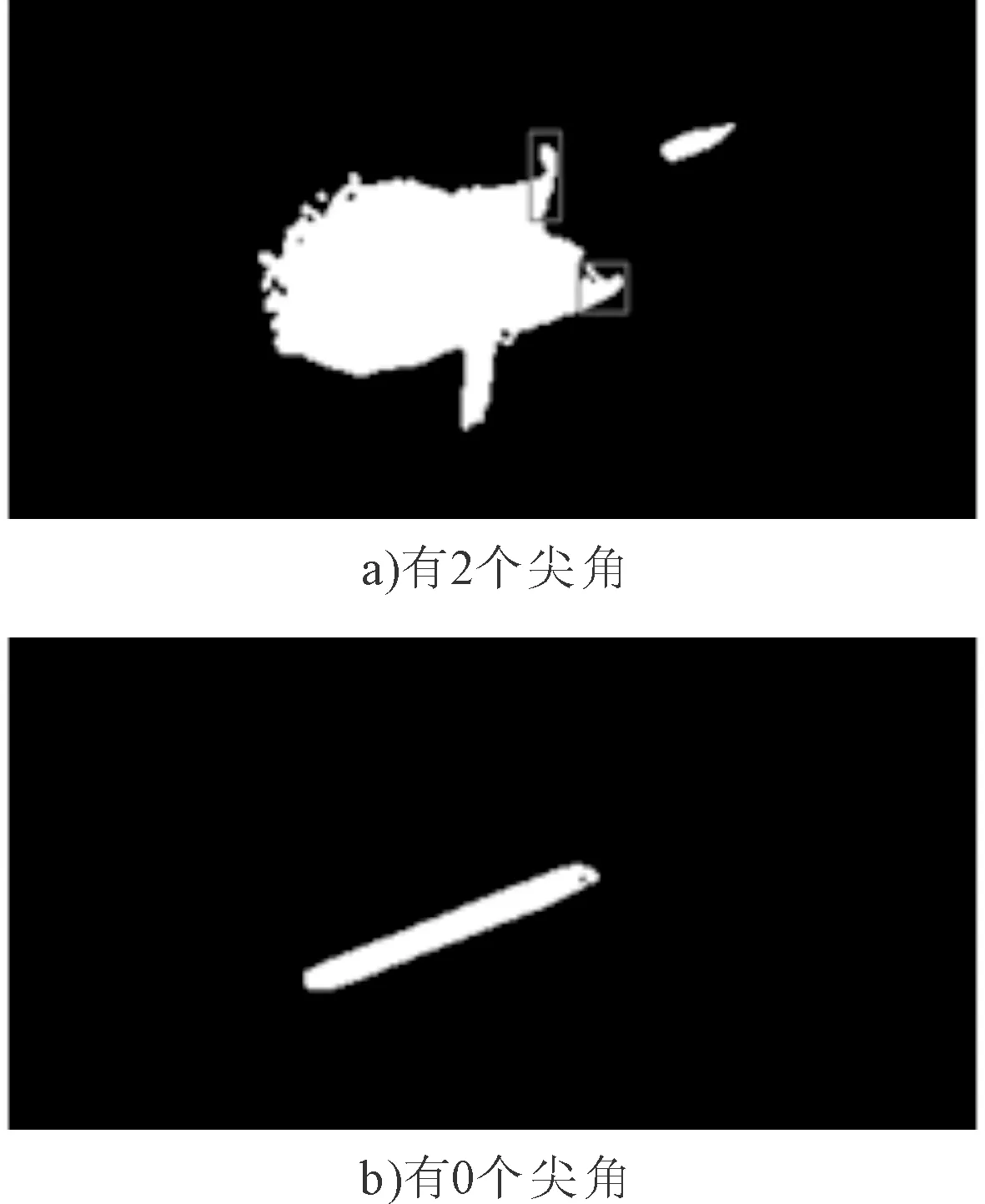

火焰尖角的检测是同样在图像二值化的基础上实现。按照一定的算法,扫描整个图像,可以初步标记图像尖角;同时尖角的形态要符合一定的标准,即尖角相邻两行相同标记的部分宽度比例满足一定条件。将满足条件的尖角标记为火焰尖角,统计尖角数量N,并记录第一个火焰尖角的顶点位置(xV,yV)。图2中的示例显示了火焰尖角的检测结果。

图2 图像的火焰尖角检测

不稳定火焰尖角的数目和位置随火焰抖动而呈现无规则的变化,文中采用火焰尖角的判据为

(4)

1.4 颜色特征分析

火焰颜色与温度、燃烧物光谱两个因素密切相关。通过对大量火焰彩色图像的分析可知,火焰目标具有强烈的视觉特征,火焰图像颜色和灰度级呈一定的分布规律[11]:火焰色调一般介于红黄之间,火焰内核呈现亮白色,向外颜色由黄变橙、到红;低温火焰颜色饱和度较高,高温下饱和度较低。因此,可以利用火焰的颜色特征,过滤运动检测所提取运动目标中不具有火焰颜色的运动目标,以便更好地识别火焰。

1.4.1 RGB颜色检测

RGB颜色模型是一种最常见的颜色模型。自然界的各种颜色光都可分解成红、绿、蓝(R,G,B)三种基本颜色光,根据三基色原理,任意颜色光的配色均可通过三基色表达。

关于火焰颜色在图像上的分布特征,前人已经进行了大量的研究统计,得到多种方式来限定火焰颜色像素的 RGB范围。本文采用以下 RGB 颜色判据:

(5)

以上颜色判据的三个公式分别代表:①火焰颜色一般比周围背景鲜亮突出,即像素的平均饱和度应大于一定阈值;②火焰比周围环境的一般物体“红”,因此红色分量应比绿色和蓝色分量着重强调,即对红色分量设定阈值;③火焰颜色分量存在内在关系,红色分量大于等于绿色分量,绿色分量又大于等于蓝色分量。

1.4.2 YCbCr颜色检测

YcbCr颜色模型是另一种常见的颜色模型。在该模型中,亮度信息被存为单一要素Y,色调信息存成不同的颜色要素Cb和Cr。Cb代表蓝色元素与参考值的差异,Cr代表红色元素与参考值的差异。通过资料显示及大量实验分析,得出火焰图像在每个基色分量下的特征分布范围,结果见表1。在YcbCr颜色检测中,亮度分量Y是其主要判据,背景的光照条件对火焰的饱和度有相反影响,可能使得干扰物具有与火焰相似的颜色值,而被误判为火焰。

表1 YCbCr颜色模型的三种颜色要素的特征值域

1.4.3 灰度分布检测

与火焰图像的颜色分布相对应,灰度图像中从焰心到外焰火焰的灰度大体呈现递减的规律。灰度分布检测需要从水平方向和竖直方向分别进行。

以水平方向上的灰度检测为例,其基本思路是:逐行扫描图像,找出每行上相应的焰心和外焰点;取横坐标差值最大的一对点进行灰度检测;从焰心到外焰点,建立直线方程,模拟其灰度值序列的发展趋势;对发展趋势进行线性拟合,以直线的斜率作为灰度判据。两个方向上灰度分布的斜率均应为负值,用公式表示为

Sv<0,Sh<0

(6)

2 系统实现与实验

通过分析火焰图像在颜色和形态上的各种特征,将各种火焰图像判据有机耦合在一起,根据每种特征的运算速度,排除干扰信息的难易程度等综合考虑,编程实现多特征融合的火灾图像探测。

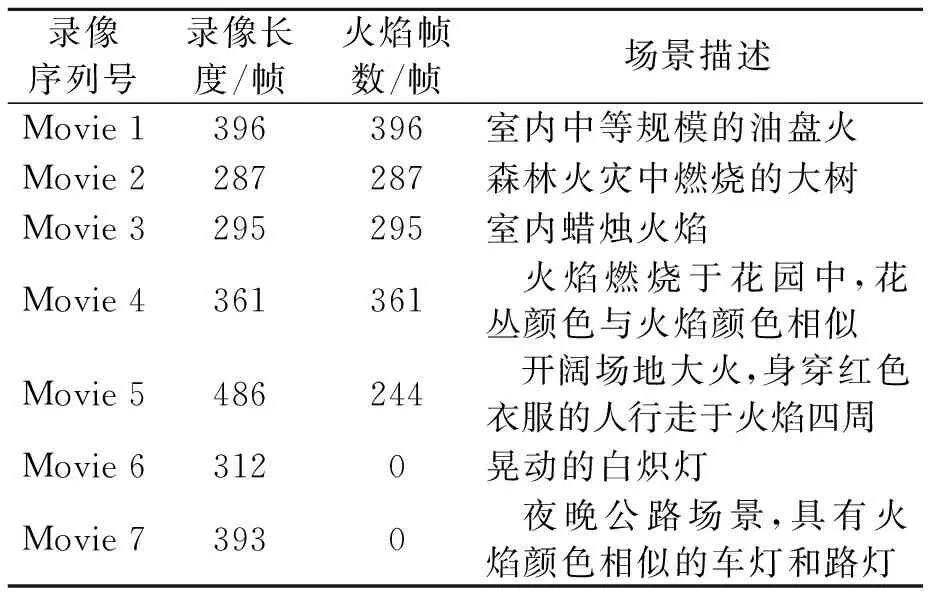

为了验证文中火灾图像探测方法的性能,采用了七组火灾视频和干扰视频进行测试,并与文献[7,12] 提出的探测方法进行对比。测试视频中包括了不同光照条件、背景复杂度以及火焰干扰的室内和室外场景。视频图像大小为 320×240 像素,采集帧率为 25 帧/s。每组测试视频的详细信息见表2。

表2 测试视频的详细信息

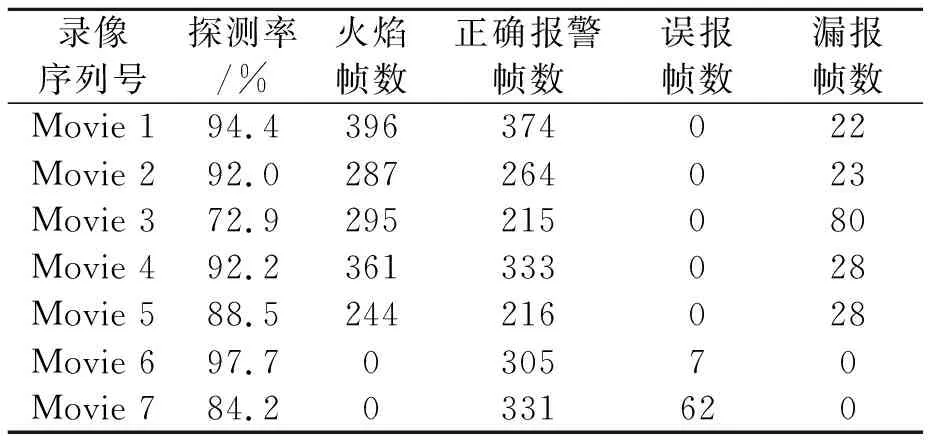

本文和文献[7]的探测方法对上述视频录像的测试结果分别列于表3和表4中。

表3 基于本文提出方法的火灾图像探测结果 帧

表4 基于文献[7]方法的火灾图像探测结果 帧

在测试结果中,当对录像某帧识别到真实火焰目标而又不误报其它非火焰目标则统计为正确报警帧数;当对录像某帧错误标记了非火焰目标则统计误报帧数;当对录像某帧具有真实火焰目标但算法没有给出报警提示则统计为漏报帧数。因此,表中的探测率是正确报警帧数除以火焰帧数,或者正确报警帧数除以录像总帧数计算得到。

通过与文献[7]的探测方法相比较,可见本文提出的探测方法对各测试场景的探测率都能达到70%以上,且很多场景的探测率能达到90%以上,说明本文所拓展的方法具有较好的场景适应性和探测可靠性。

文献[7]提出的探测方法在某些测试场景探测率很高,可以达到94.4%,而对大部分测试场景的探测率都较低。这可能有两方面的原因,一是文献[7]的探测方法主要是基于统计颜色模型,对场景的依赖性很强,会出现漏报、误报严重的问题;二是文献所述方法在某些地方解释不详细,没有说明公式经验值。本文中的程序是按照笔者的主观理解重现,两种算法的比较只是符合基本原理的比较。

3 结论

在分析火焰图像的颜色与形态学特征的基础上,拓展了一种多特征融合的火灾图像探测方法,将颜色空间、灰度分布、面积变化以及火焰尖角等多种判据有机耦合到一起,实现对火灾的快速探测。视频录像的测试结果表明,此探测方法对各测试场景的探测率都能达到70%以上,且很多场景的探测率能达到90%以上,具有较好的场景适

应性和探测可靠性。

[1] CHENG X F, WU J H, YUAN X, et al. Principles for a video fire detection system[J].Fire Safety Journal,1999,33(1):57-69.

[2] NODA S, UEDA K. Fire detection in tunnels using an image processing method[C]∥ In: Proceedings of Vehicle Navigation and Information Systems Conference, Japan,1994:57-62.

[3] CHEN T H, WU P H, CHIOU Y C. An early fire-detection method based on image processing[C]∥ Proceedings of IEEE International Conference on Image Processing, Singapore,2004:1707-1710.

[4] 吴龙标,宋卫国,卢结成.图像火灾监控中一个新颖的火灾判据[J].火灾科学,1997,6(2):60-66.

[5] CHEN T, YUAN H Y, SU G F, et al. Automatic fire searching and suppression system for large spaces[J].Fire Safety Journal,2004,39(4):297-307.

[6] LI J, FONG N K, CHOW W K, et al. The motion analysis of fire video images ba sed on moment features and flicker frequency[J].Journal of Marine Science and Application,2004,3(1):81-86.

[7] CELIK T, DEMIREL H, OZKARAMANLI H,et al. Fire Detection using Statistical Color Model in Video Sequences[J].Journal of Visual Communication & Image Representation,2007(18):176-185.

[8] ZHANG J H, ZHUANG J, DU H F, et al. A flame detection algorithm based on video multi- feature fusion[J].Lecture Notes in Computer Science,2006(4222):784-792.

[9] CHEN J, HE Y P, WANG J. Multi-feature fusion based fast video flame detection[J].Building and Environment,2010(45):1113-1122.

[10] 袁非牛,廖光煊,张永明,等.计算机视觉火灾探测中的特征提取[J].中国科学技术大学学报,2006,36(1):39-43.

[11] TOREYIN B U, DEDEOGLU Y, GUDUKBAY U, et al. Computer vision based method for real-time fire and flame detection[J].Pattern Recognition Letters,2006,27(1):49-58.

[12] CELIK T, DEMIREL H. Fire detection in video sequences using a generic color model[J].Fire Safety Journal,2009,44(2):147-158.