基于自适应多特征融合的均值迁移红外目标跟踪

2012-09-19唐林波赵保军刘嘉骏翟威龙

刘 晴 唐林波 赵保军 刘嘉骏 翟威龙

(北京理工大学信息与电子科学学院 北京 100081)

1 引言

红外序列图像中目标跟踪是视觉跟踪研究的一个热点,在智能交通、智能监控、机器人视觉导航和精确制导系统等领域有广泛的应用。相比于可见光图像,红外图像不受光照度和光影等因素影响,但信噪比低、背景杂波强以及目标信息单一,要实现稳健、高效地跟踪目标仍具挑战性[1]。在各种目标跟踪算法中,Mean Shift(MS)算法[2-4]因其实时性好,易于其他算法集成,对目标形变、旋转和遮挡有一定适应性而引起了极大的重视。

MS算法采用核函数加权的颜色直方图建模,当目标和背景相似程度较大时容易造成跟踪的不稳定,因此出现了许多改进的MS算法。文献[5]利用颜色和纹理特征表示目标,通过均值迁移和粒子滤波算法进行特征融合实现目标跟踪。文献[6]将目标的颜色特征和目标角点信息相结合,先由MS得到目标位置,然后利用仿射矩阵对目标位置和大小进行修正实现目标跟踪。文献[7]提出了基于梯度特征与颜色特征相融合的跟踪方法。首先分别提取目标的梯度特征和颜色特征,利用多尺度的相似度计算方法进行特征的匹配,然后通过最大化相似度对目标进行跟踪。但红外目标一般没有丰富的纹理、色彩信息,也缺乏突出、稳健的外形轮廓,因此本文提出一种基于自适应多特征融合的MS红外目标跟踪算法。该算法提取局部均值对比度和灰度特征进行目标建模,并根据红外图像的特点对局部均值对比度特征进行改进,提高区分目标和背景的能力;在特征融合时,为了减少计算量,分别利用目标特征建立子模型对目标进行跟踪,并引入不确定性度量特征的准确度计算多特征加权的权重,增强算法的鲁棒性;为了适应尺度变化目标的跟踪,分别提取两种尺度算子,并利用最优尺度算子进行尺度更新。

2 跟踪框架

MS算法[2]是一种半自动的跟踪算法,起始帧由人工或其他识别算法确定目标窗口,计算核函数加权的目标特征直方图分布作为目标模型,用同样的方法在第N帧计算候选目标模型,以两个分布相似性最大为原则使跟踪窗口沿直方图分布密度变化最快的方向移动,从而定位目标。MS算法有 3个基本步骤:(1)建立目标特征的核函数直方图作为目标模型;(2)测量目标模型和候选目标模型之间的相似性;(3)应用均值移位向量的迭代搜索目标的位置,实现目标跟踪。下面分别介绍这3个基本步骤。

2.1 核函数直方图建模

MS算法以目标特征的核函数加权直方图作为目标模型。设目标中心为x0,其中共有n个像素点,用{xi}i=1…n表示,则目标特征值u=1…m的概率分布为

式中k(x)为核函数的轮廓函数,h为核函数的带宽,δ[b(xi)-u]的作用是判断xi的灰度值是否属于第u个量化等级。C为归一化常数,以保证

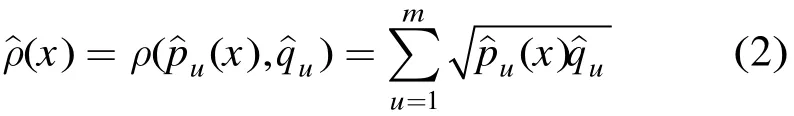

2.2 相似性度量

目标模型和候选模型之间的相似程度用相似性函数描述,MS算法中用Bhattacharyya系数作为相似性函数[8],Bhattacharyya系数定义为

其中,根号内的两项分别为候选模型的概率密度估计和目标模型概率密度估计。概率密度的估计模型即为式(1)所求得的核函数直方图模型,m为直方图柱的个数。系数取值在0~1之间,值越大,表示两个模型越相似。

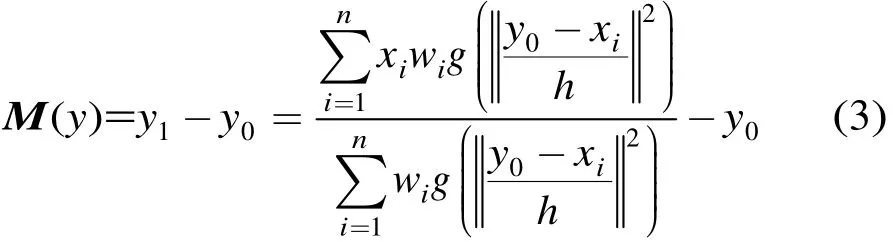

2.3 沿梯度变化最大的方向趋向目标位置

文献[9]证明了MS算法迭代过程对于目标跟踪的应用具有空域位置上的收敛性,这表明MS算法在某点的梯度方向上一定能找到与目标模板最相似的候选者。均值移位向量定义为

式中y0是第N帧搜索窗口的中心坐标,y1表示寻找到的新的搜索窗口的中心的坐标。wi为权重,h为核函数的带宽。

3 特征融合

采用单一的特征对目标进行跟踪,当该特征区分度不佳时,容易跟踪不稳定。为了增强跟踪的稳定性,越来越多的跟踪算法采用多特征对目标进行跟踪,本文根据红外图像的特点选取图像的局部均值对比度特征和灰度特征作为目标特征。

3.1 局部均值对比度特征的提取

[10]中方法,引入局部均值对比度特征作为目标的特征描述。为了适应MS算法的跟踪,对局部灰度均值对比度进行改进,并将局部灰度均值对比度图量化为m等级,得到局部均值对比度核函数直方图模型。下面介绍改进的局部均值对比度特征的提取。

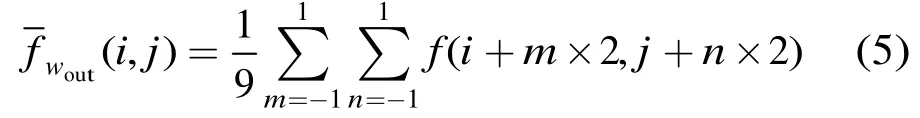

(1)以像素点为中心的 3×3邻域作为内窗口Win,对Win内的像素点求均值。Win均值的公式如下:

(2)以像素点为中心的 5×5邻域作为外窗口Wout,对Wout内的像素点求均值。为了简化计算,在Wout中25个点中抽取9个点求简化的Wout的均值。Wout均值的公式如下:

(3)局部均值对比度的公式如下:

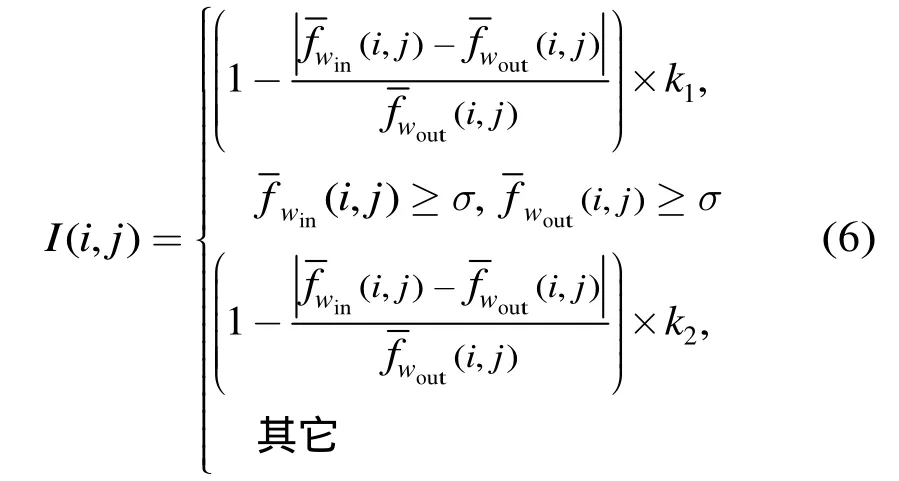

其中I(i,j)为图像的像素点,f(i,j)为局部均值对比度的值,σ为跟踪窗口内图像的均值,k1,k2为比例系数。k1,k2是根据目标的灰度值和背景的灰度值来确定的。k1为目标的灰度最大值,k2为背景的灰度均值。阈值σ为跟踪窗口内所有灰度的均值。

3.2 基于不确定性的特征融合

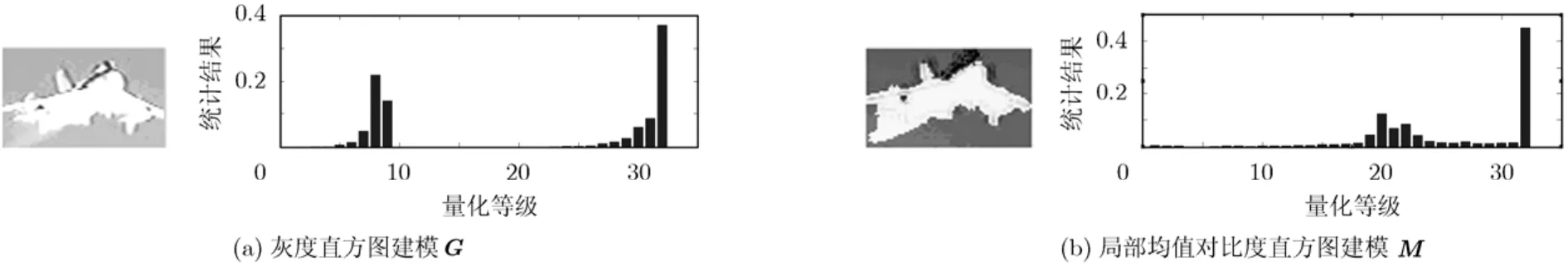

考虑到目标的多特征融合,如果直接将目标的多个特征组合在一起,那么随着特征空间维数的增加,运算量会大大增加。本文分别建立目标的灰度直方图子模型G和局部均值对比度直方图子模型M,以降低特征维数。子模型的建模示意图如图1所示。

图1 子模型的建模示意图

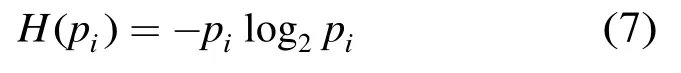

目标跟踪过程中,针对不同的场景,每种特征对目标位置估计的准确度是不一样的。Bhattacharyya系数表示候选模型和目标模型的相似度,值越大,表示两个模型越相似,也就是说该模型对目标位置估计的准确度越高。在信息论中,熵是不确定性的度量[11]:

其中pi为目标第i种特征对应的Bhattacharyya系数。H(pi)值越小,表示目标第.i.种特征对目标位置估计的准确度越高。

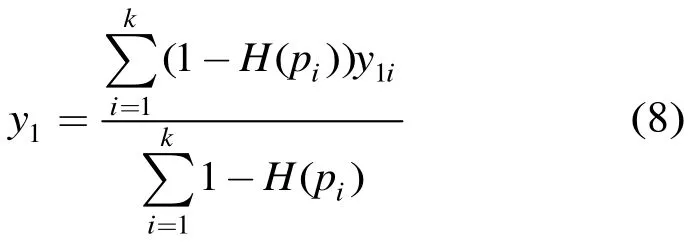

将不确定性度量引入目标融合中,对每个子模型分别运行一次MS迭代(均值移位向量),求得子模型的y1g和y1m;利用目标位置估计的不确定性对子模型的结果进行融合得到一次迭代的结果y1。在多特征融合时给每个子模型赋予一个权值,不确定性小,则赋予大的权值;反之,则赋予小的权值。多特征融合的公式如下:

其中k为子模型的个数。为了避免单个特征不确定性过大造成目标定位偏差,对特征进行判定,若H(pi)≥0.5,则认为该特征无效,不参与特征融合。

4 尺度更新

文献[6]证明了传统的MS算法采用固定的核函数带宽,当目标尺寸变化时存在跟踪不稳定的问题,当目标尺度变大时,甚至跟踪失败。为了适应尺度变化目标的跟踪,本文引入尺度更新因子对搜索窗口的尺度参数进行更新。

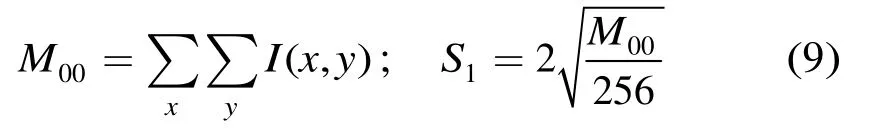

4.1 CAMShift提取尺度更新因子S1

在CAMShift算法[12]中,对图像的反投影图像,计算局部图像的零阶距,并根据局部图像的零阶距更新搜索窗口的尺度参数S1。本文直接对红外图像计算窗口内像素的零阶距,并求得尺度参数S1。计算公式如式(9)所示:

4.2 迭代投影提取尺度更新因子S2

CAMShift算法中尺度更新方法是针对人脸目标提出的,当目标的面积较小时更新效果不好,本文采用文献[13]中的迭代投影算法提取当前帧目标外阶四边形面积,近似表示目标的面积A1。设初始帧目标的面积为A0,则尺度更新因子S2定义为

4.3 最优尺度因子判决

分别利用尺度更新因子S1和S2更新跟踪窗口,按式(11)更新当前帧跟踪窗口的高度H和宽度W。在更新后的跟踪窗口内比较目标模型的相似性,得到 Bhattacharyya系数Pg1,Pm1,Pg2和Pm2,Bhattacharyya系数最大者对应的尺度算子作为最终的更新的跟踪窗口。

其中S为Bhattacharyya系数最大者。

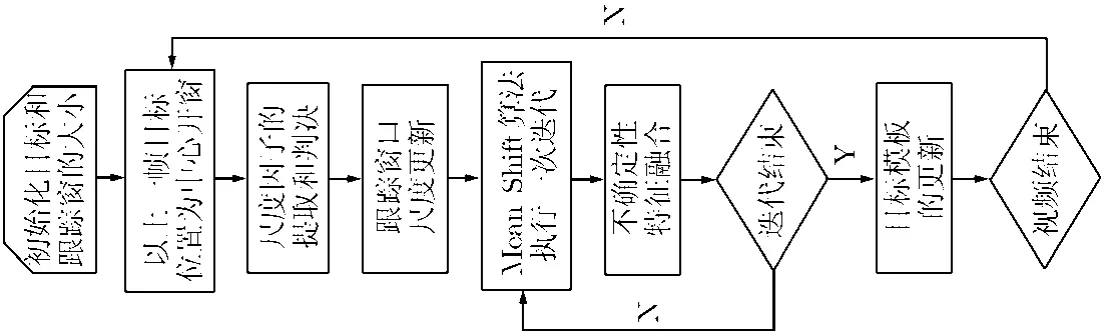

5 算法步骤

综上所述,本文提出的基于自适应多特征融合的MS目标跟踪算法步骤如下:

步骤 1 初始化跟踪目标的位置和跟踪窗的大小,并按式(1)提取该目标的特征直方图子模型G和M,令y0为该目标的中心位置。

步骤 2 以上一帧图像得到的位置为中心开窗;

步骤 3 提取跟踪窗口的尺度更新因子,对跟踪窗口进行尺度更新;

步骤 4 在新的跟踪窗口内执行一次MS算法的迭代,得到子模型的搜索窗口坐标y1g和y1m,利用式(8)进行特征融合,得到新的目标位置y1,如迭代结束执行步骤5,否则继续执行步骤4;

步骤 5 若跟踪视频未结束读取下一帧图像,转步骤2;否则结束算法。

本文算法的流程图如图2所示。

6 实验结果与分析

本文提到的算法均在 Pentium E5800双核CPU,2 G内存配置的电脑上,Windows XP系统下用Matlab9.0编程实现的。为验证算法的有效性,使用在复杂背景中的多个红外视频序列进行测试。在试验中,灰度、局部均值对比度的特征空间分别量化为32等级。

图2 自适应多特征融合的MS目标跟踪算法的流程图

首先应用于以飞机为目标的红外视频序列,k1=255,k2=64,红外序列图像共231 帧,其中由于成像器材的自身抖动,目标平移运动较为剧烈;目标的尺度在整个序列中变化近3倍;拍摄场景则由起初的天空背景迅速进入复杂的地物背景。通过对比采用灰度特征的原始MS算法与固定权重融合方案的尺度自适应的MS算法,对本文提出的算法进行评估。图3给出了在第5,10,170,190和210帧的跟踪结果。灰线框表示原始MS算法的跟踪结果,黑线框表示固定权重融合方案的MS算法的跟踪结果(权重w1=w2=0.5),白线框表示本文算法的跟踪结果。由图3可知,采用本文的尺度更新算法,固定权重融合方案的的MS算法和本文算法均能自适应地更新跟踪窗口的大小。

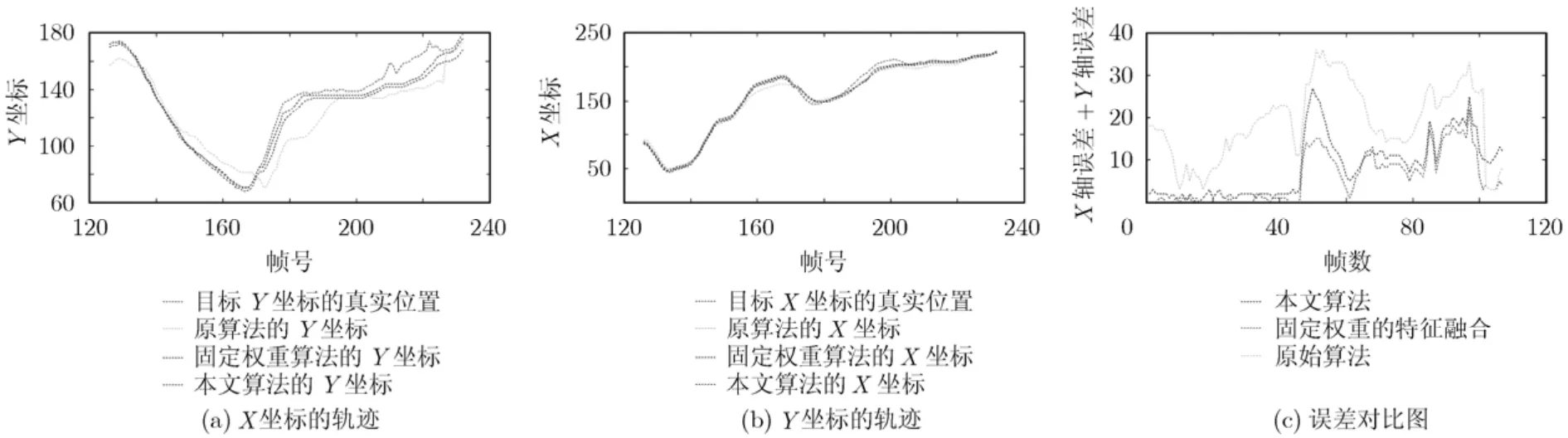

图4给出了3种方法从120帧开始的跟踪的轨迹图及误差的对比图。可见原始MS算法误差最大,本文MS算法跟踪误差普遍较固定权重融合MS算法低。从165帧处目标迅速进入复杂的地物背景,跟踪误差突然增大,随着自适应的调节,误差有减小的趋势。

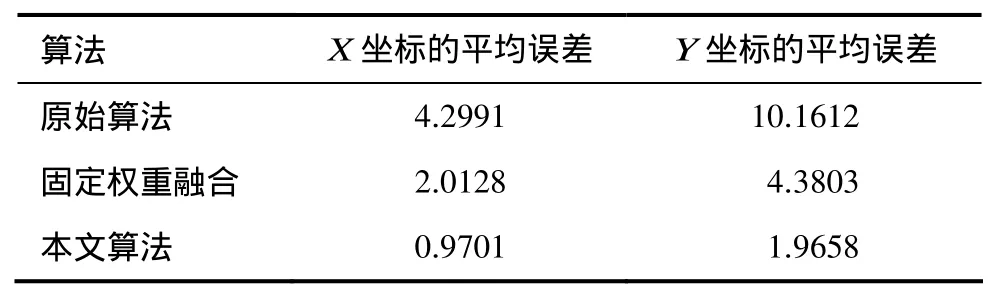

表1给出了不同跟踪算法X坐标和Y坐标的误差统计结果。

表1 跟踪误差统计结果(像素)

以人体为目标的红外视频序列进行仿真,k1=255,k2=32,红外序列图像共30帧,目标在运动过程中发生形变和部分遮挡。图5是对过路行人的红外视频跟踪的结果。第01帧白色跟踪框内的行人为跟踪的目标,当多个行人进入跟踪窗时,跟踪窗的中心始终在最初的行人(目标)身上;当其他目标消失后,仍对最初的行人(目标)进行稳定跟踪。由图5可以看到,本文所述算法能对非刚性的运动物体进行跟踪,并对目标的交叉运动和遮挡具有一定的鲁棒性。

7 结论

本文提出一种基于多特征子模型融合的红外目标跟踪方法,在MS框架下实现目标特征自适应融合。选用局部均值对比度和灰度两种特征建立目标的子模型,利用特征不确定性自适应调节特征对跟踪结果的贡献,对复杂场景的目标跟踪具有良好的效果。实验表明,在复杂场景的红外图像中,该算法能有效地适应场景变化和目标的形变和部分遮挡,其性能优于仅采用单一特征描述的MS算法和固定权重融合算法;但当目标存在无规则的大位移运动时影响算法的稳定性。

图3 不同跟踪算法的结果示例

图4 不同跟踪算法的误差对比

图5 人体目标跟踪算法的结果示例

参 考 文 献

[1]张辉,赵保军,唐林波,等.基于自适应多特征整合的红外目标跟踪[J].光学学报,2010,30(5): 1291-1296.Zhang Hui,Zhao Bao-jun,Tang Lin-bo,et al..Infrared object tracking based on adaptive multi-features integration[J].Acta Optica Sinica,2010,30(5): 1291-1296.

[2]Comaniciu D,Ramesh V,and Meer P.Kernel-based object tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2003,25(5): 564-577.

[3]Jiang Z L,Li S F,and Gao D F.An adaptive mean shift tracking method using multiscale image[C].Wavelet Analysisand Pattern Recognition,Beijing,China,Nov.2-4,2007,Vol.3: 1060-1066.

[4]Han Ri-sheng,Jing Zhong-liang,et al..Kernel based visual tracking with scale invariant features[J].Chinese Optics Letters,2008,6(3): 168-171.

[5]李远征,卢朝阳,高全学,等.基于多特征融合的均值迁移粒子滤波跟踪算法[J].电子与信息学报,2010,32(2): 411-415.Li Yuan-zheng,Lu Zhao-yang,Gao Quan-xue,et al..Particle filter and mean shift tracking method based on multi-feature fusion[J].Journal of Electronics&Information Technology,2010,32(2): 411-415.

[6]康一梅,谢晚冬,胡江,等.目标尺度自适应的mean shift跟踪算法[J].兵工学报,2011,32(2): 210-216.Kang Yi-mei,Xie Wan-dong,Hu Jiang,et al..Target scale adaptive mean shift tracking algorithm[J].Acta Armamentarii,2011,32(2): 210-216.

[7]李平生,李小霞.基于梯度特征与彩色特征相融合的 mean shift 跟踪方法[J].图形、图像与多媒体,2011,30(3): 35-38.Li Ping-sheng and Li Xiao-xia.Mean shift tracking algorithm based on gradient feature and colorfeature fusion[J].Image Processing and Multimedia Technology,2011,30(3): 35-38.

[8]Comanuciu D and Meer P.Mean-Shift: a robust approach toward feature space analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(5):603-619.

[9]Comaniciu D.Nonparametric robust methods for computer vision[D].[Ph D.dissertation],New Jersey: The State University of New Jersey,2000.

[10]马东辉,朱斌,樊祥,等.基于粒子滤波的目标图像多特征融合跟踪方法[J].探测与控制学报,2009,31(4): 39-43.Ma Dong-Hui,Zhu Bin,Fan Xiang,et al..Method of tracking target images based on multi-feature fusion and particle filter[J].Journal of Detection&Control,2009,31(4): 39-43.

[11]顾鑫,王海涛,汪凌峰,等.基于不确定性度量的多特征融合跟踪[J].自动化学报,2011,37(5): 550-559.Gu Xin,Wang Hai-tao,Wang Ling-feng,et al..Fusing multiple features for object tracking based on uncertainty measurement[J].Acta Automatica Sinica,2011,37(5):550-559.

[12]Bradski G R.Computer video face tracking for use in a perceptual user interface[EB/OL].http://developer.intel.com/technology/itj/ q21998/pdf/camshift.pdf.

[13]叶有时,唐林波,赵保军,等.基于SOPC的深空目标实时跟踪系统[J].系统工程与电子技术,2009,31(12): 3002-3006.Ye You-shi,Tang Lin-bo,Zhao Bao-jun,et al..Real-time deep space target track system based on SOPC[J].Systems Engineering and Electronic,2009,31(12): 3002-3006.