IBM:用超级计算机模拟人脑

2012-08-08

11月13日,IBM宣布了世界上最大的人脑模拟计划“Compass”,使用了世界排名第二的超级计算机Sequoia Blue Gene/Q和一个全新的、扩展性很强的低功耗计算机架构,终于模拟出了与人脑相当的5300亿个神经元和137万亿个神经突触,这一数字已经足以和人类大脑相媲美,向真正意义上的“人工大脑”迈出了重要的一步。

那么,他们是怎样达成这一成果的呢?来看果壳网的揭密——

认知计算

人脑也许是宇宙中最复杂的存在了,但同时它又十分节能。人类的大脑可以同时收集上千个感官信号,并对它们进行判断、分析,把具体的感知转化为抽象的概念,同时在这一过程中进行学习、规划和创造。据IBM估计,以现有的科技水平,建造与人类大脑复杂度相当的计算机需要近100兆瓦的能量供应,而人类大脑进行这一切活动,只需要区区20瓦的功率就够了。

如此巨大的能量消耗显然是不现实的。要解决这一问题,我们需要一套全新的思路。IBM提出的方案就是“认知计算”。这一全新的领域凝聚了来自神经科学、纳米科技和超级计算机等领域的最新研究成果。

神经科学家们发现,人类大脑之所以如此的节能,是因为它是由“事件驱动”的。简单的说,神经元、神经突触和轴突只在接收到感觉信号或者来自其他神经元的信号时才会被激活,而其他时间它们是不消耗能量的。和它们相比,现在的电脑浪费了大量的能源。

从猕猴大脑结构中推导出来的神经突触网络

来自IBM的工程师们受到这一原理的启发,开发出了一套新颖的计算架构,并用它来模拟数目与人类大脑相当的神经元与神经突触。从生物学意义或者功能性上讲,这一成果并不是对大脑的准确模拟。虽然这套系统还无法进行任何传统意义上的感知、思考与概念形成等活动,但它却是向这一目标迈进的关键一步。

工作原理

研究者们最初是从CoCoMac开始工作的。CoCoMac是一套包含猕猴大脑结构信息的数据库,虽然还不完整,但却足够全面。在经过了四年对CoCoMac的艰难修补之后,这一团队最终得到了一套可用的数据,并在此基础上建立起了他们的人工大脑,这一系统的两个主要组成部分便是神经元和神经突触。

神经元是计算中心。每个神经元可以接收来自多达一万个相邻神经元的信号,随后它会处理这些数据,并输出另一个信号。约80%的神经元是兴奋性的,当它们发出信号时,周围的神经元也会被激活。而剩下的20%的神经元则是抑制性的,当它们发出信号时,接收信号的相邻神经元会被抑制。

神经突触的功能是连接不同的神经元,记忆与学习也随着神经突触的形成而发生。每一个突触都有一个“权重值”。这个权重值是由经过某一突触的信号数量决定的。当大量的信号通过某一突触时,这一突触的权重值就会上升,而这台虚拟大脑就是这样进行“联想学习”的。

这套系统的算法会定期检查一个神经元是否在发出信号。如果它的确在发出信号,这一神经元周围的突触的权重值就会被调整,而随后它们会根据这一新状态与其他的神经元进行交流。这一算法的关键优势是它不会在大量的突触上浪费时间与能量,而只在一小部分需要被激活的突触上花费有限的计算能力。

就像一个真正的大脑一样,这种计算架构是分布式、由事件驱动的,而且十分节能。同时,它还可以绕过传统计算架构固有的许多局限。

IBM的终极目标是建造一个复杂度可与人类大脑相媲美、体积又足够小的计算机,同时它的能量消耗还要在1千瓦左右。现在,他们已经利用世界排名第二的超级电脑Sequoia Blue Gene/Q达成了这一目标(当然,这距离“便携”和“节能”还有很远的距离)。这台超级计算机中有超过150万只处理器内核和1.5PB(150万GB)的内存,可以同时运行多达629万条线程。

为了进一步降低能量消耗,IBM正在构建一款全新的定制芯片,被称作“神经突触核心”(neurosynaptic cores)。这款特制的芯片可以充分激发新计算架构的潜能,并将最终取代现在模拟中使用的超级计算机。

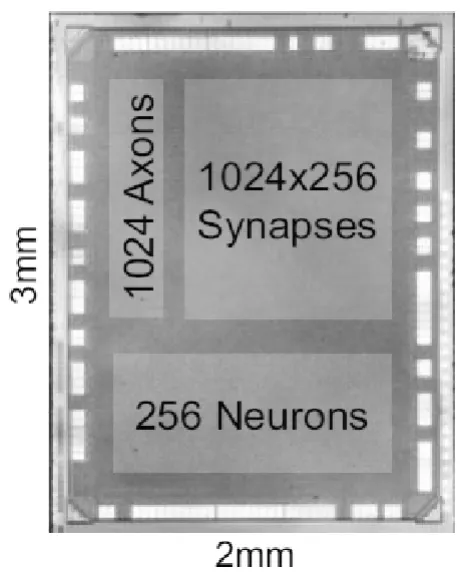

“神经突触核心”芯片结构图

每个核心都是由“神经元”、“突触”和“轴突”组成的。虽然被如此命名,但这些元件其实并不是模仿生物大脑中的结构而设计的。它们的设计目标是降低生产成本和提高性能。

应用前景

IBM最新设计的这一架构具有极高的并行性,这让它非常适合处理需要大量数据输入的计算。这和标准的神经计算网络没有太大的差别,但新系统的处理性能和能量利用效率却有了很大的提升。

IBM通过进行这样的实验可以进一步了解标准计算架构的局限,如在进行大规模运算时如何平衡存储、计算和传输性能。这项实验还可以为将来设计更加节能、并行程度更高的高性能芯片积累经验。

对于这一新的研究成果,未来的应用可能包括更加准确的天气预报,股票市场预测,可以实时进行诊断的智能病患监控系统和性能可以与人类媲美的光学字符识别和语音识别软件等等。

至于真正模拟人类大脑,我们仍有很长的路要走。但至少,科学家们在不断取得新的突破。