基于SURF目标跟踪算法研究

2011-03-16彭欣刘富强宋华军

彭欣,刘富强,宋华军

(1.91404部队91分队,秦皇岛 066001;2.中国石油大学(华东) 信息与控制工程学院,东营 257061)

视频运动目标跟踪是计算机视觉、图像处理和模式识别领域里非常活跃的课题。作为计算机视觉研究的热点和难点,国内外很多的人和组织进行了大量的研究[1]。Aristidis Likas等人提出了一种基于卡尔曼滤波和Mean shift的自适应可视目标跟踪方法[2],使用Meanshift预测目标位置,后使用可更新状态矩阵的Kalman滤波实现目标跟踪;Ta,D.-N.等人研究了一种使用局部特征描述的连续快速目标跟踪识别算法SURFTrack[3],并试验证明了其在户外进行移动电话跟踪的良好性能;HuiyuZhou等人研究了基于 SIFT特征和均值漂移的目标跟踪,提出了一种优化的相似性搜索函数对复杂背景下的目标跟踪有较好的效果[4];张锐娟等研究了基于SURF的图像配准[5],实验证明了SURF特征提取算法的计算量小快速性特点。

由于SURF特征提取算法是当前特征点匹配领域的热点,具有较高的匹配能力,并且当图像发生平移、旋转和仿射变换、光照变换等情况,都具有较高的匹配精度和鲁棒性。本文研究基于SURF特征的目标跟踪算法,同时结合德州仪器公司最高性能的处理器TMS320C6416T的快速数据处理和运算能力,以实现高速度、高精度、具有很强鲁棒性的视频目标跟踪。

1 SURF特征匹配算法

SURF(Speed Up Robust Features)[6]特征是一种图像的局部特征,当目标图像发生旋转、尺度缩放、亮度变化时,具有保持不变性,并且对视角变化、仿射变换和噪声等也具有保持一定程度的稳定性。

SURF特征提取算法的流程主要包括:特征点检测、特征点描述和特征点匹配三部分。特征点检测采用了基于Hessian矩阵的检测器,其在稳定性和可重复性方面都优于基于Harris的检测器。特征点描述采用 Haar小波[7]作为特征描述子,由于Harr特征最大的特点是速度快,能减少计算时间且增加鲁棒性。

用方框滤波近似代替二阶高斯滤波,运用积分图像加速卷积,减少了时间计算的复杂度,提高了计算速度。

SURF的算法流程[8]如图1所示。

图1 SURF算法流程图Fig.1 SURF method structure

1.1 积分图像

积分图像是对原始图像的一种特征表示方法,如图2所示深色区域表示点(x,y)的积分值,即深色区域的灰度值总和。对原始图像进行积分,得到积分图像,其中代表像素值[9]。

1.2 尺度空间的建立

对图像进行预处理时,使用箱式滤波器对高斯核近似,由于其在计算卷积时的计算量与滤波器大小无关,因此可以极大的提高算法运行速度。

图2 积分图像Fig.2 Integration image

加权箱式滤波器[10]在 x,y和 xy方向上的对高斯二阶偏导的近似如图3所示,分别用表示。图中白色区域的权重赋予正数,灰色区域的权重赋予0,黑色区域的权重赋予负数(如 1)。为了建立适应目标变换的尺度空间,需要不同尺度的箱式滤波器。

图3 箱式滤波器Fig.3 Box filters

根据SURF算法的要求,在不同尺度上寻找极值点,需要建立图像的尺度空间。在 SIFT中,建立DOG尺度空间,其是通过对图像金字塔中的相邻两层的图像做差值。而 SURF在建立尺度空间时,不需要做差值,保持原始图像不变。通过改变滤波器的大小,得到尺度空间。SURF算法由于使用了积分图像和箱式滤波器,加快了算法的运算速度[11]。

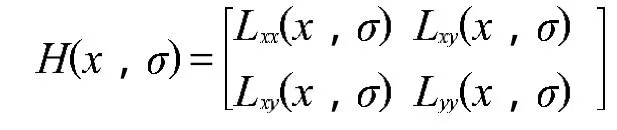

1.3 快速Hessian特征检测

由Hessian矩阵来进行图像极值点的检测,首先根据特征值计算出来的行列式的符号(如正或负)对极值点进行判别。然后根据值得正或负判断该点是不是局部极值点。如果行列式是正的,那么特征值全为正或者全为负,故该点是极值点。给出图像上的某点,尺度定为,则Hessian矩阵定义为:

Hessian矩阵中用到的核函数是高斯核函数,也就是箱式滤波器,9*9的滤波器是对高斯核函数在处的近似。为了保持计算精度,引入一个高斯核函数和高斯核函数的近似的比例因子,Hessian矩阵的行列式表示为:

式中:det(Hopprox)表示在点X周围的区域的箱式滤波器响应值。用det(Hopprox)进行极值点的检测,同时求出矩阵的迹。比邻因子的值通过下式计算:

1.4 SURF描述子生成

SURF特征描述子[6]可以分为两步:第一步根据特征点周围的一个圆形区域,找到一个主方向;第二步在这个选定方向上构造一个矩形区域,并提取出所需的描述信息。求极值点的主方向是以极值点为中心选取某一半径圆形区域。在此区域内计算哈尔小波在x和y方向上的响应值,记为

图4 哈尔小波Fig.4 Harr wavelet

图4所示为哈尔小波滤波器在x方向和y方向上描述。计算出图像在哈尔小波的x和y方向上的响应值之后,对两个值进行因子为(是极值点所在的尺度)的高斯加权,加权后的值分别表示在水平和垂直方向上的方向分量,记为

图5 主方向的选择Fig.5 Main direction selection

选定特征点主方向之后,在特征点周围按主方向构造一个大小20s的窗口,这些窗口被分割成4×4的子区域。在每一个子区域中,在特征点处为Haar小波响应加一个高斯权值,将特征向量归一化,这样就形成了一个四维的向量:

分别求16个子区域的特征向量,形成一个16*4=64维的特征向量,如图6所示,这64个值就是构成特征点的SURF描述子。

图6 SURF描述子的生成Fig.6 SURF descriptor generate

1.5 SURF相似性度量

特征点的匹配采用选定的特征向量欧式距离作为两帧图像中关键点的相似性判定度量。欧氏距离的公式是:

2 基于SURF目标跟踪算法

根据 SURF的特征提取算法,经过系列运算后,提取图像的特征,使用欧氏距离的方法进行相似度测量完成特征点的匹配。基于目标跟踪的具体算法过程如下:

(1)人工选定目标模板图像,使用 SURF特征提取算法提取特征值,保存到特征库。

(2)在后续帧中,提取人工选定位置附近的大区域图像(如果模板大小为100*100,则处理区域200*200),计算大区域图像的SURF特征值。

(3)使用欧氏距离度量方法计算被匹配的特征点,由于匹配的特征点十分分散,提出使用重心算法计算特征点的重心作为目标的脱靶量。

(4)将新匹配的特征点存入特征库,完成了模板的更新,用新的特征继续匹配后续帧。

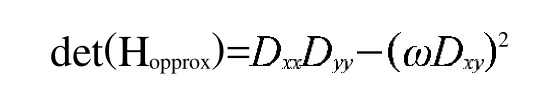

图7 行走的人跟踪效果图Fig.7 Pedestrian tracking result

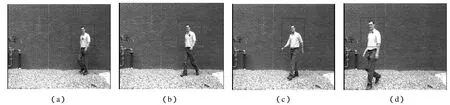

图8 飞机目标跟踪效果图Fig.8 Plane tracking result

3 实验结果

图7是行走人的跟踪结果,从(a)到(d)分别是15,30,50,78帧跟踪结果。由实验可以发现对于背景固定,简单,目标比较清晰地场合,SURF目标跟踪算法可以很好的实现跟踪效果。

图8为飞机目标跟踪效果图,从(a)到(d)分别是 215,286,323,389帧跟踪结果。视频的背景比较复杂,飞机飞行过程中有旋转,光照视角等变化,由实验可以发现飞机在天空飞行过程中算法跟踪效果较好,当飞机进入树林复杂背景后,目标跟踪丢失目标,目标特征淹没在树林的特征中,匹配发生错误难以定位目标。

对于模板大小为80*60,匹配区域为160*120的图像,算法的速度大约在33ms左右,不能满足实时目标跟踪算法的要求。后面继续对算法进行改进,提供运行速度。

4 结论

基于SURF算法的目标跟踪算法,比SIFT算法具有更快的跟踪速度,与传统重心、相关跟踪算法相比较,对处理较复杂背景下的跟踪效果较好,匹配精度高,并且对目标遮挡、光照变换具有较高的鲁棒性。

通过实验发现SURF算法可以有效提取图像的典型局部特征,将其应用于目标跟踪中时,能较好的实现目标跟踪效果,但是作为SURF算法的速度优势还没有完全发挥出来。将编写的算法移植到基于TMS320C6416T的目标跟踪板上,不能达到实时跟踪,下一步将努力优化算法,改进确定目标中心的方法,提高算法速度。

[1]贾云得.机器视觉[M].北京:科学出版社,2002:26-32.

[2]Vasileios K,Christophoros Nikou,Aristidis Likas.Visual Tracking by Adaptive Kalman Filtering and Mean Shift[J].Springer-Verlag Berlin Heidelberg,2010,6040:153-162.

[3]Ta,D N,Chen,W C,Gelfand,N,Pulli,K.SURFTrac:Efficient Tracking and Continuous Object Recognition using Local Feature Descriptors[C].Computer Vision and Pattern Recognition(CVPR'09),2009:2937-2943.

[4]Huiyu Zhou,Yuan Yuan,Chunmei Shi.Object tracking using SIFT features and mean shift[J].Computer Vision and Image Understanding,2009,113:345-352.

[5]张锐娟,张建奇,杨翠.基于SURF的图像配准方法研究[J].红外与激光工程,2009,38(1):160-165.

[6]Bay H,Tuytelars T,Van Gool L.Speeded-Up Robust Features(SURF)[J].Computer Vision and Image Understanding,2008(110):346-359.

[7]Khashman A,Dimililer K.Image compression using neural networks and Haar wavelet[J].WSEAS Transactions on Signal Processing,2008,5(4):330-339.

[8]徐秀云.基于特征点的景象匹配技术研究[D].南京:南京理工大学,2009:1-68.

[9]Freund Y.Boosting a weak learning algorithm by majority[J].Information and Computation,1995(121):226-230.

[10]Mikolajczyk K,Schmid C.An affine invariant interest point detector[J].Computer Vision-ECCV,2002(2350):128-142.

[11]Lowe D.Distinctive image features from scale invariant ke-ypoints[J].In journal of Computer Vision,2004,60(2):91-110.

[12]Mizutani Eiji,Dreyfus Stuart E,Demmel James W.Second-order backpropagation algorithms for a stagewisepartitioned separable Hessian matrix[C].Proceedings of the International Joint Conference on Neural Networks,2005(2):1027-1032.